Улучшения Yolov8: новейшая архитектура мобильной сети с открытым исходным кодом RepViT | RepViTBlock для облегчения обнаружения Tsinghua ICCV 2023

💡💡💡Эксклюзивное оригинальное улучшение этой статьи: эффективный выбор архитектуры облегченного ViT постепенно повышает удобство использования для мобильных устройств стандартного облегченного CNN (особенно MobileNetV3). В результате появилось новое семейство чисто облегченных CNN — RepViT.

RepViTBlock — это готовая к использованию система для облегчения обнаружения | Личное тестирование позволяет добиться высоких результатов и легкости в нескольких наборах данных

1. Введение в Реп Ви Т

бумага:https://arxiv.org/pdf/2307.09283.pdf

Основное внимание уделяется переосмыслению конструкции легких сверточных нейронных сетей и интеграции легких сверточных нейронных сетей на мобильных устройствах с ограниченными ресурсами. ViTs Эффективный выбор архитектуры для улучшения легкости CNNs производительность.

Вклад в эту статью:

- Как упоминалось в статье, легкий ViTs Обычно легче, чем CNNs существуют лучше справляются с визуальными задачами,В основном это связано с их многоголовым модулем самообслуживания.(

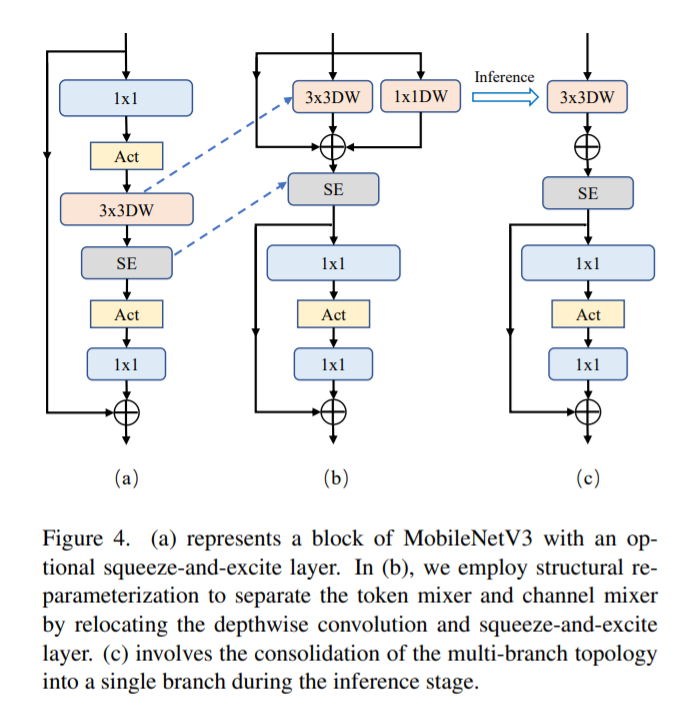

MSHA)Позвольте модели учитьсяглобальное представительство。Однако,легкий ViTs и легкий CNNs Архитектурные различия между - В этом исследовании авторы интегрируют облегченный ViTs Эффективный выбор архитектуры постепенно улучшает стандартную легковесность. CNN (особенно

MobileNetV3мобильное удобство. Это порождает новый чистый легкий вес. CNN Рождение семьи,Прямо сейчасRepViT。Стоит отметить, что,хотя RepViT иметь MetaFormer структуру, но она целиком состоит из извилин. - Результаты экспериментов показывают,

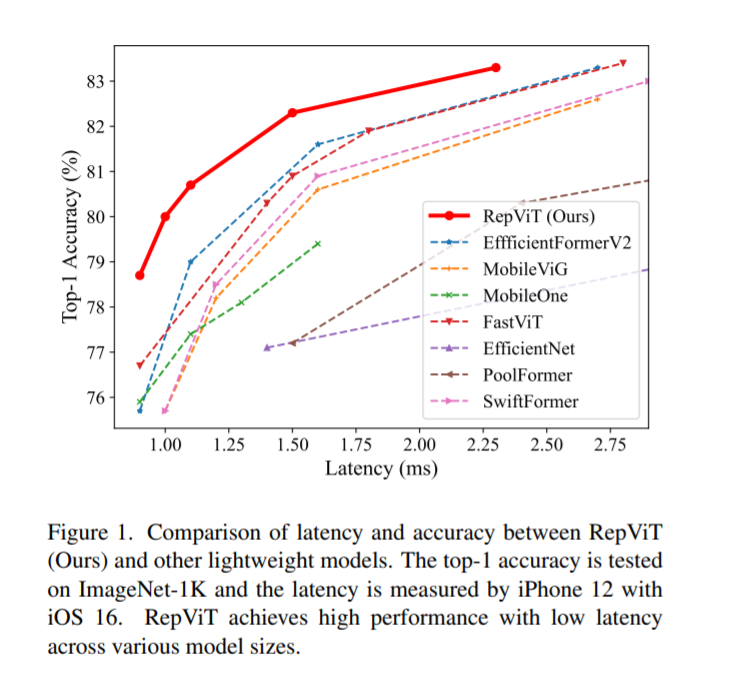

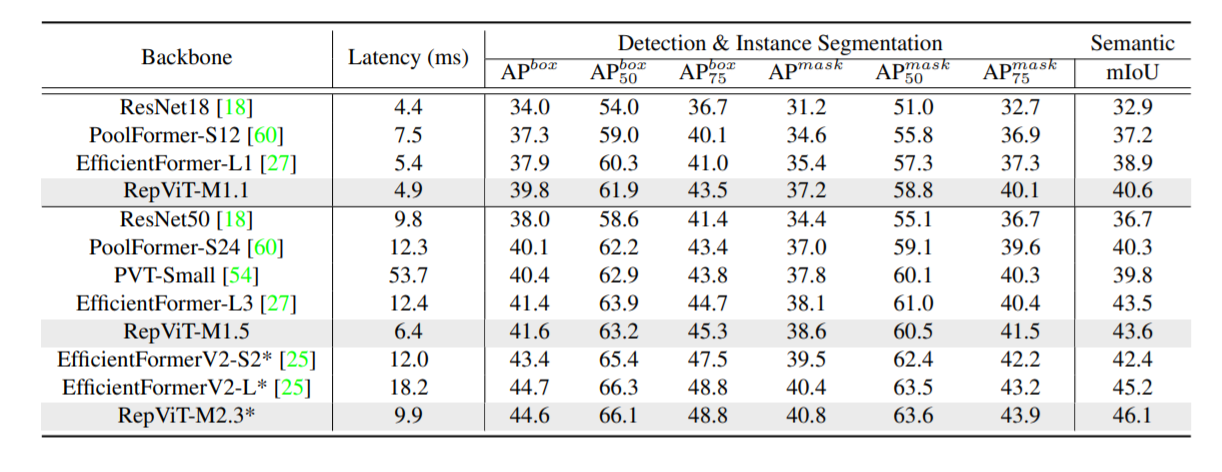

RepViTПревосходя существующие современные легкие ViT и демонстрируют превосходную производительность и эффективность по сравнению с существующими современными легкими ViT при выполнении различных задач машинного зрения, включая ImageNet Классификация, COCO-2017 обнаружение объектов и сегментация экземпляров на ADE20k Семантическая сегментация включена. специально,существоватьImageNetначальство,RepViTсуществоватьiPhone 12достиг почти 1ms задерживать и превышать 80% Топ-1 Точность, это первый прорыв среди легких моделей.

Постепенно повышайте удобство использования стандартных облегченных CNN для мобильных устройств (особенно MobileNetV3) за счет эффективных архитектурных решений, интегрирующих облегченный ViT. Результатом является новое семейство чистых легких CNN — RepViT.

RepViT настраивает легкие CNN посредством послойного микропроектирования, которое включает в себя выбор подходящего размера ядра свертки и оптимизацию расположения слоя сжатия и возбуждения (SE). Оба метода значительно улучшают производительность модели.

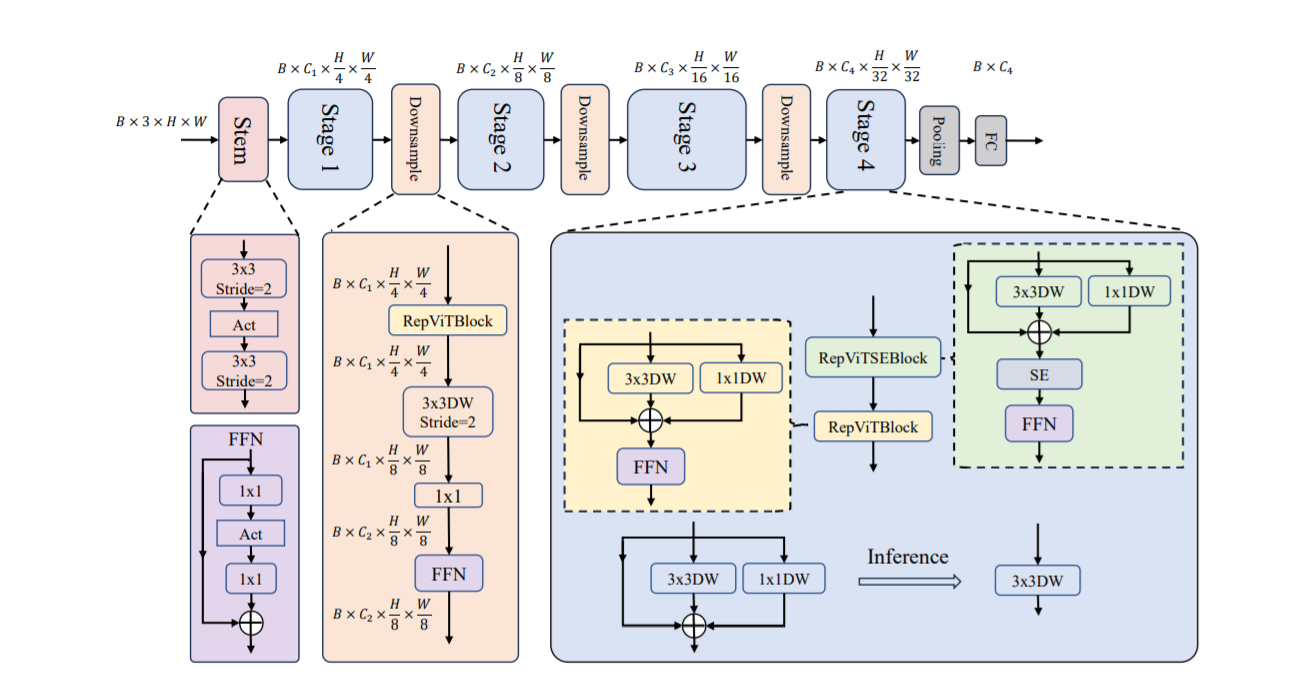

Неглубокие сети используют сверточные экстракторы

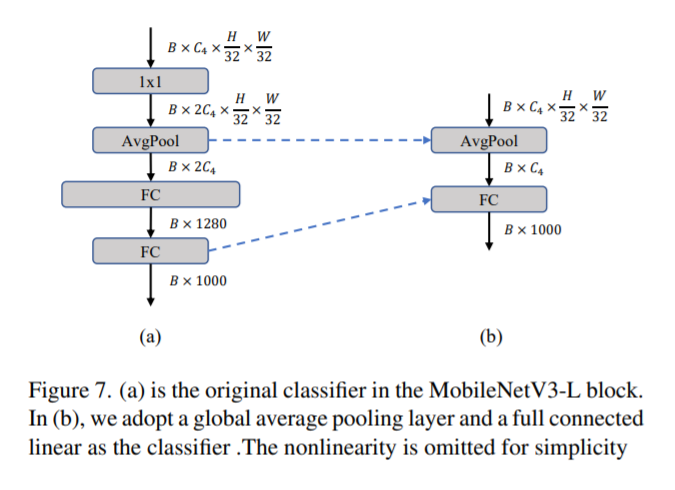

Более глубокие слои субдискретизации,Авторы начали со свертка 1x1 для настройки размеров канала., а затем объединить два 1x1 Вход и выход свертки соединены через остатки, образуя сеть прямой связи. Кроме того, они добавили RepViT блок для дальнейшего углубления слоя понижающей дискретизации, этот шаг улучшает top-1 точность до 75,4%, при этом задержка составляет 0.96ms。

финальный,Путем интеграции вышеуказанных стратегий улучшения,Мы получили модельRepViTОбщая структура,Данная модель имеет несколько вариантов,НапримерRepViT-M1/M2/M3。Так же,Различные варианты в основном отличаются количеством каналов и блоков на каскад.

2. Реализация RepViTBlock на базе Yolov8

2.1 присоединитьсяultralytics/nn/backbone/repvit.py

Основной код:

class RepViTBlock(nn.Module):

def __init__(self,in1, inp, hidden_dim, oup, kernel_size=3, stride=2, use_se=0, use_hs=0):

super(RepViTBlock, self).__init__()

assert stride in [1, 2]

self.identity = stride == 1 and inp == oup

print(inp)

print(hidden_dim)

print(oup)

assert(hidden_dim == 2 * inp)

if stride == 2:

self.token_mixer = nn.Sequential(

Conv2d_BN(inp, inp, kernel_size, stride, (kernel_size - 1) // 2, groups=inp),

SqueezeExcite(inp, 0.25) if use_se else nn.Identity(),

Conv2d_BN(inp, oup, ks=1, stride=1, pad=0)

)

self.channel_mixer = Residual(nn.Sequential(

# pw

Conv2d_BN(oup, 2 * oup, 1, 1, 0),

nn.GELU() if use_hs else nn.GELU(),

# pw-linear

Conv2d_BN(2 * oup, oup, 1, 1, 0, bn_weight_init=0),

))

else:

assert(self.identity)

self.token_mixer = nn.Sequential(

RepVGGDW(inp),

SqueezeExcite(inp, 0.25) if use_se else nn.Identity(),

)

self.channel_mixer = Residual(nn.Sequential(

# pw

Conv2d_BN(inp, hidden_dim, 1, 1, 0),

nn.GELU() if use_hs else nn.GELU(),

# pw-linear

Conv2d_BN(hidden_dim, oup, 1, 1, 0, bn_weight_init=0),

))

def forward(self, x):

return self.channel_mixer(self.token_mixer(x))Подробности см.:

https://blog.csdn.net/m0_63774211/article/details/131939062

Учебное пособие по Jetpack Compose для начинающих, базовые элементы управления и макет

Код js веб-страницы, фон частицы, код спецэффектов

【новый! Суперподробное】Полное руководство по свойствам компонентов Figma.

🎉Обязательно к прочтению новичкам: полное руководство по написанию мини-программ WeChat с использованием программного обеспечения Cursor.

[Забавный проект Docker] VoceChat — еще одно приложение для мгновенного чата (IM)! Может быть встроен в любую веб-страницу!

Как реализовать переход по странице в HTML (html переходит на указанную страницу)

Как решить проблему зависания и низкой скорости при установке зависимостей с помощью npm. Существуют ли доступные источники npm, которые могут решить эту проблему?

Серия From Zero to Fun: Uni-App WeChat Payment Practice WeChat авторизует вход в систему и украшает страницу заказа, создает интерфейс заказа и инициирует запрос заказа

Серия uni-app: uni.navigateЧтобы передать скачок значения

Апплет WeChat настраивает верхнюю панель навигации и адаптируется к различным моделям.

JS-время конвертации

Обеспечьте бесперебойную работу ChromeDriver 125: советы по решению проблемы chromedriver.exe не найдены

Поле комментария, щелчок мышью, специальные эффекты, js-код

Объект массива перемещения объекта JS

Как открыть разрешение на позиционирование апплета WeChat_Как использовать WeChat для определения местонахождения друзей

Я даю вам два набора из 18 простых в использовании фонов холста Power BI, так что вам больше не придется возиться с цветами!

Получить текущее время в js_Как динамически отображать дату и время в js

Вам необходимо изучить сочетания клавиш vsCode для форматирования и организации кода, чтобы вам больше не приходилось настраивать формат вручную.

У ChatGPT большое обновление. Всего за 45 минут пресс-конференция показывает, что OpenAI сделал еще один шаг вперед.

Copilot облачной разработки — упрощение разработки

Микросборка xChatGPT с низким кодом, создание апплета чат-бота с искусственным интеллектом за пять шагов

CUDA Out of Memory: идеальное решение проблемы нехватки памяти CUDA

Анализ кластеризации отдельных ячеек, который должен освоить каждый&MarkerгенетическийВизуализация

vLLM: мощный инструмент для ускорения вывода ИИ

CodeGeeX: мощный инструмент генерации кода искусственного интеллекта, который можно использовать бесплатно в дополнение к второму пилоту.

Машинное обучение Реальный бой LightGBM + настройка параметров случайного поиска: точность 96,67%

Бесшовная интеграция, мгновенный интеллект [1]: платформа больших моделей Dify-LLM, интеграция без кодирования и встраивание в сторонние системы, более 42 тысяч звезд, чтобы стать свидетелями эксклюзивных интеллектуальных решений.

LM Studio для создания локальных больших моделей

Как определить количество слоев и нейронов скрытых слоев нейронной сети?