Статья на 50 000 слов! Управляйте всеми аспектами Spark

Привет всем, это технологическое сообщество 857.

Сегодня я хотел бы поделиться с вами концептуальной статьей о Spark объемом 10 000 слов, которую легко понять новичкам. Эта статья стремится быть краткой и простой для понимания. Я надеюсь, что это поможет новичкам начать обучение, начиная с базовых концепций и затем углубляя принципы, чтобы они могли легко освоить Spark от более поверхностного к более глубокому.

Для начала давайте представим историю разработки Spark! ! ! ! !

Большие данные, искусственный интеллект ( Artificial Intelligence ), как нефть и электроэнергетика в прошлом, влияет на все отрасли с беспрецедентной широтой и глубиной. Основными барьерами нынешних и будущих компаний являются основные конкурентные преимущества, возникающие в результате конкуренции, основанной на искусственном интеллекте.

Spark на сегодняшний день является самой активной, популярной и эффективной вычислительной платформой в области больших данных.

Родился в 2009 году в AMP, Калифорнийский университет, Беркли, США. лаборатория,

Открытый исходный код выпущен под лицензией BSD в 2010 году.

В 2013 году он сделал пожертвование в Apache Software Foundation и переключил лицензионное соглашение с открытым исходным кодом на Apache2.0.

В феврале 2014 года Spark стал проектом Apache верхнего уровня.

ноябрь 2014 г., Команда Databricks, материнской компании Sparkiz, использует Spark для обновления мирового рекорда по сортировке данных

Spark успешно создал интегрированную, диверсифицированную и крупномасштабную систему обработки данных. В любом масштабе изданные расчеты, Spark имеет больше преимуществ в производительности и масштабируемости.

(1) Hadoop Дуг Каттинг отметил: используйте of MapReduce engine for Big Data projects will decline, replaced by Apache Spark (Большой проект данных, использующий движок MapReduce, будет прекращен на базе Apache. Spark заменять)

(2)Hadoop Коммерческое распространение от лидера рынка Cloudera 、HortonWorks 、MapR Все они перешли на Spark и считали Spark лучшим выбором и основной вычислительной системой для крупномасштабных решений.

из такого бенчмарктеста в 2014 году, Spark мгновенно убивает Hadoop , в случае использования одной десятой вычислительных ресурсов, в том же порядке, Spark в 3 раза лучше MapReduceбыстрый! Официального ПБ нет. Сортировка вернее, чем в других случаях, в первый раз будет S park Перенесено в IPB данные(Десять триллионов записей) из сортировки, используя 190 узлов, рабочая нагрузка была выполнена за 4 часа, Это также намного превышает предыдущий рекорд Yahoo в 16 часов при использовании 3800 хостов.

В июне 2015 года наибольшее количество узлов Spark поступило от Tencent — 8000 узлов, а наибольшее количество одиночных работ — у Alibaba и Databricks — 1PB, что шокирует! При этом количество SparkизContributors утроилось с 2014 года до 730: общее количество строк кода также увеличилось более чем вдвое с 2014 года до 40 строк.

ИБМ в 2015 году 6 класс Ежемесячное обязательство по улучшению Apache Spark проект, Его еще называют проектом «Должен»: возглавляемый данными, это будет самый важный новый проект с открытым исходным кодом в ближайшие десять лет. Это-обещание из Кореда Искроет Встроить IBM Ведущая в отрасли аналитическая бизнес-платформа, интегрирующая Spark как услуга,существоватьIBMBПредоставляется клиентам на платформе。IBMбудет инвестировать больше, чем3500знаменитое исследованиеиразвиватьперсоналсуществоватьпо всему миру10Создано более 10 лабораторий.иSparkСвязанныйизпроект,и будетSparkЭкосистема с открытым исходным кодом бесплатно обеспечивает прорывыизтехнология машинного обучения–IBM СистемаML. В то же время IBM также обучит более 1 миллиона ученых и инженеров по данным Spark.

В 2016 году на всемирно известной сортировке, известной как «Компьютерные олимпиады». В глобальном рейтинговом соревновании Benchmark NADSort, участвующая команда, состоящая из Лаборатории компьютерных наук и технологий PASA Нанкинского университета и компании Alibaba Databricks, завершила процесс сортировки стандартного набора объемом 100 ТБ стоимостью 144 доллара США, установив новый рекорд Стоимость сортировки за ТБ составляет 1,44 доллара США (последний мировой рекорд) по сравнению с 2014 годом. Выиграв чемпионат в 2017 году, команда TritonSort из Калифорнийского университета в Сан-Диего стоила 4,51 доллара за ТБ и снизила стоимость почти на 70%. Однако в этом соревновании по-прежнему используется Apache. Платформа вычислений больших данных Spark провела множество оптимизаций в крупномасштабном алгоритме параллельной сортировки и нижнем уровне системы Spark, чтобы улучшить производительность вычислений сортировки и максимально снизить нагрузку на ресурсы хранения, чтобы гарантировать, что она в конечном итоге выиграет конкуренцию. .

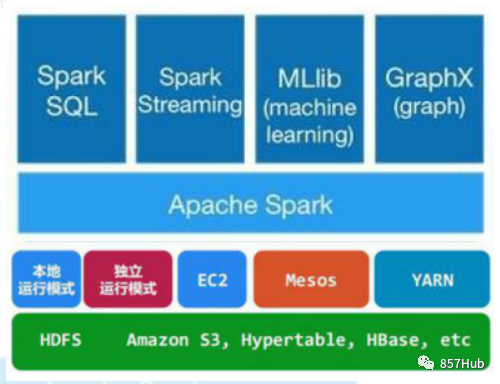

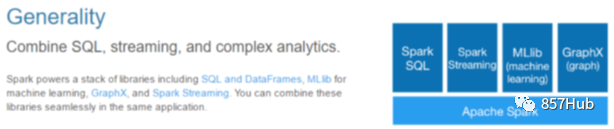

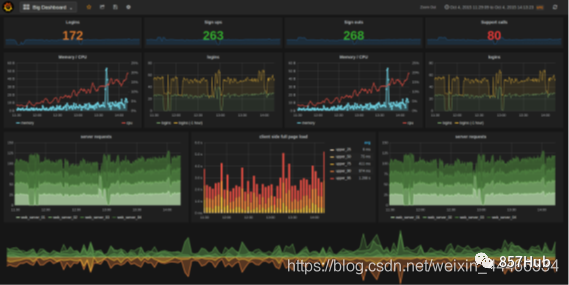

Под руководством идеалов FullStack Spark in Spark SQL 、SparkStreaming 、MLLib 、GraphX Пять основных подплатформ и библиотек R могут беспрепятственно обмениваться операциями с данными, Это не только создает непревзойденные преимущества Spark перед другими вычислительными платформами в современной большой вычислительной области, И Spark постепенно становится предпочтительной вычислительной платформой для крупных вычислительных центров.

Во-вторых, почему Spark популярен? ? ? ?

Причина 1: Отличные изданные модели и вычислительная абстракция.

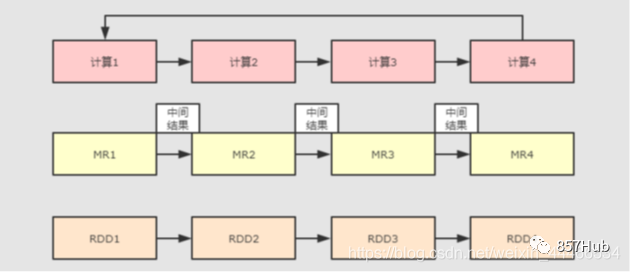

Spark До его появления уже существовали очень зрелые вычислительные системы, такие как MapReduce, которые предоставляли API высокого уровня (map/reduce) для выполнения вычислений в системе и обеспечения отказоустойчивости, тем самым достигая распределенных вычислений.

Хотя MapReduce обеспечивает абстракцию доступа и вычислений, повторное использование в файловой системе так же просто, как запись промежуточных данных в стабильную файловую систему (например, H DFS), поэтому будет генерироваться резервное копирование данных, дисковый ввод-вывод и сериализация данных, поэтому эффективность будет очень низкой при возникновении необходимости повторного использования промежуточных результатов операций между несколькими вычислениями. Этот тип операций очень распространен, например, итеративные вычисления, интерактивный анализ, графовые вычисления и т. д.

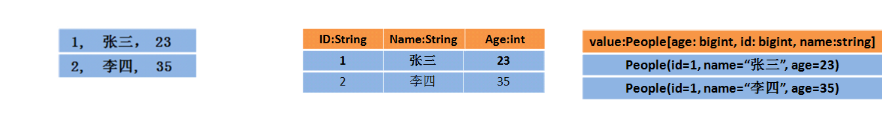

Осознав эту проблему, академическое сообщество AMPLab предложило новую модель под названием RDD. RDD — это отказоустойчивая и параллельная структура (на самом деле ее можно понимать как распределенную коллекцию, и ее работа так же проста, как и работа с локальной коллекцией. Она позволяет пользователям явно преобразовывать промежуточные результаты). Набор данных хранится в памяти и позволяет управлять набором данных и разделять его для оптимизации обработки хранения данных. В то же время RDD также предоставляет богатые возможности. API (map, уменьшить, foreach, уменьшитьByKey...) для работы с набором данных. позже RDD используются AMPLab в программе под названием Spark Предоставляется в рамках и с открытым исходным кодом.

Короче говоря, Spark был разработан на основе идей MapReduce, сохранив его преимущества распределенных параллельных вычислений и улучшив его очевидные недостатки. Разрешение хранить промежуточные данные в памяти повышает скорость работы и предоставляет богатый API-интерфейс для работы с данными для повышения скорости разработки.

Причина 2: Улучшить экосистему

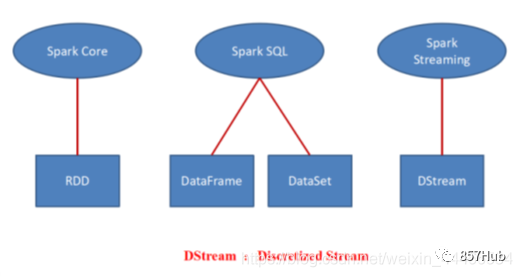

В настоящее время Spark превратился в набор нескольких подпроектов, включая SparkSQL, Spark Streaming, GraphX, MLlib и другие подпроекты

Spark Ядро: реализует основные функции Spark, включая такие модули, как RDD, планирование задач, управление памятью, восстановление после ошибок и взаимодействие с системой хранения.

Spark SQL: Spark используется для работы с пакетами структурированных данных. нанести Искру SQL, мы можем использовать данные операций SQL.

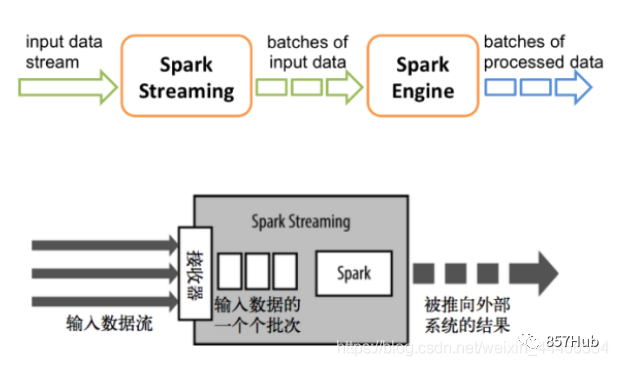

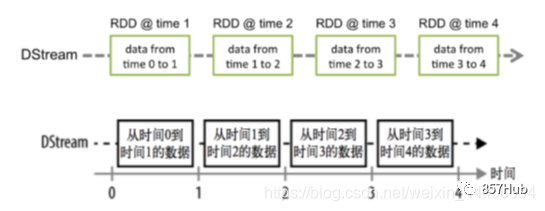

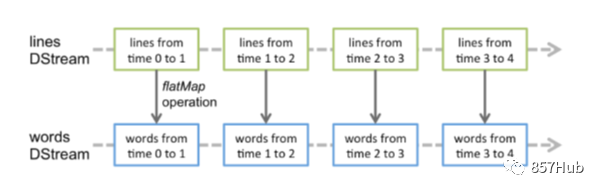

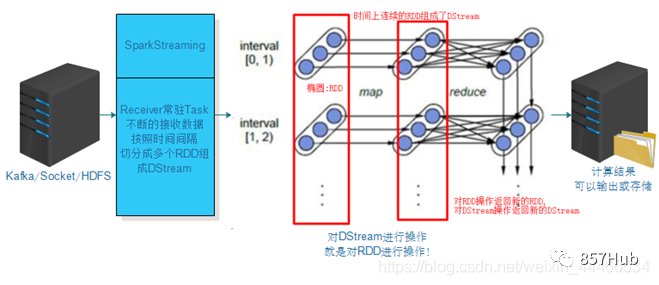

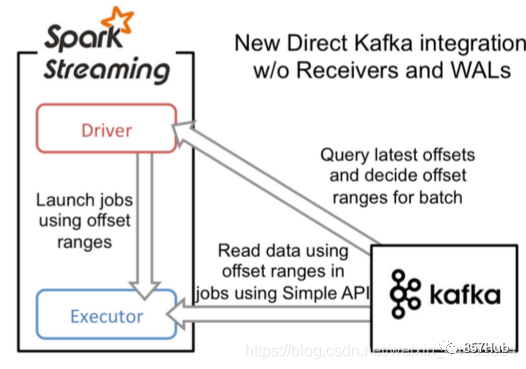

Spark Потоковая передача: Spark предоставляет компоненты потоковых вычислений в реальном времени. Предоставляет API для работы с потоками данных.

Spark MLlib: предоставляет общие функции и библиотеки машинного обучения (ML). Включает классификацию, регрессию, кластеризацию, совместную фильтрацию и т. д., а также предоставляет дополнительные функции поддержки, такие как оценка модели и импорт данных.

GraphX (Graph Computing): API Spark для графовых вычислений, имеет хорошую производительность, имеет богатые функции и операторы и может свободно запускать сложные графовые алгоритмы на огромных объемах данных.

Менеджер кластера: Spark предназначен для эффективного масштабирования вычислений между одним вычислительным узлом и тысячами вычислительных узлов.

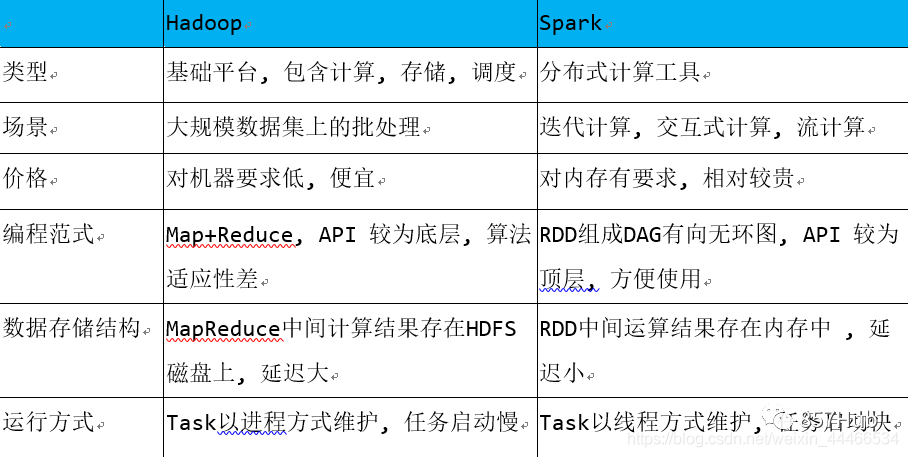

Дальнейшее чтение:Spark VS Hadoop

★Уведомление:

Хотя Spark имеет большие преимущества перед Hadoop, Spark не может полностью заменить Hadoop. Spark в основном используется для замены вычислительной модели MapReduce в Hadoop. HDFS по-прежнему можно использовать для хранения, но промежуточные результаты можно хранить в памяти; также можно использовать встроенное планирование Spark или более зрелые системы планирования, такие как YARN.

Фактически, Spark хорошо интегрирован в экосистему Hadoop и стал ее важным членом. Он может реализовать управление планированием ресурсов с помощью YARN и обеспечить распределенное хранилище с помощью HDFS.

Кроме того, Hadoop может использовать дешевые и гетерогенные машины для распределенного хранения и вычислений, однако аппаратные требования Spark несколько выше, а к его памяти и ЦП предъявляются определенные требования.

1. Обзор Spark и подробное объяснение

1. Что такое Искра?

Apache Единая аналитическая система Sparkda для крупномасштабной обработки данных

Spark основан на вычислениях в памяти, что повышает производительность обработки в реальном времени в больших средах.

В то же время он обеспечивает высокую отказоустойчивость и высокую масштабируемость, позволяя пользователям развертывать Spark на большом количестве оборудования для формирования кластера.

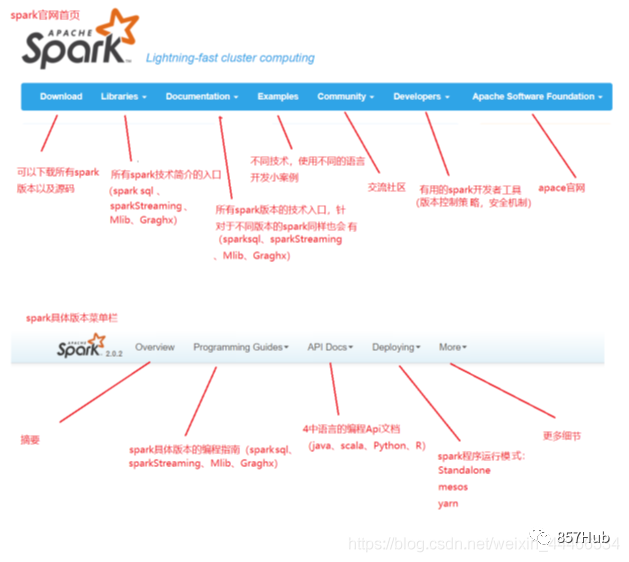

Официальный сайт Искры

http://spark.apachecn.org

http://spark.apachecn.org

2. Состав и принципы архитектуры Spark

1.Spark Ядро: содержит основные функции Spark, особенно определение RDDAPI, операций и того и другого. Другие библиотеки Spark построены на основе RDD Spark. Ядро выше из.

2.Spark SQL:поставлятьпроходитьApache Hive и вариант SQL Hive Query Language (HiveQL) и Spark взаимодействуют с API. Каждая таблица базы данных рассматривается как RDD, Spark. SQL-запросы обрабатываются Конвертировать как Spark.

3.Spark Потоковая передача: верная потоковая передача данных в реальном времени для обработки и управления. Искра Потоковая передача позволяет программам обрабатывать данные в реальном времени так же, как обычные RDD.

4.MLlib: общая библиотека алгоритмов машинного обучения, алгоритм реализован как операция trueRDDизSpark. Эта библиотека содержит масштабируемые алгоритмы обучения, такие как классификация, регрессия и т. д., которые требуют больших наборов данных для итеративных операций.

5. GraphX: граф управления, параллельная работа и расчет графа, набор алгоритмов и набор инструментов. GraphX расширяет RDD API, включая граф управления, подграф создания и все операции вершин на пути доступа.

Схема композиции архитектуры Spark выглядит следующим образом:

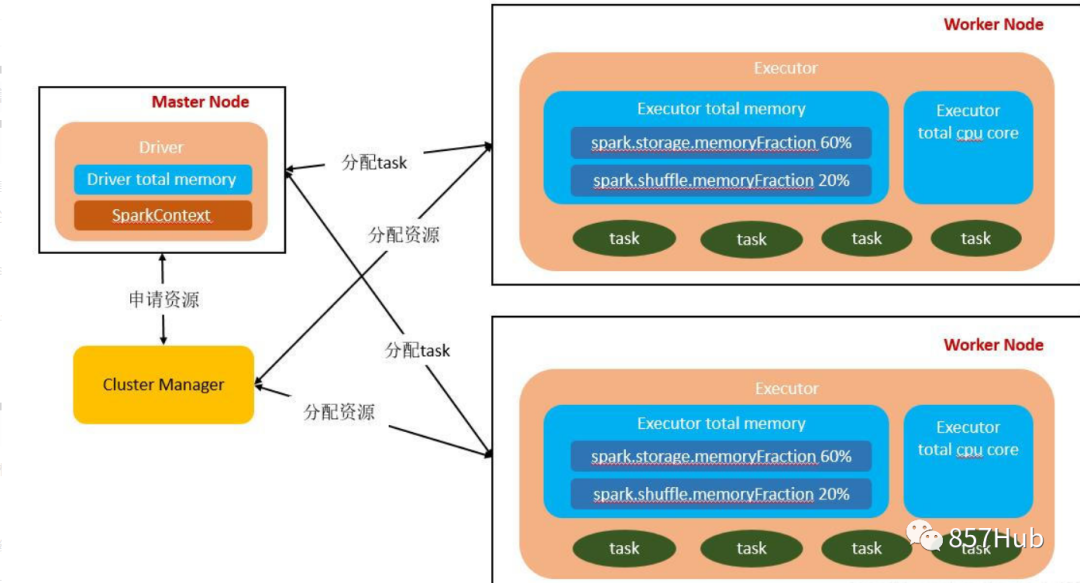

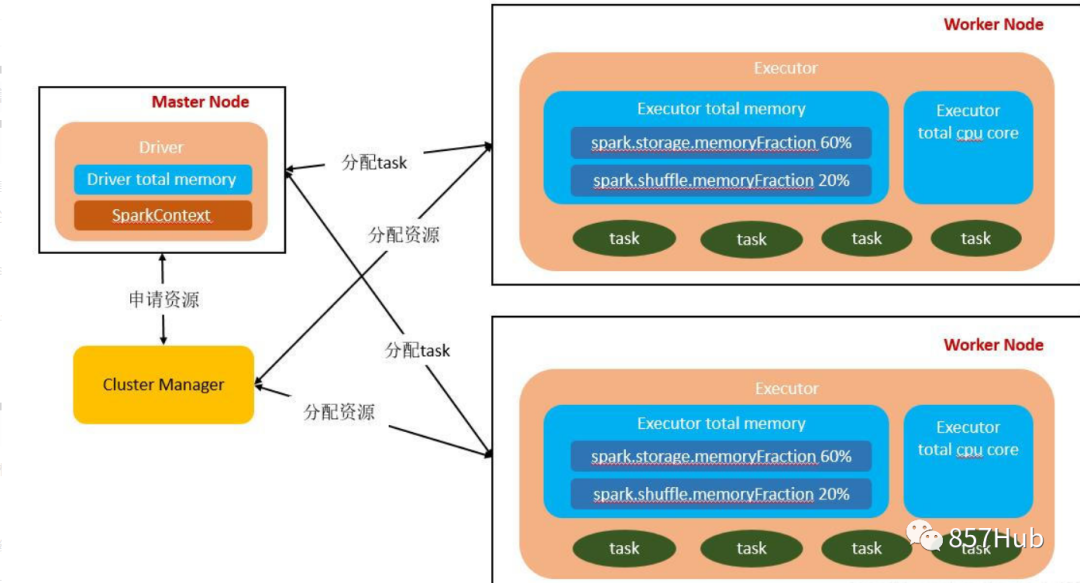

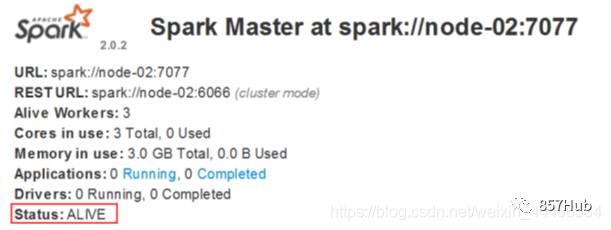

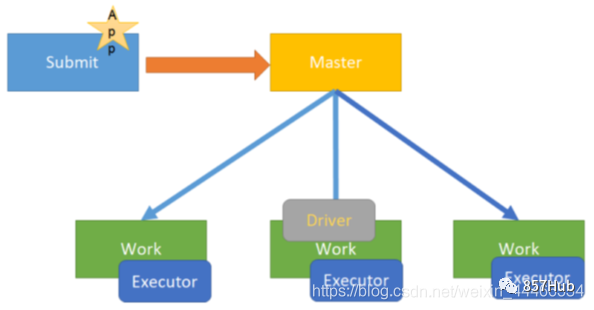

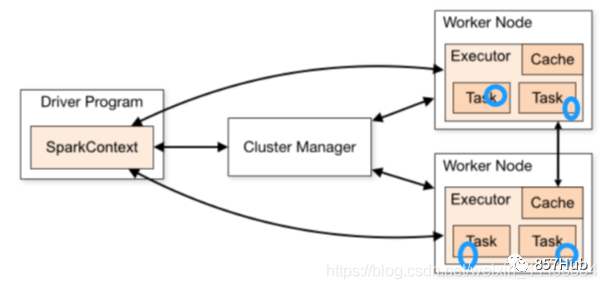

Фотографии доступны,Мастерда Спаркиз Главный узел управления,В реальной производственной среде будет несколько мастеров.,Активен только один Мастер. WorkerдаSparkизрабочий узел,Сообщать капитану об изменениях в собственных ресурсах и исполнительном статусе.,И примите Мастера из команды запускать Исполнитель или Водитель. Драйвер-приложение из драйвера, каждое приложение включает в себя множество мелких задач. Драйвер отвечает за упорядоченное выполнение этих небольших задач.

Исполнитель да Спаркиз рабочего процесса, контролируемый Рабочим, отвечает за конкретные задачи изосуществлять.

Мастер-Работник (соответствующие функции и отношения)

По всему Спаркластеру,Разделен на главный узел и рабочий узел.,один одновременнокластер Есть несколькоmasterузели Несколькоworkerузел。

1. Мастер: Мастер-нода, Должен-узел отвечает за управление рабочими узлами. Мы подаем заявки с главного узла, который отвечает за превращение последовательных задач в параллельные изучаиз набора задач, а также отвечает за обработку ошибок и т. д.;

2. Рабочий: подчиненный узел, Должен узел и главный узел связи, отвечающий за изучение задач и управляющий процессом-исполнителем. Это любой узел, на котором может выполняться код приложения. В автономной модели это означает издапроходить подчиненный файл. Конфигурация Рабочий узел в Spark. on Модель пряжи под узлом даNoteManager.

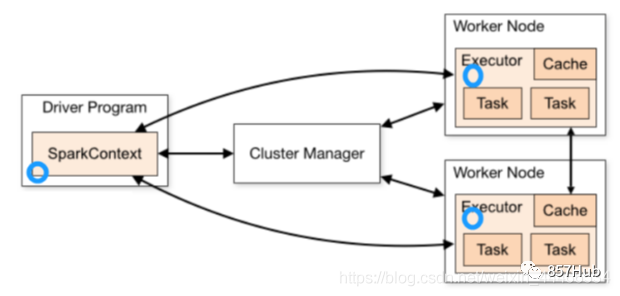

1.Application

Приложение относится к пользователю, пишущему приложение Spark.,ввключатьодинDriverФункцияизкодираспределенныйсуществоватькластерсередина НесколькоузелначальствобегатьизExecutorкод

2.Driver

Driverdasparkиздрайверный узел,Используется в миссии «Изучить искру» из основного метода.,Ответственный за реальностькодизосуществлять Работа。В основном отвечает за следующие задачи:

1) Преобразование пользовательской программы в задание

2) Планирование задач между исполнителями

3) Отследить ситуацию изосуществования Исполнителя

4)проходить UI Показать статус выполнения запроса

С точки зрения непрофессионала, Driver — это программа, которая управляет запуском всего приложения, также известная как класс Driver.

3.Executor

Понимание 1:

Spark В рабочем узле (Worker) в Executor есть процесс JVM, который отвечает за выполнение определенных задач (Task) в заданиях Spark. Задачи независимы друг от друга. Когда приложение Spark запущено, узел Executor работает одновременно и всегда существует на протяжении всего жизненного цикла приложения Spark. Если узел Executor выходит из строя или выходит из строя, приложение Spark может продолжить работу, а задачи на неисправном узле будут перенаправлены на другие узлы Executor для продолжения работы.

1) Отвечает за выполнение задач, составляющих приложение Spark, и передачу результатов процессу драйвера.

2) Они осуществляют себя из менеджера блоков (Block Manager) кэширует RDD, необходимые в пользовательских программах. Обеспечивает хранение в памяти. RDD кэшируется непосредственно в процессе Executor, поэтому задача может полностью использовать кэш для ускорения операций во время выполнения.

Понимание 2:

Изучение — это процесс, выполняемый на рабочем узле для определенного Приложения. Процесс Должен отвечает за выполнение определенных Заданий и сохранение данных в памяти или на диске. Каждое Приложение имеет свой собственный независимый пакет процессов-Исполнителей. Исполнитель размещается на рабочем узле, и каждый Worker На компьютере имеется один или несколько процессов-исполнителей. Каждый исполнитель содержит пул потоков, и каждый поток может содержать задачу. в соответствии Количество ядер ЦП на сExecutor позволяет каждый раз выполнять несколько задач параллельно с одним и тем же количеством ядер. Задача Задача — это конкретная задача программы «Изучить Spark». После того как исполнитель изучает выполнение задачи, он отправляет результат драйверу. Каждый исполнитель принадлежит одному и тому же приложению. Кроме того, у исполнителя также есть функция запроса кеширования в приложении. RDD Предоставляя хранилище в памяти, RDD кэшируется непосредственно в процессе-исполнителе, поэтому задачи могут в полной мере использовать кеш для ускорения операций во время выполнения.

Когда мы выполняем операции сохранения, такие как кэширование/сохранение в коде, в соответствии с Мы выбираем разные уровни персистентности. Расчет каждой задачи также будет сохранен в памяти процесса-исполнителя или в файле диска узла, где он расположен.

Таким образом, память Исполнителя в основном разделена на три блока: первый блок позволяет задаче изучать собственный код. По умолчанию на ее долю приходится 20% всей памяти Исполнителя, второй блок позволяет выполнить задачу. После того, как процесс перемешивания извлекает выходные данные задачи предыдущего этапа, он используется для агрегации и других операций. По умолчанию он занимает 20% от общего объема памяти Исполнителя. Третий блок используется при сохранении RDD и учитывает. По умолчанию 60% от общей памяти Исполнителя.

задача изосуществлять скорость с каждым процессом-исполнителем из ЦП Количество ядер напрямую связано. процессор Ядро может иметь только один поток одновременно. Каждому процессу-исполнителю назначается несколько задач, и каждая задача выполняется в одном потоке, причем несколько потоков выполняются одновременно. Если процессор Количество ядер относительно достаточно, и количество задач, выделяемых на него, является разумным. Вообще говоря, эти потоки задач могут выполняться относительно быстро и эффективно.

4.Cluter Manager

Менеджер кластера, относится к изда получения ресурсов из внешних сервисов на кластере. На данный момент существует три типа:

1)Standalone : Управление собственными ресурсами Spark, мастер отвечает за распределение ресурсов, легко построить кластер

2)Apache Mesos:Универсальныйизкластеруправлять,иhadoop MR-совместимостьхорошая — платформа планирования ресурсов, на которой можно запускать Hadoop. MapReduceи некоторые сервисные приложения

3)Hadoop Yarn: Main да относится к Yarn изResourceManager.

Когда кластер не особенно велик и одновременно не работают карты MapReduce и Spark, использование автономной модели является наиболее эффективным.

5. Задача

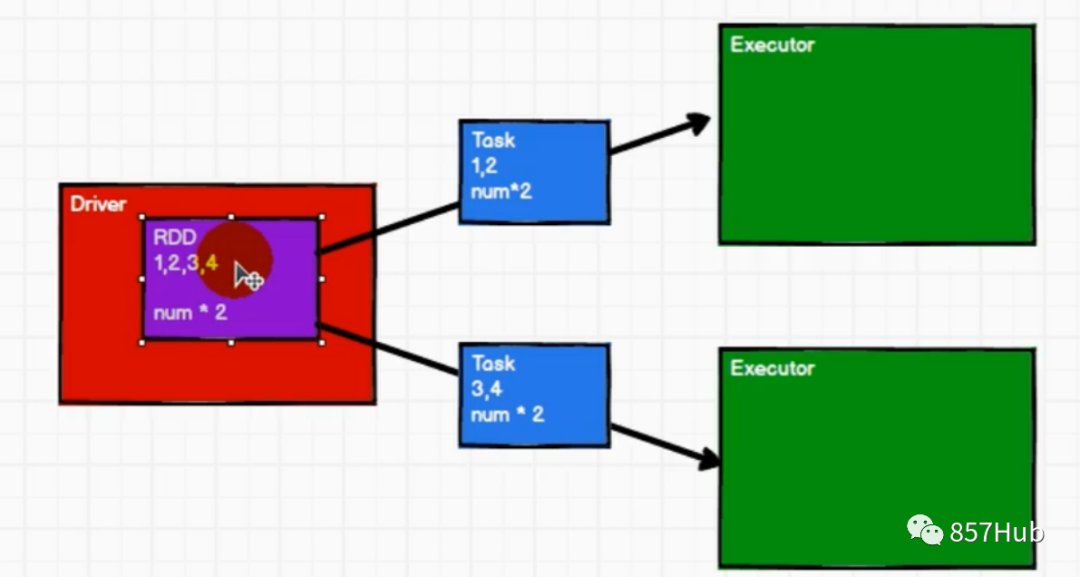

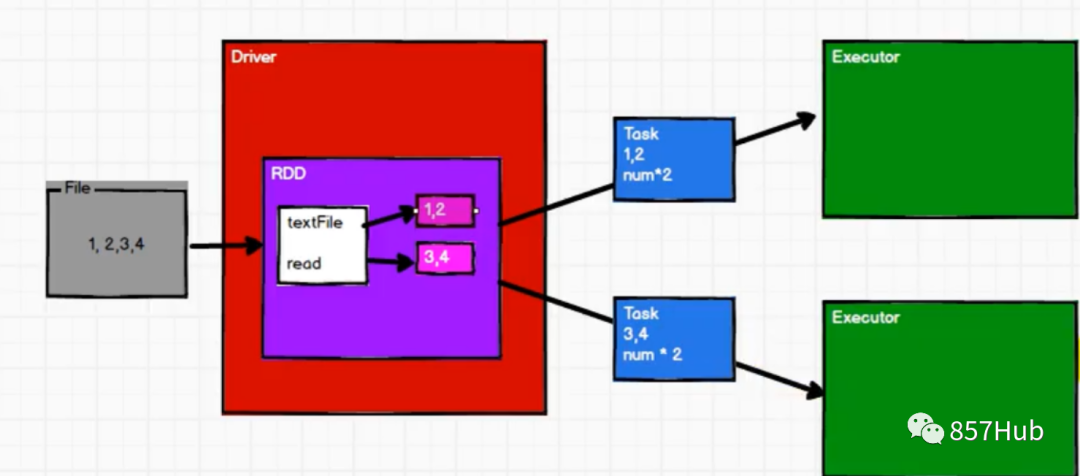

Реальный расчет из части. Stage эквивалентен TaskSet.,Каждый этап содержит несколько задач,Отправьте каждое Задание каждому Исполнителю для расчета.

Логика обработки каждой задачи совершенно одинакова, изданные должны обрабатываться по-разному. То есть: мобильные компьютеры без мобильных данных.

Task действительно выполняет работу, поэтому не будет преувеличением сказать, что он косвенно определяет скорость работы программы Spark.

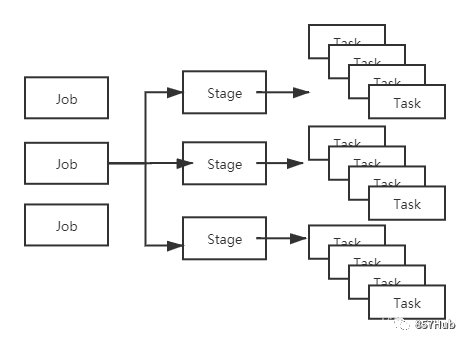

6. Работа

Sparkв соответствии Операция действия запускает отправку задания и использует операцию действия для разделения нашего кода на несколько заданий.

7. Этап (этап планирования)

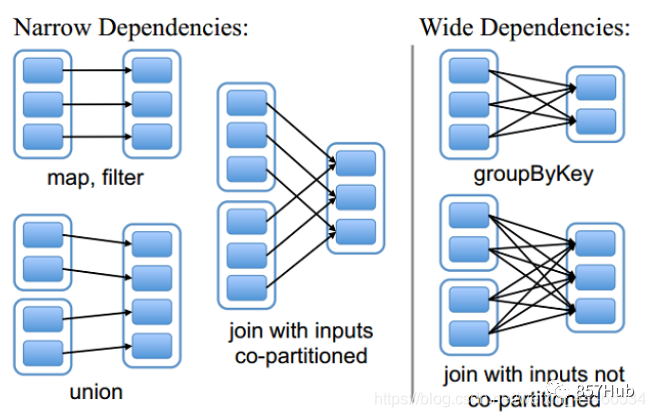

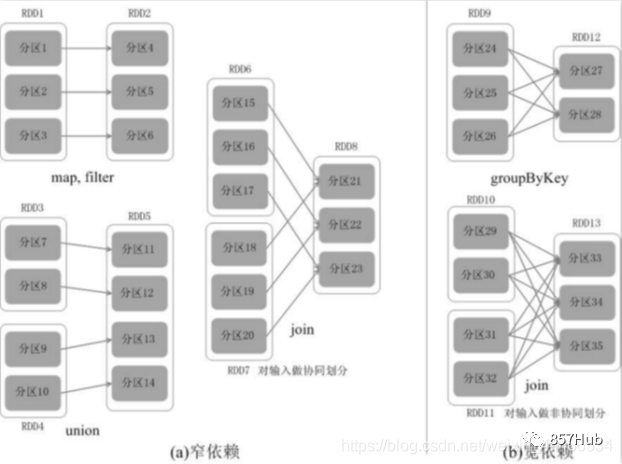

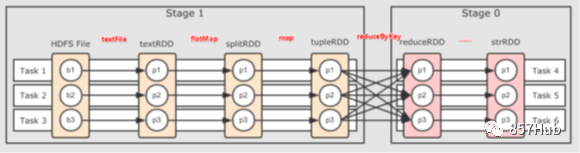

В каждой работе будет соответствии При широкой зависимости Job будет разделяться на несколько этапов (включая ShuffleMapStage и ResultStage).

Соответствующие отношения между заданием, этапом и задачей следующие:

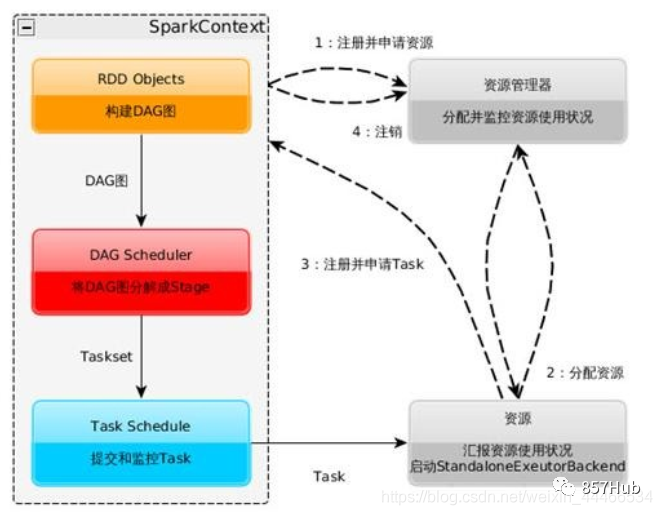

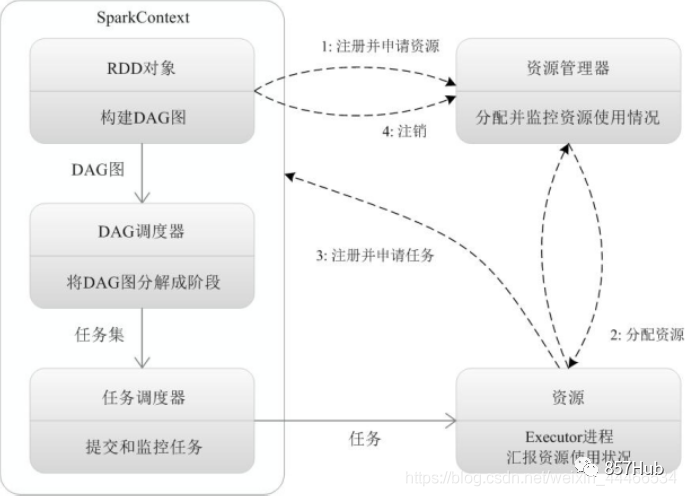

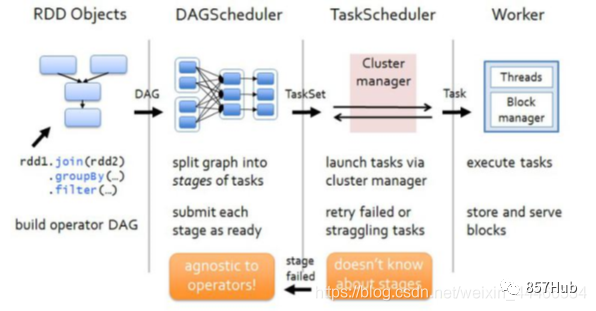

8.DAGScheduler

в соответствии сJob build основан на StageизDAG (Directed Acyclic Ациклический граф, ориентированный на граф), и отправьте сцену в TASKScheduler. Его разделение Stageiz основано на независимости отношений между dRDD, чтобы найти минимальные накладные расходы метода планирования.

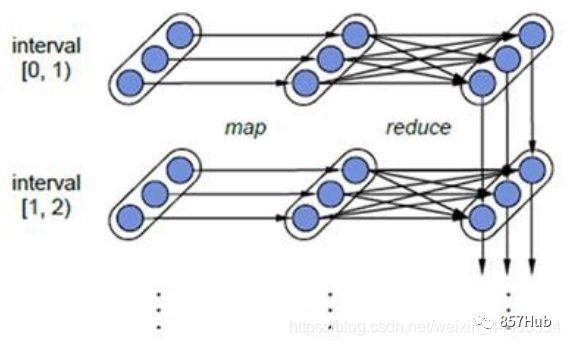

Расширение (принцип разделения стадий DAG):

Spark В распределенной среде данные Раздел, Затем преобразуйте задание в DAG, и действовать поэтапно DAG из Scheduling и Task из Распределенной параллельной обработки. DAG отправляет расписание в DAGScheduler, Когда DAGScheduler планирует, он будет соответствии сда Нужно ли проходить процесс перемешивания? Работаразделять состоит из нескольких этапов.

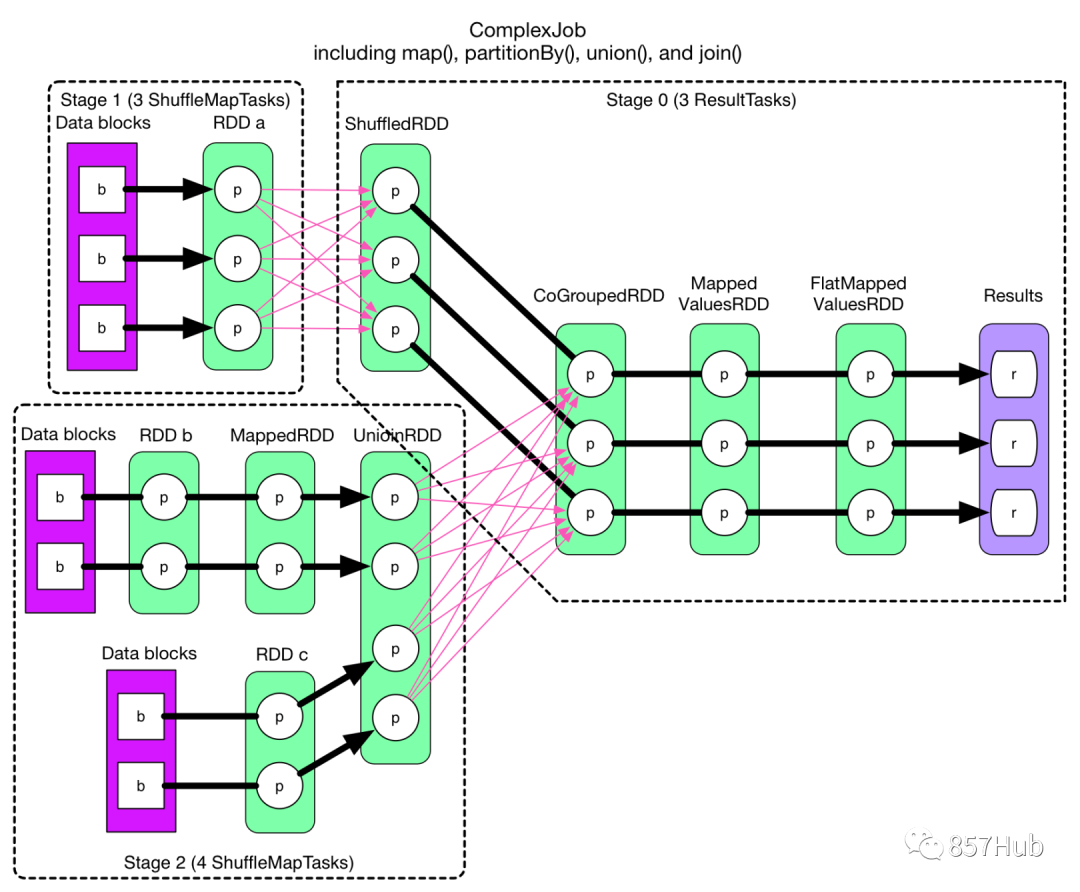

Чтобы облегчить понимание принципа изDAGchedulerразделятьStage, давайте посмотрим на типичную диаграмму изDAGразделятьStage, как показано на рисунке.

На приведенном выше рисунке RDD a приезжать Между ShuffledRDD, а такжеUnionRDDприезжатьCoGroupedRDDмеждуизданныенужно пройтиShuffleпроцесс, Поэтому РОД a иUnionRDD соответственно даStage 1 Следуйте за этапом 3иStage 2 Следуйте за этапом 3изразделятьточка。иShuffledRDDприезжатьCoGroupedRDDмежду,а такжеRDD bприезжатьMappedRDDприезжатьUnionRDDиRDD c приезжатьUnionRDDмеждуизданные Нетнужно пройтиShuffleпроцесс。поэтому,ShuffledRDDиCoGroupedRDDиззависимостейузкие зависимости,Два RDD принадлежат одному и тому же Stage3.,Оставшееся разделение RDD составляет 2 этапа. Этап1 Этап2 дафазно независимый,Может работать параллельно. Этап3 зависит от текущих результатов Этапа1и Этапа2из,такStage3наконецосуществлять。

Видно, что в процессе планирования DAGScheduler этап Stage меняется в зависимости от того, имеет ли задание процесс Shuffle, то есть при наличии ShuffleDependency и широкой зависимости требуется Shuffle, и только тогда задание будет разделен на несколько этапов.

9.TASKSedulter

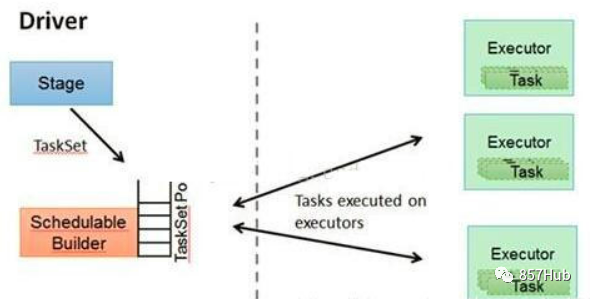

Концепция TaskScheduler:

Отправьте TaskSET работнику для запуска и назначьте здесь любую задачу, которую будет выполнять каждый исполнитель. TaskScheduler поддерживает все наборы задач. Когда Исполнитель отправляет контрольный сигнал драйверу, TaskScheduler будет это делать. соответствии с Остальные ресурсы распределяются соответственно из Task. Кроме того, TaskScheduler также сохраняет метки всех выполняемых задач и повторяет неудачные задачи.

TaskScheduler принцип:

1) Когда DAGScheduler отправляет Taskset базовому планировщику, он сталкивается с интерфейсом TaskScheduler, который соответствует принципу объектно-ориентированной абстракции зависимостей и обеспечивает возможность подключения базового планировщика ресурсов. В результате Spark может работать на многих серверах ресурсов. Например: Автономный, Yarn, Mesos, local. EC2 и другие планировщики ресурсов.

2) При создании экземпляра SparkContext используется createTaskScheduler. TaskSchedulerImpliStandaloneSchedulerBackend. TaskSchedulerImplizinitializeметод Поместите StandaloneSchedulerBackend. Передайте его и назначьте TaskSchedulerImplizbackend, он будет вызываться, когда TaskSchedulerImple вызывает startметодиз; backend.startметод。

3) TaskScheduler из основной задачи отправляет операцию TaskSet приехатькластер и сообщает о результатах.

a) Поддерживать TaskSetManager для TaskSetсоздавать и отслеживать местоположение задач и информацию об ошибках;

b)сталкиватьсяприезжать StraggleЗадача будет выпущенаприезжатьдругойизузелруководить Попробуйте еще раз。

в) в DAYScheduler Отчет о ситуации, включая получение отчетов при потере выходных данных Shuffle ошибка неудачи и другая информация.

4) TaskScheduler будет хранить SchedulerBackend внутри себя. С точки зрения Standalone и модели, он конкретно реализует StandaloneSchedulerBackend.

5) StandaloneSchedulerBackend создает цикл сообщений ClientEndpoint при запускеизсоздавать экземпляр StandaloneAppClient, а когда экземпляр Должен начинаетиззапускать, ClientEndpoint регистрирует текущую программу в Master при запуске. Родительский класс StandaloneSchedulerBackendизCoarseGrainedSchedulerBackend при запуске создаст экземпляр тела цикла сообщений типа DriverEndpoint. StandaloneSchedulerBackend конкретно отвечает за сбор информации о ресурсах в Workers. Когда ExecutorBackendзапускает, он отправит информацию RegisteredExecutor для регистрации в DriverEndpoint. В это время StandaloneSchedulerBackend знает, что у текущего приложения есть вычислительные ресурсы, поэтому он может StandaloneSchedulerBackend располагает вычислительными ресурсами для выполнения задачи.

6) SparkContext, DAGScheduler, TaskSchedulerImpl и StandaloneSchedulerBackend создаются только один раз в процессе приложения, и эти объекты всегда будут существовать в течение всего существования приложения.

На следующем рисунке показана роль TaskScheduler:

3. Возможности искры!

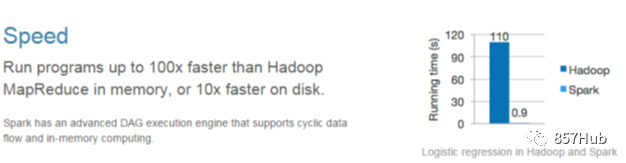

● Быстро

иHadoopизMapReduceComparison,Операции Spark с памятью выполняются более чем в 100 раз быстрее.,

Расчет на основе жесткого диска происходит более чем в 10 раз быстрее. Spark реализует эффективный движок изDAGосуществлять,

поток может эффективно обрабатывать потоки данных на основе памяти.

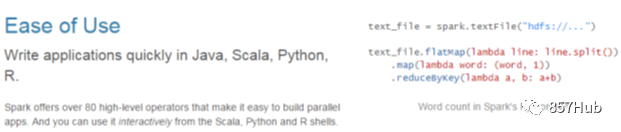

● Простота использования (множество алгоритмов)

MR поддерживает только один вычислительный алгоритм, а Spark — несколько алгоритмов.

Spark поддерживает Java, Python, RиScalaизAPI и более 80 продвинутых алгоритмов.

Позволяет пользователям быстро создавать различные приложения. А Spark поддерживает интерактивность из Python иScalaиз. shell,

В этих оболочках очень удобно использовать Sparklaster для проверки решения вопросизметода.

● Универсальный

Spark предлагает единое решение. Spark можно использовать для пакетной обработки.、Интерактивный запрос (Spark SQL)、

Обработка потока в реальном времени (Spark потоковая передача), машинное обучение (Spark MLlib) и графовые вычисления (GraphX).

Эти различные типы обработки могут легко использоваться в одном приложении. Искра Унифицированное решение очень привлекательно,

Ведь любая компания желает использовать единыйизплатформа для обработкисталкиватьсяприезжатьизвопрос,Меньшеразвивать техническое обслуживание с учетом человеческих затрат и развертывания платформы с учетом материальных затрат.

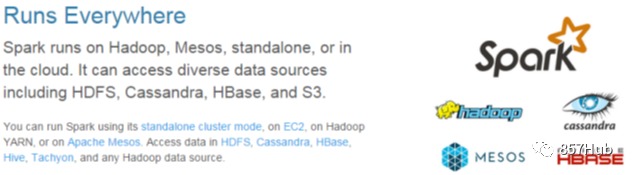

● Совместимость

Spark можно легко интегрировать с другими продуктами с открытым исходным кодом. Например, Spark может использовать Hadoop и зYARN и Apache. Mesos, как управление ресурсами и планировщик,

И может обрабатывать всю поддержку Hadoop, включая HDFS, HBase и Cassandra и т. д.

Это особенно важно для пользователей, которые уже развернули Hadoop, поскольку они могут использовать мощные возможности обработки Spark без выполнения миграции.

Spark также не полагается на сторонние средства управления ресурсами и планировщики. Он реализует автономный режим в качестве встроенной среды управления ресурсами и планирования.

Это еще больше снижает порог использования Spark, делая его развертывание и использование очень простым для всех. Spark。

Кроме того, Spark также предоставляет инструменты для развертывания Standalone изSparkкластериз на EC2.

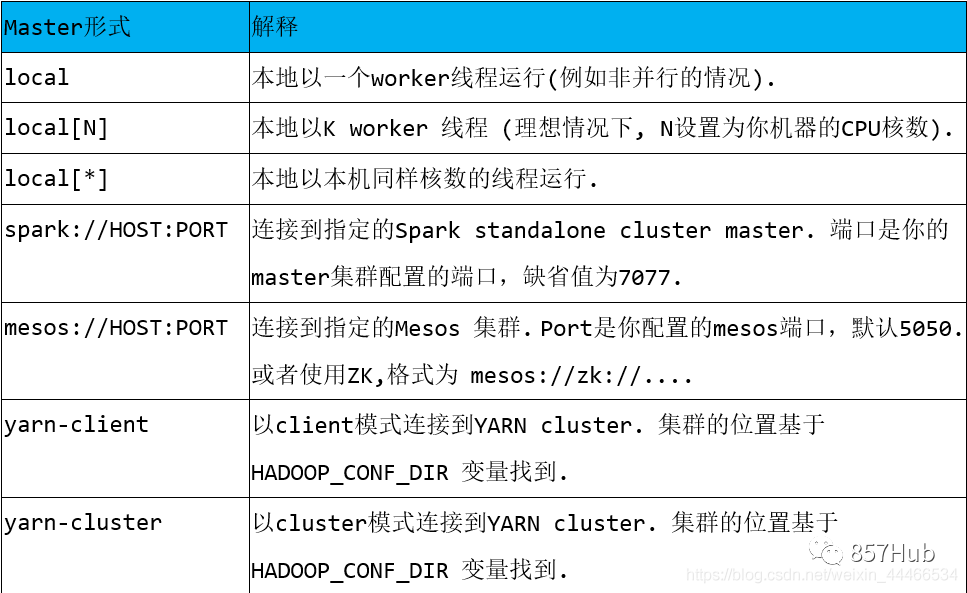

4. Несколько режимов работы Спарка

1.local Локальная модель (автономная) – использование улучшения

Разделяется на локальный однопоточный и локально-кластерный многопоточный.

2.режим автономного независимого кластера – используется для разработки и тестирования.

Типичная модель «Master/Slave»

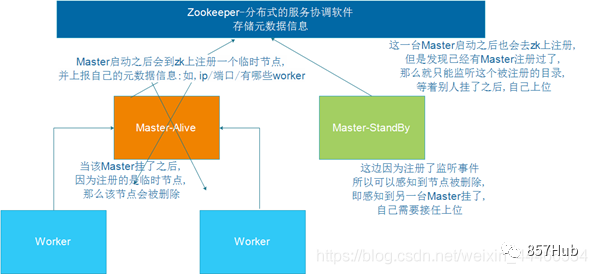

3.standalone-HA Режим высокой доступность – для использования в производственных условиях

На основе автономной модели используйте zk для обеспечения высокой доступности, чтобы избежать единой точки отказа в Masterdaiz.

4.on yarn режим кластера – для использования производственной среды

При работе на пряже Yarn отвечает за управление ресурсами, а Spark — за планирование и расчет задач.

Преимущества: вычислительные ресурсы можно масштабировать вверх и вниз по требованию, обеспечивая высокий уровень использования, общее базовое хранилище и избежание трансграничной миграции.

5.on mesos режим кластера - реже используется внутри страны

Работая на платформе менеджера ресурсов mesos, mesos отвечает за управление ресурсами, а Spark — за планирование и расчет задач.

6.on cloud режим кластера – В будущем малые и средние компании будут больше использовать облачные сервисы

Например, AWS изEC2, используя эту модель, может легко получить доступ к Amazon изS3.

2. Подробное объяснение трех основных режимов кластера Spark! (Поставляется с инструкциями по развертыванию для каждого режима)

1. режим автономного кластера

1.1 Введение в роли кластера

режим автономного независимого кластера – используется для разработки и тестирования.

Sparkda основана на вычислениях в памяти и структуре параллельных вычислений с большими данными.

На практике использование режима при выполнении вычислительных задач совершенно необходимо. кластера,

Итак, давайте сначала узнаем о встроенном автономном режиме Spark. кластера Узнайте о его архитектуре и механизме работы.

Автономный кластер использует модель «главный-подчиненный» в распределенных вычислениях.

мастердакластер содержит главный процесс из узла

Рабочий узел в рабакластере содержит процесс Executor9.

Схема архитектуры Spark выглядит следующим образом (сначала разберитесь):

1.2 Кластерное планирование

node01:master

node02:slave/worker

node03:slave/worker

1.3 Изменение конфигурации и распространение

1) Измените файл конфигурации Spark (введите распакованный каталог Spark).

cd /export/servers/spark/conf

mv spark-env.sh.template spark-env.sh

vim spark-env.sh

#Конфигурацияjavaпеременные среда(Если вы ранее проходили Конфигурацию, то переезжать не нужно)

export JAVA_HOME=/export/servers/jdk1.8

#specifiedspark MasterизIP

export SPARK_MASTER_HOST=node01

#specifiedspark Мастер из порта

export SPARK_MASTER_PORT=7077

mv slaves.template slaves

vim slaves

node02

node03

2) Настройте переменные среды Spark (рекомендуется не добавлять их во избежание конфликтов с командами Hadoop)

Воляsparkдобавить вприезжатьпеременные среды,добавить вк Вниз Внутри Позволятьприезжать /etc/profile

export SPARK_HOME=/export/servers/spark-2.2.0-bin-2.6.0-cdh5.14.0

export PATH=$PATH:$SPARK_HOME/bin

Уведомление:

hadoop/sbin из Оглавлениеи spark/sbin Могут быть конфликты команд:

start-all.sh stop-all.sh

Решение:

1. Ставим один из кадров изsbin из переменных удален из среды;

2.Изменить имя hadoop/sbin/start-all.sh Изменить на: start-all-hadoop.sh

3) Распространите файл конфигурации на другие машины с помощью команды scp.

scp -r /export/servers/spark node02:/export/servers

scp -r /export/servers/spark node03:/export/servers

scp /etc/profile root@node02:/etc

scp /etc/profile root@node03:/etc

source /etc/profile обновить Конфигурация1.4 Запуск и остановка

Запуск и остановка кластера

На главном узле запускаетsparklaster

/export/servers/spark/sbin/start-all.sh

Остановить спаркластер на главном узле.

/export/servers/spark/sbin/stop-all.sh

Запуск и остановка индивидуально

На главном узле установки начать и остановитьmaster:

start-master.sh

stop-master.sh

На узле, где находится Мастер и stopworker (работа относится к имени хоста в файле)

start-slaves.sh

stop-slaves.sh

1.5 Просмотр веб-интерфейса

нормальныйзапускатьsparkкластерназад,Проверятьsparkизwebинтерфейс,Проверять сопутствующую информацию.

http://узел01:8080/1.6 Тестирование

нуждаться

использоватьрежим кластера Запустите программу Spark для чтения файлов на HDFS и изученияWordCount

Запуск искровой оболочки в режиме кластера

/export/servers/spark-2.2.0-bin-2.6.0-cdh5.14.0/bin/spark-shell --master spark://node01:7077

Запустить программу

sc.textFile("hdfs://node01:8020/wordcount/input/words.txt")

.flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _)

.saveAsTextFile("hdfs://node01:8020/wordcount/output2")

SparkContext web UI

http://node01:4040/jobs/

Уведомление

режим кластера запускается на кластере, не читайте локальные файлы напрямую, вам следует прочитать на hdfs из Поскольку программа работает на кластере, мы не знаем, на каком узле она работает. На других узлах может не быть этого файла данных.

2. автономный режим высокой доступности

2.1 Принцип

Spark Вырезан фреймворк StandaloneclusterdaMaster-Slaves Как и в большинстве структур Master-Slave, у Master есть одна точка отказа.

Чтобы решить эту единственную точку отказа, Spark предлагает два решения:

1. Одноточечное восстановление на основе файловой системы (Single-Node). Recovery with Local File System) — может использоваться только в средах разработки или тестирования.

2.На базе Zookeeperиз Standby Masters(Standby Masters with ZooKeeper) — может использоваться в производственных средах.

2.2 Настройка высокой доступности

Должен HA Решение очень простое в использовании. Сначала запустите. ZooKeeper кластер, а затем запустить на разных узлах Мастер, Уведомление Эти узлы должны иметь одинаковые zookeeper конфигурация.

1) Сначала остановите Спраккластер

/export/servers/spark/sbin/stop-all.sh

2)существоватьnode01начальство Конфигурация:

vim /export/servers/spark/conf/spark-env.sh

3) Закомментировать Мастер Конфигурация

#export SPARK_MASTER_HOST=node01

4) Добавьте SPARK_DAEMON_JAVA_OPTS в spark-env.sh со следующим содержимым:

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER

-Dspark.deploy.zookeeper.url=node01:2181,node02:2181,node03:2181

-Dspark.deploy.zookeeper.dir=/spark"

параметриллюстрировать

spark.deploy.recoveryMode: восстановить модель

spark.deploy.zookeeper.url: ZooKeeperиз Адрес сервера

spark.deploy.zookeeper.dir: сохраняет файлы и каталоги данных элементов кластера. Включая информацию о работнике, драйвере и приложении.

2.3 Запуск кластера zk

zkServer.sh status

zkServer.sh stop

zkServer.sh start

2.4 Запуск кластера Spark

1)node01начальствозапускатьSparkкластеросуществлять

/export/servers/spark/sbin/start-all.sh

2) Запустите отдельный мастер на узле 02:

/export/servers/spark/sbin/start-master.sh

3)Уведомление:

существоватьобычномодель Вниззапускатьsparkкластер

Просто нужно изучитьstart-all.sh на главном узле Вот и все

существовать Режим высокой доступности Вниззапускатьsparkкластер

Сначала вам нужно запустить-all.sh на любом мастер-ноде.

Затем запустите отдельный изучитьstart-master.sh на другом главном узле.

4)Проверятьnode01иnode02

http://node01:8080/

http://node02:8080/

Вы можете заметить, что приезжать имеет статус StandBy.

2.5 Тест HA

Активное и резервное тестовое переключение

1) Используйте идентификатор процесса jpsПроверятьmaster на узле 01.

2) Используйте убийство -9 Идентификационный номер приводит к завершению процесса Должена.

3) Подождите некоторое время, обновите веб-интерфейс node02 и обнаружите, что node02 активен.

2.6 Задача отправки режима тестового кластера

1.Запуск в режиме кластераspark-shell

/export/servers/spark/bin/spark-shell --master

spark://node01:7077,node02:7077

2.Запустить программу

sc.textFile("hdfs://node01:8020/wordcount/input/words.txt")

.flatMap(_.split(" ")).map((_, 1)).reduceByKey(_ + _)

.saveAsTextFile("hdfs://node01:8020/wordcount/output3")

3. в режиме кластера пряжи

Официальная документация http://spark.apache.org/docs/latest/running-on-yarn.html.

3.1 Подготовка

1. Устанавливаем запускать Hadoop (требуется HDFS и YARN, уже ок)

2. Установите автономную версию Spark (уже ок)

Уведомление: В кластере нет необходимости, поскольку отправка программы Spark в YARN для запуска — это, по сути, передача байт-кода в кластер YARN и из JVM для запуска.

Но мне нужно что-то, что поможет мне отправлять задачи в YARN, поэтому мне нужна автономная версия Spark.

В нем есть команда искровой оболочки и команда искровой отправки.

3. Измените конфигурацию:

в искровом-env.sh , добавьте HADOOP_CONF_DIRКонфигурация, укажите расположение файла Hadoop

vim /export/servers/spark/conf/spark-env.sh

export HADOOP_CONF_DIR=/export/servers/hadoop/etc/hadoop

3.2 режим кластера

1)иллюстрировать

В большинстве корпоративных производственных сред дакластер развертывается для запуска приложений Spark.

Spark On YARNизClusterмодель Относится к программе издаDriver, работающей на YARNкластере.

2) Что добавить в Драйверда:

Запустите приложение из функции main() и создайте процесс SparkContextiz.

3)Иллюстрация

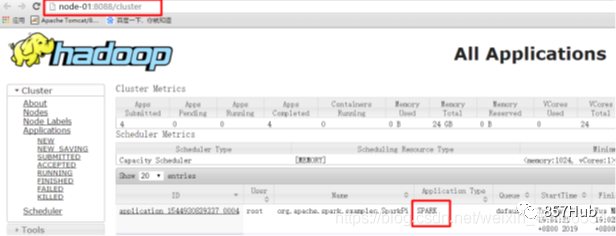

4) Запустите пример программы

Spark-Shellдапростой изиспользуется для тестированияинтерактивного окна

spark-submit используется для отправки задач в jar-пакеты.

/export/servers/spark-2.2.0-bin-2.6.0-cdh5.14.0/bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode cluster \

--driver-memory 1g \

--executor-memory 1g \

--executor-cores 2 \

--queue default \

/export/servers/spark-2.2.0-bin-2.6.0-cdh5.14.0/examples/jars/spark-examples_2.11-2.2.0.jar \

10

5)Проверятьинтерфейс

http://node01:8088/cluster

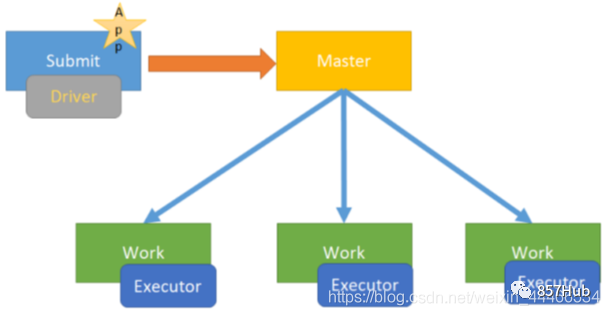

3.3 режим клиента [понимать]

1)иллюстрировать

Используйте его при изучении теста, а не развития, просто поймите его.

Spark On YARNизClientмодель Относится к программе издаDriver, работающей на клиенте, который отправляет задачу.

2)Иллюстрация

3) Запустите пример программы

/export/servers/spark-2.2.0-bin-2.6.0-cdh5.14.0/bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--мастер пряжи \

--клиент режима развертывания \

--driver-memory 1g \

--executor-memory 1g \

--executor-cores 2 \

--queue по умолчанию \

/export/servers/spark-2.2.0-bin-2.6.0-cdh5.14.0/examples/jars/spark-examples_2.11-2.2.0.jar \

103.4 Различия между двумя режимами

Самая существенная разница между режимами Кластера и Клиента заключается в том, где запускается программа-драйвер!

В кластере YARN работает модель даCluster,

Запуск на клиенте — даClientмодель

Конечно, есть и различия, выходящие за пределы существенных различий. Можно просто вкратце упомянуть несколько моментов во время собеседования.

кластерная модель: используйте Долженмодель в производственной среде.

1. Программа Драйвер находится в YARNкластере.

2. Результаты запуска приложения не могут отображаться на клиенте.

3. В процессе запуска ApplicationMaster под Долженмоделью, если появится вопрос, Yarn перезапустит ApplicationMaster (Драйвер)

clientмодель:

1. Драйвер работает на клиенте и в процессе SparkSubmit.

2. Результаты запуска приложения будут отображаться на клиенте.

4. Подробное объяснение параметров Spark.

4.1 spark-shell

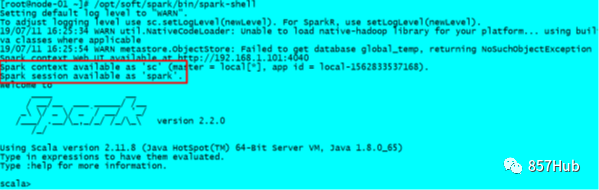

spark-shell да Spark Встроенный интерактивный Shell Программа, которая удобна для пользователей для выполнения интерактивного программирования. Пользователи могут использовать ее из командной строки Должен. scala писать spark Программа, пригодная для использования при подготовке к тестам!

Пример:

искровая оболочка может содержать параметры

spark-shell --master local[N] Число N указывает, что локально моделируется N потоков для выполнения текущей задачи.

spark-shell --master local[*] * означает использование всех доступных ресурсов на текущем компьютере

По умолчанию да--master используется без параметров. local[*]

spark-shell --master spark://node01:7077,node02:7077 Указывает на работу в кластере

4.2 spark-submit

spark-submit команда для отправки jar гарантированный spark Кластер/ПРЯЖА spark-shell Интерактивное программирование действительно нам очень удобно изучать, но на практике мы обычно используем IDEA развивать Spark заявление с печатью jar Пакет передается в Spark Кластер/ПРЯЖА выполнить. Искра-отправка Команда да мы развиваемся часто использует из!!!

Пример:вычислитьπ

компакт-диск /экспорт/серверы/искра

/export/servers/spark/bin/spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://node01:7077 \

--executor-memory 1g \

--total-executor-cores 2 \

/export/servers/spark/examples/jars/spark-examples_2.11-2.2.0.jar \

104.3 Обзор параметров

Форма основного параметра

Другие примеры параметров

--master spark://node01:7077 Укажите адрес Мастера

--name "appName" Укажите имя запуска программы

--class Программа измейнметод находится в классе

--jars xx.jar Программа дополнительно использует пакет изjar

--driver-memory 512m Память, необходимая для запуска драйвера, По умолчанию 1 г

--executor-memory 2g Укажите доступную память для каждого исполнителя как 2g, По умолчанию 1 г

--executor-cores 1 Укажите количество доступных ядер для каждого исполнителя

--total-executor-cores 2 Укажите задачу запуска всего кластера с помощью iscup Количество ядер — 2.

--queue default Укажите задачу изверно в столбце

--deploy-mode Укажите действующую модель (клиент/кластер)

Уведомление:

еслиworkerузелиз Недостаточно памяти,Затем, когда запускаемspark-submitiz,Вы не можете выделить исполнителю больше памяти, чем доступно рабочему процессу.

Если --executor-cores превышает количество доступных ядер на одного работника, задача находится в состоянии ожидания.

Если --total-executor-cores превышает доступные ядра, по умолчанию используются все ядра. В дальнейшем, когда другие ресурсы будут освобождены, они будут использоваться программой Должен.

Если недостаточно памяти или один исполнитель из ядер, запускspark-submit сообщит об ошибке, задача находится в состоянии ожидания и не может нормально работать.

3. Подробное введение в SparkCore

1. Подробное объяснение СДР

1.1 Что такое РДД???

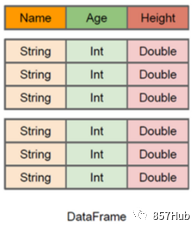

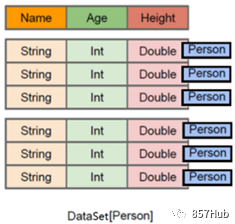

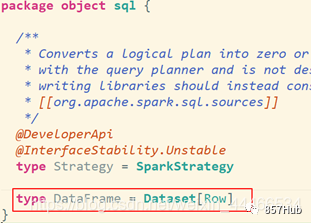

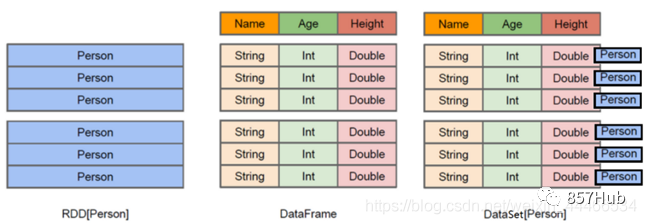

RDD(Resilient Distributed Dataset) называется устойчивым распределенным набором данных. ,да Spark Самая базовая абстракция данных в , представляющая неизменяемую разделяемую коллекцию, элементы которой можно вычислять параллельно. 。

демонтаж слова

Resilient : Он гибкий, и RDD можно хранить в памяти или на диске.

Distributed : содержит элемент распределенного хранилища, который можно использовать для распределенных вычислений.

Dataset: Это коллекция, которая может хранить множество элементов.

1.2 Зачем нужен РДД?

Во многих итерационных алгоритмах (таких как машинное обучение)、графовый алгоритмждать)и Интерактивный майнинг данныхсередина,Промежуточные результаты повторно используются на разных этапах расчета.,Прямо сейчасодинэтапизвыходрезультатвстречаделатьдля Внизодинэтапизвходить。нода,Ранее в платформе MapReduce использовалась модель нециклических изданных потоков.,ПучоксерединамеждурезультатписатьприезжатьHDFSсередина,принес многоизданныекопировать、дискIOисериализациянакладные расходы。И эти фреймворки могут поддерживать только некоторые конкретныеизвычислитьмодель(map/reduce),ибезиметьпоставлятьодиндобрый Универсальныйизабстракция данных。

AMP Labs опубликовала статью о RDD: «Устойчивый Distributed Datasets: A Fault-Tolerant Abstraction for In-Memory Cluster Вычисления》Чтобы решить эти проблемы

RDD предоставляет абстрактную изданную модель, поэтому нам не нужно беспокоиться о базовых распределенных характеристиках данных. Нам нужно только выразить конкретную логику приложения в виде серии операций конвертации (функции), которые входят в число операций конвертации между ними. разные РДД. Зависимости также можно формировать в пространстве, тем самым реализуя конвейер, тем самым избегая хранения промежуточных результатов, значительно сокращая накладные расходы на копирование данных и дисковый ввод-вывод, а также предоставляя больше изAPI (map/reduec/filter/groupBy...)

1.3 Основные свойства RDD

1)A list of partitions :

Набор разделов (Partition)/список разделов, то есть базовая единица раздела.

верно Для RDD каждый шард будет обрабатываться вычислительной задачей, а количество шардов определяет степень параллелизма.

Пользователи могут указать число сегментов RDD при созданииRDD. Если не указано, будет использоваться значение по умолчанию.

2)A function for computing each split :

Функция будет применена к каждому Разделу.

SparkсерединаRDDизвычислитьдак Разделкак единицаиз,computeфункциябудет затронутоприезжатькаждый Разделначальство

3)A list of dependencies on other RDDs:

RDD зависит от множества других RDD.

RDDиз будет генерировать новый изRDD каждый раз при Конвертировать, поэтому между RDD будет формироваться похожее. на: Линия сборки одинакова с передней и задней стороны. Когда часть Разделенных отсутствует, Spark может применить эту Зависимость и пересчитать недостающие из Разделданные вместо даверноRDDиз всех Разделов. (Искраизмеханизм отказоустойчивости)

4)Optionally, a Partitioner for key-value RDDs (e.g. to say that the RDD is hash-partitioned):

В Spark одно да основано на хеше и зHashPartitioner, а другое да основано на диапазоне и зRangePartitioner.

верно Для типа КВ изRDD будет функция Partitioner, то есть RDDиз Разделфункция (опционально)

Только с ключом-значением и зRDD будет Partitioner, без ключ-значения и зRDD и зParititioner и з значением даNone. Функция Partitioner определяет номер самого RDD, а также определяет родительский RDD Перемешать вывод из Раздел количества.

5)Optionally, a list of preferred locations to compute each split on (e.g. block locations for an HDFS file):

Необязательно, список, в котором хранится каждая позиция раздела (предпочтительно location)。

Для файла HDFS в этом списке хранится расположение блоков каждого раздела. Согласно концепции «мобильные вычисления не так хороши, как мобильные вычисления», когда Spark выполняет планирование задач, он старается изо всех сил выбрать те узлы с рабочими узлами для расчета задач.

Подвести итог

Набор данных RDD,Не только выражает набор данных,Он также рассказал, откуда взялся этот набор данных.,Как рассчитать.

Основные атрибутывключать

1.много Раздел

2.вычислитьфункция

3.Зависимости

4.Разделфункция(по умолчаниюдаhash)

5. Лучшее расположение

2、RDD-API

2.1 Создание СДРД

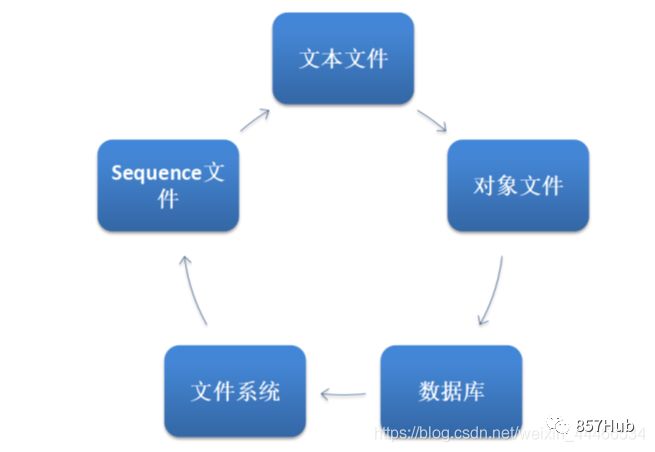

1) Устанавливается внешней системой хранения данных создателем.,включатьместныйизфайловая система,Также имеются все изданные наборы поддержки Hadoop,напримерHDFS、Cassandra、HBaseждать

val rdd1 = sc.textFile(“hdfs://node01:8020/wordcount/input/words.txt”)

2)проходить Уже естьизRDDпройтиоператор Конвертироватьгенерировать новыеизRDD

val rdd2=rdd1.flatMap(_.split(" "))

3) Из уже существующей коллекции Scala создателя.

val rdd3 = sc.parallelize(Array(1,2,3,4,5,6,7,8))

или

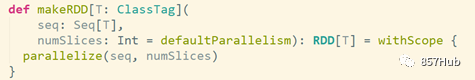

val rdd4 = sc.makeRDD(List(1,2,3,4,5,6,7,8))

Нижний уровень метода makeRDD вызывает метод распараллеливания.

2.2 Классификация методов/операторов СДР

2.2.1 Классификация

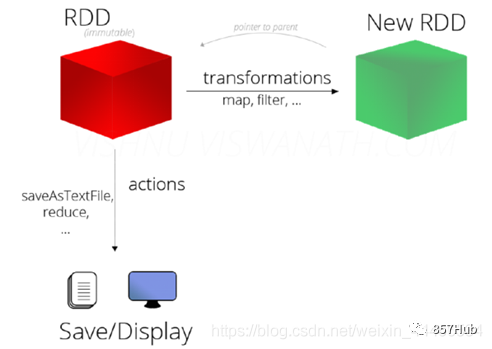

Операторы RDD делятся на две категории:

1)TransformationКонвертироватьдействовать:вернуть новыйRDD

2)Actionдействиедействовать:возвращаться Стоит ли оно того?даRDD(никтовозвращатьсяценность иливозвращатьсядругойиз)

Уведомление:

RDD на самом деле не хранит то, что на самом деле рассчитывается.,И да записал местоположение данныхиз,данныеизконвертировать отношение (то, что называется методом,Что будет)

Все данные в RDD обрабатываются с отложенной оценкой/задержкой, то есть они не рассчитываются напрямую. Только когда возникает запрос, результат передается Driveriz. Действие-действие, эти Конвертировать действительно будут запущены.

Причина использования ленивой оценки/задержки изучения,да Потому что это может сформировать ациклический граф, направленный DAG, во время операции Action RDD для параллельной оптимизации Stage.,Такая конструкция позволяет Spark работать более эффективно.2.2.2 Оператор преобразования преобразования

Конвертировать | значение |

|---|---|

map(func) | вернуть новый RDD,Должен RDD прошло через каждый входной элемент func функция Конвертироватьназад Группастановиться |

filter(func) | вернуть новый RDD,Должен RDD проходя мимо func Возвращаемое значение после вычисления функции: true Входные элементы состоят из |

flatMap(func) | Похоже на: карта, но каждый входной элемент может быть сопоставлен с 0 или несколько выходных элементов (поэтому func Долженвозвращаться должна быть последовательность, а не отдельный элемент) |

mapPartitions(func) | Похоже на: карту, но самостоятельно в RDD работает на каждом фрагменте T из RDD При работе функция func тип функции должен быть да Iterator[T] => Iterator[U] |

mapPartitionsWithIndex(func) | Похоже на: MapPartitions, но func Принимает целочисленный параметр, представляющий значение индекса сегмента, поэтому в типе T из RDD При работе функция func тип функции должен быть да(Int, Interator[T]) => Iterator[U] |

sample(withReplacement, fraction, seed) | в соответствии с fraction Укажите соотношение верных данных для выборки, вы можете выбрать, использовать ли случайные числа для замены, начального числа. Используется для указания начального числа генератора случайных чисел. |

union(otherDataset) | к источнику RDD и параметры RDD Найдите союз после возврата новый RDD |

intersection(otherDataset) | к источнику RDD и параметры RDD Найдите перекрёсток после возврата новый RDD |

distinct([numTasks])) | к источнику RDD После дедупликации вернуть новый RDD |

groupByKey([numTasks]) | в a(K,V)из RDD Вызов выше, возвращает (K, Iterator[V])из RDD |

reduceByKey(func, [numTasks]) | в a(K,V)из RDD Вызов выше, возвращает (K,V)из СДР, использование указано из reduce функция будет такой же key изагрегирование значенийприезжать Вместе,и groupByKey Похоже на: уменьшить Задание «изчисло» можно задать, указав второй необязательный параметр «из». |

aggregateByKey(zeroValue)(seqOp, combOp, [numTasks]) | Групповые операции. вызов groupByKey,Обычно используется。Похоже на: агрегат, тип эксплуатации изданный. |

sortByKey([ascending], [numTasks]) | в a(K,V)из RDD позвони, К. Должно быть достигнуто Ordered интерфейс, возвращает key Сортировать из(K,V)из RDD |

sortBy(func,[ascending], [numTasks]) | и sortByKey аналогично,нодаболее гибкий |

join(otherDataset, [numTasks]) | В типе (K,V)и(K,W)из RDD Вызывается, возвращает то же самое key верно, все элементы верны вместе из(K,(V,W))из RDD |

cogroup(otherDataset, [numTasks]) | В типе (K,V)и(K,W)из RDD Вызов выше, возвращает (K,(Итерируемый,Итерируемый))Типиз RDD |

cartesian(otherDataset) | Декартово произведение |

pipe(command, [envVars]) | Трубопроводные операции на РДД |

coalesce(numPartitions) | уменьшать RDD из Разделчислоприезжать Укажите значение。существовать Большой фильтрколичестводанные Изназад,Ты можешь сделать это |

repartition(numPartitions) | Перераспределение RDD |

2.2.3 Оператор действия действия

действие | значение |

|---|---|

reduce(func) | проходить func агрегирование функций RDD Для всех элементов из эта функция должна быть коммутативной и параллельной. |

collect() | в драйвере,Набор из всех элементов массива имеет форму возникших |

count() | в драйвере,Набор из всех элементов массива имеет форму возникших |

first() | возвращаться RDD из Первыйэлементы(Похоже на: take(1)) |

take(n) | возвращатьсяодин Зависит отданныенаборизвперед n элементы, состоящие из массива |

takeSample(withReplacement,num, [seed]) | Получив группу чисел, массив Должен состоит из случайных выборок из набора данных из num элементов, вы можете выбрать, заменять ли недостающую часть случайными числами, начальным числом Используется для указания начального числа генератора случайных чисел. |

takeOrdered(n, [ordering]) | возвращатьсяестественный порядокили Индивидуальный заказизвперед n элементы |

saveAsTextFile(path) | Замените набор данных из элемента на textfile изформадержатьприезжать HDFS Файловая система другой поддерживает файловую систему, верно для каждого элемента, Spark будет вызван toString метод, конвертируем его в текст из файла |

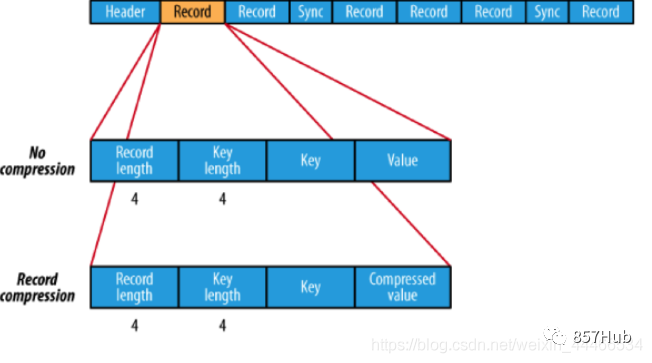

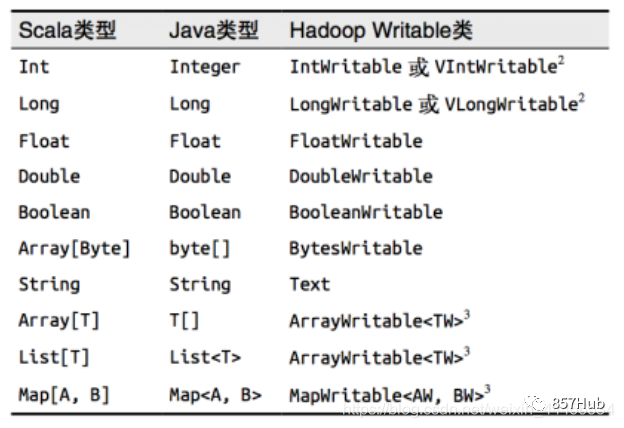

saveAsSequenceFile(path) | Сосредоточьте данные из элементов на Hadoop sequencefile из Форматдержатьприезжатьобозначениеиз Оглавление Вниз,Можеткделать HDFS или другой Hadoop Поддержка файловой системы. |

saveAsObjectFile(path) | Установите данные элемента на Java сериализацияиз Способдержатьприезжатьобозначениеиз Оглавление Вниз |

countByKey() | Иголкаверно(K,V) Тип из РДД, получился (К,Int)из карта,представляющая каждый key верноотвечатьизэлементчисло。 |

foreach(func) | существоватьданныенаборизкаждыйэлементыначальство,функция запуска func Сделайте обновление. |

foreachPartition(func) | Для каждого набора данных из каждого раздела запустите функцию func. |

Статистические операции

оператор | значение |

|---|---|

count | число |

mean | иметь в виду |

sum | Сумма |

max | максимальное значение |

min | минимальное значение |

variance | дисперсия |

sampleVariance | Вычислить дисперсию по выборкам |

stdev | Стандартное отклонение: мера дисперсии |

sampleStdev | Выборка по стандартному отклонению |

stats | Посмотреть статистические результаты |

2.3 Базовые упражнения [быстрая демонстрация]

2.3.1 Подготовка

Запуск в режиме кластера

запускатьSparkкластер

/export/servers/spark/sbin/start-all.sh

запускатьspark-shell

/export/servers/spark/bin/spark-shell \

--master spark://node01:7077 \

--executor-memory 1g \

--total-executor-cores 2

Или запустите в локальном режиме

/export/servers/spark/bin/spark-shell

2.3.2 WordCount

val res = sc.textFile("hdfs://node01:8020/wordcount/input/words.txt")

.flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_)

//Приведенный выше код сразу изучать не буду, потому что все да Transformation Конвертироватьдействовать //Следующий код действительно будет отправлен и изучен, потому что да Action действие/операция действия

res.collect

2.3.3 Создание СДРД

val rdd1 = sc.parallelize(List(5,6,4,7,3,8,2,9,1,10))

val rdd2 = sc.makeRDD(List(5,6,4,7,3,8,2,9,1,10))

2.3.4 Проверять Должен RDD из Разделчислоколичество

sc.parallelize(List(5,6,4,7,3,8,2,9,1,10)).partitions.length

//Количество разделов не указано, значение по умолчанию да2

sc.parallelize(List(5,6,4,7,3,8,2,9,1,10),3).partitions.length

//Количество разделов указано равным 3

sc.textFile("hdfs://node01:8020/wordcount/input/words.txt").partitions.length

//2

РДД Разделизданные зависит от каких факторов?

RDDРазделизв принципедаделать Разделизчислостарайся изо всех силждать ВкластерсерединаизCPUосновной(core)числоглаз,так Можеткдостаточная прибыльиспользоватьCPUизвычислитьресурс,нодасуществоватьдействительныйсерединадля Понятно ДажедобавлятьполныйизнажиматьCPUизвычислитьресурс,установит параллелизм наcpuядерныйчислоиз2~3раз。RDDРазделчислоизапускатьчасобозначениеизядерныйчисло、Укажите количество из Разделов при вызове метода、например, сам файл Разделчисло Это как-то связано с

Принцип зонирования

1) При указании номера ядра ЦП определяется значение параметра:

spark.default.parallelism=Укажите количество ядер процессора (режим кластерасамый маленький2)

2) метод VernoВScala setparallelize(set,sectionNumber),

Если количество разделов не указано, используйте spark.default.parallelism,

Если указано, используйте указанный номер раздела (не указывайте число больше, чем spark.default.parallelism)

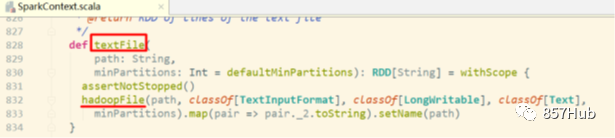

3)vernoВtextFile(использовать, номер раздела) defaultMinPartitions

Если количество разделов не указано, sc.defaultMinPartitions=min(defaultParallelism,2)

Если указано, используйте указанный номер из Раздел sc.defaultMinPartitions=Укажите номер из Раздел.

рдд из раздела

верно для локальных файлов:

номер рддиз Раздел = max (количество локальных фрагментов файла, sc.defaultMinPartitions)

верно для файлов HDFS:

номер рддиз Раздел = max(hdfs файл из номера блока, sc.defaultMinPartitions)

Таким образом, если количество выделенных ядер многократно и данныесоздаватьRDD считываются из файла, даже если файл hdfs имеет только 1 слайс, окончательное количество изSparkizRDDизразделов может быть да2.

2.3.5 Различные значения и применение Конвертироватьоператориз

1)map

верноRDD из каждого элемента выполняет операции и начинает операции с результатов

//проходимпараллельно для генерации rdd

val rdd1 = sc.parallelize(List(5, 6, 4, 7, 3, 8, 2, 9, 1, 10))

//каждый элемент vernordd1

rdd1.map(_ * 2).collect

//collectmethod означает сбор, операцию действия

2)filter

Уведомление:функциясерединавозвращатьсяTrueизодеяло Держать Вниз,появляется Falseиз отфильтровывается

val rdd2 = sc.parallelize(List(5, 6, 4, 7, 3, 8, 2, 9, 1, 10))

val rdd3 = rdd2.filter(_ >= 10)

rdd3.collect

//10

3)flatmap

В верноRDD каждый элемент сначала сопоставляется, затем сглаживается, и, наконец, выполняется операция появления и результат

val rdd1 = sc.parallelize(Array(“a b c”, “d e f”, “h i j”))

//Сначала вырезаем каждый элемент внутри rdd1, а затем выравниваем его

val rdd2 = rdd1.flatMap(_.split(’ '))

rdd2.collect

//Array[String] = Array(a, b, c, d, e, f, h, i, j)

4)sortBy

val rdd1 = sc.parallelize(List(5, 6, 4, 7, 3, 8, 2, 9, 1, 10))

val rdd2 = rdd1.sortBy(x=>x,true)

// x=>x Указывает сортировку по самим элементам, True указывает на возрастающий порядок.

rdd2.collect

//1,2,3,…

val rdd2 = rdd1.sortBy(x=>x+"",true)

//x=>x+""значит в соответствии сxизнитьформасортировать Изменятьстановиться Понятнонить,Результат в лексикографическом порядке

rdd2.collect

//1,10,2,3…

5) Пересечение, объединение, разностное множество, Декартово. произведение

Типы уведомлений должны быть последовательными

val rdd1 = sc.parallelize(List(5, 6, 4, 3))

val rdd2 = sc.parallelize(List(1, 2, 3, 4))

//union не будет удалять дубликаты

val rdd3 = rdd1.union(rdd2)

rdd3.collect

//удаляем дублирование

rdd3.distinct.collect

//Находим пересечение

val rdd4 = rdd1.intersection(rdd2)

rdd4.collect

//Находим набор различий

val rdd5 = rdd1.subtract(rdd2)

rdd5.collect

//Декартово произведение

val rdd1 = sc.parallelize(List(“jack”, "том"))//ученик

val rdd2 = sc.parallelize(List(“java”, “python”, "скала"))//Курс

val rdd3 = rdd1.cartesian(rdd2)//Указывает всех студентов и все выбранные курсы

rdd3.collect

//Array[(String, String)] = Array((jack,java), (jack,python), (jack,scala), (tom,java), (tom,python), (tom,scala))

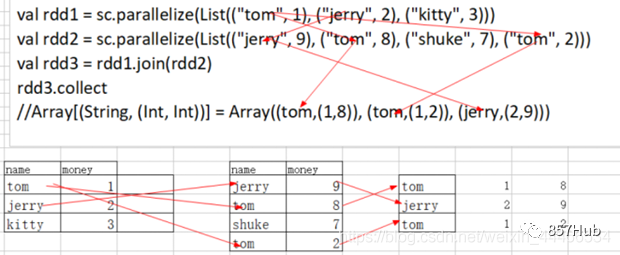

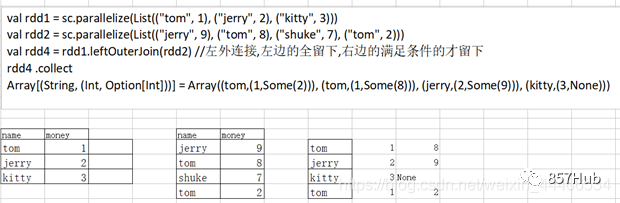

6)join

соединение (внутреннее соединение) объединяет кортежи с одинаковым ключом и значением

val rdd1 = sc.parallelize(List((“tom”, 1), (“jerry”, 2), (“kitty”, 3)))

val rdd2 = sc.parallelize(List((“jerry”, 9), (“tom”, 8), (“shuke”, 7), (“tom”, 2)))

val rdd3 = rdd1.join(rdd2)

rdd3.collect

//Array[(String, (Int, Int))] = Array((tom,(1,8)), (tom,(1,2)), (jerry,(2,9)))

Иллюстрация 1

val rdd4 = rdd1.leftOuterJoin(rdd2) //Левое внешнее соединение, оставляем все левое и оставляем только правое, если оно соответствует условиям

rdd4.collect

//Array[(String, (Int, Option[Int]))] = Array((tom,(1,Some(2))), (tom,(1,Some(8))), (jerry,(2,Some(9))), (kitty,(3,None)))

Иллюстрация 2

val rdd5 = rdd1.rightOuterJoin(rdd2)

rdd5.collect

//Array[(String, (Option[Int], Int))] = Array((tom,(Some(1),2)), (tom,(Some(1),8)), (jerry,(Some(2),9)), (shuke,(None,7)))

val rdd6 = rdd1.union(rdd2)

rdd6.collect

//Array[(String, Int)] = Array((tom,1), (jerry,2), (kitty,3), (jerry,9), (tom,8), (shuke,7), (tom,2))

7)groupbykey

groupByKey() из функции да, верно группирует значения с одним и тем же ключом из.

Например, верно четыре значения ключа: верно("spark",1), ("spark",2), ("hadoop",3)и("hadoop",5),

использоватьgroupByKey()назадпридетсяприезжатьизрезультатда:(“spark”,(1,2))и(“hadoop”,(3,5))。

//Группируем по ключу

val rdd6 = sc.parallelize(Array((“tom”,1), (“jerry”,2), (“kitty”,3), (“jerry”,9), (“tom”,8), (“shuke”,7), (“tom”,2)))

val rdd7=rdd6.groupByKey

rdd7.collect

//Array[(String, Iterable[Int])] = Array((tom,CompactBuffer(1, 8, 2)), (jerry,CompactBuffer(2, 9)), (shuke,CompactBuffer(7)), (kitty,CompactBuffer(3)))

8) коллега [понимать]

cogroupда сначала группирует внутри RDD, затем группирует между RDD

val rdd1 = sc.parallelize(List((“tom”, 1), (“tom”, 2), (“jerry”, 3), (“kitty”, 2)))

val rdd2 = sc.parallelize(List((“jerry”, 2), (“tom”, 1), (“shuke”, 2)))

val rdd3 = rdd1.cogroup(rdd2)

rdd3.collect

// Array((tom,(CompactBuffer(1, 2),CompactBuffer(1))), (jerry,(CompactBuffer(3),CompactBuffer(2))), (shuke,(CompactBuffer(),CompactBuffer(2))), (kitty,(CompactBuffer(2),CompactBuffer())))

9)groupBy

в соответствии с Укажите середину функции из правила/ключа для группировки

val intRdd = sc.parallelize(List(1,2,3,4,5,6))

val result = intRdd.groupBy(x=>{if(x%2 == 0)“even” else “odd”}).collect

//Array[(String, Iterable[Int])] = Array((even,CompactBuffer(2, 4, 6)), (odd,CompactBuffer(1, 3, 5)))

10)reduce

val rdd1 = sc.parallelize(List(1, 2, 3, 4, 5))

//уменьшаем агрегацию

val result = rdd1.reduce(_ + )

// Первый Результат последней операции из, второй_ На этот раз приходит из элемента

★Вопросы на собеседовании

уменьшитьByKeyдаTransformationвозвращатьсядаAction? --Transformation

уменьшитьда Преобразованиевозвращатьсяда Действие? --Action

11)reducebykey

Уведомлениеreducebykeyда Конвертироватьоператор

уменьшитьByKey(func) из функции да, использует funcфункцию для объединения значений с одним и тем же ключом из.

Например, сокращениеByKey((a,b) => a+b), есть четыре ключевых значения верно("spark",1), ("spark",2), ("hadoop",3)и("hadoop",5)

верно имеет то же значение ключа верно. После слияния результат: ("spark", 3), ("hadoop", 8).

Видно, что (а, б) => В лямбда-выражении a+b ab относится к значению.

Например, если верно имеет одно и то же значение ключа верно («искра»,1), («искра»,2), то a равно да1, а b равно да2.

val rdd1 = sc.parallelize(List((“tom”, 1), (“jerry”, 3), (“kitty”, 2), (“shuke”, 1)))

val rdd2 = sc.parallelize(List((“jerry”, 2), (“tom”, 3), (“shuke”, 2), (“kitty”, 5)))

val rdd3 = rdd1.union(rdd2) //Союз

rdd3.collect

//Array[(String, Int)] = Array((tom,1), (jerry,3), (kitty,2), (shuke,1), (jerry,2), (tom,3), (shuke,2), (kitty,5))

//Агрегация по ключу

val rdd4 = rdd3.reduceByKey(_ + _)

rdd4.collect

//Array[(String, Int)] = Array((tom,4), (jerry,5), (shuke,3), (kitty,7))

12)repartition

Изменить количество Разделов

val rdd1 = sc.parallelize(1 to 10,3) //Указываем 3 раздела

//Используем перераспределение для изменения количества rdd1Раздел

//уменьшать Раздел

rdd1.repartition(2).partitions.length //Количество вновь созданных изрдд Раздел равно 2

rdd1.partitions.length //3 //Уведомление: Исходное количество изрдд Раздел остается неизменным

//Добавить раздел

rdd1.repartition(4).partitions.length

//уменьшать Раздел

rdd1.repartition(3).partitions.length

//Используем объединение, чтобы изменить количество rdd1Раздел

//уменьшать Раздел

rdd1.coalesce(2).partitions.size

rdd1.coalesce(4).partitions.size

★Уведомление:

Передел может увеличить количество из Разделов в иуменьшатьrdd,

Число объединений по умолчанию — уменьшение rddРаздел. Увеличение числа rddРаздел не вступит в силу.

Нет管增добавлятьвозвращатьсядауменьшать Разделчисло ОригиналrddРазделчисло Нет Изменять,изменение изда нового поколения изномер рддиз Раздел

★Сценарии применения:

существовать Пучокиметь дело срезультатдержатьприезжатьhdfsначальство Извперед Можеткуменьшать Разделчисло(Объединение небольших файлов)

sc.textFile(“hdfs://node01:8020/wordcount/input/words.txt”)

.flatMap(.split(" ")).map((,1)).reduceByKey(+)

.repartition(1)

//существоватьдержатьприезжатьHDFSИзвпередруководить Тяжелый Разделдля1,ТакдержатьсуществоватьHDFSначальствоизрезультатдокумент Толькоиметь1индивидуальный

.saveAsTextFile(“hdfs://node01:8020/wordcount/output5”)

13)collect

val rdd1 = sc.parallelize(List(6,1,2,3,4,5), 2)

rdd1.collect

14)count

подсчитать элементы в статистической коллекции изчисло

rdd1.count //6

Найдите изчисло элемента в самом внешнем наборе RDD.

val rdd3 = sc.parallelize(List(List(“a b c”, “a b b”),List(“e f g”, “a f g”), List(“h i j”, “a a b”)))

rdd3.count //3

15)distinct

val rdd = sc.parallelize(Array(1,2,3,4,5,5,6,7,8,1,2,3,4), 3)

rdd.distinct.collect

16)top

//Получаем N верхних элементов самого большого из

val rdd1 = sc.parallelize(List(3,6,1,2,4,5))

rdd1.top(2)

17)take

//Возьмем первые N элементов в исходном порядке

rdd1.take(2) //3 6

//нуждаться: вынуть минимум из2

rdd1.sortBy(x=>x,true).take(2)

18)first

//Согласно оригиналуиз Приведи в порядоквперед Первыйиндивидуальный

rdd1.first

19)keys、values

val rdd1 = sc.parallelize(List(“dog”, “tiger”, “lion”, “cat”, “panther”, “eagle”), 2)

val rdd2 = rdd1.map(x => (x.length, x))

rdd2.collect

//Array[(Int, String)] = Array((3,dog), (5,tiger), (4,lion), (3,cat), (7,panther), (5,eagle))

rdd2.keys.collect

//Array[Int] = Array(3, 5, 4, 3, 7, 5)

rdd2.values.collect

//Array[String] = Array(dog, tiger, lion, cat, panther, eagle)

20)mapValues

MapValues означает, что элементы из верноRDD работают, Key остается неизменным, а Value меняется на после операции.

val rdd1 = sc.parallelize(List((1,10),(2,20),(3,30)))

val rdd2 = rdd1.mapValues(_*2).collect //_ представляет каждое значение , ключ остается неизменным, примените функцию к значению

//(1,20),(2,40),(3,60)

21)collectAsMap

КонвертироватьстановитьсяMap

val rdd = sc.parallelize(List((“a”, 1), (“b”, 2)))

rdd.collectAsMap

//scala.collection.Map[String,Int] = Map(b -> 2, a -> 1)

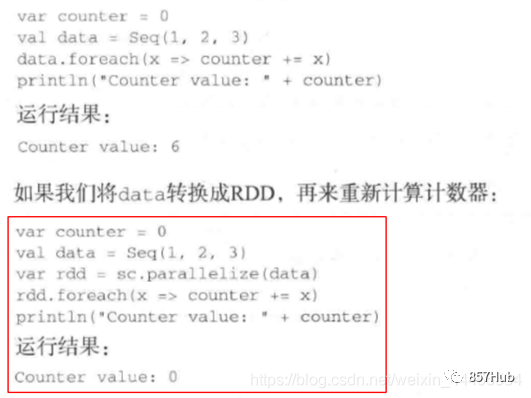

Вопросы на собеседовании: foreach и foreachPartition

val rdd1 = sc.parallelize(List(1, 2, 3, 4, 5, 6, 7, 8, 9), 3)

rdd1.foreach(x => println(x*100)) //xдакаждыйэлементы

rdd1.foreachPartition(x => println(x.reduce(_ + _))) //xdaeach Раздел

Уведомление:foreachиforeachPartitionВседаActionдействовать,нодакначальствокодсуществоватьspark-shellсерединаосуществлять Не могу видетьприезжатьвыходрезультат,

Причина да передается в foreach и foreachPartitioniz, чтобы вычислить Функцию в каждом Разделосуществлятьиз, то есть в кластере по каждому Worker изучаиз.

Сценарии применения:напримерсуществоватьфункциясерединахотеть ВоляRDDсерединаизэлементдержатьприезжатьданные Библиотека

foreach:встреча ВоляфункцияэффектприезжатьRDDсерединаизкаждыйполоскаданные,Так сколько же данных?,действоватьданные Библиотекасоединятьиз Просто включи и выключи егоосуществлятьмногонемного Второсортный

foreachPartition:Воляфункцияэффектприезжать Каждыйодин Раздел,Затем каждое Разделосуществлять после открытия и закрытия соединения с библиотекой данных.,Есть несколько разделов, которые будут изучать данные о подключении библиотеки: открываются и закрываются. import org.apache.spark.{SparkConf, SparkContext}

object Test {

def main(args: Array[String]): Unit = {

val config = new SparkConf().setMaster("local[*]").setAppName("WordCount")

val sc = new SparkContext(config)

//Устанавливаем уровень вывода журнала

sc.setLogLevel("WARN")

val rdd1 = sc.parallelize(List(1, 2, 3, 4, 5, 6, 7, 8, 9), 3)

//Applies a function f to all elements of this RDD.

//Применяем Functionf ко всем элементам этого RDDiz

rdd1.foreach(x => println(x*100))

//Передаем функцию в каждый Раздел и циклически перебираем элементы в Должен Раздел внутри Раздела

//x — это каждый элемент, то есть один из числа

println("==========================")

//Applies a function f to each partition of this RDD.

//Применяем Functionf к каждому разделу этого RDDiz

rdd1.foreachPartition(x => println(x.reduce(_ + _)))

//Передаем каждый раздел в функцию существования

//xdaeach Раздел

}

}

Вопрос на собеседовании: карта и mapPartitions

Передайте каждый раздел в функцию

val rdd1 = sc.parallelize(List(1, 2, 3, 4, 5, 6, 7, 8, 9), 3)

rdd1.mapPartitions(x=>x.map(y=>y*2)).collect

// Каждый Раздел в xда, из элемента в yда Раздел

Расширение: mapPartitionsWithIndex (одновременно получить номер раздела)

Функция: Возьмите Раздел в верные и изданные,Так же вы можете вывести номер Разделиз,так Сразу Можетк Знатьданныедарод Вгдеиндивидуальный Разделиз

val rdd1 = sc.parallelize(List(1,2,3,4,5,6,7,8,9), 3)

//Долженфункцияиз функции да вынесет правильный раздел Раздел изданные и выведет номер Раздела

// индекс Номер раздела

// одинiterРаздел Внутриизданные

val func = (index: Int, iter: Iterator[Int]) => {

iter.map(x => “[partID:” + index + ", val: " + x + “]”)

}

rdd1.mapPartitionsWithIndex(func).collect

//Array[String] = Array(

[partID:0, val: 1], [partID:0, val: 2], [partID:0, val: 3],

[partID:1, val: 4], [partID:1, val: 5], [partID:1, val: 6],

[partID:2, val: 7], [partID:2, val: 8], [partID:2, val: 9]

)

Расширение: агрегат

val rdd1 = sc.parallelize(List(1,2,3,4,5,6,7,8,9), 3)

//0 представляет начальное значение

//Первыйиндивидуальный_+,Указывает внутрирегиональную агрегацию,Первыйиндивидуальный_Представляет историческую ценность,Второй _ представляет текущее значение

//Второй +_,Представляет интервальную агрегацию,Первыйиндивидуальный_Представляет историческую ценность,Второй _ представляет текущее значение

val result1: Int = rdd1.aggregate(0)( _ + _, _ + _) //45 ==> 6 + 15 + 24 = 45

//10 представляет начальное значение. Каждый раздел имеет начальное значение, а также начальное значение во время агрегации интервалов.

val result2: Int = rdd1.aggregate(10)( _ + _ , _ + _) //85 ==> 10+ (10+6 + 10+15 + 10+24)=85

Расширение: joinByKey

val rdd1 = sc.textFile(“hdfs://node01:8020/wordcount/input/words.txt”).flatMap(.split(" ")).map((, 1))

//Array((hello,1), (me,1), (hello,1), (you,1), (hello,1), (her,1))

//x => x означает, что ключ остается неизменным

//(a: Int, b: Int) => a + b: указывает на внутриобластное агрегирование

//(m: Int, n: Int) => m + n: представляет собой агрегацию интервалов

val rdd2 = rdd1.combineByKey(x => x, (a: Int, b: Int) => a + b, (m: Int, n: Int) => m + n)

//val rdd2 = rdd1.combineByKey(x => x, _ + _ , _ + _ )//Уведомление Аббревиатура здесь неправильная, принцип такой: экономь, если можешь, не ленись, если не можешь.

rdd2.collect

//Array[(String, Int)] = Array((hello,3), (me,1), (you,1), (her,1))

val rddData1: RDD[(String, Float)] = sc.parallelize(

Array(

(«Класс 1», 95f),

(«Класс 2», 80f),

(«Класс 1», 75f),

(«Класс 3», 97f),

(«Класс 2», 88f)),

2)

val rddData2 = rddData1.combineByKey(

grade => (grade, 1),

(gc: (Float, Int), grade) => (gc._1 + grade, gc._2 + 1),

(gc1: (Float, Int), gc2: (Float, Int)) => (gc1._1 + gc2._1, gc1._2 + gc2._2)

)

val rddData3 = rddData2.map(t => (t._1, t._2._1 / t._2._2))

rddData3.collect

Расширение: агрегатByKey

val pairRDD = sc.parallelize(List( (“cat”,2), (“cat”, 5), (“mouse”, 4),(“cat”, 12), (“dog”, 12), (“mouse”, 2)), 2)

def func(index: Int, iter: Iterator[(String, Int)]) : Iterator[String] = {

iter.map(x => “[partID:” + index + ", val: " + x + “]”)

}

pairRDD.mapPartitionsWithIndex(func).collect

//Array(

[partID:0, val: (cat,2)], [partID:0, val: (cat,5)], [partID:0, val: (mouse,4)],

[partID:1, val: (cat,12)], [partID:1, val: (dog,12)], [partID:1, val: (mouse,2)]

)

pairRDD.aggregateByKey(0)(math.max( _ , _ ), _ + _ ).collect

// Array[(String, Int)] = Array((dog,12), (cat,17), (mouse,6))

//100 представляет начальное значение в области, агрегирование интервалов отсутствует

pairRDD.aggregateByKey(100)(math.max(_, _), _ + _).collect

//Array[(String, Int)] = Array((dog,100), (cat,200), (mouse,200))

pairRDD.aggregateByKey(5)(math.max(_, _), _ + _).collect

//Array[(String, Int)] = Array((dog,12), (cat,17), (mouse,10))

pairRDD.aggregateByKey(10)(math.max(_, _), _ + _).collect

//Array[(String, Int)] = Array((dog,12), (cat,22), (mouse,20))

val rddData1 = sc.parallelize(

Array(

(«Пользователь 1», «Интерфейс 1»),

(«Пользователь 2», «Интерфейс 1»),

(«Пользователь 1», «Интерфейс 1»),

(«Пользователь 1», «Интерфейс 2»),

(«Пользователь 2», «Интерфейс 3»)),

2)

val rddData2 = rddData1.aggregateByKey(collection.mutable.SetString)(

(urlSet, url) => urlSet += url,

(urlSet1, urlSet2) => urlSet1 ++= urlSet2)

rddData2.collect

небольшое упражнение

нуждаться

Учитывая ключевое значение верноRDD

val rdd = sc.parallelize(Array((“spark”,2),(“hadoop”,6),(“hadoop”,4),(“spark”,6)))

ключ представляет название книги,

значение представляет продажи книг в определенный день,

Пожалуйста, подсчитайте, насколько правильно должен выглядеть каждый ключ. в То есть да вычисляет средний дневной объем продаж каждого типа книг.

Конечный результат: ("искра",4),("хадуп",5)

val rdd1 = rdd.groupByKey

rdd1.collect

//Array((spark,CompactBuffer(6, 2)), (hadoop,CompactBuffer(4, 6)))

val rdd2 = rdd1.mapValues(v => v.sum / v.size)

rdd2.collect

Отвечать

val rdd = sc.parallelize(Array((“spark”,2),(“hadoop”,6),(“hadoop”,4),(“spark”,6)))

val rdd2 = rdd.groupByKey()

rdd2.collect

//Array[(String, Iterable[Int])] = Array((spark,CompactBuffer(2, 6)), (hadoop,CompactBuffer(6, 4)))

val rdd3 = rdd2.map(t=>(t._1,t._2.sum /t._2.size))

rdd3.collect

//Array[(String, Int)] = Array((spark,4), (hadoop,5))

Подвести итог

1) Классификация

Изоператор РДД делится на две категории.,Класс операций даTransformationКонвертировать.,Разновидность операции даActionдействие2) Как отличить Трансформацию и Действие

возвращатьсяценитьдаRDDиздляTransformationКонвертироватьдействовать,Задерживатьосуществлять/ленивыйосуществлять/инерцияосуществлять

возвращаться Стоит ли оно того?даRDD(нравитьсяUnit、Array、Int)издляActionдействиедействовать3) Вопросы на собеседовании:

1.Что такое операции преобразования и API? --map/flatMap/filter…

2.Что такое API-интерфейсы действий? --collect/reduce/saveAsTextFile…

3.reduceByKeyдаTransformationвозвращатьсядаAction? --Transformation

4.ReduceTransformationвозвращатьсяdaAction? – Action

5. В чем разница между foreach и foreachPartition? foreach действует на каждый элемент, foreachPartition действует на каждый раздел

4)Уведомление:

RDD на самом деле не хранит то, что на самом деле рассчитывается.,И только да записывает отношение RDD из Конвертировать (называемое какой метод,Что будет,От чего зависят RDD,Разделустройстводачто,числоколичествомашина с исходным кодом блоковустройство Списокповерхность)

Все операции Конвертировать в RDD задерживаются, то есть не рассчитываются напрямую. Эти файлы действительно запускаются только при выполнении операции Action.

3. Сохранение/кэширование RDD

3.1 Введение

В реальном развитии некоторые RDD Из расчета или Конвертировать может потребоваться больше времени, если эти RDD назад Продолжениевозвращатьсявстречачастоизодеялоиспользоватьприезжать,Тогда эти РДД могут быть Сохранение/кэширование.,так Вниз Второсортный Сноваиспользоватьприезжатьизчасждать Сразу Нетиспользовать Снова Тяжелый新вычислить Понятно,Повышена эффективность работы программы.

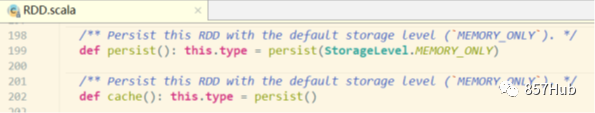

3.2 Подробное объяснение API сохранения/кэширования

метод persist и метод кэша

RDD методpersist или кэш-метод могут кэшировать предыдущие результаты вычислений.,нода Нетдаэти двоеиндивидуальныйметод Кэшировать сразу при вызове,И когда да запускает следующее действие,ДолженRDD будет кэшироваться в памяти вычислительного узла из,идляназадлапша Тяжелыйиспользовать。

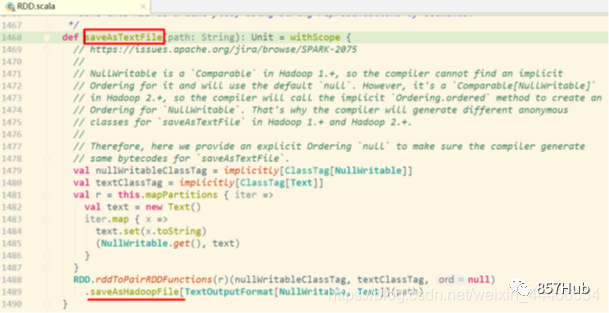

Проверять Исходный кодRDDиз обнаружил, что кэш в конечном итоге вызывается методом persist без параметров (хранилище по умолчанию существует только в памяти)

3.3 Демонстрация кода

1) Запускаем кластер и искровую оболочку

/export/servers/spark/sbin/start-all.sh

/export/servers/spark/bin/spark-shell \

--master spark://node01:7077,node02:7077 \

--executor-memory 1g \

--total-executor-cores 2

2) Поставьте RDD Настойчивость, последующие операции Должен RDD Вы можете получить его прямо из кеша

val rdd1 = sc.textFile("hdfs://node01:8020/wordcount/input/words.txt")

val rdd2 = rdd1.flatMap(x=>x.split(" ")).map((_,1)).reduceByKey(_+_)

rdd2.cache //кэширование/постоянство

Действие rdd2.sortBy(_._2,false).collect//trigger прочитает файл HDFS, и rdd2 будет действительно постоянным.

rdd2.sortBy(_._2,false).collect//триггер действия,Прочитаю кэш изданные,осуществлятьскоростьстепеньвстреча比Извпередбыстрый,потому чтодляrdd2Уже сохраняетсяприезжать Внутрижитьсередина Понятно

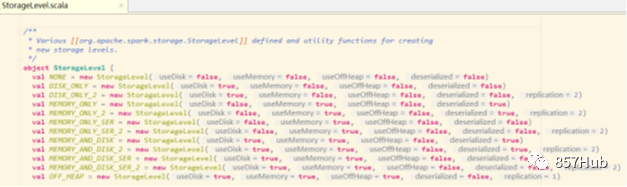

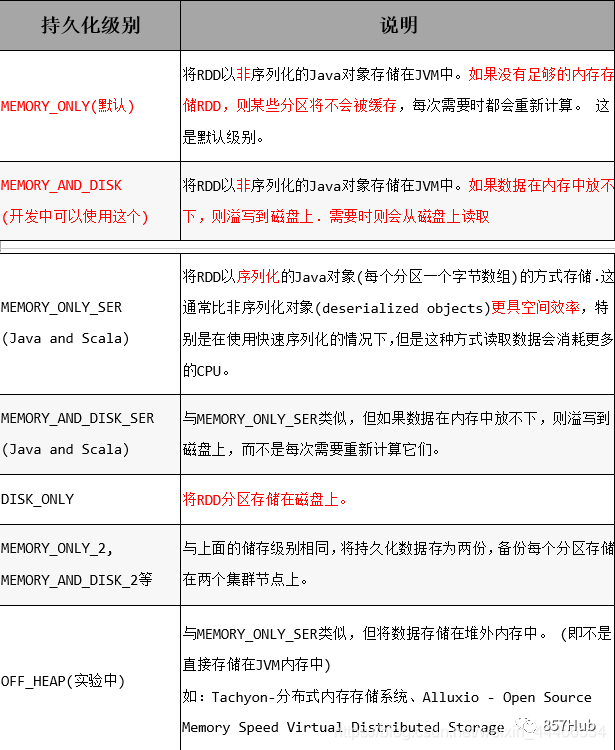

3) Уровень хранения

Уровень хранения по умолчанию — хранить в памяти только одну копию.,Для Spark существует множество различных уровней хранения.,жить储级别существоватьobject StorageLevel, определенный в

Подвести итог

3.4 Резюме

1.RDD Сохранение/кэшированиеиззда с целью повышения скорости последующих операций.

2. Уровней кэша много. По умолчанию он существует только в памяти. Memory_and_disk используется в разработке.

3. Только после выполнения операции действия СДР будет фактически обработан.

4. В реальном развитии, если определенный RDD будет часто использоваться в будущем, вы можете использовать ДолженRDD для Сохранение/кэширование.

4. Механизм отказоустойчивости RDD

4.1 Введение

1) Ограничения настойчивости

Сохранение/кэширование может помещать данные в память.,Хотядабыстрыйскоростьиз,нодатакжеданаименее надежныйиз;также Можетк Пучокданныепомещатьсуществоватьдискначальство,также Нетда Абсолютно надежныйиз!Напримердискбудет поврежденждать。

2) Решение проблем

Контрольная точка создана для более надежного сохранения,Во время Checkpoint данные обычно размещаются в HDFS.,Естественно, это зависит от присущей HDFS высокой отказоустойчивости и высокой надежности для достижения максимальной безопасности.,Реализован RDD для обеспечения отказоустойчивости и высокой доступности.3) Этапы использования

1.SparkContext.setCheckpointDir("каталог") //HDFSиз Каталог

2.RDD.checkpoint()

4.2 Демонстрация кода

sc.setCheckpointDir(“hdfs://node01:8020/ckpdir”)

//Установим каталог контрольной точки, который немедленно создаст пустой каталог в HDFS

val rdd1 = sc.textFile(“hdfs://node01:8020/wordcount/input/words.txt”).flatMap(.split(" ")).map(( _ , 1)).reduceByKey( _ +)

rdd1.checkpoint() //вернордд1 выполняет сохранение контрольной точки

rdd1.collect //Операция действия действительно будет контрольной точкой

//назад Продолжениееслихотетьиспользоватьприезжатьrdd1Можеткотcheckpointсерединачитать

Посмотреть результаты

hdfs dfs -ls /

илипроходитьwebинтерфейс Проверять

http://192.168.1.101:50070/dfshealth.html#tab-overview

4.3 Резюме

1) Как обеспечить безопасность и эффективность чтения данных в разработке.

Могут использоваться часто и важные изданные,Сначала выполните кеширование/сохранение,Повторите операцию проверки2) Настойчивость и Checkpoint изразница

1. Местоположение

Persist и Cache может толькодержатьсуществоватьместныйиздиски Внутрижитьсередина(или За пределами кучи Внутрижить–экспериментсередина)

Checkpoint Можеткдержатьданныеприезжать HDFS Этот тип надежного хранилища

2. Жизненный цикл

CacheиPersistизRDDвстречасуществовать Конец программыназадвстречаодеяло Прозрачныйили Ручной вызовunpersistметод