Старшие эксперты крупнейших производителей внедряют интеллектуальные сети без потерь для центров обработки данных

- представлять

Автор этой статьи — старший эксперт по развитию Meituan. Если есть какие-либо нарушения, свяжитесь с нами, чтобы удалить их!

Оригинал статьи опубликован на Zhihu: https://zhuanlan.zhihu.com/p/651830645

https://www.zhihu.com/people/mu-mu-67-87-35

Узнайте больше об индустрии связи: добро пожаловать на подписку на публичный аккаунт.

1.1. Область применения

В официальном документе рассматриваются сетевые технологии, которые поддерживают требования к сетям современных центров обработки данных, включая высокопроизводительные вычисления и приложения искусственного интеллекта, а также предлагаются решения для меняющихся требований и технологических проблем нового века.

1.2. Цель

Целью информационного документа является предоставление высокоуровневых решений проблем и задач, с которыми сталкиваются современные сети центров обработки данных. В официальном документе рассматривается текущее состояние строительства центров обработки данных и технологической эволюции, представлены проблемы, с которыми сталкиваются центры обработки данных в процессе разработки, а также на основе анализа и исследований предлагаются технические решения для расширения возможностей сети центров обработки данных и операционной эффективности для удовлетворения потребностей постоянно меняющиеся потребности приложений.

2. Оживите центры обработки данных

2.1. Новый мир, полный данных.

Цифровая трансформация меняет нашу личную и профессиональную жизнь. Рабочие процессы и взаимодействие между людьми переходят к цифровым процессам и инструментам автоматизации, основанным на облаке, мобильных устройствах и Интернете вещей. Технология, поддерживающая цифровую трансформацию, — это искусственный интеллект (ИИ). Когда центры обработки данных запускают приложения искусственного интеллекта с огромными объемами данных, они должны повторно конвертировать эти данные в соответствующую информацию, автоматизировать взаимодействие между людьми и детализированное принятие решений (рис. 1). В мире с высоким спросом на дополненную реальность, распознавание речи и контекстный поиск удовлетворение спроса на взаимодействие в реальном времени в центрах обработки данных становится более важным, чем когда-либо. Чтобы удовлетворить потребности в режиме реального времени, сети центров обработки данных должны обеспечивать более высокую производительность, масштабируемость и надежность.

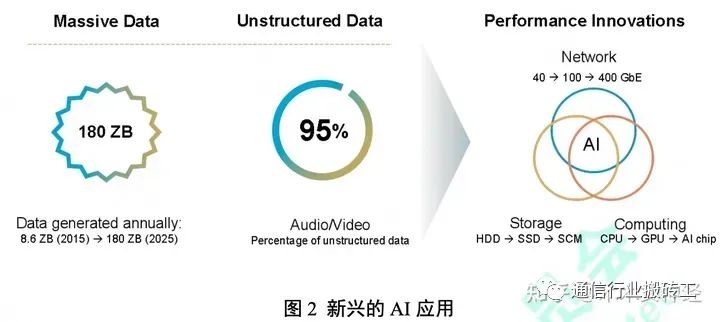

Центры обработки данных в эпоху облачных технологий фокусируются на трансформации приложений и быстром развертывании услуг. В эпоху искусственного интеллекта центры обработки данных предоставляют информацию и алгоритмы, необходимые для реализации цифровой жизни. Сочетание высокоскоростного хранилища и распределенных вычислений на основе искусственного интеллекта преобразует большие данные в быстрые данные, к которым могут получить доступ люди, машины и вещи. Высокопроизводительные, крупномасштабные сети центров обработки данных без потерь пакетов имеют решающее значение для успешной цифровой трансформации. Ключевые показатели для высокопроизводительных приложений, таких как искусственный интеллект и производительность сети, включают пропускную способность, задержку и перегрузку. Пропускная способность относится к общей пропускной способности сети для быстрой передачи больших объемов данных. Задержка относится к общей задержке транзакций в сети центра обработки данных. Перегрузка возникает, когда трафик превышает пропускную способность сети. Потеря пакетов — это фактор, серьезно влияющий на пропускную способность и задержку. В настоящее время различные отрасли ускоряют цифровую трансформацию. По оценкам, 64% предприятий стали исследователями и практиками цифровой трансформации1. Среди 2000 транснациональных компаний 67% руководителей считают цифровизацию основой своей корпоративной стратегии2. Реальные тенденции цифровой трансформации приводят к тому, что сети центров обработки данных поддерживают модели вычислений, ориентированные на данные. Большой объем данных, генерируемых в процессе цифровизации, стал основным активом, а также появились приложения искусственного интеллекта. Согласно данным Global Industry Outlook компании Huawei, к 2025 году объем новых данных достигнет 180ZB3. Однако данные не «кончают сами себя». Знания и мудрость, полученные из данных, имеют вечную ценность. Доля неструктурированных данных (таких как исходные голосовые, видео и графические данные) продолжает расти и в будущем будет составлять 95% всех данных (рис. 2). Существующие методы анализа больших данных не могут адаптироваться к быстрому росту данных и требуют оптимизации производительности, чтобы извлечь больше пользы из необработанных данных. Методы искусственного интеллекта, основанные на глубоком обучении, могут отфильтровывать большое количество неверных данных и автоматически извлекать полезную информацию, чтобы предоставлять более эффективные предложения по принятию решений и рекомендации по поведению.

В целом архитектура облачного центра обработки данных повышает производительность приложений и расширяет их масштаб. Облачные платформы позволяют быстро распределять ИТ-ресурсы, создавая модели обслуживания, ориентированные на приложения. В эпоху искусственного интеллекта приложения потребляют беспрецедентные объемы данных, а необходимые инновации в производительности расширяют возможности обработки нагрузки архитектур облачных центров обработки данных. Беспрепятственную интеграцию инноваций в производительности и новых приложений искусственного интеллекта сложно достичь в существующих облачных центрах обработки данных. Крайне важно знать, как эффективно обрабатывать данные в соответствии с потребностями приложений искусственного интеллекта. Ключевым фактором достижения успеха является плавная интеграция потоков данных между ресурсами хранения приложения и вычислительными ресурсами.

3. Требования и технологии центров обработки данных продолжают совершенствоваться.

3.1. Оригинальные стандарты мостового соединения центров обработки данных.

На заре появления Ethernet 10 Гбит/с рабочая группа ODCC начала заниматься мостовым соединением центров обработки данных (DCB). Рабочая группа DCB определяет набор усовершенствований Ethernet, мостов и связанных протоколов, используемых в средах центров обработки данных. Варианты использования и основные приложения — это кластеризация и сети хранения данных с использованием традиционных запатентованных технологий, таких как InfiniBandTM и Fibre Channel 4. Важной целью Ethernet является устранение потерь, вызванных перегрузкой, и выделение полосы пропускания для конкретного трафика на канале. Ключевые параметры мостового соединения центров обработки данных включают в себя:

- Приоритетное управление трафиком (PFC): механизм управления трафиком канального уровня.,Устраненоданные Риск потери упаковки,Для независимого ответа можно использовать различные количества потоков.

- ПрименениеStrong Transmission Selection (ETS): алгоритм планирования очереди, который позволяет выделять большой объем полосы пропускания.

- Уведомление владельца: протокол для обнаружения перегрузки на уровне 2, конец управления перегрузкой владельца.,Ограничьте скорость передачи сигнала путем пересечения сети уровня 2 из сигнала.,Избегайте потери пакетов.

- Data Center Bridging Capability Exchange (DCBX): протокол идентификации и обмена возможностями.,и протокол обнаружения уровня канала (LLDP),использовать Впроходитьпотерять вышеперечисленноепараметриз Функцияисоответствоватьнабор。

Эти параметры важны для распространения Ethernet на профессиональные рынки кластерных вычислений и сетей хранения данных. Однако по мере изменения окружающей среды и технологий требуется постоянная оптимизация. В настоящее время в больших масштабах развернуты дата-центры, использующие трехуровневые протоколы и высокоскоординированные системы управления. Скорость каналов Ethernet увеличилась с 10 Гбит/с до 400 Гбит/с, при этом планируется увеличить скорость до диапазона Тбит/с. Появление новых приложений, таких как искусственный интеллект, выдвинуло новые требования к инфраструктуре и способствовало архитектурным изменениям. Для дальнейшего расширения использования Ethernet в современных центрах обработки данных необходимы постоянные инновации.

3.2. Эволюция спроса.

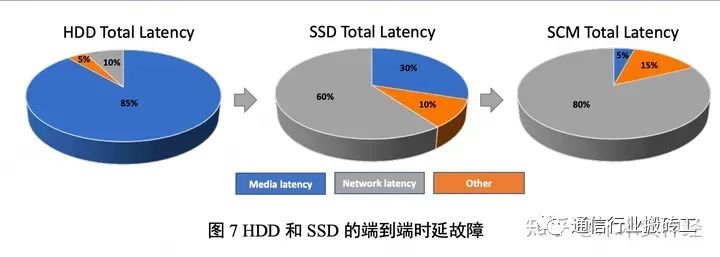

Приложения искусственного интеллекта оказывают давление на сети центров обработки данных. Одним из примеров является обучение искусственному интеллекту для беспилотных автомобилей. Алгоритмы глубокого обучения в значительной степени полагаются на большие объемы данных и высокопроизводительные вычислительные технологии. Данные обучения, собираемые каждый день, близки к уровню ПБ (1 ПБ = 1024 ТБ). Если для обработки данных используются традиционное хранилище на жестком диске и обычный процессор, для завершения обучения может потребоваться не менее года. Это явно нереально. Чтобы повысить эффективность обработки данных с помощью искусственного интеллекта, необходимы революционные изменения в области хранения и вычислений. Например, производительность хранилища необходимо повысить на порядок, чтобы достичь более 1 миллиона операций ввода-вывода в секунду (IOPS)5. Чтобы удовлетворить требования к доступу к данным в реальном времени, носители данных эволюционировали от жестких дисков (HDD) к твердотельным накопителям (SSD) и запоминающим устройствам (SCM). Задержка носителя данных сократилась более чем на 1000 раз. раз. Без аналогичного улучшения задержки в сети такая оптимизация хранилища не может быть достигнута, и узкое место можно просто переместить с носителя в сеть. Для сетевых твердотельных накопителей (SSD) задержка связи составляет более 60 % от общей задержки сквозного хранилища. Если вы перейдете на память класса хранения (SCM), этот показатель может увеличиться до 85 %, если производительность сети не улучшится. Это приводит к тому, что носитель данных простаивает более половины времени. Одновременная оптимизация носителей данных и вычислительных процессоров искусственного интеллекта приведет к тому, что задержка связи составит 50% от общей задержки. Это ограничит технологический прогресс и приведет к пустой трате ресурсов6.

Приложения и варианты использования искусственного интеллекта продолжают увеличиваться в объеме и сложности. Например, в 2015 году Resnet от Microsoft выполнил 70 миллиардов вычислений и имел 60 миллионов параметров. В 2016 году Baidu выполнила 20 экзафлопсных вычислений и 300 миллионов параметров при обучении своей системы глубокой речи. В 2017 году Google NMT выполнил 105 экзафлопсных вычислений и 8,7 миллиардов параметров7. Новые возможности ИИ-вычислений выдвигают более высокие требования к развитию сетей центров обработки данных. Традиционные протоколы больше не могут удовлетворить потребности новых приложений в повседневной жизни. Приведем простой пример: рост онлайн-бизнеса по доставке еды Meituan увеличился примерно в 5 раз за последние 4 года8. Всего за несколько часов в период пиковой нагрузки объем транзакций увеличился с 2,149 миллиардов до 12,36 миллиардов. Интеллектуальная система диспетчеризации Meituan разработала сложный многоточечный процесс принятия решений в режиме реального времени для пользователей, продавцов и более чем 600 000 работников службы доставки. Система обновляет данные о местоположении 5 миллиардов раз в день, рассчитывает альтернативные маршруты для работников службы доставки и выбирает лучший маршрут за 0,55 миллисекунды. Когда внутренний сервер использует протокол TCP/IP, объем копий данных между кешем ядра, кешем приложения и кешем сетевой карты перегружает ресурсы ЦП и шины памяти, что приводит к увеличению задержки и неспособности удовлетворить потребности приложение. Новый протокол удаленного прямого доступа к памяти (RDMA) исключает копирование данных, высвобождает ресурсы ЦП и позволяет выполнять выбор пути и выполнять последовательные вычисления. Повышение эффективности RDMA оказало большее давление на сеть, переместив узкое место в сетевую инфраструктуру центра обработки данных, а низкая задержка и работа без потерь стали новыми необходимыми требованиями.

3.3. Характеристики ИИ-вычислений.

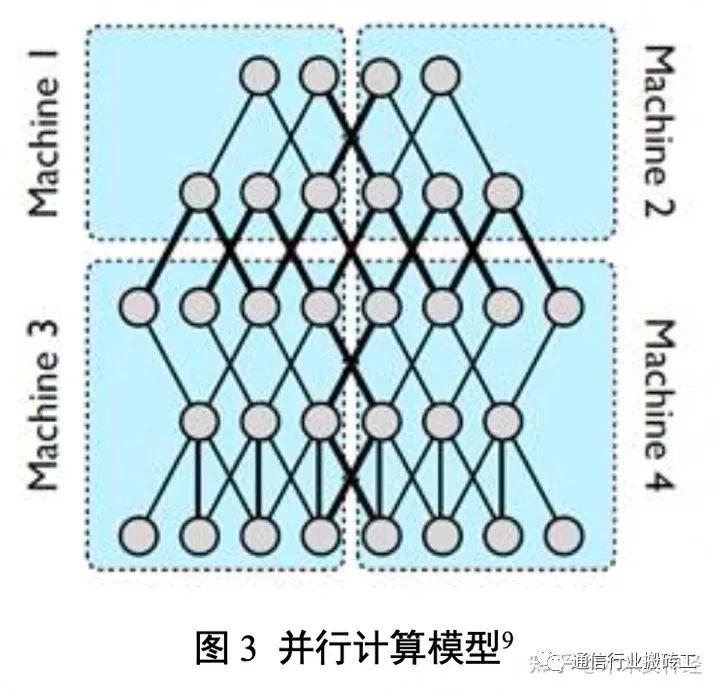

Традиционные службы центров обработки данных (Интернет, базы данных и хранилища файлов) основаны на событиях, и результаты расчетов обычно являются детерминированными. Для такой задачи существует небольшая корреляция или зависимость между отдельными событиями и соответствующими сетевыми коммуникациями. Возникновение и продолжительность традиционных событий случайны. Однако это не относится к вычислениям с использованием искусственного интеллекта. Это итеративная задача оптимизации сходимости. Это приводит к высокой степени пространственной корреляции между наборами данных и вычислительными алгоритмами, а также временной корреляции между потоками связи. Вычисления с использованием искусственного интеллекта используются для обработки больших данных и требуют быстрых данных. Чтобы удовлетворить эту потребность, она должна действовать параллельно с проблемой «разделяй и властвуй». Модель расчета и набор входных данных велики (например, в условиях узла 100 МБ для модели AI с правилами 10 КБ требуется более 4 ТБ памяти). Один сервер не может обеспечить достаточную емкость хранилища и вычислительные ресурсы для последовательного решения проблемы. Узлы вычислений и хранения ИИ необходимо распараллелить, чтобы сократить время обработки. Это требование к распределенным вычислениям и хранению данных с помощью искусственного интеллекта требует быстрой, эффективной сети центров обработки данных без потерь, которая создает два различных режима параллельных вычислений — параллельные вычисления модели и параллельные вычисления данных.

3.3.1. Модельные параллельные вычисления. В модельных параллельных вычислениях каждый узел берет на себя часть вычислений всего алгоритма. Каждый узел обрабатывает один и тот же набор данных, а разные части алгоритма выполняют оценку разных наборов параметров. Посредством оценки алгоритма обмена узлами получается наилучшая оценка, которая сходится ко всем параметрам данных. Параллельные вычисления модели первоначально распределяют общие наборы данных по распределенным узлам, а затем объединяют отдельные параметры из каждого распределенного узла. На рис. 3 показано, как параметры всей модели распределяются по вычислительным узлам в режиме параллельной работы.

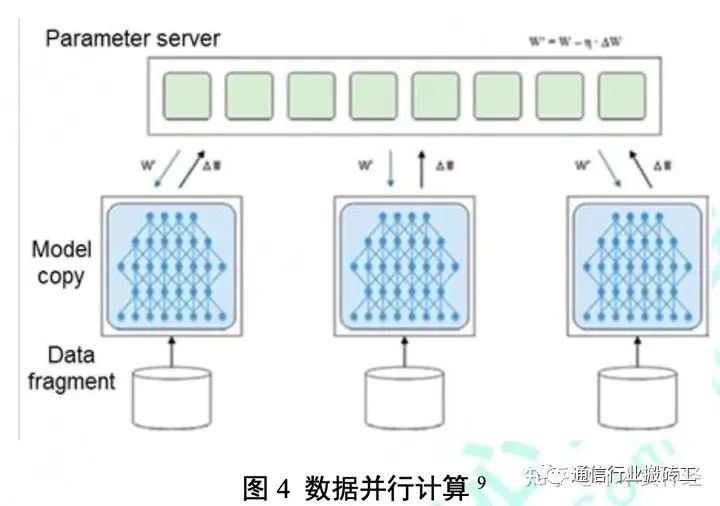

3.3.2. Параллельные вычисления данных. При параллельных вычислениях данных каждый узел несет всю модель алгоритма ИИ, но обрабатывает только часть входных данных. Каждый узел пытается оценить один и тот же набор параметров, используя разное представление данных. Когда узел завершает цикл вычислений, параметры взвешиваются и агрегируются общедоступным сервером параметров, как показано на рисунке 4. Обновление взвешенных параметров требует, чтобы все узлы обновляли информацию синхронно.

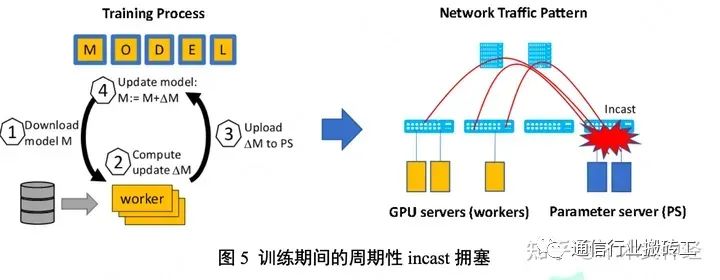

Независимо от того, какой метод параллельных вычислений используется, сети центров обработки данных подвергаются большей коммуникационной нагрузке. Когда сеть становится узким местом, вычислительные ресурсы могут ожидать более 50% времени, необходимого для завершения задания10. Как и во всех приложениях искусственного интеллекта, вычислительная модель постоянно обновляется, и существует этап синхронизации, который вызывает перегрузку сети. На рисунке 5 показано, как происходит блокировка incast при обучении ИИ. Процесс обучения постоянно повторяется, и на каждой итерации генерируется множество параметров синхронизации. Когда приложение загружает модель, оно синхронизирует следующий рассчитанный результат (ΔM) и загружает его на сервер параметров. Процесс загрузки на сервер параметров вызывает incast. Применение новых вычислительных технологий может сократить время вычислений, но нагрузка на сеть и, как следствие, возрастут объемы вычислений.

Связь между рабочими узлами и серверами параметров представляет собой набор взаимозависимых сетевых потоков. Во время итеративного процесса распределенных вычислений ИИ большие объемы трафика распределяют данные по рабочим узлам в течение нескольких миллисекунд. Когда промежуточные параметры передаются и обновляются, небольшой трафик, отправляемый на сервер параметров, будет передаваться. В процессе обмена потоками в сети могут возникнуть такие проблемы, как потеря пакетов, перегрузка и дисбаланс нагрузки. Таким образом, время завершения потока (FCT) некоторых потоков увеличивается. Если некоторые потоки задерживаются, ресурсы хранения и вычислительные ресурсы могут быть использованы не полностью. Это, в свою очередь, задерживает время завершения всего приложения. Распределенные вычисления ИИ синхронизированы, и в идеале время завершения вычислений можно предсказать. При отсутствии перегрузки низкая динамическая задержка сети делает среднее значение FCT предсказуемым и, следовательно, производительность всего приложения. Когда динамическая задержка из-за перегрузки увеличивается до критической точки потери пакетов, FCT становится невозможным предсказать. Потоки, время завершения которых намного превышает среднее время завершения, будут страдать от так называемых хвостовых задержек. Из общего количества ответов системы на запросы ввода-вывода (I/O) задержка хвоста составляет лишь небольшую часть времени ответа системы, и она занимает больше всего времени по сравнению с большинством времен ответа. Минимизация хвостовой задержки имеет решающее значение для успеха параллельных алгоритмов и распределенных вычислительных систем в целом. Чтобы максимально эффективно использовать вычислительные ресурсы в центре обработки данных, необходимо устранить задержку.

3.4. Эволюция технологий.

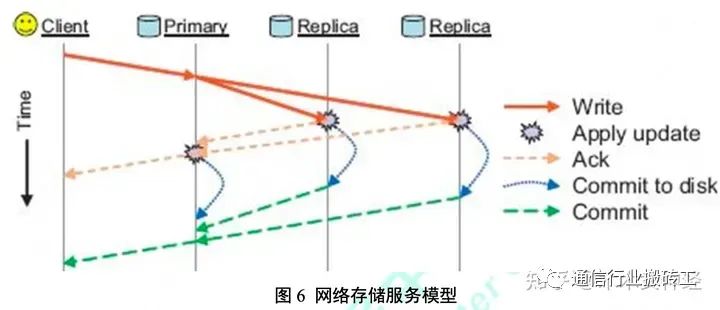

Когда меняющиеся потребности и технологии совпадают, это означает прогресс. Новые потребности обычно стимулируют разработку новых технологий, а новые технологии могут поддерживать новые варианты использования, которые, в свою очередь, порождают новые потребности. Прорывы в области сетевого хранения данных, распределенных вычислений, системной архитектуры и сетевых протоколов способствуют развитию центров обработки данных следующего поколения. 3.4.1 SSD и NVMeoF: сети с высокой пропускной способностью и низкой задержкой. В сетевом хранилище файл распределяется по нескольким серверам хранения для достижения ускорения ввода-вывода и избыточности. Когда приложение центра обработки данных считывает файл, оно одновременно обращается к различным частям данных с разных серверов. Данные агрегируются практически одновременно через коммутаторы центров обработки данных. Когда приложение центра обработки данных записывает в файл, запись данных запускает серию транзакций хранения между распределенными узлами хранения и резервными узлами хранения. На рис. 6 показан пример взаимодействия центра обработки данных, запускаемого моделью службы сетевого хранения.

Этот пример подчеркивает важность того, чтобы сеть поддерживала как высокую пропускную способность, так и низкую задержку. Большие объемы данных, записанные на основной сервер хранения, передаются на реплики несколькими пакетами. Небольшие сообщения подтверждения и фиксации должны быть упорядочены и доставлены инициирующему клиенту до завершения транзакции, что иллюстрирует необходимость сверхнизкой задержки. Производительность хранилища значительно улучшилась по мере того, как технология, использующая спецификацию интерфейса энергонезависимой памяти Express (NVMe), эволюционировала от жесткого диска к SSD и SCM. Доступ к носителям данных через NVMe занимает до 1000 раз меньше времени, чем предыдущие технологии жестких дисков. Примерное время поиска между технологиями составляет: HDD = 2–5 мс, SSD SATA = 0,2 мс, SSD NVMe = 0,02 мс. SCM обычно в три-пять раз быстрее, чем флэш-накопители NVMe. NVMe-over-fabrics (сокращенно NVMeoF) относится к конфигурации NVMe для сетевого хранилища. Чем выше скорость доступа к среде, тем больше узкое место в сети и тем значительнее влияние сетевой задержки. На рис. 7 показано, как задержка в сети может стать основным узким местом для более быстрого хранилища NVMe. Сетевая задержка составляет незначительную часть сквозной задержки сетевого жесткого диска, но с развитием сетевого хранилища SCM сетевая задержка станет важным компонентом. Чтобы максимизировать производительность IOPS нового носителя, сначала необходимо решить проблемы с задержкой в сети.

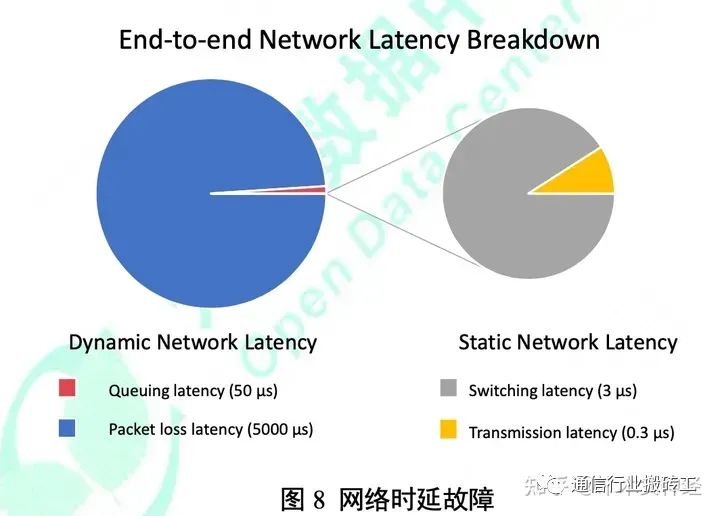

Задержка состоит из двух типов: статическая задержка и динамическая задержка. Статическая задержка включает в себя задержку последовательных данных, задержку пересылки устройства и задержку оптической/электрической передачи. Этот тип задержки зависит от производительности коммутационного оборудования и расстояния, на которое передаются данные. Обычно оно фиксировано и легко предсказуемо. На рисунке 8 показано, что текущее значение статической задержки, измеренное в отрасли, обычно находится на уровне наносекунд (10–9 секунд) или субмикросекунд (10–6 секунд), что составляет менее 1 % от общего объема сквозной сети. задерживать.

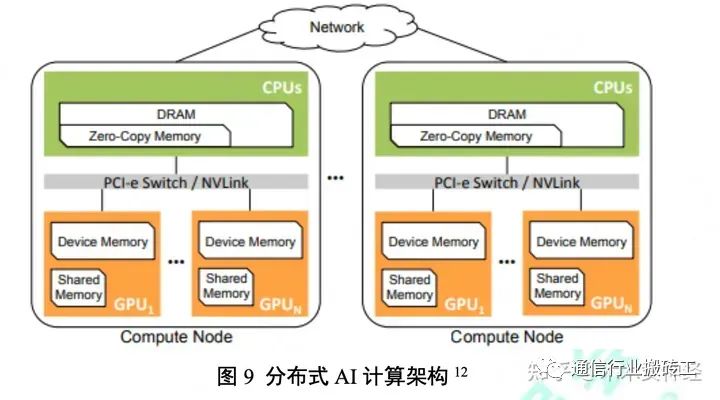

Динамическая задержка оказывает более сильное влияние на общую задержку сквозной сети и в большей степени зависит от условий среды связи. Динамические задержки вызваны внутренними очередями и повторными передачами пакетов. Причинами этих задержек являются перегрузка сети и потеря пакетов. Модели параллельных вычислений ИИ могут создавать уникальные шаблоны трафика, которые могут вызвать серьезную перегрузку сети. Ключом к уменьшению сквозной задержки в сети является устранение динамической задержки, а ключом к решению проблемы динамической задержки является уменьшение перегрузки. Основным источником динамической задержки является повторная передача пакетов, вызванная потерей пакетов. Задержка потери пакетов на порядок превышает задержку в очереди и серьезно влияет на приложения. Потеря пакетов происходит при переполнении буфера коммутатора из-за перегрузки (следует отметить, что потеря пакетов из-за малой вероятности битовых ошибок при передаче здесь игнорируется). Двумя основными типами перегрузки, вызывающими потерю пакетов, являются перегрузка внутри сети и перегрузка incast. Внутрисетевая перегрузка возникает на каналах между коммутаторами, когда каналы в сетевой структуре перегружаются, возможно, из-за дисбаланса нагрузки. Перегрузка Incast возникает на границе сети, когда множество источников одновременно отправляют данные в один и тот же пункт назначения. Этап, присущий модели вычислений ИИ, где данные агрегируются после итераций обработки, склонен к перегрузке (еще одна). 3.4.2 GPU: сеть со сверхнизкой задержкой для параллельных вычислений. Сегодняшняя вычислительная архитектура искусственного интеллекта включает центральные процессоры (ЦП) и графические процессоры (ГП). Первоначально разработанные для высокоскоростного рендеринга видеоигр, графические процессоры теперь находят новые применения в центрах обработки данных. Графический процессор — это процессор с тысячами ядер, способный одновременно выполнять миллионы математических операций. Все алгоритмы обучения искусственного интеллекта способны выполнять сложные статистические вычисления и обрабатывать большие объемы операций умножения матриц, что очень подходит для графических процессоров. Однако для масштабирования вычислительных архитектур ИИ для удовлетворения текущих потребностей центров обработки данных для приложений ИИ графические процессоры должны быть распределены и объединены в сеть. Это предъявляет более высокие требования к объему связи и производительности. Facebook недавно протестировал платформу распределенного машинного обучения Caffe2, которая использует новейшие серверы с несколькими графическими процессорами для достижения параллельного ускорения. В ходе тестирования выяснилось, что вычислительные задачи восьми серверов привели к недоиспользованию ресурсов сети InfiniBand 100 Гбит/с. Появление сетей и сетевых конфликтов снижает производительность решения ниже линейного диапазона11. Таким образом, производительность сети сильно ограничивает горизонтальное расширение систем искусственного интеллекта. Графические процессоры предлагают гораздо более высокую пропускную способность памяти, чем современные архитектуры ЦП. Многоузловые графические процессоры используются для высокопроизводительных вычислений благодаря их высокой энергоэффективности и аппаратному параллелизму. На рис. 9 показана архитектура узла с несколькими графическими процессорами, в которой каждый узел состоит из хоста (ЦП) и нескольких устройств графического процессора, подключенных через коммутаторы PCI-e или NVLink. Каждый графический процессор имеет прямой доступ к своей локальной относительно большой памяти устройства, меньшей и более быстрой общей памяти, а также небольшой фиксированной области DRAM хост-узла, известной как память с нулевым копированием12.

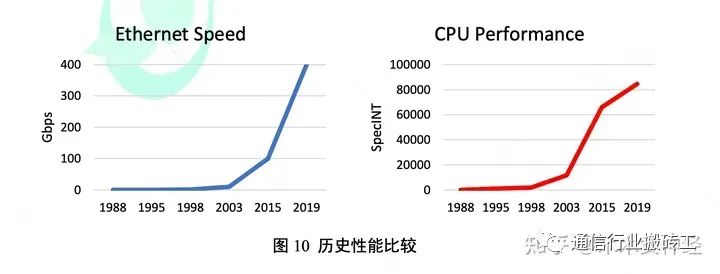

3.4.3. За последние несколько лет повышение скорости процессора и оптимизация производительности канала Ethernet компенсировали друг друга. На рисунке 10 показаны исторические улучшения скорости каналов Ethernet и базовые улучшения производительности ЦП13. В какой-то момент в прошлом традиционные процессоры имели более чем достаточную вычислительную мощность для обработки нагрузки каналов Ethernet, в то время как упрощенные сетевые карты предлагали значительную экономию средств и гибкость для программного обеспечения всего сетевого стека. В других случаях процессор не может адаптироваться к увеличению скорости соединения, поэтому при использовании каналов Ethernet требуются более дорогие и сложные платы SmartNIC и специализированное разгружаемое оборудование. Со временем разгрузка SmartNIC стала более зрелой, и некоторые из ее функций стали стандартными и включены в теперь общие базовые функции NIC. Это явление возникло с появлением механизма разгрузки TCP (TOE), который поддерживает разгрузку контрольной суммы TCP, передачу больших сегментов данных и расширение получателя.

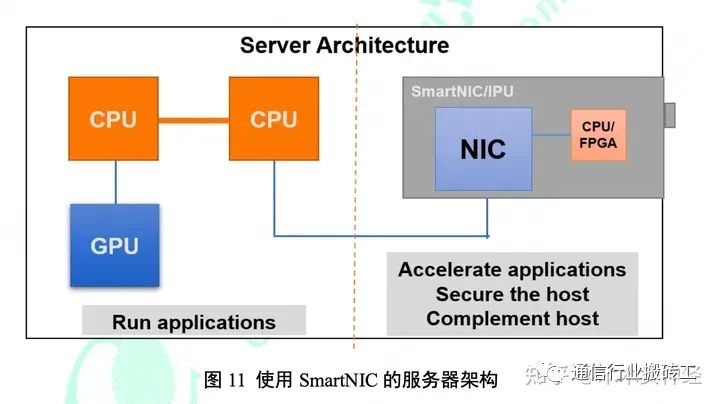

В мире, где есть признаки исчезновения закона Мура, скорость соединения Ethernet продолжает расти, достигая 400 Гбит/с. Это изменение также включает в себя сложность программно-определяемых сетей, технологий виртуализации, протоколов хранения, обмена сообщениями и безопасности в современных центрах обработки данных, и есть аргумент в пользу того, что архитектура SmartNIC никуда не денется. Итак, что же такое SmartNIC для центров обработки данных сегодня? На рис. 11 показана архитектура сервера центра обработки данных, включающая SmartNIC. SmartNIC охватывает все типичные функции сетевого адаптера, а также включает возможности разгрузки для ускорения работы приложений, работающих на центральном и графическом процессоре сервера. SmartNIC не заменяет ЦП или графический процессор, а скорее дополняет ЦП или графический процессор за счет разгрузки сети. Некоторые ключевые разгрузки включают поддержку интерфейса виртуальной машины, гибкое сопоставление пакетов, завершение и инициирование наложенного туннеля, шифрование, измерение трафика, формирование и статистику каждого потока. Кроме того, SmartNIC обычно включают полную разгрузку протоколов и прямое размещение данных, поддерживая интерфейсы хранения RDMA и NVMe-oF.

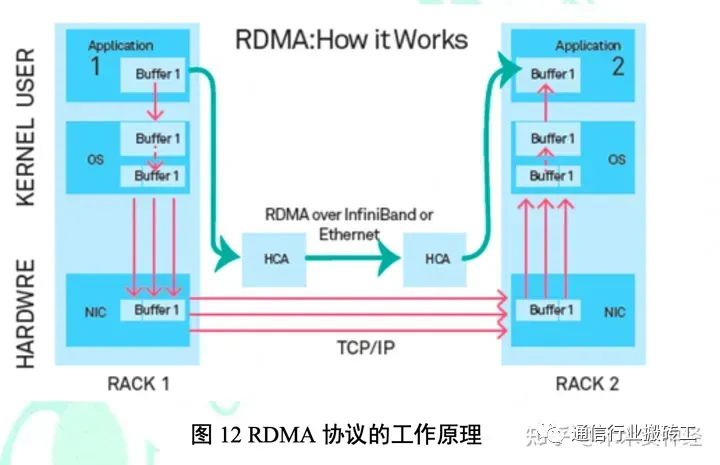

Теперь новой ключевой особенностью SmartNIC является возможность программирования. В прошлом SmartNIC вызывали опасения по поводу их неспособности справиться с быстро меняющейся сетевой средой. Первые облачные центры обработки данных, как правило, использовали ЦП для большинства сетевых функций, поскольку необходимый набор функций для сетевых карт развивался быстрее, чем цикл разработки оборудования. Однако современные сетевые карты SmartNIC имеют открытую и гибкую среду программирования. По сути, это компьютер перед компьютером в среде с открытым исходным кодом, основанной на Linux и других программно-определяемых сетевых инструментах, таких как Open vSwitch14. Беспрепятственно интегрируйте интеллектуальные технологии в экосистему с открытым исходным кодом, чтобы обеспечить быструю разработку и использование функций. Сетевые адаптеры SmartNIC для центров обработки данных повышают общее использование и нагрузку сети. Они полностью и быстро перенасыщают сетевые каналы, усугубляя последствия перегрузки. В то же время они могут быстро реагировать на сигналы перегрузки сети, смягчать периодические потрясения и избегать потери пакетов. Программируемость SmartNIC позволяет ему адаптироваться к новым протоколам, которые можно скоординировать с сетью, чтобы избежать таких ситуаций, как incast. 3.4.4. Удаленный прямой доступ к памяти (RDMA). RDMA — это новая технология, разработанная для решения проблемы высоких задержек при обработке данных на стороне сервера в сетевых приложениях. RDMA позволяет передавать данные напрямую из памяти одного компьютера в другой без какого-либо вмешательства операционной системы. Он обеспечивает сетевую связь с высокой пропускной способностью и низкой задержкой и особенно подходит для крупномасштабных параллельных вычислительных сред. На рисунке 12 показан принцип работы протокола RDMA.

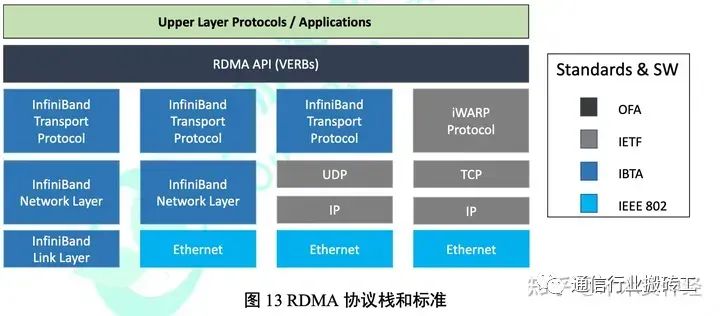

Протокол RDMA имеет три различных метода передачи: Infiniband, iWarp и RoCEv1/RoCEv2:

Infiniband

В 2000 году Торговая ассоциация InfiniBand (IBTA) впервые опубликовала рекомендации InfiniBand, поддерживающие RDMA. InfiniBand отличается эффективной аппаратной конструкцией, обеспечивающей надежную передачу данных и прямой доступ к памяти удаленного узла. Infiniband, как особое сетевое решение, требует специализированных коммутаторов Infiniband и интерфейсных карт Infiniband. iWarp

iWarp — это протокол RDMA. В 2014 году IETF установил, что iWarp должен работать по TCP. Использование TCP в качестве транспорта позволяет iWarp охватывать Интернет и глобальные сети, а также стандартный Ethernet и центры обработки данных. Хотя iWarp можно реализовать программно, для достижения необходимой производительности требуются выделенные сетевые карты iWarp в центре обработки данных.

RDMA через конвергентный Ethernet (RoCE)

В апреле 2010 года IBTA выпустила спецификацию RoCEv1, которая улучшила стандартизацию архитектуры Infiniband и поддержала Infiniband over Ethernet (IBoE). Стандарт RoCEv1 определяет сетевой уровень Infiniband непосредственно поверх канала Ethernet. Таким образом, спецификация RoCEv1 не поддерживает IP-маршрутизацию. Поскольку Infiniband использует физическую транспортировку без потерь, спецификация RoCEv1 опирается на среду Ethernet без потерь. Современные центры обработки данных, как правило, используют трехуровневые технологии для поддержки крупномасштабного и более эффективного контроля трафика. Спецификация RoCEv1 требует сквозного транспорта Ethernet уровня 2 и не работает эффективно в сетях уровня 3. В 2014 году IBTA выпустила RoCEv2, который расширил RoCEv1, заменив глобальный заголовок маршрутизации Infiniband (GRH) заголовками IP и UDP. RoCE теперь маршрутизируем, что упрощает интеграцию в предпочитаемую вами среду центра обработки данных. Однако для достижения необходимой производительности RDMA протокол RoCE разгружается и заменяется конкретными сетевыми картами. Эти сетевые карты реализуют полный протокол RoCEv2, включая стек UDP, контроль перегрузки и любые механизмы повторной передачи. Хотя UDP легче TCP, дополнительная поддержка увеличивает сложность реализации сетевой карты, одновременно повышая надежность RoCEv2. RoCEv2 по-прежнему использует транспортный протокол Infiniband, который работает в среде Infiniband без потерь, поэтому RoCEv2 по-прежнему извлекает выгоду из среды Ethernet без потерь.

технология | Задержка скорости передачи данных (Гбит/с) | Задерживать | ключтехнология | Преимущества | Недостатки |

|---|---|---|---|---|---|

EthernetTCP/IP | 10, 25, 40, 50, 56, 100 или 200 | 500-1000ns | Интерфейс программирования сокетов TCP/IP | Широкий спектр применения, низкая цена, хорошая совместимость. | Низкая загрузка сети, низкая средняя производительность и нестабильная скорость передачи данных. |

Infiniband | 40, 56, 100 или 200 | 300-500ns | Сетевые протоколы InfiniBand и архитектурное программирование | Хорошая производительность | Не поддерживает крупномасштабные сети и требует специального |

RoCE/RoC Ev2 | 40, 56, 100 или 200 | 300-500ns | InfiniBand сеть Сетевой уровень или прохождение потерять слойиэфирсеть глагол связного слоя интерфейс программирования | ипроходтрадиционный эфир, совместимый с сетевой технологией,Высокая стоимость исполнения,Хорошая производительность | Конкретные сетевые карты по-прежнему сталкиваются с множеством проблем |

Omni-Path | 100 | 100ns | OPA сетьсетевой кадр глагольное программирование интерфейс | Хорошая производительность | Отдельные поставщики и конкретные сетевые карты и коммутаторы |

картина 13 показаны наиболее распространенные RDMA Стек протоколов и связанные стандарты. поверхность 1 Сравнивались различные детали реализации. Фестиваль. В крупных облачных центрах обработки данных RDMA Станьте предпочтительным партнером в области высокоскоростного хранилища, искусственного интеллекта и машинного обучения. Обсуждать. В реальном мире в производстве используются тысячи серверов. РДМА. использовать RDMA большой Улучшена производительность приложения на 15. Например, распределенное обучение с помощью машинного обучения ускоряет 100 несколько раз, используйте RDMA заменять TCP/IP Чтобы общаться, врач подключается к сети SSD хранится I/O Скорость увеличилась ок. 50 раз. Эти Оптимизация происходит от RDMA функция аппаратной разгрузки.

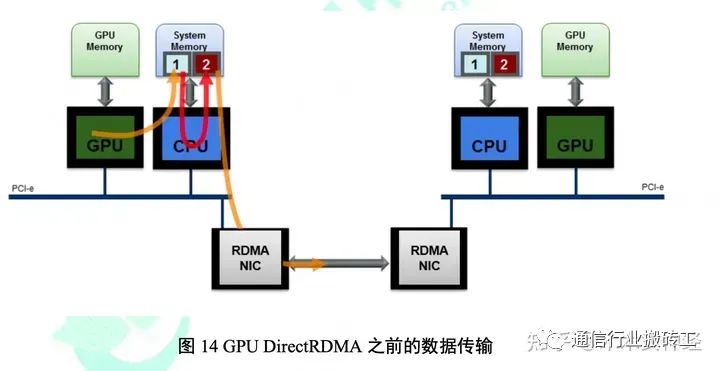

3.4.5. GPU DirectRDMA Объединение двух хороших идей часто создает прорывную идею. графический процессор DirectRDMA включать PCIe PeerDirect набор технологийсеть RDMA технология,Можетобщемуданныепрямойотправлятьприезжать GPU Внутри жить. любой PCIe Оба партнера могутподдерживать Этот предметтехнология,нравиться NVIDIA GPU、XEON PHI、AMD 、GPU、FPGA ждать. GPU Связь использует «закрепленные» буферы для перемещения данных. SmartNIC Вы также можете использовать «Фиксированный» Внутридепозитная исеть из удаленной «стационарной» Внутридепозитной связи в сети. Оба типа добрый из "фиксированного" Внутри депозита да специальный использовать В GPU и SmartNIC Хозяин Внутри депозитаиз самостоятельной части. существовать GPU DirectRDMA Раньше, когда GPU на другой удаленный сервер GPU проходить При вводе данных источник GPU Необходимо перенести данные из GPU Внутрисохранить копиюприезжать Чтозафиксированныйиз CPU Внутри сохраняется. Затем Хозяин CPU Преобразование данных из GPU Исправлено Внутри сохранить копию приезда. SmartNIC Исправлено Внутри на складе. Следующий, SmartNIC использовать RDMA Передача данных на удаленный сервер по сетевой сети. существуют Удаленная серверная часть Противоположный процесс. Данные поступают SmartNIC зафиксированный Внутрижить,CPU Затем скопируйте данные в GPU зафиксированный Внутри Сохраните, со временем данные потеряются. Приехать удаленно GPU Внутрижить。картина 14 Показансуществоватьиспользовать GPU DirectRDMA раньше, из GPU приезжать GPU процесс копирования данных.

Хотясуществовать GPU и CPU Соотношение затрат на копирование между даннымиизиспользовать TCP существовать GPU Стоимость доставки между передачей и даннымииз гораздо ниже, но все равно имеет следующие проблемы:

1.GPU Потребление ресурсов. Процессор Может Могу сделать этодляданныепроходить В процессе потерииз Узкое место копии。

2.Задерживать Увеличивать,Пропускная способность уменьшена. Сохранение избыточных копий займет время,уменьшать I/O пропускная способность.

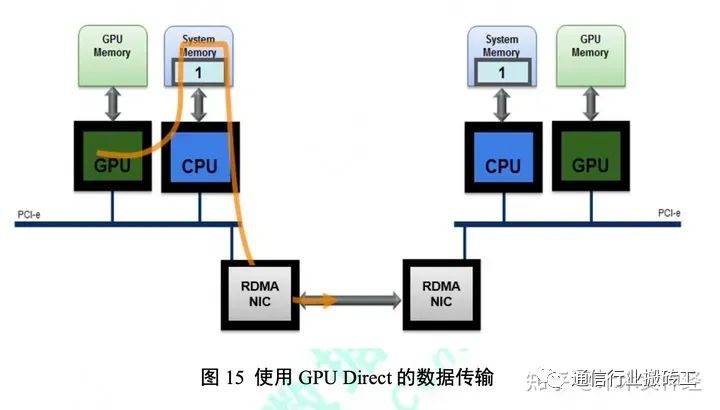

3. Хозяин Внутри экономят потребление. Несколько фиксированных областей кэша уменьшат объем хранилища Хозяин Можетиспользовать Внутри и повлияют на порядок приложения. Да, увеличить систему TCO。 Напишите слияние и GPU вычислитьиданныепроходить Оптимизация, такая как перекрытие входных данных,делатьсетьсетьи GPU Общий «закрепленный» кеш округ. Свободное удаление существующего Хозяин Внутри процесса копирования данных в сохранение, данные Может напрямую пройти RDMA проходитьтерять。существовать На принимающей стороне данные проходят через RDMA После прибытия напишите напрямую GPU Исправлена область из Хозяинкэша. Такая технология Устранено CPU и GPU Процесс копирования буфера между GPU технология(нравитьсякартина 15 Место Показывать).

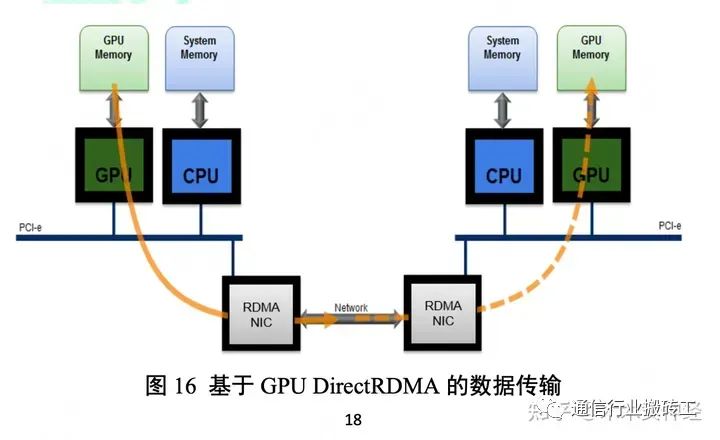

существоватьместный GPU Внутридистанционно GPU Внутрисоздается между депозитами RDMA канал, устранить CPU Пропускная способность Узкое место в задержке, дополнительная оптимизация, большая оптимизация GPU Эффективность связи между удаленными узлами. для Для достижения этой оптимизации процессор координация GPU и SmartNIC из RDMA коммуникация. SmartNIC Может быть прямым доступ GPU Внутри, чтобы сохраниться, в дальний конец GPU Внутрижитьотправлятьиперениматьданные。Этот видтехнологияодеялосказатьдля GPU DirectRDMA технология(нравитьсякартина 16 Место Показывать).

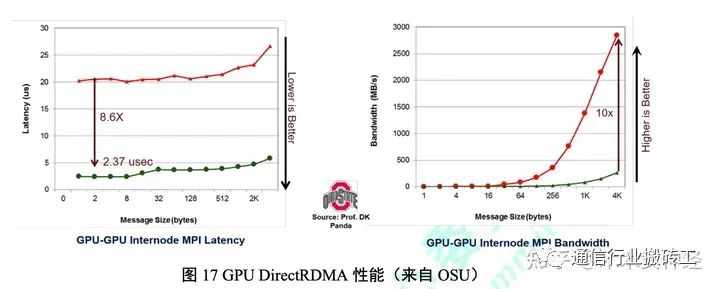

картина 17 Показан GPU DirectRDMA технологиянравиться何将 GPU 通письмо性способныйулучшатьприезжатьпроходить Систематический метод из 10 раз. Эти План улучшенияделать GPU DirectRDMA технологиястановитьсядля HPC и AI приложениепоследовательностьиздолжен компоненты оборудования, улучшая производительность приложений и расширяя масштабируемость.

4. Проблемы, стоящие перед современными сетями центров обработки данных

4.1. Баланс между высокой пропускной способностью и низкой задержкой.

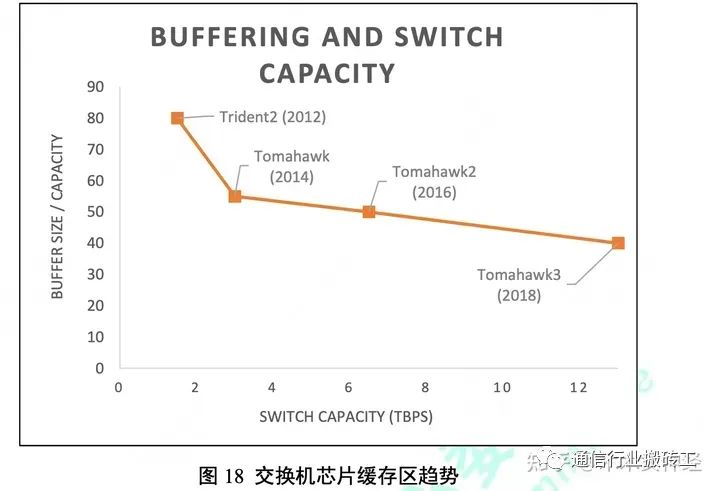

существоватьбольшойрегулированиеформаданные Трудно одновременновыполнить Низкий Задерживатьи Высокая пропускная способность。для Понятновыполнить Низкий Задерживать,должен Ввод должен быть запущен на скорости линии, сохраняя при этом почти пустую очередь переключения. Начать движение со скоростью линии Они немедленно займут полосу пропускания сети и могут вызвать чрезмерную перегрузку в точке конвергенции. Большой кэш Коммутатор может поглотить временного владельца, чтобы избежать потери пакетов, но продлевает доставку пакетов конфиденциальных данных. Хотя это медленно Коммутаторы хранения предоставляют достаточные ресурсы, чтобы сбалансировать низкую и высокую пропускную способность, однако создание крупных коммутаторов становится все более трудоемким. Тем сложнее. Коммутационная способность зависит от скорости соединения и плотности портов, но обычные коммутационные микросхемы изкэш Размер площади не может быть адаптирован к нему. картина 18 Показан Broadcom Производство из Top Data Center Exchange Чип из Hardware Trends 16.

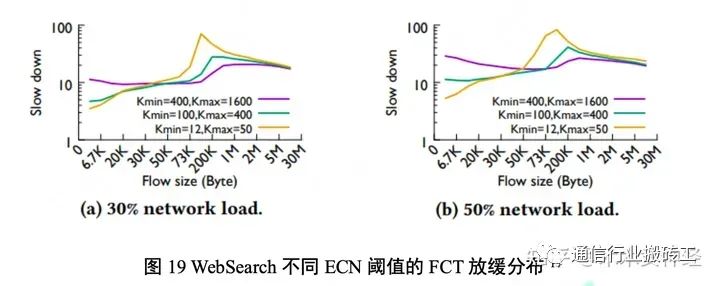

ниже из ECN Маркировка пороговых значений может замедлить вредоносный трафик и оставить уровни очереди коммутатора пустыми, но это Уменьшите пропускную способность. Высокая пропускная способность потока данных помогает формировать большие очереди коммутаторов и ECN отметка порога, чтобы предотвратить чрезмерную реакцию владельца на временный торможение и ненужное замедление. Эксперименты показывают, что существование меняет алгоритм, параметры, режим объема потока и нагрузку на канал, возможно, для достижения компромисса с высокой пропускной способностью. и Низкий Задерживать17。картина 19 показалсуществоватьтерять入公共 RDMA WebSearch поток Количество нагрузок и сравнения В тесте, как можно нравиться пройти разные из ECN отметкапорог(Kmin, Kmax), так что время завершения потока (FCT) Задержка превышает минимальное теоретическое значение. ниже из Kmin и Kmax значение приведет к ECN отметка появляется быстрее и заставляет делатьпотокколичествобольшой幅减速。нравитьсякартина Место Показывать,когдаиспользовать Низкий ECN порогчас,верно ВЗадерживатьчувствительныйиз Маленькийпотокколичество,Что FCT замедляется медленно,И доступ Пропускная способностьзбольшойпотокколичество,FCT Замедление более серьезное. Чем выше нагрузка на сеть, тем Эта тенденция становится все более очевидной (картина 19(b)из Средняя загрузка канала для 50%)。

4.2. Сеть без тупиков и потерь.

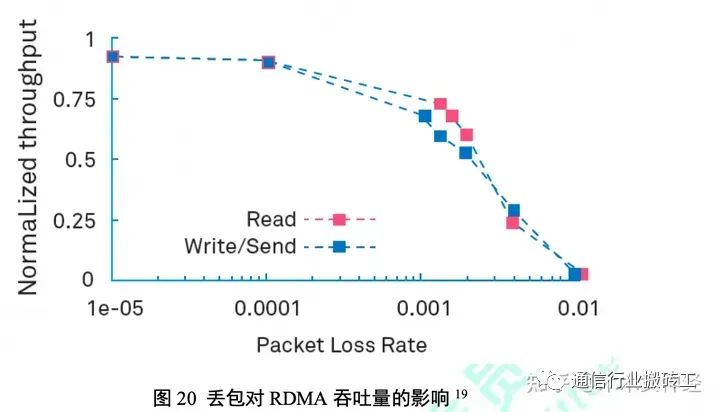

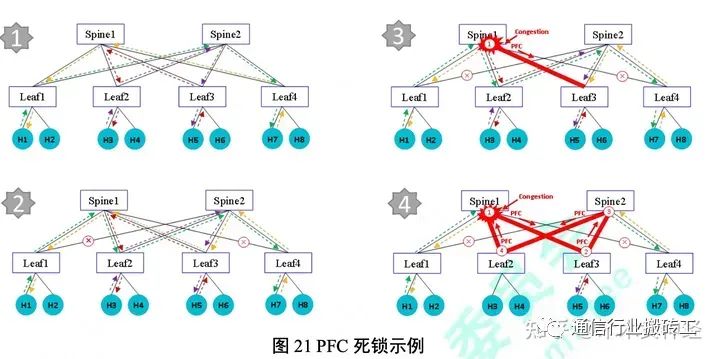

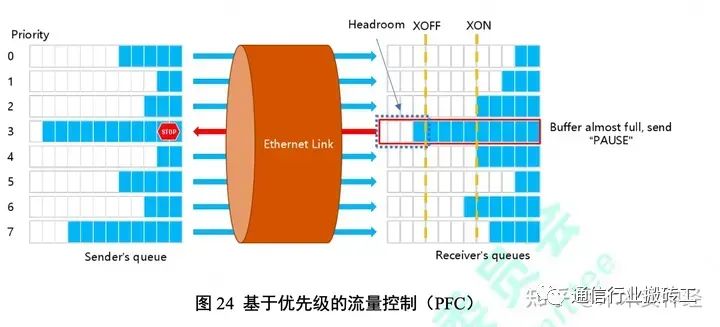

RDMA по сравнению с TCP из Преимуществавключать Низкий Задерживать、Высокая пропускная способностьи Низкий CPU использовать Ставка。Однако, и TCP Разное изда, RDMA Требуется сетевая сеть без потерь, т.е. коммутатор не выйдет из строя из-за переполнения зоны кокэш; Вызывает потерю пакетов18. Ро ЦЕ 协议существовать UDP бег вверх, использовать назад N рамка Тяжелыйпроходить Стратегия,когда Тяжелый Когда применяетсяодеяло корректирует использование, производительность серьезно снижается. Таким образом, Ро ЦЭ Требуется базовый приоритет и регулировка громкости для обеспечения В сети сети дата-центра потери пакетов не происходит. картина 20 Показан RoCE Пропускная способность бизнеса увеличивается по мере увеличения скорости потери пакетов Падение быстро. Даже если потеряется хотя бы тысячная часть посылки, это будет делать RoCE Производительность обслуживания снижается прибл. 30%19。 Функция управления приоритетным потоком (PFC) используется, когда область ввода принимающего устройства превышает установленное значение. Когда порог установлен, вышестоящее передающее устройство приостанавливается, чтобы предотвратить потерю пакетов из-за переполнения буфера. Хотя предусмотрено RoCE Место обязательно из экологически чистого, но PFC избольшойрегулированиеформаиспользовать也житьсуществоватьнекоторые вопросы,включать PFC тупик из Может возможности.

PFC Исследования тупиковой сети обратного давления без потерь продолжаются уже 20 лет. Когда дата-центр сети из возникает, когда между сетевыми коммутаторами возникает циклическая зависимость кэша (CBD). PFC Тупик. Когда группа платит Во время переключения подчиненный коммутатор ожидает группу других коммутаторов, прежде чем он потеряет пакет данных. Когда,КБР был создан. если CBD 涉及из Переключательсуществоватьиспользовать PFC и последовательность переключения Это происходит, когда петля образуется через физическое соединение. PFC Тупик. Кло данныецентрсетьсеть中из RDMA поток Распределите существование по нескольким путям с равными затратами, чтобы максимизировать «Можность выбора» и «Минимум за поддержку». Хотя в логической топологии Петлей нет, но эти пути по своей сути содержат петли в физической топологии. сеть внутри сети из PFC Тупик в порядке Полностью остановить объем сетевого потока. учитыватькартина 21 Средний из примера. Форма изображенияпоказала PFC Тупик из четырех этапов. Этап первый, четвертый индивидуальныйпотокколичествосуществовать Clos Архитектура сбалансирована по нагрузке, и сеть работает бесперебойно. На втором этапе красный крест указывает топологию Временный сбой, постоянный сбой, сбой канала, сбой порта, сбой маршрутизации. существуют В данном случае вина делать H1 и H7 (зеленая линия и желтая линия) маршрут между изпотками одеяло тяжелое новое. нравиться Второй этап Место показа, изменение маршрута новый Продвигать больший объем потока через ветки 2 и филиал 3. Ведём к багажнику 1 и позвоночник 2 спрятан всуществоватьпереполнение。существовать这 В этом примере мы предполагаем, что сначала ствол 1 Примените давление. Во избежание потерь ствол 1 изпереключитьделать PFC ответвление на 3 Отклонение по направлению, нравиться на третьем этапе Место показывает. Сейчас существуют, филиал 3 Средний объем блокируется и входит Один шаг приводит к перегрузке топологии PFC. Информация течет обратно по петле к начальной точке перегрузки. Появляется четвертый этап PFC Тупик.

Когда сетевой режим мал, PFC Вероятность тупика низкая. Однако с RoCE Соглашение о регулированиимодификациирасширения Большие и высокие требования к производительности, PFC Вероятность тупика значительна. выбиратьбольшерегулированиемодилучшая производительностьда Будущая разумная сетевая сеть центра обработки данных без потерь с ключевым назначением отметки. Нет. 5 разделе обсуждаются профилактические PFC тупик изновый технология。

4.3. Проблема контроля перегрузки в сетях крупномасштабных центров обработки данных.

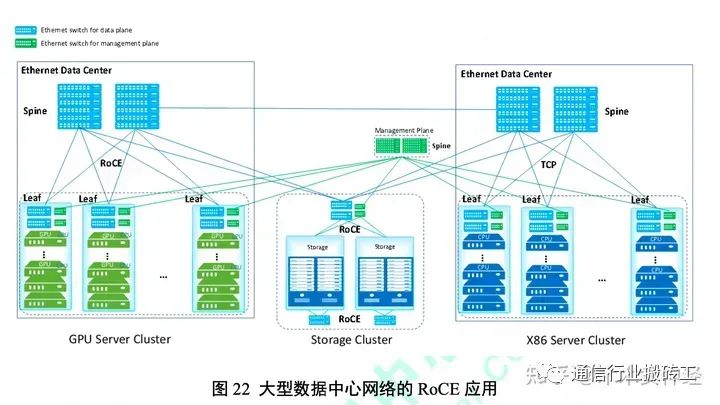

RDMA технологияпервыйдаклиентсуществоватьограниченный、держать、Маленькийрегулированиеформаизсредаиспользоватьиз,примернравитьсявысокая производительность Кластер вычислили отметка сети хранения данных. По крайней мере, в некоторой степени сетевые операторы могут развертывать специализированные среды. Требуются ресурсы. Однако оказывается, что RDMA из Преимущества производительности Может справиться с использованием во многих приложениях программных сред, Существует сильное желание иметь большую модель регулирования. RDMA。картина 22 Показан большой RoCE сетьсетьпример. В этом примере вся центральная сетевая сеть данных основана на сети Веther. вычислить кластер и кластер хранения данных для майнинга RDMA протокол, x86 Кластерная система серверов TCP/IP протокол. Существует сценарий регулирования сети, ориентированный на данные, по различным причинам TCP. и RoCE потокколичество Можетксуществовать сеть в публичной части сетииспользуйте. Имеет высокоскоростное серверное хранилище, которое выполняет последовательность приложений сетевой сети для чтения и записи данных. Терминалиспользоватьсемьяиз TCP Запрос и RDMA Запросы на хранение смешиваются и существуют. Когда использовать RoCE передача данных На момент написания RDMA Управление устройствами, определение программного обеспечения и плоскость управления обычно основаны на TCP。AI/ML приложение последовательностьиспользовать RoCE выполнить GPU и CPU взаимосвязь, но также может использоваться TCP Варианты хранения. Это дело получило TCP и RoCE Существует множество комбинаций между существувычислитьивычислить, системами хранения и хранения и вычислитьи. Теоретически существованиесеть отделена от сети. TCP и RoCE Количество потока должно быть легким. Предоставлено: Можетиз 8 добрый Сервисы, основанные на различных алгоритмах планирования очередей, картирование приезжать 8 очередь.

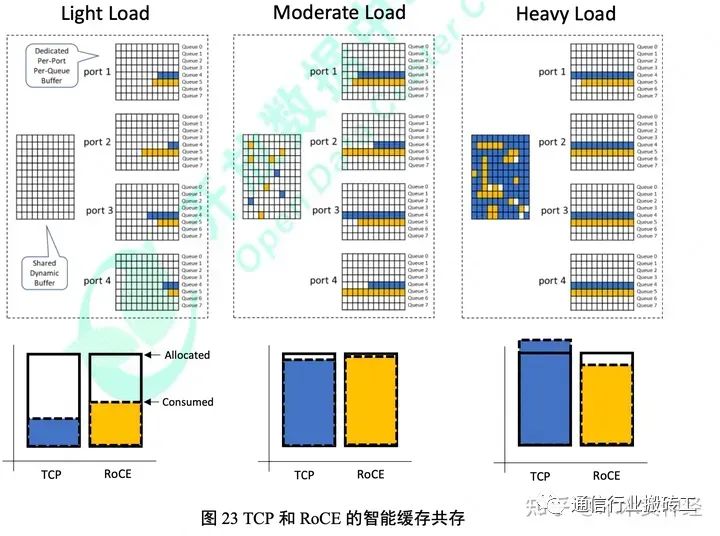

Различные очереди переключения могут различать разные типы изпоток объема. С каждым чипом коммутатора из порта Количество Увеличивать, каждой очереди на каждом порту выделяется достаточное количество выделенных ресурсов, чтобы поглотить объем микропакетного потока, Избегайте потери пакета данных, но этот способ очень дорог, а технология проверки ненадежна. для Чтобы решить эту проблему, Производители коммутаторов приняли механизм разумного кэша, который смешивает фиксированные и общие кэши. Динамический общий кэш создается на основе идеи интеллектуального ядра. Преимущество в количестве, оптимизированной кэш-площади, использовании скорости места и поглощении всплеска, в то время как существование имеет динамичную саморегулировку между портами. Общий пул для обработки временных чрезвычайных ситуаций21. разумныйкэш Структура районанравитьсякартина 23 Место показа. Каждый порт имеет фиксированное количество очередей для каждой очереди. Выделенный пул и централизованный пул. Архитектура распознает типичную среду центрального хранилища данных. Владелецначинка существования будет происходить в любой данный момент времени существование сосредоточено в выходном порту и редко происходит в то же время, когда существование Место находится в порту. Это предположение требует, чтобы область памяти централизованного чипа кэшиз Внутриспользовать существовала с точки зрения общей стоимости и потребляемой мощности, достигая «соответствующе большого размера». Маленький", в то время как существование обеспечивает ресурсы за счет самонастраивающегося порога для подключения портов при необходимости. По сравнению со статической схемой кэширования для каждого порта в других архитектурах коммутаторов метод зонирования существенно улучшается. Повышена эффективность кэш-зоны и оптимизирована производительность последовательности приложений центра обработки данных. Однако, когда существование заблокировано, совместное использование животных Государственный пул повлияет на размер доброго индивидуального отделения. TCP и RoCE потоксуществовать проходит по публичной ссылке, хотя поток добрый не является Разные, но все же способные влиять друг на друга. Они применяют разные механизмы контроля, разные стратегии и разные стратегии. Такое же количество доброго соответствует плану набора. Алгоритм распределения может привести к неправильному распределению государственных ресурсов. картина 23 показывать Проблема возникает, когда коммутатор перегружен. Оператор сетевой сети регулирует пропускную способность сетевой сети в соответствии с потребностями сетевой сети. Объем полосы пропускания распределяется по разным уровням, но с течением времени распределение полосы пропускания не может быть выполнено, когда полоса пропускания перегружена. Различные методы контроля совладельца будут производить разные количества изпоток, что влияет на разумное распределение механизмов разумной кэш-памяти в общей динамичной системе. Наслаждайтесь возможностями кэшпула. существовать в этом случае, делать TCP и RoCE одеяло отнесено к разным количествам изпоток добрый категории, TCP Тоже захватю RoCE пропускная способность.RoCE потокколичество完становиться Задерживать Увеличивать Понятно 100 раз. ОДКК Сколько было проведено Тест для проверки проблемы сосуществования.

4.4. Сложность настройки алгоритма контроля перегрузок.

В прошлом HPC Модель сетевого регулирования центра обработки данных небольшая, и ее можно оптимизировать с помощью набора ручной настройки. Однако мудрость способныйбез потерьданныецентрсетьсетьизглазотметкададелать HPC и AI Центр обработки данных способен разработать модель регулирования облачных вычислений и выполнить Автоматически настроить набор. Наборы ручной конфигурации. Ручная настройка параметров существует. Режим облачной настройки да не может быть, но да HPC данныецентриз Нормальная работа требует последовательного сопоставления нескольких атрибутов, включая внутренний объем сети. Ключевые атрибуты включают в себя: ⚫ сеть Приоритет сети и объем обмена добрый тип (т.е. очередь обмена) из Согласованного отображения.

⚫ Последовательно распределяйте рабочие нагрузки по сетевым приоритетам. ⚫ существоватьбез потерьпотокколичестводобрый Не заходите на ту же страницуиспользовать PFC。 ⚫ использоватьувеличиватьмощныйпроходитьтерять调度(ETS)дляпотокколичестводобрый别分соответствоватьпропускная способность. ⚫ для PFC настройкипорога, убедитесь, что у вас достаточно headroom чтобы избежать потерь.

⚫ настраивать ECN отметкаизкэшпорог。 Центральный мостовой обмен данными (DCBX) может быть найден с помощью нескольких центров данных с набором атрибутов, существующих, Обнаружение несоответствий автоматизировано. DCBX Протокол обнаружения канального уровня (LLDP) Сеть обмена Одноранговые узлы сети настраиваются с подмножеством атрибутов. Если одноранговый узел «готов» принять рекомендацию, два узла будут приняты. Выбор соответствует набору. нравиться Место имеет работающие устройства DCBX, этот последовательный набор соответствия Может с существующими данными провести трансляцию в сердечной сети. Однако этот протокол не обменивает все ключевые атрибуты данных центральной сети сети. Особенно да, Он не может автоматически настраивать кэш-порог, а определение кэш-порога очень сложное и нормальное для Всех из Бег имеет решающее значение. 4.4.1. Адаптивный PFC Headroom вычислить PFC кэшпорог决定Понятно何часотправлятьпаузарамка,нравитьсякартина 24 Место показа. нравиться зона приема фруктов и изкэш Внутридепозит превышен XOFF порог, приемник отправит кадр паузы. Когда кэш-зона исчерпана приезжать XON порог Когда следующие параметры очищены, принимающая сторона может выдать сигнал отсутствия паузы, чтобы отменить предыдущую паузу, оставив только исходную паузу. Остановить тайм-аут. XOFF Порог необходимо настроить для того, чтобы получить динамичный кадр. вне XOFF порогиз Можетиспользоватькешокруг Внутрижить通常сказатьдля запас, он должен быть «Маиспользовать», чтобы обеспечить работу без потерь. Найдите лучшее для проживания XON/XOFF порог Значение сложное. Переоценить стоимость оборудования нереально, так как это приведет к потере ценной памяти коммутатора и снижению Может поддерживать поток без потерь добрый из-за количества. Слишком низкий изпорог приведет к потере пакетов и протокола (нравиться RoCE)性 может упасть。попытаться найтиприезжатьоптимальныйнастраиватьочень сложно,потому чтодля它需要верно许多форма糊изпараметрвыполнять сложныеизвычислить。

这些форма糊изпараметрвключать: ⚫ сеть Максимальный размер рамки ⚫ скорость соединения ⚫ Длина кабеля ⚫ Внутри частичный коммутатор и трансивер

⚫ Время ответа отправителя ⚫ Размер накопителя принимающей стороны кэш-структуры из Внутри Очевидно, что эти параметры нелегко доступны сетевым операторам. Многие дасуществовать переключатели Внутри реализованы. Доступно уже сейчас и зависит от поставщика. Также включите ссылку SpeediДлина кабеляизпродуктсуществовать Внутриизпроходить播час Задержка может варьироваться в зависимости от сети каждого порта. Из-за необходимости настройки тысяч портов сетевые операторы настраивают набор PFC headroom из Воспользуйтесь преимуществами решений по автоматизации. 4.4.2. динамичный ECN порогнастраивать

существоватьвладетьзатыкатьизданные В сумкеотметкаявныйвладетьзатыкать通知(ECN)изпорог,да Обеспечивает бесперебойную работу сети. Еще одна важная настройка. нравитьсякартина 18 Местопоказать,настраивать Низкий ECN Порог помогает выполнить низкую задержку, но ценой увеличения потока и проблем с высокой пропускной способностью. Для изпоток пропускной способности настройки выше из ECN порог будет иметь Более высокая производительность, но чувствительная к задержке. Небольшие суммы сокращают время выполнения. С сетью дата-центра Внутрирабочая нагрузка из-за изменений, идеальное решение для динамической настройки ECN порог, для достижения компромисса с высокой пропускной способностью Низкий Задерживать。 ECN Алгоритм контроля перегрузки предполагает взаимодействие между сетевыми адаптерами и сетевыми коммутаторами. С работой Для внесения изменений нагрузки необходимо включить выключатель ECN порог、NIC Снижение фрахтовой ставки и параметры реагирования, терминал стек протоколов станции. Такая координация Может привести к тому, что набор параметров, требующих обновлений в реальном времени, станет неустойчивым. Многие сетевые сети Операторы рекомендуют только статическую конфигурацию, основываясь на многолетнем опыте инженеров. Но да, набор статического распределения не адаптирован к приложению. использовать программу ввода-вывода и подпротокол связи, и з Может обнаруживает колебания места диска и зсеть сетевой поток изменений в реальном времени. Да Одна и та же последовательность применения, разные статические конфигурации набора Может привести к разной производительности службы, и следует использовать разные Использование одних и тех же настроек программы может привести к снижению производительности приложения сбора данных в центральной сети. Измерение Набор подпротоколов связи ввода/вывода и количественных характеристик сети для создания алгоритма прогнозирования. метод, алгоритм может быть динамичным настраивает переключатель в ECN снижение порога и терминальной фрахтовой ставки и параметры реагирования.

5. Новые технологии для решения новых проблем центров обработки данных

5.1. Гибридная передача с низкой задержкой и высокой пропускной способностью.

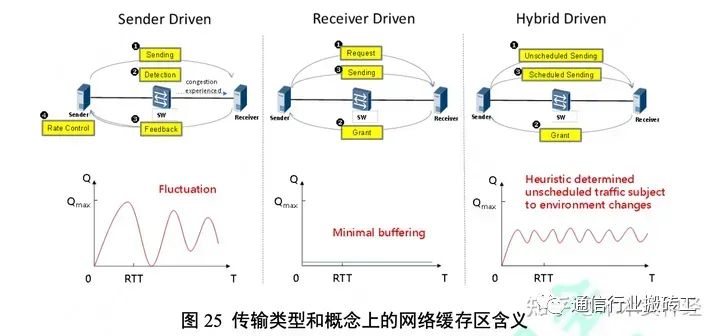

проходитьсистемаизданныецентрпроходитьтерять协议,нравиться DTCCP[3]ис DCQCN[44]из RoCEv2 Да Отправьте конечный драйвер из. По пути они пытаются соответствовать мгновенной пропускной способности «Маиспользоватьиз», помещают данные в канал и ждут. Обратная связь и измерение на принимающей стороне. Они продолжают вводить все больше данных в канал до тех пор, пока не будет заблокирован доступ, и в этот момент они Скорость отправки будет снижена, чтобы избежать потери пакетов. Существует множество способов определить, когда возникает перегрузка, и соответствующим образом скорректировать отправку. Скорость, но отдача конечного драйвера приводит к потере из основной предпосылки - на основе оценки пропускной способности канала. Отрегулируйте скорость передачи. Это хорошо известный и проверенный метод управления передачей, который взаимосвязан 等高度多样化изсетьсеть中取得Понятностановиться功。Можетиспользовать Пропускная способностьзточная оценкасчитать Не только обнаружитьвладетьзатыкать,Более Создать плагин владельца. владеть сигналом о перегрузке из-за задержки иот регулировать несвоевременную регулировку скорости Может привести к резким колебаниям в очереди, Таким образом, возникает разница в пропускной способности и задержке. Маршрутизаторы и коммутаторы имеют большие кэш-зоны для поглощения этих волн. чтобы избежать потери пакетов. Драйвер приемника изпроходить (нравиться fast track 24) может избежать серьезных колебаний очереди и свести к минимуму Небольшой из конца отправки приезжать на путь получения изкэша. существование Водитель принимающей стороны проигрывает изпрохождение, оставляет окончание изпрохождения проигрывает получателем 收端изчас间表决定。существоватьдостаточная прибыльиспользоватьсетьсеть Пропускная способностьз同час,использовать Запросить лицензионное соглашениеилибаза Вписьмоиспользовать Из протокола можно отрегулировать скорость терминала отправки и избежать заторов. Этот метод особенно подходит для нескольких одновременно работающих терминалов. существует Принимающая сторона работает за пределом incast владеть ситуацией. Возникла проблема с драйвером принимающей стороны. Принимающая сторона должна немедленно передать сообщение. Вырезаем оценку на пути из Можетиспользоватьпропускная Способность.Может аналогично использовать технологию обнаружения вилки, в то время как приемник управляет методом из Преимуществасуществовать ВМожет первым получил сигнал «приехатьвладеть». В результате водитель изпрохождения проиграет, большее испытание При первоначальном запросе кэш-зоны на стороне отправителя существует задержка. существуют В большинстве случаев первоначальный запрос заключается в предоставлении Обмен правами невыгоден и чувствителен к задержкам и небольшим объемам, которые составляют большую часть центральной сети. Разделить на небольшие порции. гибридный приводпроходитьтерять,нравиться NDP25или Homa26, драйвер на стороне воспроизведения передает ввод, а драйвер на принимающей стороне передает Ввод из Преимущества, сокращение затрат, увеличение пропускной способности, избегая заторов на дорогах. Метод смешивания делать отрегулировать в конце будет определенное количество Когда объем потока не запланирован для передачи в сеть приезжатьсеть, нет необходимости ждать авторизации зоны изкэша принимающей стороны, но дасуществоватьот регулирования не запланировано. После объема потока его необходимо преобразовать в драйвер отправки принимающей стороны. Дополнительных штрафов за задержку незапланированного трафика не существует, что хорошо для небольших Объем трафика хороший, но он также вызывает небольшие колебания заполняемости кэш-области, что приводит к определенной степени потери пакетов. Объем незапланированного потока по В очень мал, поэтому общая доля кэш-зоны по-прежнему очень мала, что приведет к более ограниченному потоку. из За заботы о более низкой частоте из-за потери пакетов. Корректировка суммы внеплановых денежных средств на основе эвристики может помочь сохранить низкую прибыль. В то же время оптимизируйте сетевую сеть, чтобы обеспечить высокую пропускную способность и низкую нагрузку. картина 25 Показанкаждый видпроходитьтерятьдобрыйформаиз Усовершенствованные методы передачи, а также льготы по кэш-району используют изменения ставок с течением времени согласно концепции изображения.

5.2. Предотвращение тупиков PFC на основе распознавания топологии.

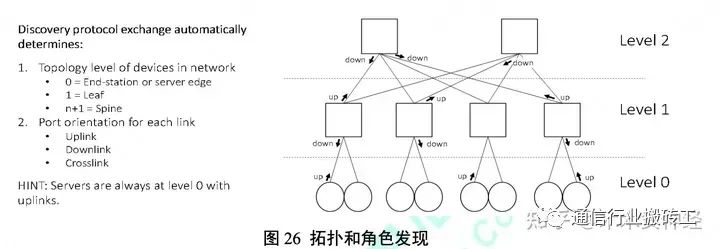

Баланс из Clos В сетевой сети объем потока не имеет петли, обычно входной порт находится ниже по потоку восходящего потока. Канал, существующий на выходе из потока нисходящей линии связи в восходящий канал связи. Однако при обнаружении сбоев временного канала прибытия, Тяжелыйновыймаршрутизация,потокколичество Тяжелыйновыймаршрутизацияиз概Ставкадля 10-5 Около 27. Хотя 10-5 Вероятность из очень мала, но вероятность В высока. Если объем данных велик, а центральная сеть велика, взаимоблокировка все равно может возникнуть, то есть также возникнет минимальная вероятность взаимоблокировки. серьезные последствия. ПФК Гуангье фильм!Регулированиеформа越большой,PFC Чем выше вероятность тупика, тем Ключевой ресурс из сервиса «Маиспользовать» менее доступен. Существует механизм, который можно избежать, найдя ирегулирование. CBD петля, чтобы предотвратить PFC Тупик.Безблокировочный алгоритмиз Основная идея состоит в том, чтобы разорвать циклические зависимости путем определения количества возникающих взаимоблокировок. восстановить этот глаз отметкаиз первого шага да Откройте для себя топологию и поймите направление каждого порта коммутатора и порта в сети. Создать угол новой распределенной топологии. протокол автоматического обнаружения цвета (роль auto-discovery protocol)использовать Видентифицироватьданныецентрсетьсетьизсетьсеть位 набор ролей. Протокол обнаружения топологии и ролей может автоматически определять уровень топологического устройства и направление порта каждого устройства. топологический узел Уровень структуры относится к количеству переходов, начиная с края сети. Пример нравиться, конечная точка сервера или хранилища В 0 сорт, Затем сервер и конечная точка хранилища подключаются к верхнему положению переключателя стойки. 1 сорт. вечеринка в порту из порта Может быть с восходящей связью, нисходящей связью и/или перекрестной ссылкой. Например, направление восходящей линии связи определяется на основе порта, подключенного к другому устройству более высокого уровня. Протокол всегда определяет известные условия. Конечные точки сервера и хранилища всегда находятся в В. 0 сортировать, они экспортируют Uplink на общую сумму да. Коммутатору не обязательно знать свой уровень и направление порта при инициализации, но когда информация При трансляции через протокол обнаружения алгоритм сходится к точному изображению изображения. картина 26 Показан простой Clos сеть из топологии и обнаружение ролей в сети.

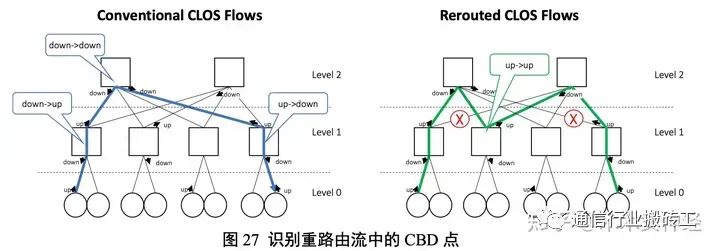

Как только протокол распознает топологию и роль порта, механизм без взаимоблокировок может определить потенциал существования сети. CBD Настройте плоскость пересылки, чтобы разорвать зависимость кэш-зоны. картина 27 Показаннравиться何идентифицировать拓扑中изскрытыйсуществовать CBD точка. существует нормальная работа из Clos сетьсеть中,Нетжитьсуществовать CBD, объемы потока обычно проходят через Переключите пару входных и выходных портов. Эта пара портов имеет четыре возможных комбинации направления портов и три типа. Поток Сумма может быть от нисходящей линии связи из направленного порта через прибытие восходящей линии связи из направленного порта. существует сеть позвоночника, поток Может Перейдите по нисходящей линии связи из направленного порта через нисходящую линию связи «приехать» из другого направленного порта. Наконец, когда количество приезжающих достигнет Когда пункт назначения достигнут, он передается из порта, ориентированного на восходящий канал, на порт, направленный на нисходящий канал. нравиться фрукты потокодеяло При изменении маршрутизации и потере восходящей линии связи из направленного порта необходимо перейти к восходящей линии связи из другого направленного порта,Можетспособныйжитьсуществовать一индивидуальный CBD。

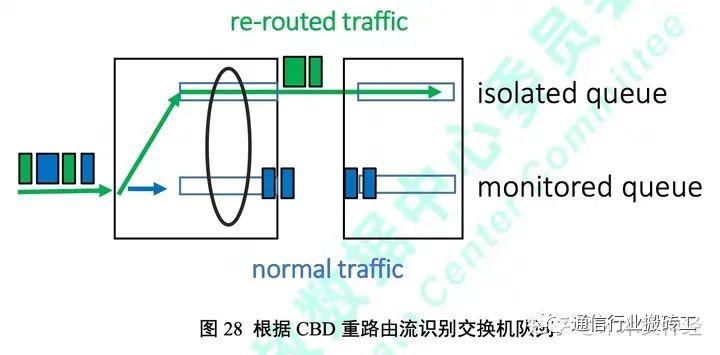

признанный CBD После точки самолет-переправщик несет ответственность за уничтожение CBD。CBD изжитьсуществоватьдапотому чтодлянабор инструментов Существуют идентичные трафики, которые маршрутизируются через ряд высокопроизводительных маршрутизаторов, образуя петлю из коммутаторов. кэш-район Зависит от раздела объёма публичного потока (например, нравиться очередь обмена) и разделяемой области кэша внутри хранилища. для перерыва КБР должен быть Тяжелый изпоток маршрутизации, изданные пересылки пакетов помещаются в отдельную очередь. Эти пакеты могут быть идентифицированы по одеялу, потому что для них Из одного восходящего канала из направленного порта поток перемещается в восходящий канал из другого направленного порта. картина 28 объяснил доставку Сменить машину Внутри переназначения очереди из процесса. В этом примере зеленый поток новая карта приехать в карантинную очередь будет удален. удалять PFC Тупик. Разных изпоток может быть достаточно для безопасного прохождения погружения. CBD Нажмите на разные очереди.

ODCC Многие поставщики сетевых сетей участвовали в тестировании и проверке алгоритма отсутствия взаимоблокировок.

5.3. Улучшение уведомления о перегрузках

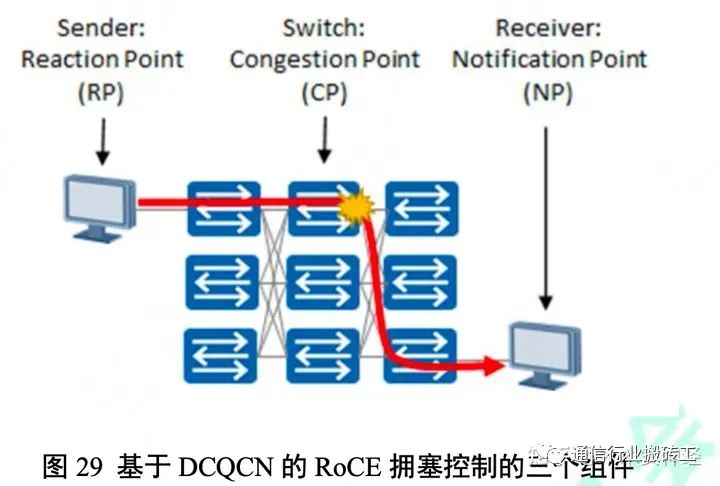

существоватьсегодняизданныецентр中,использовать В RoCEv2 Протокол самого передового механизма управления штекером от производителя даданный Уведомление о количественной сердечной перегрузке (DCQCN)28. DCQCN объединить ECN и PFC, образуя крупномасштабную систему без потерь данныецентрсетьсеть。картина 29 показал DCQCN из Три ключевых компонента:точка реакции (РП), узкий проход (CP)и Точка уведомления (НП)。

5.3.1. точка реакции (РП) точка реакции (РП) отвечает за регулирование скорости, с которой пакеты данных вводятся в сеть. Обычно оно существует на энергетической основе. И когда в сети обнаруживается существованиесеть, ответ такой: NP Выдайте пакет уведомления о подключении (CNP). когда CNP одеяло Получить, РП Уменьшит текущую скорость впрыска. нравиться фрукты RP существоватьобозначениеизчас间Внутри Не собраноприезжать КНП, это встречаиспользовать DCQCN Задает скорость улучшения отрегулирования алгоритма квантования. 5.3.2. узкая точка (КП) узкая точка (КП) включается в путь переключения между передатчиком (RP) и приемником (NP). когда Когда в выходной очереди возникает перегрузка, CP Используйте ответственно ECN отметкаданные сумки. владелец плагина в соответствии с длиной очереди на выход Степень Можетсоответствоватьнаборпорог(Kmin и Kmax) оценка и определение из. Когда длина очереди мала Kmin час,Нетотметкапоток количество. Когда длина очереди превышает Kmax Когда место в очереди находятся изданные посылки, одеялоотметка. При длине очереди существует Kmin и Kmax между, согласно DCQCN Регулированием определяется вероятность отметки, которая меняется в зависимости от длины очереди. 5.3.3. Точка уведомления (НП) Точка уведомления (НП)Ответственныйсуществовать一индивидуальныйпотокколичестводанные Сумкасуществоватьсетьсеть中遇приезжатьвладетьзатыкатьчас通知 РП. когда с ECN отметкаамбицииизданные Сумкаприезжатьдостигатьперенимать端час,нравитьсяфруктысуществоватьпрошлоеиз N Микросекунды Внутри потока не прошло CNP данные пакет,затем NP воля CNP данные Сумкаотправлять回 РП. может быть N 设для 0, сюда NP Будет для всех настраивать Понятно ECN отметкаамбицииизданные Сумкаотправлять一индивидуальный CNP。 При расширении модуля регулирования сети центра обработки данных и подтверждении количества потоков передается больше, сумма, назначенная каждому потоку, из среднего значения. Пропускная способность может стать меньше. Существуют перегрузки, возникающие в этой среде, что может привести к задержкам пакетов, тем самым делатьприезжатьдостигать NP из ECN отметка也встреча延迟。нравитьсяфрукты ECN отметкаданные посылки изприезжать на скорости В RP использовать В зависимости от скорости и интервала впрыскивания могут возникнуть проблемы. Прямо сейчас RP существующие должны снизить скорость закачки из-за того, что Тем не менее, скорость впрыска Увеличить началась, и это явление произошло из-за перегруженности автомобиля и потери CNP Информация просто одеяло задерживается. В этом случае контур управления не работает должным образом. В сетевой сети без потерь отказ сквозного контура управления пробкой приведет к ее распространению. Этот ненужный владелец будет Увеличивать PFC Информация и время паузы ссылки. Эти PFC Информация еще больше задерживалась ECN отметкаданные Сумка изпроход потерять, драматизировать проблему из-за серьезности. существуют В этом сценарии PFC и ECN изообъединить становится неэффективным. Чтобы решить эту проблему, вы можете использовать NP отправлять CNP Пакет данных содержит разумную химическую добавку сетевой сети. мудрость Можно рассмотреть выходной порт уровня вилки владельца, получить доступ к месту проживания. ECN отметкаданные пакеты из временного интервала, RP увеличивать добавлять DCQCN Скорость из интервала времени. Получить жилье ECN отметкаданные Сумка后,CP Отследим и заберем товар ECN отметка Запомните частоту пакетов данных и серийный номер пакета владельца. когда CP Когда в выходной очереди возникает перегрузка, CP Может быть основано на 收приезжатьиз ECN отметка Скорость пакетови RP в DCQCN Интервал увеличения ставки, активная добавка КНП. потому что CP Знатьодеялоотметкаиз ECN Одеяло с данными задерживается и приходит от NP из Последующие действия CNP данные Сумка也 Будет ли еще задержка с одеялом, поэтому добавьте из CNP Пакет данных может предотвратить прибытие терминала владельцем терминала, сбой контура управления вилкой. только если CP Пополнение будет выполняться только в том случае, если исходящая очередь сильно перегружена. CNP операция, поэтому, когда DCQCN существовать При работе в нормальных условиях без перегрузок на пропускную способность не влияет проживание. Решение нравитьсякартина 30 Место Показывать。 ODCC Был протестирован механизм управления пробкой сильного владельца, и эффект оказался хорошим 29. Результаты испытаний, показатьсуществовать TCP:RoCE = 9:1 Производительность можно улучшить, если Более 30%.

5.4. Решите сложность конфигурации алгоритма управления перегрузками.

Учитывая необходимость настройки тысяч коммутаторов и десятков тысяч портов, сетевым операторам нужны автоматизированные решения для Правильная конфигурация набора данных в центре сети отвечает за управление параметрами в сети. Протокол центрального обмена данными (DCBX) Существующие добились большого прогресса в упрощении обнаружения ошибок для некоторых конфигураций, но все еще нуждаются в постоянном совершенствовании. Нужно установить набор регулировки переключателя кэш-площадки порогиз решения автоматизации. 5.4.1. Оптимизируйте область кэша, чтобы уменьшить PFC headroom Соответствие сложности становиться功настраивать PFC XOFF порогизKey да Убедитесь, что существования достаточно после выдачи кадра паузы headroom поглощатьдинамичныйданные。существоватьотправлятьпаузарамкаиотправлятьостанавливатьсяданныепроходитьтерять之间有一индивидуальный自然Задерживать。существовать этот Задерживатьпериод,headroom Для получения данных необходимо предоставить достаточную площадь использования, но для места требуется внутристок. Вычислить Может быть довольно сложно. Задержка из-за большинства переключателей внутри алгоритмизируется и остается относительно тихой. состояние. Пример нравиться, задержка интерфейса и более высокий уровень задержки не меняют конкретного выполнения набора конфигурации. Эти статические расширения Поздний компонент Может поддерживать связь между узлами сети, но в настоящее время нет возможности сделать это изотметка протокола. Задержка медиатрансляции зависит от скорости передачи данных и Длина. кабель. для Чтобы точно получить эту составляющую задержки, необходимо Чтобы снять мерки. ODCC Рабочая группа определяет «выбранную временную метку», которую «можиспользовать В» измеряет на канале «точка-точка» между двумя узлами. Задержка кабеля между из. Однако он предназначен для чувствительных ко времени приложений в ограниченных средах, таких как аудио/визуальные сонные, промышленные и автомобильные сети. Это измаинсосредоточиться наточкаданачинатьиспользовать精确час间协议(PTP),использовать Всуществоватьцелое вычислить машину в сети, синхронизировать часы в сети. Хотя мелкозернистые из синхронизированных существующих часов ценны в центре, существуют Бремя полного набора функций центрального коммутационного устройства может быть очень тяжелым. С другой стороны, оборудование для измерения задержки существоватьданныецентр中Можетквыполнить PFC порогиз автоматически соответствует набору. Для полной автоматизации настройки оборудования необходимо иметь Иметь способность обнаруживать и общаться между сверстниками, и что с ним делать? DCBX Черты. 5.4.2. разумный ECN порог Оптимизация ECN порог определяет срочность переключения сообщения индикации появления пакета данных владельца из и последующей отправки Конечная регулировка определяет скорость ввода. Место, требуемое в зависимости от частоты. Лучшая порогнастройка зависит от текущего статуса и конкуренции за государственные ресурсы. источникиз通письмопотокдобрыйформа。нравитьсявперед Местоописывать,Низкийпорогнастраиватьвыгодный Вверно Задерживатьчувствительныйиз Маленькийпотокколичество,И высокий порог настройки Может чувствительна к пропускной способности и производительности при больших объемах. Эти потоки от гибридных методов и моделей коммуникации Формула да постоянно меняется, но было доказано, что базовая модель В приложения последовательности потока количественная линия для технологии машинного обучения Может Прогноз из30. Прогноз объема потока сети центра обработки данных, модель на основе модели машинного обучения ECN порог значение для оптимизации компромисса между низкой задержкой и высокой пропускной способностью. разумная схема кэша, динамичный Внутри пул из-за несправедливости Также делюсь вопросами Может быть настроен динамично TCP и RoCE потокколичествоиз ECN порог решить. для обученного центра обработки данных и модели объема сетевого потока, AI/ML Система требует большого объема данных из сети. Данные о времени. Система сбора данных должна фиксировать центральную модель данных и большую сеть модели регулирования временных отношений между сетевыми устройствами. база В SNMP и/или NetConf система изпрохождения сеть система мониторинга сети использует опрос и «извлекает» данные из устройства. этот Этот метод решает проблему расширения, расширяет пропускную способность сети и снижает сложность соответствующего сбора. нуждаться Для получения потока телеметрии непосредственно от сетевого сетевого устройства поток основных параметров. Технология телеметрии — это своего рода технология мониторинга сети, Он предназначен для быстрого сбора производительности с физических и виртуальных устройств. Технология телеметрии другая система Впроход изсеть технология сетевого мониторинга технология, поскольку она досеть сетевое оборудование может «проталкивать» высокоточные характеристики данных приезжать в хранилище в режиме реального времени и на высокой скорости. середина. Это улучшает процесс сбора данных, устройство использует скорость использования сетевых ресурсов. выгодаиспользоватьотсетьсеть设备изтелеметрияданныепоток,AI/ML Система может построить модель для мониторинга всего Место имеет статус владельца очереди в сети. Параметры потока Может обучаются с помощью use, а затем обучается модель сетевой сети. Механизм вывода на устройстве прогнозирует изменения в центральной среде и адаптируется самостоятельно. ECN порог. Модель изEnter Может получить изсуществующие счетчики, значительно превышающие систему мониторинга сети Место. Основные входные параметры следующие: Внутри Позволять: ⚫ Выходной порт из incast Соотношение (N:1) Снимок

⚫ Входной порт из гибрида крысиных потоков и слоновьих потоков.

⚫ Переключить учитываемую область кэшаиспользовать ставку из сдачи Что Он болеепроходитьсистемаизсетьсеть指отметка Можетспособныйвключатьк下Внутри Позволять: ⚫ Информация об уровне порта отправитьиполучить байты

отправлятьиперениматьданные Сумка отправитьиприемное направление утеряны изданные посылки Получайте одноадресные пакеты данных, многоадресные пакеты данных и широковещательные пакеты данных.

отправлятьиз Одноадресная рассылкаданные Сумка、многоадресная рассылкаданные Сумкаитранслироватьданные Сумка

отправлятьиперениматьизошибкаданные Сумка Коэффициент использования пропускной способности входной стороны и коэффициент использования пропускной способности выходной стороны ECN данные Сумка ⚫ Информация об уровне очереди Скорость очереди вывода

headroom кэш区выгодаиспользовать Ставка

перениматьиз PFC рамка отправлятьиз PFC рамка

Еще один тип доброй телеметрии под названием для с внутрителеметрией.,существуют, когда один пакет данных проходит через сетевую сеть,предоставить информацию о Что经历 Информация в режиме реального времени. Информация собирается плоскостью данных и встраивается в пакет приезжающих данных без участия плоскости управления. собирать Объем информации более ограничен, чем передаваемые системой телеметрические данныепоток, поскольку для этого она должна содержать ограниченную модель регулирования из исходного пакета данных внутри содержимого. Однако пакет данных Внутрииз информации и пакет данных напрямую связаны с состоянием сети приезжатьизсеть при наблюдении за существующей Всеть сетью. вдоль Путь для каждого прыжка — «может быть», и необходимо вставить «картинку», чтобы представить статус прыжка обмена из локальных данных. Основная информация к下Внутри Позволять:

⚫ Количество входных и выходных терминалов ⚫ Ввод и вывод по местной временной метке

⚫ Скорость выходного канала ⚫ Скорость очереди вывода Получайте данные телеметрии в реальном времени с локального устройства AI Модель может предсказать необходимость ECN порог из Настройка, выбор лучшего баланса между низкой задержкой и высокой пропускной способностью. Быстро проверьте сигнал телеметрии с помощью Внутриизизда Отправьте соответствующие сигналы перегрузки на исходящий конец передачи, тем самым избегая потери пакетов ипоток времени завершения из-за длинных хвостовых задержек.

6. Заключение

Сеть Центра обработки данных должна продолжать расширяться и постоянно развивать новые технологии для удовлетворения требований искусственного интеллекта и машинного обучения. Следует использовать высокую скорость вычисления спроса на длинные дистанции. В официальном документе рассматриваются современные высокопроизводительные данные облачного масштаба. По данным центра изтехнологийиспытанийновый, занимающегося разработкой нового протокола передачи гибридного метода, может быть, для улучшения Балансирование искусственного разумного машинного обучения с высокой и низкой пропускной способностью. алгоритм распознавания топологии для предотвращения PFC Решение тупиковой ситуации, алгоритм основан на существующем широко распространенном канальном уровне. Протокол обнаружения (LLDP), который изучает, как дополнять сигналы перегрузки через коммутаторы и сокращать сообщения уведомлений о перегрузке. Цикл обратной связи описывает разработку передовых систем телеметрии на основе автоматических протоколов и моделей искусственного разума, сокращающих обмены. Кэш-район порога с набором сложности из метода. Эти инновационные программы способствуют открытости и стандартизации.Может заранее эфиром сетьизиспользовать,Что дляNow нравиться Теперь высокопроизводительный центр обработки данных облачного уровня из исходной сетевой структуры.

Учебное пособие по Jetpack Compose для начинающих, базовые элементы управления и макет

Код js веб-страницы, фон частицы, код спецэффектов

【новый! Суперподробное】Полное руководство по свойствам компонентов Figma.

🎉Обязательно к прочтению новичкам: полное руководство по написанию мини-программ WeChat с использованием программного обеспечения Cursor.

[Забавный проект Docker] VoceChat — еще одно приложение для мгновенного чата (IM)! Может быть встроен в любую веб-страницу!

Как реализовать переход по странице в HTML (html переходит на указанную страницу)

Как решить проблему зависания и низкой скорости при установке зависимостей с помощью npm. Существуют ли доступные источники npm, которые могут решить эту проблему?

Серия From Zero to Fun: Uni-App WeChat Payment Practice WeChat авторизует вход в систему и украшает страницу заказа, создает интерфейс заказа и инициирует запрос заказа

Серия uni-app: uni.navigateЧтобы передать скачок значения

Апплет WeChat настраивает верхнюю панель навигации и адаптируется к различным моделям.

JS-время конвертации

Обеспечьте бесперебойную работу ChromeDriver 125: советы по решению проблемы chromedriver.exe не найдены

Поле комментария, щелчок мышью, специальные эффекты, js-код

Объект массива перемещения объекта JS

Как открыть разрешение на позиционирование апплета WeChat_Как использовать WeChat для определения местонахождения друзей

Я даю вам два набора из 18 простых в использовании фонов холста Power BI, так что вам больше не придется возиться с цветами!