Система слежения за целью мобильного робота на основе визуального отслеживания и автономной навигации

Автор: Чжан Жуй, Цзян Ванюэ

Источник: «Журнал инженерного проектирования»

Редактор: Восточное побережье, потому что @ немного искусственного интеллекта, немного

Ориентируясь на сценарий, в котором цель исчезает, когда мобильный робот следует за целью, предлагается система слежения за целью робота, основанная на визуальном отслеживании и автономной навигации. Проблема слежения за роботом делится на две ситуации: обычное следование, когда цель находится в поле зрения робота, и автономная навигация после исчезновения цели.

При обычном слежении состояние целевого движения прогнозируется с помощью фильтра Калмана, сеть повторной идентификации пешеходов используется для извлечения признаков внешнего вида, информация о движении и признаки внешнего вида объединяются посредством ассоциации данных, а затем цель отслеживается и затем следует за ней. посредством сервоуправления. Для автономной навигации, основанной на относительном положении цели и робота до ее исчезновения, используется алгоритм автономной навигации, который перемещает робота для поиска вблизи исчезающего положения цели, чтобы повысить вероятность успешного следования за целью.

Предложенный алгоритм будет оценен на общедоступном тестовом наборе OTB100 и следующем тестовом наборе в сценариях применения робота, а эксперименты будут проводиться на мобильной платформе робота. Результаты показывают, что робот может следовать за целью в различных условиях освещения и в различных средах. на фоне множества пешеходов. Надежность и эффективность предложенного алгоритма проверены, и он может соответствовать требованиям реального времени. Результаты исследования могут стать отправной точкой для исследования проблемы роботов, следующих за целью после ее исчезновения.

В последние годы все больше роботов участвует в производстве и жизни человека. Во многих сценариях роботам приходится следовать за целями в сложных условиях, например, за тележками для покупок, тележками для гольфа и т. д. [1-2].

В настоящее время существует множество сенсорных методов слежения за целью [3-4]. Целевое положение определяется с помощью лидара, камер и технологии UWB (сверхширокополосной связи), а алгоритм навигации и управления роботом разрабатывается на основе целевого положения. Например: Феррер и др. [5] использовали лидар для определения местоположения цели и использовали SFM (режим социальной силы, модель социальной силы) для количественной оценки намерений движения пешехода, позволяя роботу следовать за целевым пешеходом бок о бок; [6] получили пешеходов с помощью лазерного облака точек. Модель ног анализирует движения ног пешехода, чтобы определить положение целевого пешехода, но трудно отличить разных пешеходов на основе только данных облака точек, предложенных Лингом и др.; метод слежения за пешеходами путем обнаружения светоотражающих материалов.

Также было получено множество результатов исследований в области визуального слежения и визуального отслеживания целей.

Визуальное отслеживание исследования:Chengждать[8]Предлагается способ слежения за целевым пешеходом путем обнаружения верхней части тела и ног.;Sunждать[9]Был разработан подход, основанный на жестах.,робот может выполнять различные задачи на основе жестов; Койде и др. [10] предложили метод, который сочетает в себе характеристики роста и цвета для идентификации целевых пешеходов.,Однако на эту информацию о теле легко влияют поза и походка целевого пешехода.;余铎ждать[11]Комбинируя алгоритм быстрого распознавания масштабного пространства с Фильтр Алгоритм Калмана переключен для достижения стабильного следования. Ванцин и др. [12] использовали улучшенный Фильтр; Механизм Калмана для прогнозирования статуса цели и выполнения сопоставления целей посредством ассоциации данных с использованием многократного отслеживания. цели и выполните калибровку идентификатора (идентификационного номера) целевого человека.

Исследование визуального отслеживания целей:Henriquesждать[13-14]предложенныйCSK(Структура цикла для отслеживания обнаружения ядра)алгоритм,Плотная выборка изображений с использованием циркулянтных матриц,Повышенная точность отслеживания,Позже многофункциональные каналы были расширены.,Предложил алгоритм KCF (Kernel Correlation Filtering) Данелльян и др. [15] оптимизировали фильтрацию обнаружения перевода и масштабирования.,Предложил алгоритм FDSST (быстрое дискриминативное масштабное отслеживание пространства) Бертинетто и др. [16] применили двойную сеть для отслеживания;,Предложил алгоритм SiamFC (полностью сверточная двойная сеть) Ли и др. [17-18] добавили сеть-кандидат на основе алгоритма SiamFC;,предложенныйSiamRPN(Siamese region proposal network (сеть генерации регионов-близнецов-кандидатов), а позже предложил алгоритм SiamRPN++, который использует стратегию выборки с учетом пространства и использует глубокую сеть для извлечения признаков во время отслеживания целей. В вышеупомянутом исследовании учитываются характеристики внешнего вида людей, но когда на сцене присутствуют пешеходы с похожей внешностью, их трудно различить. Когда робот следует за целевым пешеходом, произойдет сбой в отслеживании.

В этой статье предлагается метод слежения за целью для мобильных роботов на основе камер глубины, который позволяет роботам следовать за социальными целями посредством визуального отслеживания и автономной навигации. Обычные алгоритмы отслеживания цели могут решить проблему закрытия цели только за короткий период времени, когда цель больше не появляется в поле зрения робота после поворота за угол коридора, роботу необходимо активно повернуть, чтобы измениться; поле зрения камеры. В этой статье проблема следования робота разделена на две ситуации: цель находится в поле зрения робота и цель исчезает.

Для первых метод обработки информации о движении на основе фильтрации Калмана сочетается с методом обработки информации о признаках внешнего вида на основе извлечения сети признаков для повышения точности распознавания цели, для вторых используется автономная навигация на основе взаимного положения объектов; цель к роботу, прежде чем она исчезнет. Заставьте робота переместиться для поиска рядом с исчезающим положением цели, чтобы повысить вероятность успешного следования за целью.

В этой статье используется общедоступный тестовый набор OTB100 и следующий тестовый набор в сценариях применения роботов для оценки эффекта визуального отслеживания, а также проводятся следующие эксперименты на платформе робота для проверки эффективности отслеживания роботом целевых пешеходов в средах с большим количеством пешеходов в помещении и на открытом воздухе.

01 Структура мобильного робота и следующая структура системы

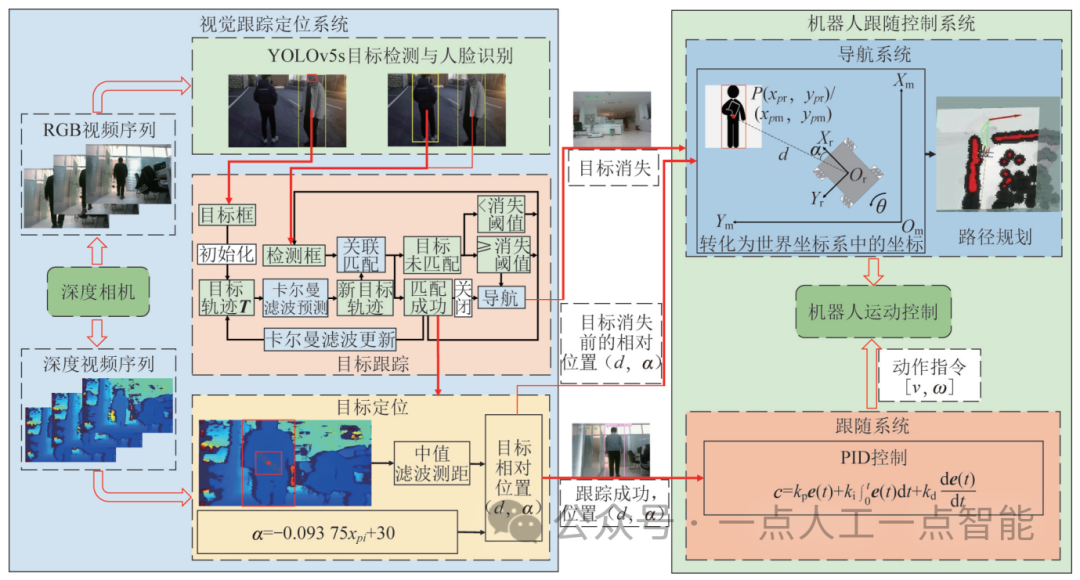

Мобильный робот отслеживание и позиционированиемодули и Робот следует за Состав модуля контроля, как показано на рисунке 1. Визуальное отслеживание и Модуль позиционирования получает RGB-видеопоследовательность и видеопоследовательность глубины, необходимую для следования робота через камеру глубины. Внешний хост — Визуальное. отслеживание и Процессор информации позиционирования используется для обработки видеопоследовательности, полученной камерой глубины, и определения взаимного положения цели и робота. Мобильная робот-платформа представляет собой ROS (робот), приводимый в движение колесами Mecanum. operating system, Операционная система робота) платформа, оснащенная Jetson TX1 управляет материнской платой, работающей на платформе, посредством алгоритмов управления.

Структура системы отслеживания целей мобильного робота показана на рисунке 2. Камера глубины получает видеопоследовательность RGB и видеопоследовательность глубины; цель обнаруживается в видеопоследовательности RGB посредством обнаружения цели и отслеживания цели. Видеопоследовательность глубины используется для определения относительного положения цели и камеры; отслеживание успешно, на основе относительного положения робота и цели, управляйте роботом, чтобы он следовал; если цель исчезает на долгое время в процессе визуального отслеживания, отслеживание считается неудавшимся. Запускается, и относительное положение до исчезновения цели преобразуется в координаты в мировой системе координат, и робот перемещается к точке, где цель исчезает. Активно находите местоположение. Этот метод может эффективно решить проблему исчезновения или блокировки цели в течение длительного времени в процессе визуального отслеживания, а также лучше справляться с ситуацией, когда цель поворачивается и исчезает в углу коридора или у двери во время следования робота. процесс.

02 Визуальное отслеживание и позиционирование

Визуальное отслеживание и позиционированиевключать Обнаружение и распознавание целей、отслеживание цели и таргетинг три части. первый,Получить кадры видео с камеры глубины.,Использование YOLOv5s для обнаружения пешеходов,В сочетании с распознаванием лиц, чтобы во-вторых определить, находится ли цель в поле зрения;,Инициализируйте алгоритм отслеживания,И извлеките статус движения и особенности внешнего вида цели.,Отслеживайте цель в последующих кадрах,И, наконец, найдите успешно сопровождаемую цель;,Выведите информацию об относительном положении цели и робота.

2.1 Обнаружение и распознавание целей

В эксперименте неудобно выбирать цель отслеживания вручную, поэтому распознавание лиц добавляется перед запуском алгоритма отслеживания, а распознавание лиц выполняется только на первом кадре или первых нескольких кадрах, как только цель обнаружена и входит в поле робота. зрения, цель отслеживается. В качестве детектора пешеходов используется уже обученная модель обнаружения YOLOv5s [19]. Модель быстро бегает, имеет высокую точность распознавания и хорошо обнаруживает целевых пешеходов. Алгоритм распознавания лиц использует библиотеку распознавания лиц face_recognition, точность которой составляет 99,38% в наборе данных о лицах в тесте Labeled Faces in the Wild [20].

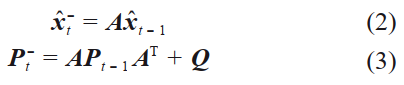

В первом кадре кадр распознавания лица и кадр обнаружения YOLOv5s являются IOU (пересечение over union,соотношение пересечения и объединения) соответствие,IOUКадр обнаружения с наименьшим расстоянием является целевым кадром.。IOUрасстояниеd_i^{(1)} Это может быть выражено как:

в формуле:\pmb{B}_{face}=[x_1\ y_1\ x_2\ y_2] ,\pmb{B}_{i}=[x_{i1}\ y_{i1}\ x_{i2}\ y_{i2}] ,其元素分别для人脸检测框и Нет.i Координаты верхнего левого угла и нижнего правого угла рамки обнаружения пешеходов в системе координат изображения.

2.2 Сопровождение цели

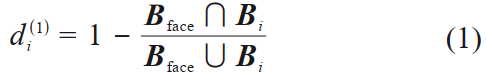

отслеживание Процесс постановки целей показан на рисунке 3. Когда цель появляется, на основании вышеизложенного Обнаружения. и распознавание целей Метод может получить целевой кадр;Извлечение характеристик изображения и информации о местоположении целевого кадра,Инициализируйте целевой кадр как целевую траекторию\pmb{T}=[x\ y\ r\ h\ s\ \pmb{F}] ,который содержит центральную позицию целевой ограничивающей рамки(x,y) 、Соотношение сторон целевой ограничивающей рамкиr 、высокийh , текущая траектория проходит через Фильтр Калманаколичество прогнозовs И библиотека функций внешнего вида цели.\pmb{F} ;В первомt Рамка от Фильтр Калмана Предиктор прогнозирует целевую позицию текущего кадра,и предсказать, сколько разs Добавьте 1, чтобы сравнить кадр пешехода, обнаруженный YOLOv5, с прогнозируемой траекторией. ассоциаций;Если цель успешно сопоставлена,Обновите библиотеку признаков внешнего вида целевой траектории.\pmb{F} 、Фильтр Калмана Параметры,И поставьте времена предсказания Калманаs Устанавливается в ноль, если целевое совпадение не удалось;,целевая траектория\pmb{T} Обновление не выполняется. Когда количество прогнозов превышает порог исчезновения, определяется, что цель исчезла в течение длительного времени, и выполняется автономная навигация. Когда кадр обнаружения и траектория цели снова успешно совпадают, автономная. навигация отключена.

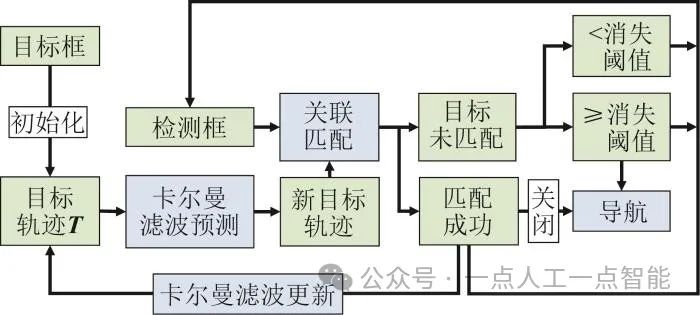

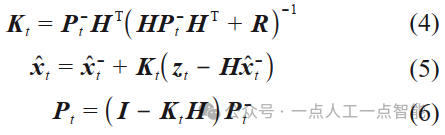

2.2.1 Фильтр Калмана

В этой статье используется стандартная модель Фильтра с постоянной скоростью. Калманаустройство,Предположим, что скорость движения пешехода постоянна.。Отслеживание переменных состояния сцены в восьми измеренияхx_t=[x\ y\ r\ h\ \dot{x}\ \dot{y}\ \dot{r}\ \dot{h}]^T определение выше,Эта переменная содержит 4 переменные состояния положения цели и скорости их изменения в соответствующих системах координат изображения.,где состояние ограничивающей рамкиz_t=[x\ y\ r\ h]^T как прямое наблюдение целевого состояния.

Прогноз статуса:

Обновление статуса:

в формуле:\pmb{I} для8×8матрица идентификации типа;\hat{x}^-_t 、\hat{x}_{t-1} 分别дляt время的状态预测值иt-1 Оптимальная оценка состояния на данный момент,\pmb{P}^-_t 、\pmb{P}_{t-1} 分别дляt время的先验估计协方差矩阵иt-1 Ковариационная матрица апостериорной оценки времени,\pmb{A} для8×8матрица перехода состояний типа,\pmb{Q} для8×8тип матрица шума процесса,\pmb{R} для4×4Тип Измерение Шумовая матрица,\pmb{H} для4×8матрица наблюдения за состоянием типа,\pmb{K}_t Выигрыш для Кальмана.

2.2.2 Сопоставление ассоциаций

Модуль корреляционного согласования решает проблему корреляции между целевой траекторией, предсказанной Калманом, и объемом обнаружения нового кадра. Интегрируйте информацию о внешнем виде и информацию о движении через косинусное расстояние и расстояние Махаланобиса.

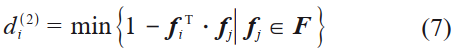

Для информации о внешнем виде,用余弦расстояние来度量。Используйте обученную сеть извлечения признаков, чтобы извлечьi Особенности внешнего вида отдельных рамок обнаружения пешеходовf_i 以及целевая траектория的外观特征库F=[f_1\ f_2\ …\ f_{100}] 。Нет.i 个检测框与целевая траектория的最小余弦расстояниеd_i^{(2)} для:

в формуле:f_i^T·f_j для Нет.i 个检测框特征与целевая траектория Нет.j косинусное сходство признаков。d_i^{(2)} Чем меньше значение, тем выше сходство внешних признаков между ними.

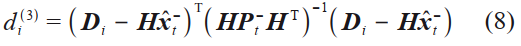

Когда есть похожие пешеходы,Точное различие невозможно провести только на основе косинусного расстояния, что приводит к дрейфу отслеживания.,Поэтому для измерения необходимо использовать информацию о движении. Объединение информации о движении,采用预测的卡尔曼状态与新一帧检测量之间的马氏расстояниеd_i^{(3)} :

в формуле:\pmb{D}_i для Нет.i вектор состояния блока обнаружения,\pmb{H}\hat{\pmb{x}}^-_t для由卡尔曼预测状态向量映射的4×1наблюдаемый вектор состояния,\pmb{HP}^-_t\pmb{H}^T представляет собой отображенную ковариационную матрицу 4×4.

d_i^{(3)} Чем меньше значение, тем выше сходство между кадром обнаружения и траекторией цели. Расстояние Махаланобиса является подходящей метрикой корреляции, когда неопределенность состояния движения низкая, но в пространстве изображений прогнозируемое состояние, полученное с помощью системы фильтрации Калмана, дает только приблизительную оценку целевого положения. В частности, когда цель перекрыта другими пешеходами или происходит дрожание камеры, плоскость изображения будет перемещаться быстро, что делает расстояние Махаланобиса неизвестным показателем.

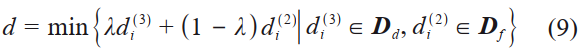

Эти два показателя могут по-разному дополнять друг друга. с одной стороны,Расстояние Махаланобиса предоставляет информацию о положении цели на основе движения.,С другой стороны, помогает в краткосрочном прогнозировании;,Косинусное расстояние учитывает информацию о внешнем виде,Эта информация не является различительной для информации о движении после того, как цель закрыта или камера трясется.,Но это помогает отслеживать цели восстановления.。Установить вес\lambda Взвесьте эти 2 меры,Получите оптимальное значение корреляцииd:

в формуле:\pmb{D}_d=[d_1^{(3)}\ d_2^{(3)}\ …\ d_m^{(3)}] ,\pmb{D}_f=[d_1^{(2)}\ d_2^{(2)}\ …\ d_m^{(2)}] ,分别для当前m Коллекция расстояний между кадрами обнаружения, а также информация о движении и внешнем виде траектории цели.

Чтобы избежать перекрытия цели и возникновения ошибок ассоциации,Добавить порог\delta измерить значение корреляцииd это приемлемо?。нравитьсяd\leq \delta , объединение считается успешным.

После того, как траектория цели и рамка обнаружения успешно согласованы,,须对целевая траектория的外观特征库\pmb{F} Сделать обновление。Воля匹配成功的检测框的外观特征替换掉与其外观特征相似度最高的целевая траектория的特征\pmb{f}_j 。

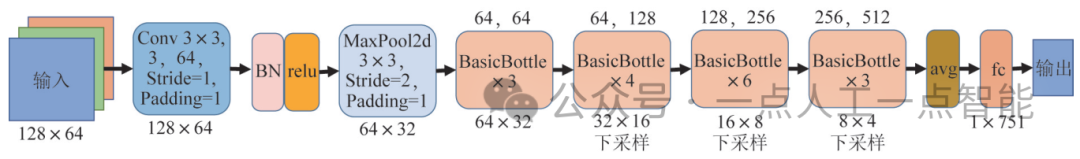

Характеристики внешнего вида извлекаются с помощью остаточной сети ResNet, структура которой показана на рисунке 4. Размер входной модели составляет 128×64×3. После свертки с шагом 1,64 ядра свертки 3×3 и максимальным объединением получается выход 64×32×64, который затем проходит через 16 обычных остаточных блоков. После свертки получаются выходные данные 8×4×512, и классификация полносвязных слоев выполняется после адаптивного среднего пула. В методе целевого отслеживания классификация полносвязных слоев не требуется при использовании этой сети извлечения признаков. После адаптивного объединения средних данные нормализуются для получения 512-мерных признаков, а затем вычисляется косинусное расстояние. Сеть обучена на наборе данных переидентификации личности Market-1501. Набор данных включает 1502 пешехода и 32668 обнаруженных пешеходных прямоугольников, снятых 6 камерами. В процессе обучения для снижения скорости обучения используется метод косинусного отжига. Точность (точность топ-1) категории с наибольшей вероятностью классификации в наборе проверки составляет 89,348%.

2.3 Целевое позиционирование

Чтобы выполнить задачу следования за пешеходами, робот должен знать информацию о местоположении цели. По результатам обнаружения отслеживания относительное расстояние между роботом и целью рассчитывается через координаты центральной точки прямоугольной рамки цели. Чтобы уменьшить объем вычислений, поле поиска определяется на основе положения центрального пикселя, затем из поля поиска выбираются 40 точек поиска для ранжирования, а эффективные значения точек поиска фильтруются по медианное среднее значение для получения расстояния до цели.

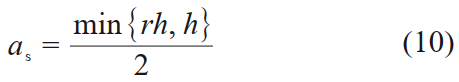

Оптимальный вектор состояния согласно цели,Определите длину стороны окна поискаa_s для:

则搜索框状态向量для[x\ y\ a_s\ a_s] ,搜索点дляP_s(x+\varepsilon,x+\varepsilon) ,в\varepsilon для偏差,\varepsilon\in [-\frac{a_s}{2},\frac{a_s}{2}] 。

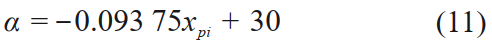

Это видно при тестировании,Угол обзора камеры глубины составляет примерно 60°.,Разрешение изображения (640×480) пикселей. Установите прямой фронт робота на 0°.,Левая сторона представляет собой отрицательный угол.,Правая сторона – положительный угол. Линейное сопоставление поля зрения камеры с размером изображения,можно рассчитатьробототносительный угол к цели。настраиватьx_{pi} для目标中心的横坐标,Тогда относительный уголa для:

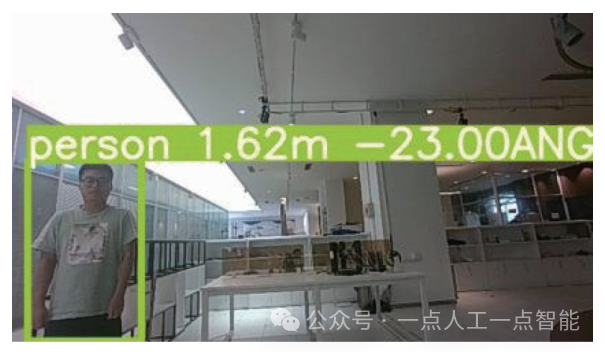

Расстояние до цели и угол, измеренные камерой глубины, показаны на рисунке 5.

03 Робот следует за контролем

Робот следует за система контроля доступна с Jetson Материнская плата управления TX1 работает на платформе ROS. Получить визуальное через локальную сеть отслеживание и Система позиционирования передает относительное расстояние и относительный угол между системой дисиционирования и целью, а также биты флага, указывающие, исчезла ли цель на длительное время. В зависимости от того, исчезнет ли цель на долгое время, Регулярное отслеживаниеиавтономная навигация две обработки.

3.1 Регулярное наблюдение

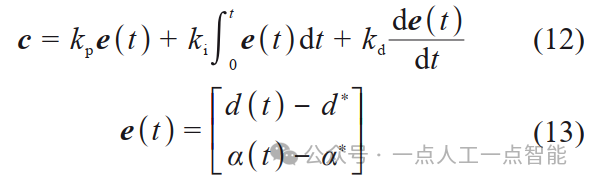

прежде чем цель исчезнет или будет скрыта на долгое время,в соответствии сробот与目标的相对расстояниеd(t) 、относительный угол\alpha(t) ,Использование ПИД (пропорционально-интегрально-производной,Пропорция‒интеграл‒дифференциал)控制устройство求解роботлинейная скоростьv и угловая скорость\omega ,делатьc=[v,\omega]^T 。

в формуле:k_p、k_i、k_d дляPIDпараметры управления;e(t) дляtвремяробот Ошибка от желаемой целевой позиции;d^* для期望的跟随расстояние,d^*=1\ m ;\alpha^* для期望的跟随角度,\alpha^*=0^° 。

3.2 Автономная навигация

Когда цель исчезает, позиция до исчезновения цели сохраняется, и робот перестает двигаться и ждет появления цели. Когда цель пропадет на 30 кадров и будет определено, что цель исчезла надолго, запустится автономная навигация и робот начнет активный поиск цели. При планировании пути используется алгоритм A*.

3.2.1 Преобразование координат

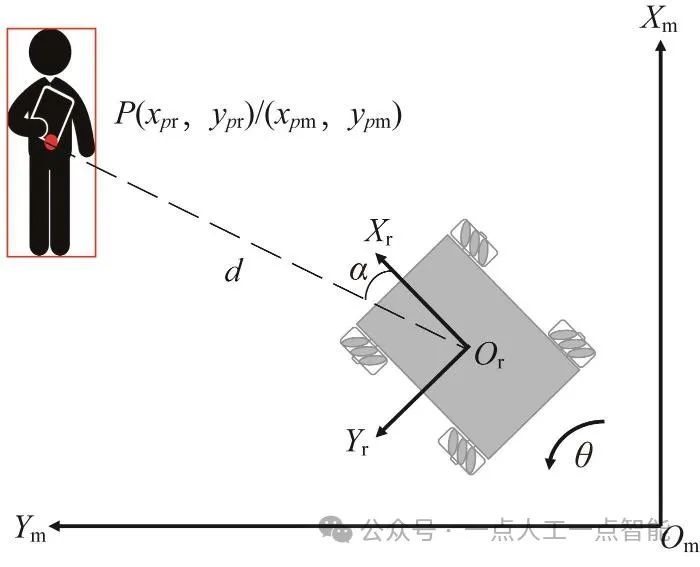

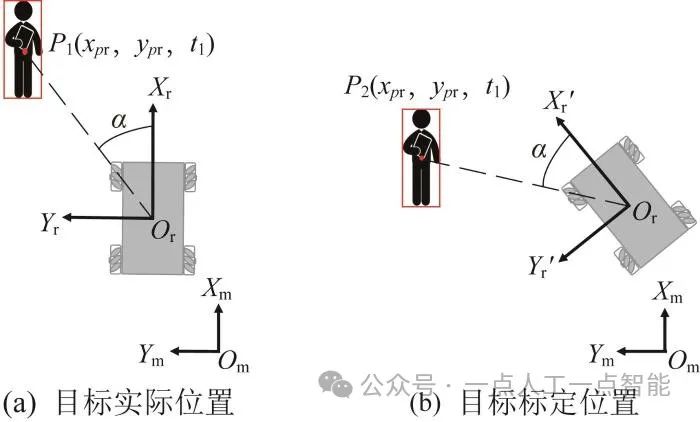

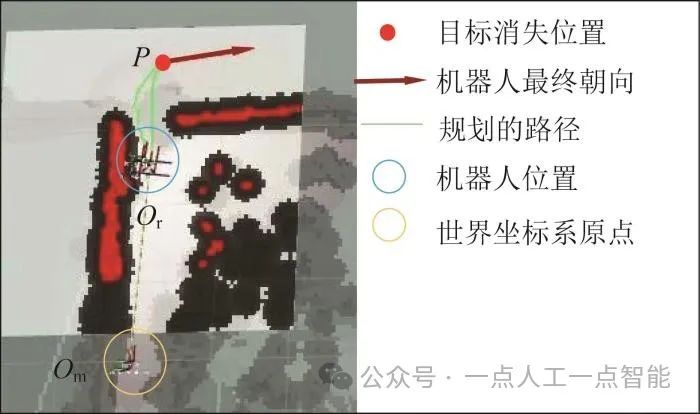

Целевая позиция, указанная в разделе 2.3, представляет собой относительное положение робота и цели, которое должно быть преобразовано в координаты в мировой системе координат, когда робот перемещается автономно. Если рассматривать систему координат камеры как систему координат робота, преобразование между системой координат робота и мировой системой координат показано на рисунке 6.

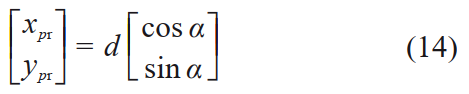

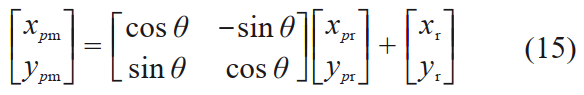

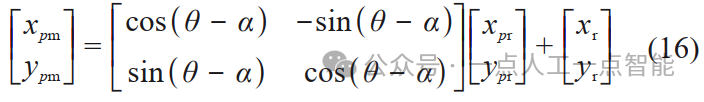

世界坐标系дляX_mO_mY_m ,робот坐标系дляX_rO_rY_r ,робот坐标系与世界坐标系的偏转角для\theta 。робот在世界坐标系中的坐标дляO_r(x_r,y_r) ,Цель наробот坐标系中的坐标дляP(x_{pr},y_{pr}) ,Прямо сейчас:

Тогда координаты цели в мировой системе координат будут:

3.2.2 Ориентация робота

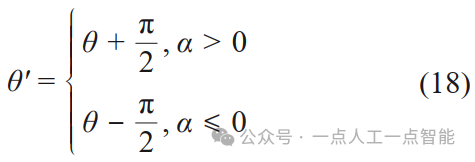

Направление робота при его движении к целевой позиции определяется исходя из того, исчезает ли цель перед левой или правой частью робота. Например, если цель исчезает перед левой стороной робота, то окончательной ориентацией робота будет поворот на 90° влево.

Во время фактической эксплуатации,Когда камера обнаруживает последний кадр перед исчезновением цели,Из-за гистерезиса движения робота,Робот будет вращаться в зависимости от положения, обнаруженного до исчезновения цели.,Это приводит к отклонению таргетинга,нравиться Рисунок 7показано。目标消失位置дляP_1 ,робот坐标系дляX_rO_rY_r 。роботв соответствии с目标位置转动,в это времяробот坐标系дляX_r'O_rY_r' 。нравитьсяв соответствии с Когда цель исчезает的相对расстояние以及относительный угол,Цель будет расположена в мировых координатах.P_2 . Если целевая позиция расположена относительно препятствия, планирование пути не удастся, поэтому необходимо компенсировать угол мировых координат, когда цель исчезает.

По формуле (15) можно получить:

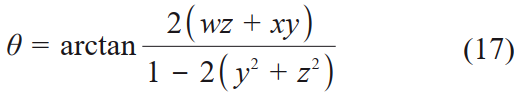

Когда цель исчезаетробот Ориентация может пройтироботопубликованоOdomкватернион(x,y,z,w) Находить:

Окончательная ориентация робота может означать:

финальный,Воля得到的欧拉角转换для四元数(x,y,z,w) выпускать。因дляробот Только рыскание,Никакой качки и переворачивания не требуется,Так что просто спросиz иw :

04 Цель мобильного робота после эксперимента

Мобильный робот Визуальное отслеживание и Система позиционирования оснащена RTX2060. GPU-хост и Realsense Камера глубины D435, в которой используется CUDA (компьютерный unified device Версия архитектуры (Computer Unified Device Architecture) — 11.6, разрешение камеры глубины — (640×480) пикселей, а алгоритм отслеживания и позиционирования цели работает со скоростью 30 кадров/с, что может соответствовать требованиям реального времени. Робот оснащен Jetson TX1 управляет основной платой и четырьмя колесами Mecanum, которые управляются через операционную систему ROS, со средней скоростью движения 0,8. m/s。

4.1 Эксперимент по отслеживанию цели

Сначала он тестируется и оценивается на общедоступном тестовом наборе OTB100. Поскольку предложенный в этой статье алгоритм отслеживания подходит для отслеживания пешеходов, была выбрана последовательность пешеходов на тестовом наборе OTB100.

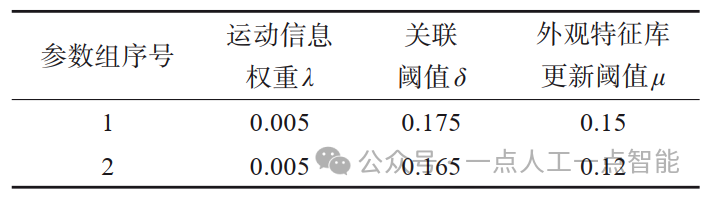

Параметры этого алгоритма выбраны в качестве группы параметров 1 в таблице 1. Когда оптимальное значение корреляции меньше 0,175,Подтвердите, что целевая ассоциация прошла успешно,затем обновите Фильтр Калманаустройство И библиотека функций внешнего вида цели.\pmb{F} 。当成功关联的检测框的外观特征余弦расстояние小于0.15,затем обновите его в базе данных объектов\pmb{F} середина. Невозможно достичь целевых потерь после автономной работы из-за оценки на тестовом наборе навигация,Поэтому, когда цель теряет 30 кадров,Воля\lambda Установите на 0.

Для оценки алгоритма используются два показателя производительности: точность и вероятность успеха. Точность — это процент от общего количества кадров, в которых расстояние между центральной точкой целевой ограничивающей рамки и центральной точкой реальной рамки, выводимой алгоритмом, меньше заданного порога. Нарисуйте кривые точности при различных порогах центральной ошибки и используйте точность, соответствующую порогу в 20 пикселей, в качестве репрезентативного индекса оценки. Вероятность успеха — это процент кадров, в которых соотношение площадей перекрытия целевой ограничивающей рамки и реального кадра превышает заданное пороговое значение. Диапазон его значений составляет 0–1, поэтому пороговое значение степени перекрытия, когда пороговое значение степени перекрытия составляет от. Можно построить кривую успеха от 0 до 1.

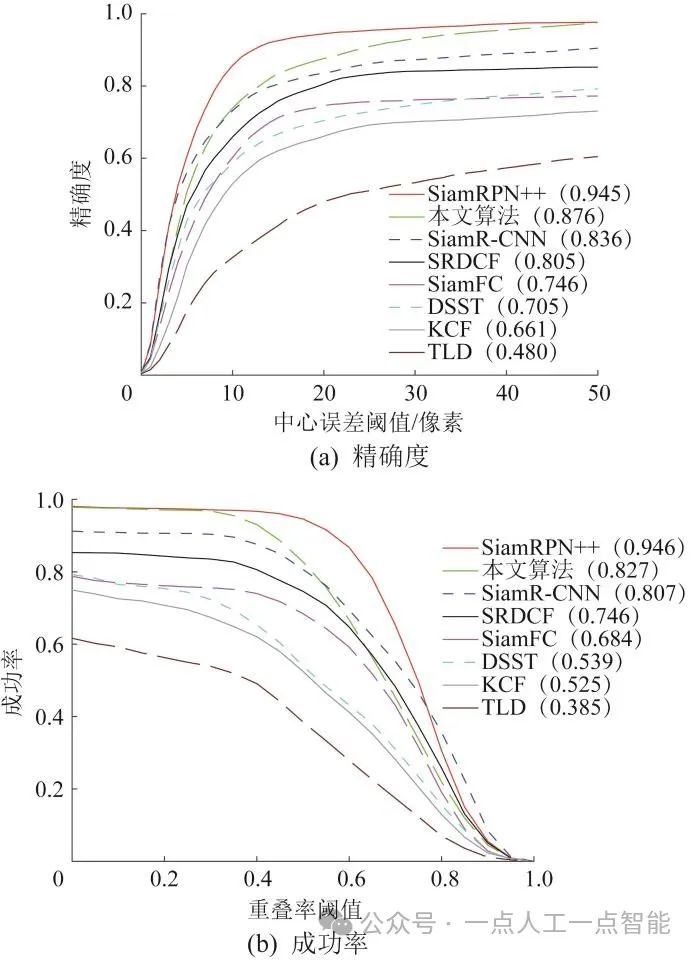

Набор данных OTB100 используется для сравнения алгоритма в этой статье с KCF[14], SiamFC[16], SiamR-CNN (сиамский re-detection convolutional neural сеть, сверточная нейронная сеть с повторным обнаружением двойников) [21], TLD (отслеживание-обнаружение-обнаружение, отслеживание обнаружения обучения) [22], DSST (дискриминативное обнаружение обучения) [22]. scale space трекер, дискриминационное масштабное космическое отслеживание) [23], SRDCF (пространственно regularized discriminative correlation фильтры, пространственная регуляризованная дискриминантная корреляционная фильтрация) [24] и другие семь алгоритмов сравнивались, результаты показаны на рисунке 8. Как видно из рисунка, при тестировании на наборе данных OTB100 производительность этого алгоритма несколько хуже, чем у алгоритма SiamRPN++. Это связано с комбинацией Фильтра. Калмана Быстрое движение конечностей целевого пешехода не окажет быстрого влияния на положение рамки слежения.,Рамка слежения в основном фокусируется на туловище человеческого тела.,В результате соотношение площадей перекрытия целевого кадра и точного кадра некоторых видео недостаточно велико. поэтому,Когда порог скорости перекрытия составляет 0,4 ~ 0,8,Процент успеха быстро падает. в то же время,Этот алгоритм значительно лучше, чем другие 6 алгоритмов.,Возможность быстрого обнаружения пешеходов и определения целей,Улучшенная возможность повторной идентификации после закрытия цели.。\lambda ,Может эффективно справляться с сильными дрожаниями камеры. Для целей, которые будут закрыты,Особенно когда цель совпадает с другими пешеходами,можно уменьшить, уменьшив\delta и\mu решить.

В оценочном наборе OTB100 большинство тестовых последовательностей выполняются с точки зрения наблюдения, и отсутствует одновременное движение камер и пешеходов на близком расстоянии. Чтобы дополнительно оценить эффективность отслеживания этого алгоритма, автор собрал 2 потока данных в разных условиях окружающей среды. В темной среде освещение меняется и цель блокируется, в яркой среде фон сложный, много похожих пешеходов и много факторов помех; В собранном потоке данных разрешение изображения составляет (1 280 × 720) пикселей. Алгоритм в этой статье используется для отслеживания целей в потоке данных, результаты показаны на рисунке 9. Как видно из рисунка, цель может быть обнаружена и позиционирована с помощью предложенного в данной статье алгоритма при различных условиях освещенности.

Из результатов тестирования двух вышеупомянутых потоков данных видно, что алгоритм в этой статье имеет лучшую производительность при отслеживании пешеходов. В основном это связано со следующими двумя аспектами: во-первых, детектор на основе YOLOv5 может точно обнаруживать людей в сложных условиях, во-вторых, когда цель исчезает, благодаря механизму отслеживания цели алгоритма робот может точно повторно идентифицировать; цель. Информация о движении, предсказанная на основе фильтра Калмана, объединяется с функциями внешнего вида, основанными на повторной идентификации пешеходов в сети ResNet, для повторной идентификации цели, что повышает точность повторной идентификации и стабильность отслеживания цели.

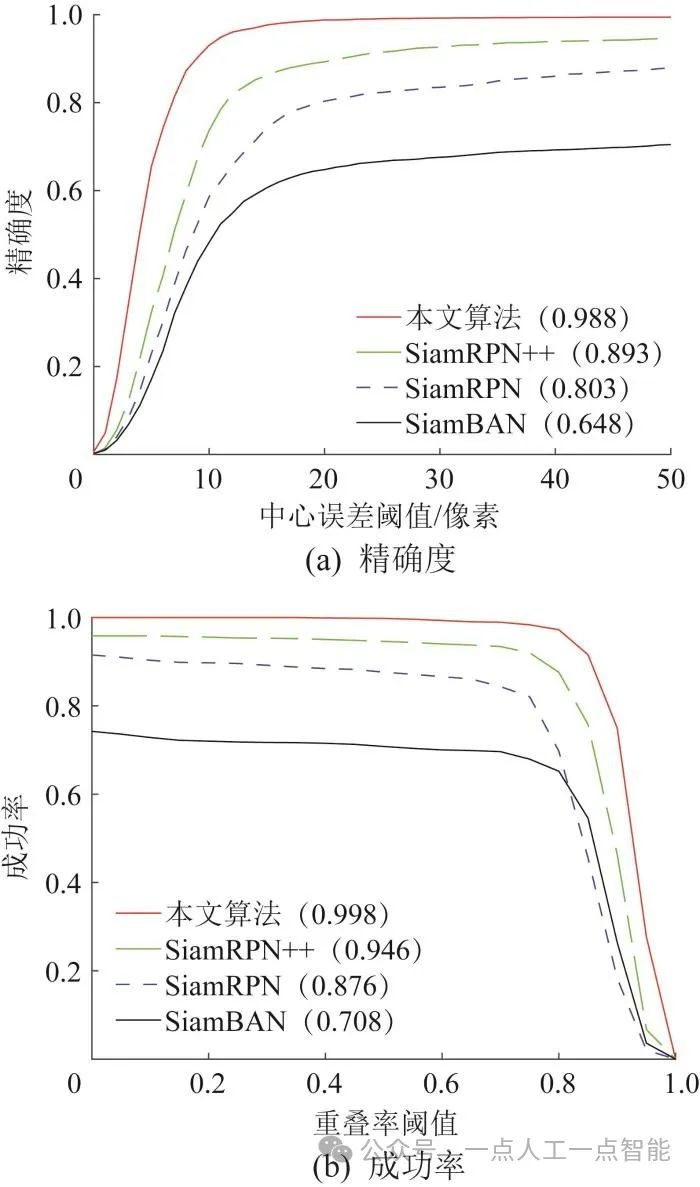

Кроме того, чтобы дополнительно проверить преимущества этого алгоритма, параметры этого алгоритма выбраны в качестве группы параметров 2 в таблице 1, а собранный поток данных используется для сравнения этого алгоритма с SiamRPN[17], SiamRPN++[18] и SiamBAN (сиамская блочная адаптивная сеть, Twin Adaptive Box Network) [25] и другие три алгоритма были сравнены и протестированы, и результаты показаны на рисунке 10. Для потока данных, используемого для сравнительных экспериментов, ограничивающая рамка целевого пешехода в каждом кадре была вручную отмечена инструментом аннотаций Labelimg, чтобы получить основную информацию. По двум показателям алгоритм в этой статье явно лучше других алгоритмов. Когда в сцене присутствуют похожие пешеходы, другим методам сложно отследить цель среди множества похожих пешеходов только по признакам внешнего вида. Алгоритм в этой статье добавляет информацию о движении, которая может эффективно решить проблему переключения целей после появления похожих на вид пешеходов. В целом алгоритм в этой статье лучше адаптируется к сложным средам и имеет более высокую точность повторной идентификации цели.

4.2 Цель робота после эксперимента

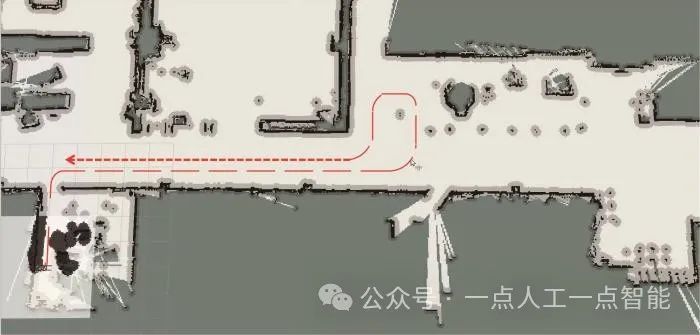

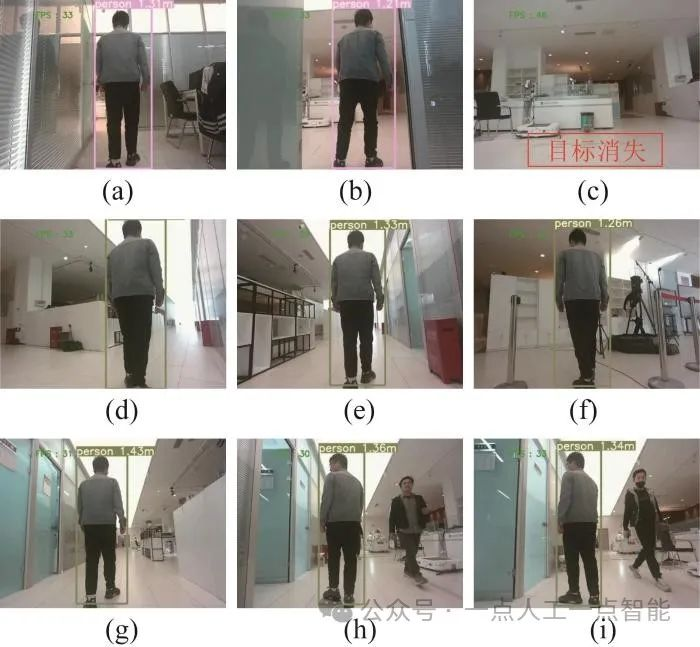

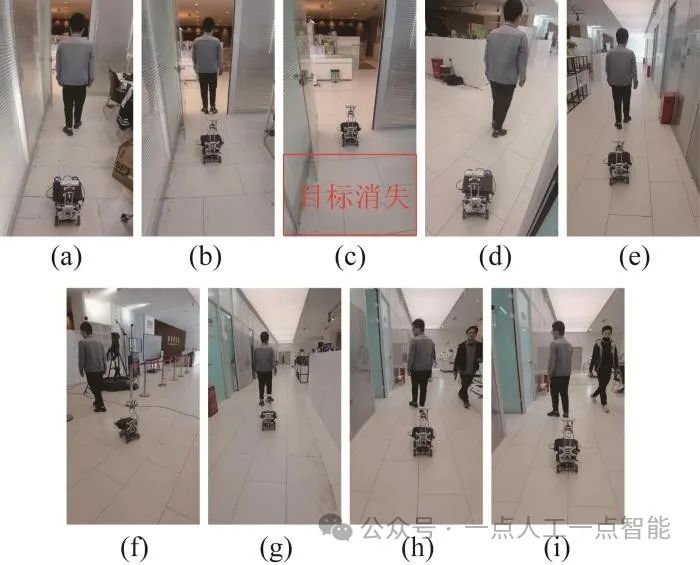

Чтобы оценить эффективность этого алгоритма на реальной роботизированной платформе, в помещении был проведен эксперимент по отслеживанию цели. В качестве датчика восприятия на платформе робота установлена камера глубины. Установленный целевой маршрут ходьбы показан на рисунке 11, следующий эффект с точки зрения камеры робота показан на рисунке 12, а следующий эффект мобильного робота показан на рисунке 13. В частности, когда цель исчезает, механизм автономной навигации робота активируется, чтобы найти цель и продолжить следовать за ней, как показано на рисунке 14.

После того, как цель исчезает на длительное время, робот ищет цель самостоятельно, как показано на рисунке 12(в) и рисунке 13(в). Когда цель снова появится в поле зрения робота, он все равно сможет отслеживать цель и следовать за ней. Во время следующего процесса робот всегда может стабильно следовать за целью, а средняя скорость обработки изображений превышает 30 кадров/с. Эксперименты показывают, что с помощью этого алгоритма можно добиться стабильного отслеживания целей в реальном времени.

Как видно из рисунка 14, после исчезновения цели робот может точно определить положение и ориентацию при исчезновении цели, что может эффективно решить проблему слежения за целью после ее исчезновения.

05 в заключение

В данной статье предлагается метод слежения за целью на основе визуальных датчиков. YoloV5s используется для обнаружения всех пешеходов, а целевое местоположение определяется с помощью модуля распознавания лиц. Сеть извлечения признаков используется для извлечения целевых признаков, создается библиотека объектов, фильтр Калмана используется для прогнозирования информации о движении цели, а цель отслеживается путем объединения информации о движении и признаков внешнего вида.

Кроме того, когда робот в течение длительного времени не может захватить цель, он использует автономную навигацию для перемещения к месту, где цель исчезает, для ее поиска. Алгоритм в этой статье сравнивался с другими алгоритмами в наборе данных OTB100 и собранном тестовом наборе, а эксперименты проводились на роботизированной платформе. Результаты показывают, что алгоритм в этой статье может решить проблему исчезновения или блокировки цели на длительное время, а также может точно и стабильно следовать за целью, обеспечивая при этом производительность в реальном времени.

В будущем мы будем продолжать изучать проблему уклонения роботов от препятствий во время следования за целью, чтобы роботы могли справляться с более сложными условиями. Кроме того, несколько датчиков объединены с камерами для дальнейшего повышения надежности метода.

Углубленный анализ переполнения памяти CUDA: OutOfMemoryError: CUDA не хватает памяти. Попыталась выделить 3,21 Ги Б (GPU 0; всего 8,00 Ги Б).

[Решено] ошибка установки conda. Среда решения: не удалось выполнить первоначальное зависание. Повторная попытка с помощью файла (графическое руководство).

Прочитайте нейросетевую модель Трансформера в одной статье

.ART Теплые зимние предложения уже открыты

Сравнительная таблица описания кодов ошибок Amap

Уведомление о последних правилах Points Mall в декабре 2022 года.

Даже новички могут быстро приступить к работе с легким сервером приложений.

Взгляд на RSAC 2024|Защита конфиденциальности в эпоху больших моделей

Вы используете ИИ каждый день и до сих пор не знаете, как ИИ дает обратную связь? Одна статья для понимания реализации в коде Python общих функций потерь генеративных моделей + анализ принципов расчета.

Используйте (внутренний) почтовый ящик для образовательных учреждений, чтобы использовать Microsoft Family Bucket (1T дискового пространства на одном диске и версию Office 365 для образовательных учреждений)

Руководство по началу работы с оперативным проектом (7) Практическое сочетание оперативного письма — оперативного письма на основе интеллектуальной системы вопросов и ответов службы поддержки клиентов

[docker] Версия сервера «Чтение 3» — создайте свою собственную программу чтения веб-текста

Обзор Cloud-init и этапы создания в рамках PVE

Корпоративные пользователи используют пакет регистрационных ресурсов для регистрации ICP для веб-сайта и активации оплаты WeChat H5 (с кодом платежного узла версии API V3)

Подробное объяснение таких показателей производительности с высоким уровнем параллелизма, как QPS, TPS, RT и пропускная способность.

Удачи в конкурсе Python Essay Challenge, станьте первым, кто испытает новую функцию сообщества [Запускать блоки кода онлайн] и выиграйте множество изысканных подарков!

[Техническая посадка травы] Кровавая рвота и отделка позволяют вам необычным образом ощипывать гусиные перья! Не распространяйте информацию! ! !

[Официальное ограниченное по времени мероприятие] Сейчас ноябрь, напишите и получите приз

Прочтите это в одной статье: Учебник для няни по созданию сервера Huanshou Parlu на базе CVM-сервера.

Cloud Native | Что такое CRD (настраиваемые определения ресурсов) в K8s?

Как использовать Cloudflare CDN для настройки узла (CF самостоятельно выбирает IP) Гонконг, Китай/Азия узел/сводка и рекомендации внутреннего высокоскоростного IP-сегмента

Дополнительные правила вознаграждения амбассадоров акции в марте 2023 г.

Можно ли открыть частный сервер Phantom Beast Palu одним щелчком мыши? Супер простой урок для начинающих! (Прилагается метод обновления сервера)

[Играйте с Phantom Beast Palu] Обновите игровой сервер Phantom Beast Pallu одним щелчком мыши

Maotouhu делится: последний доступный внутри страны адрес склада исходного образа Docker 2024 года (обновлено 1 декабря)

Кодирование Base64 в MultipartFile

5 точек расширения SpringBoot, супер практично!

Глубокое понимание сопоставления индексов Elasticsearch.