Развертывание и запуск большой модели Meta Llama3 на Mac

Не так давно Мета Официально выпущена последняя версия большой модели с открытым исходным кодом Llama3 , является самой мощной на сегодняшний день крупной моделью с открытым исходным кодом.

Llama3 Предусмотрены две версии 8B и 70B , если ты не понимаешь B что это значит,Ссылка здесь:# Некоторые базовые сведения о больших моделях

Среди них 8Б Версия, подходящая для потребительского уровня GPU Высокоэффективная разработка развертывания 70B; версия, предназначенная для крупномасштабного AI Дизайн приложения. Каждая версия включает в себя две формы: базовую и инструкцию по настройке.

Генеральный директор Meta Цукерберг объявил: Основанный на последней модели Llama 3, AI-помощник Meta теперь поддерживает все приложения, такие как Instagram, WhatsApp и Facebook.

Другими словами, Llama3 запущена в производственную среду и доступна.

Адрес с открытым исходным кодом Llama3 выглядит следующим образом:

https://github.com/meta-llama/llama3

Возможно, вам удастся запустить Llama3, следуя инструкциям по установке в документации с открытым исходным кодом, но обычным людям это не подходит. Есть более простой способ.

Я должен представить это здесь Ollama , то есть маленькая альпака внизу.

Ollama основан на Go развитие языкаиз Простой и удобный в использованииизЛокальная платформа запуска модели большого языка。

Может быть очень удобно развертывать различные модели локально и использовать их через интерфейс, который чем-то похож на Docker, загружающий различные контейнеры образов. И по мере постепенного улучшения экосистемы Олламы будет поддерживаться больше моделей, и в будущем будет удобнее запускать различные большие модели на собственном компьютере.

На самом деле, до Ollama были некоторые решения для локального развертывания больших моделей, но результаты запуска зачастую были неудовлетворительными, например LocalAI и т. д. Кроме того, требовалась Windows + GPU, в отличие от Ollama, которую можно запускать непосредственно на Mac. , например «Мой компьютер — Mac Studio».

Официальный адрес Олламы: https://ollama.com/

Нажмите «Загрузить» и выберите соответствующую платформу для загрузки. Вы также можете загрузить ее по адресу Ollama на Github:

https://github.com/ollama/ollama

Вы можете увидеть модели, которые в настоящее время поддерживаются Ollama, на домашней странице Github.

Model | Parameters | Size | Download |

|---|---|---|---|

Llama 3 | 8B | 4.7GB | ollama run llama3 |

Llama 3 | 70B | 40GB | ollama run llama3:70b |

Mistral | 7B | 4.1GB | ollama run mistral |

Dolphin Phi | 2.7B | 1.6GB | ollama run dolphin-phi |

Phi-2 | 2.7B | 1.7GB | ollama run phi |

Neural Chat | 7B | 4.1GB | ollama run neural-chat |

Starling | 7B | 4.1GB | ollama run starling-lm |

Code Llama | 7B | 3.8GB | ollama run codellama |

Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

Orca Mini | 3B | 1.9GB | ollama run orca-mini |

LLaVA | 7B | 4.5GB | ollama run llava |

Gemma | 2B | 1.4GB | ollama run gemma:2b |

Gemma | 7B | 4.8GB | ollama run gemma:7b |

Solar | 10.7B | 6.1GB | ollama run solar |

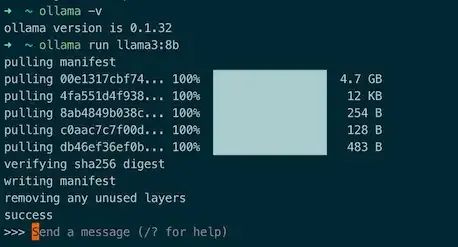

Первый — использовать Llama3. Просто запустите его с помощью следующей команды:

ollama run llama3:8b

Эффект такой, как показано на рисунке:

На этом этапе вы можете счастливо общаться на интимной основе.

Компания Huawei вступила во второй этап и готова спешить!

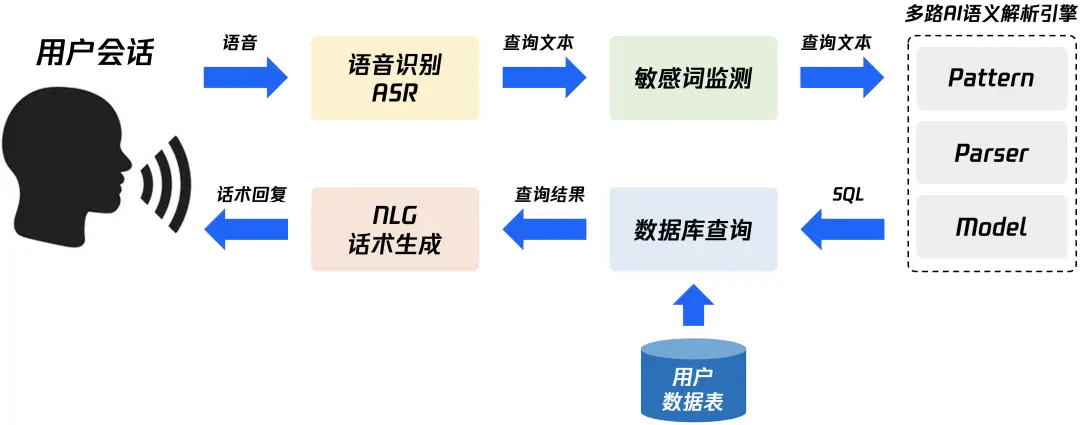

Быстро изучите в одной статье — концепцию и технологию реализации NL2SQL для передачи данных с нулевыми затратами.

Как использовать SpringBoot для интеграции EasyExcel 3.x для реализации элегантных функций импорта и экспорта Excel?

Почему транзакция не вступает в силу, когда @Transactional добавляется в частный метод?

Знание создания образов Docker: подробное объяснение команды Dockerfile.

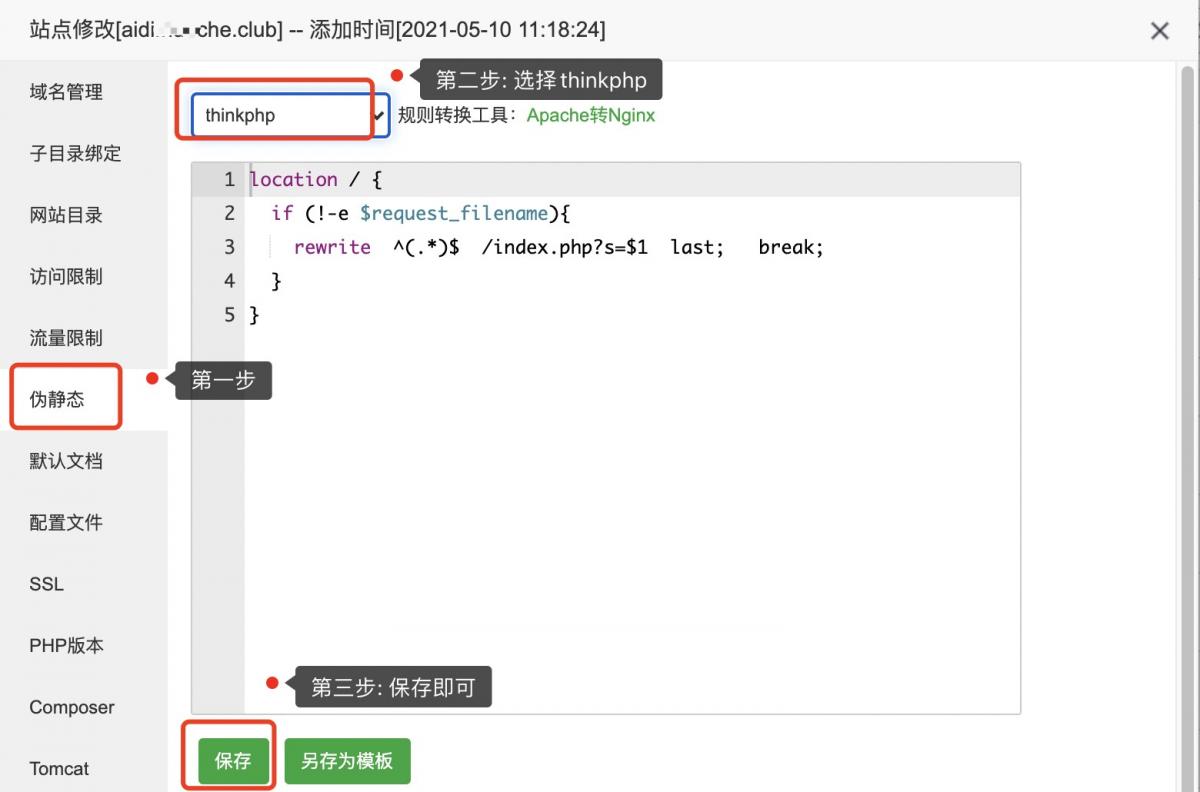

Псевдостатическая конфигурация ThinkPHP

Код изображения для загрузки апплета WeChat: последний доступный (код серверной части + код внешнего интерфейса)

Используйте растровое изображение Redis для реализации эффективной функции статистики регистрации пользователей.

[Nginx29] Обучение Nginx: буфер прокси-модуля (3) и обработка файлов cookie

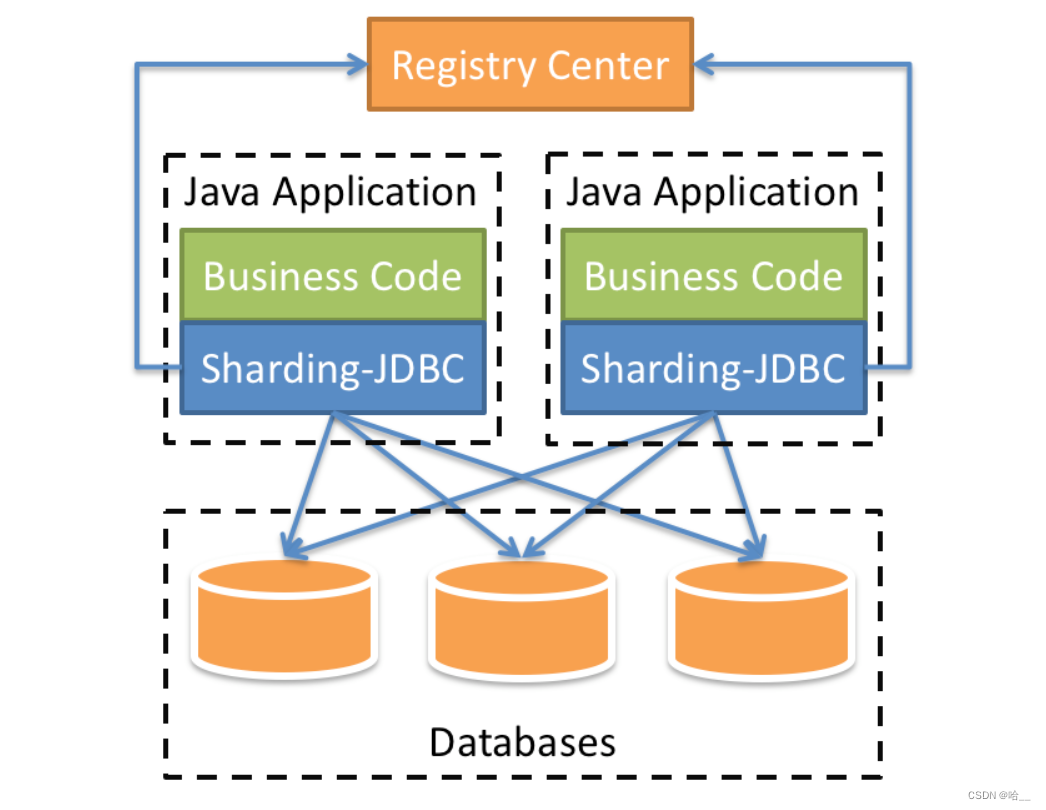

[Весна] SpringBoot интегрирует ShardingSphere и реализует многопоточную вставку 10 000 фрагментов данных в пакетном режиме (выполнение операций с базой данных и таблицами).

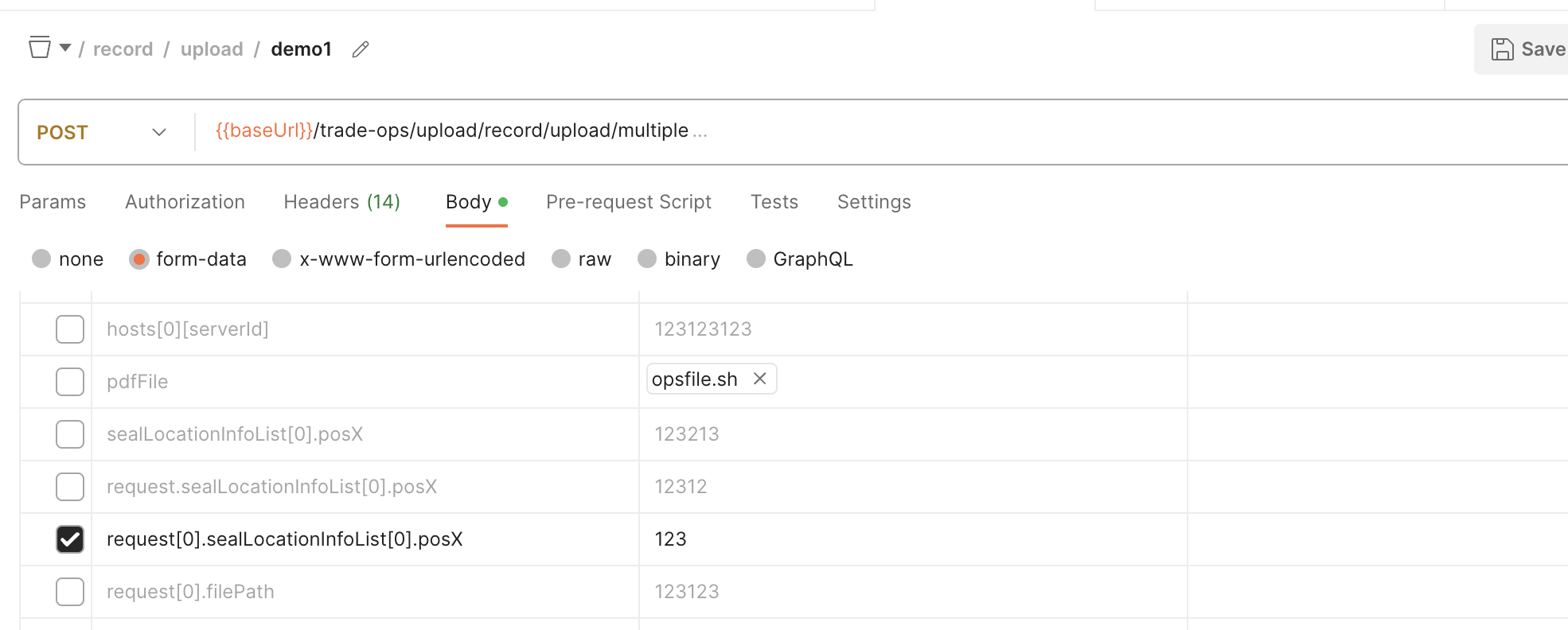

SpringBoot обрабатывает форму данных формы для получения массива объектов

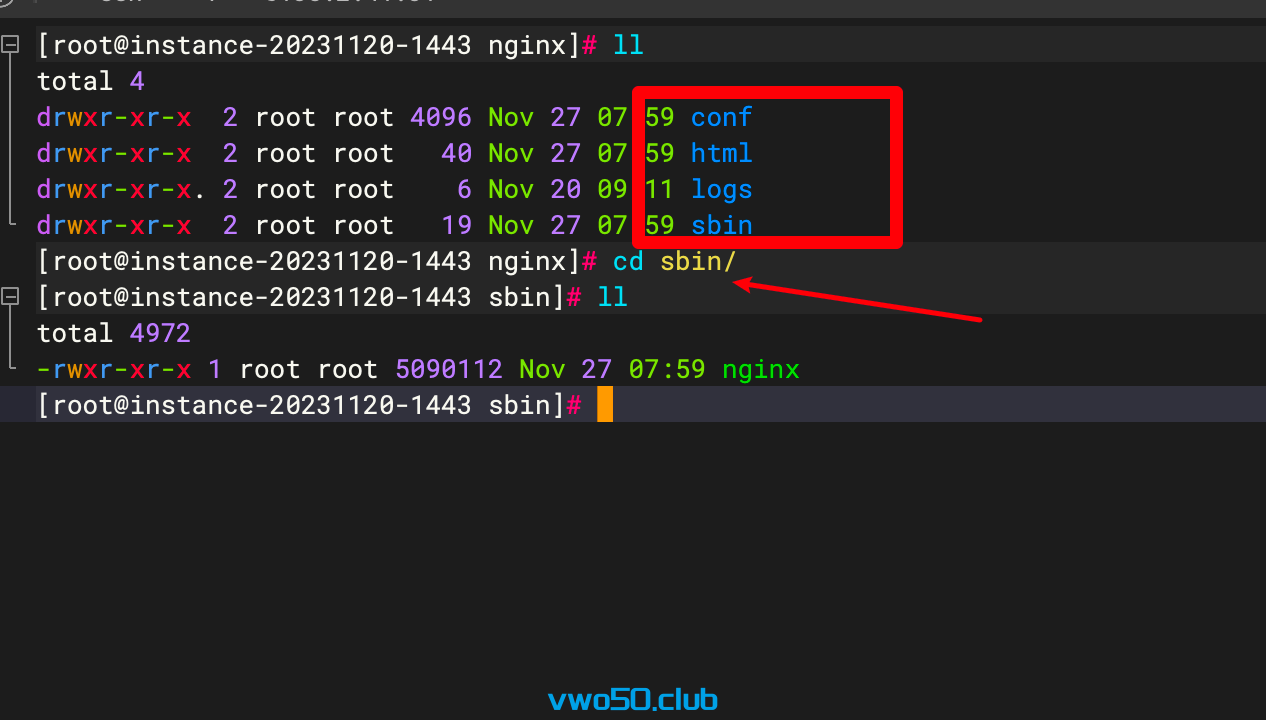

Nginx от новичка до новичка 01 - Установка Nginx через установку исходного кода

Проект flask развертывается на облачном сервере и получает доступ к серверной службе через доменное имя.

Порт запуска проекта Spring Boot часто занят, полное решение

Java вызывает стороннюю платформу для отправки мобильных текстовых сообщений

Практическое руководство по серверной части: как использовать Node.js для разработки интерфейса RESTful API (Node.js + Express + Sequelize + MySQL)

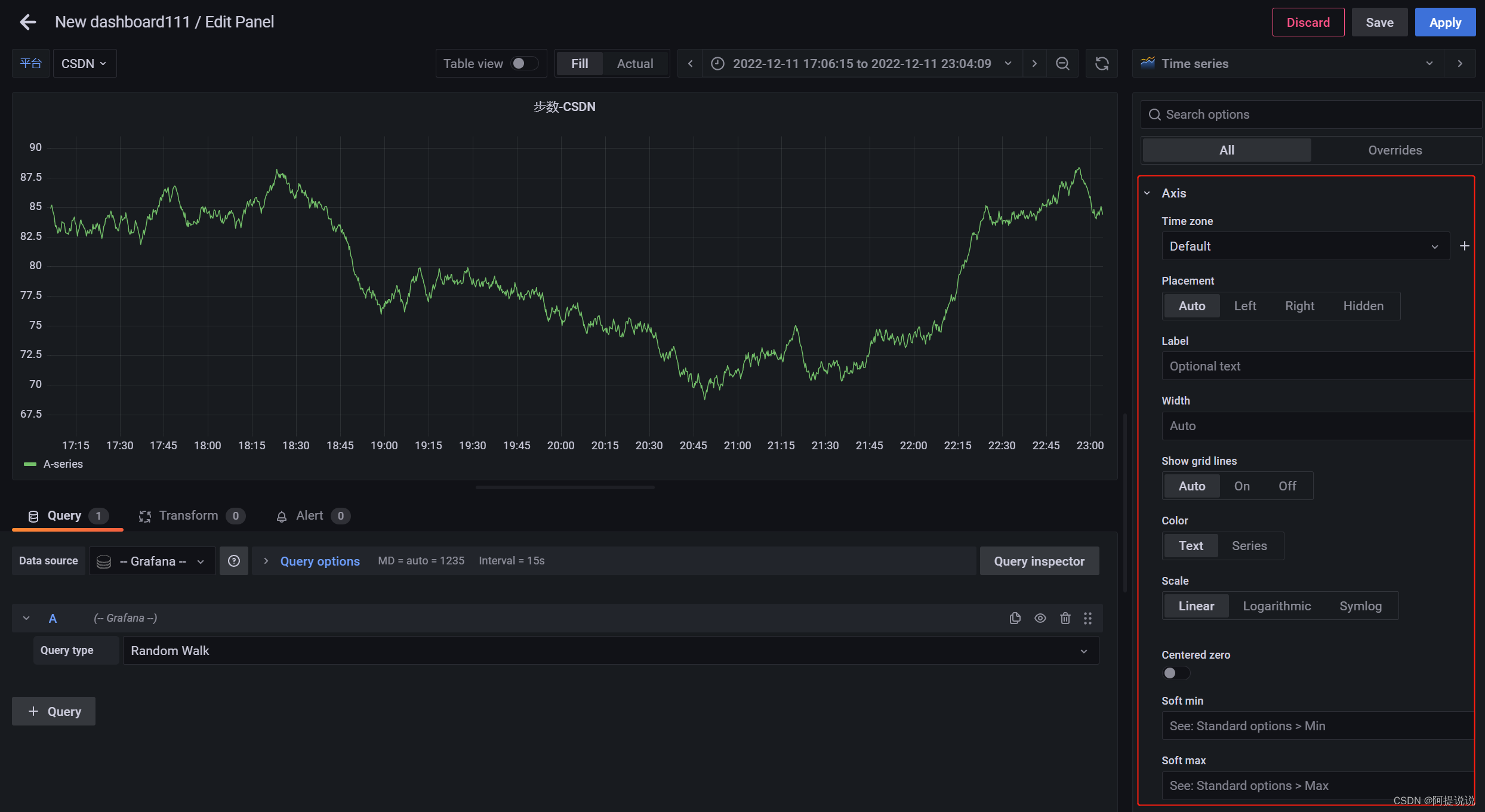

Введение в параметры конфигурации большого экрана мониторинга Grafana (2)

В статье «Научно-популярная статья» подробно объясняется протокол NTP: анализ точной синхронизации времени.

Пример разработки: серверная часть Java и интерфейсная часть vue реализуют функции комментариев и ответов.

Nodejs реализует сжатие и распаковку файлов/каталогов.

SpringBootИнтегрироватьEasyExcelСложно реализоватьExcelлистимпортировать&Функция экспорта

Настройка среды под Mac (используйте Brew для установки go и protoc)

Навыки разрешения конфликтов в Git

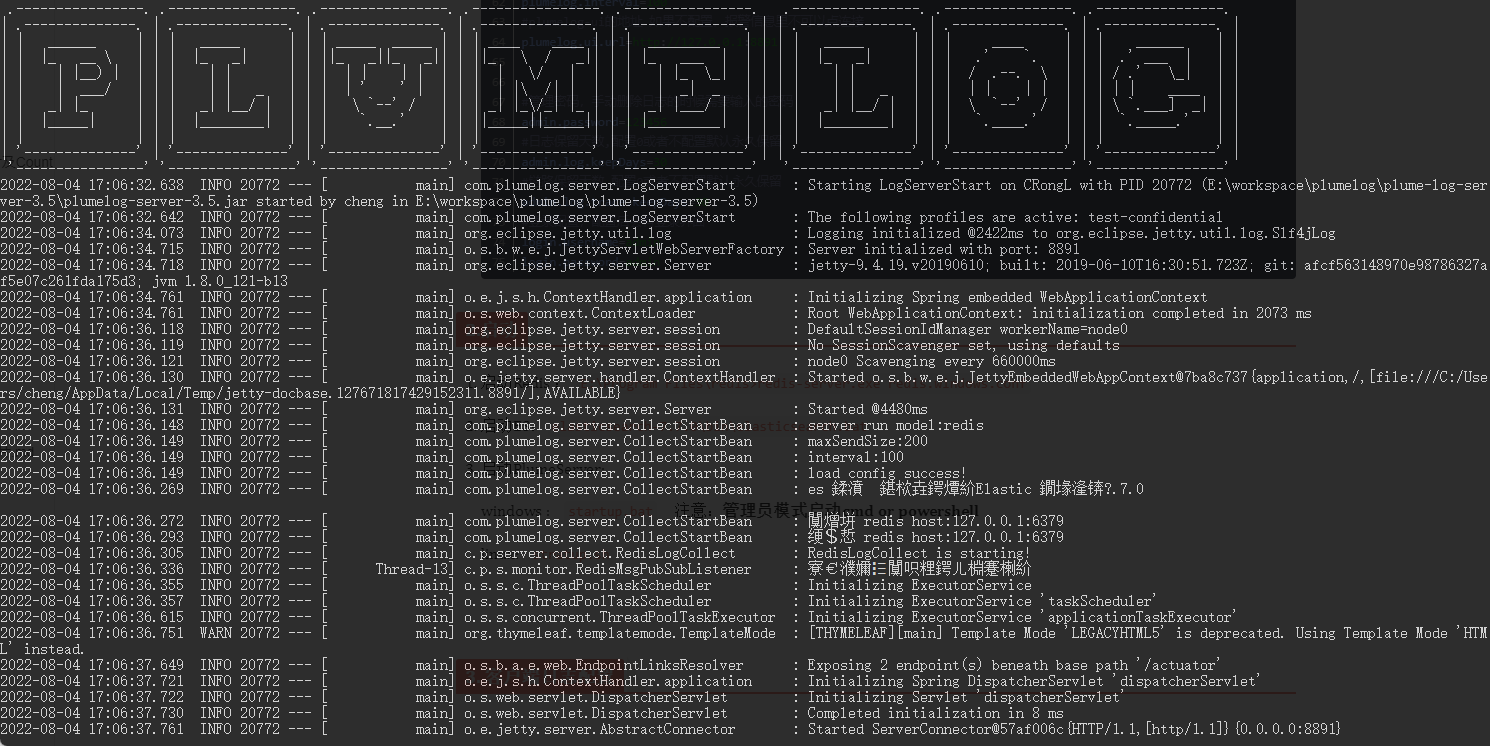

Распределенная система журналов: развертывание Plumelog и доступ к системе

Артефакт, который делает код элегантным и лаконичным: программирование на Java8 Stream

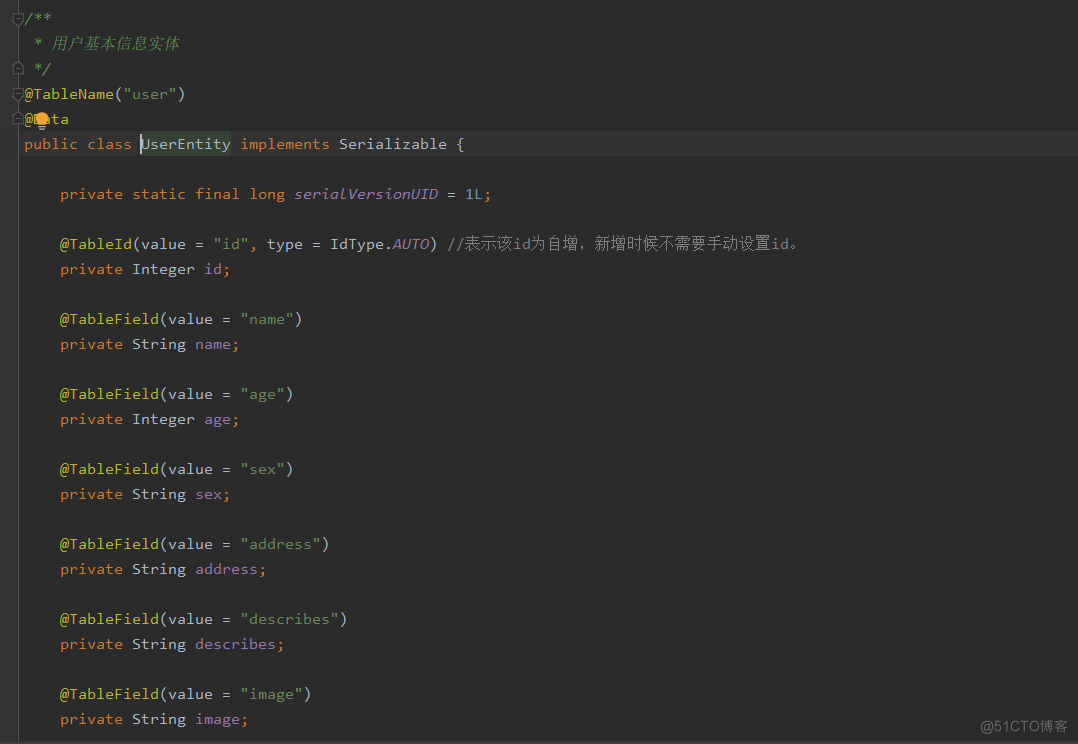

Spring Boot(06): Spring Boot в сочетании с MySQL создает минималистскую и эффективную систему управления данными.

Как использовать ArrayPool

Интегрируйте iText в Spring Boot для реализации замены контента на основе шаблонов PDF.

Redis реализует очередь задержки на основе zset