Полное руководство AutoGen и загрузка локального примера LLM

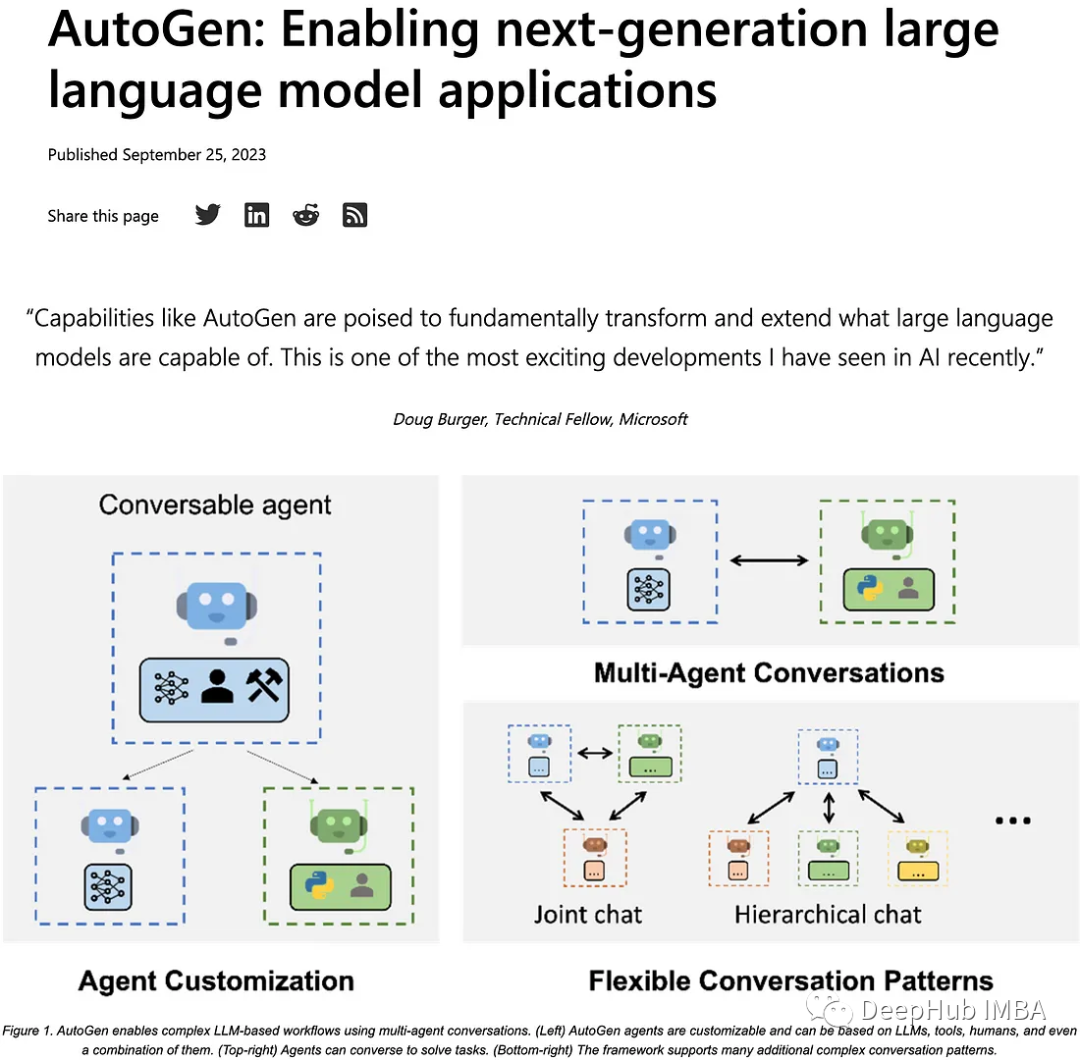

Autogen — это превосходная система искусственного интеллекта, которая может создавать несколько агентов искусственного интеллекта, которые могут сотрудничать для выполнения задач, включая автоматическую генерацию кода и эффективное выполнение задач.

в этой статье,Присмотримся к Autogen,И познакомьте, как сделать AutoGen Используйте местный LLM.

AutoGen

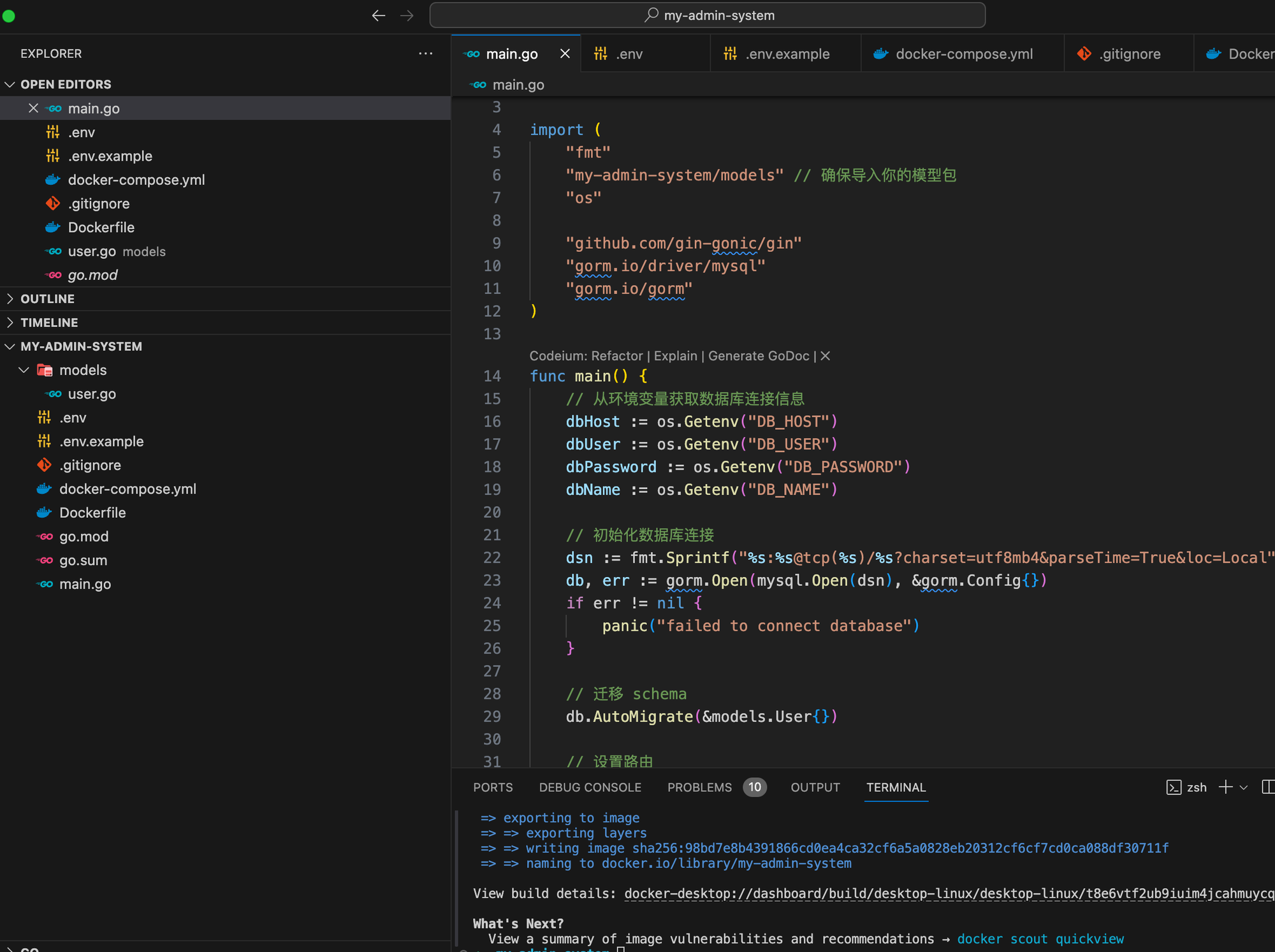

Autogen может настроить несколько агентов искусственного интеллекта, которые работают вместе для достижения конкретных целей. Следующие скриншоты взяты из официального блога Microsoft.

Создайте среду с помощью conda:

conda create -n pyautogen python=3.10

conda activate pyautogenAutoGenнуждатьсяPythonВерсия>= 3.8. Его можно установить из pip:

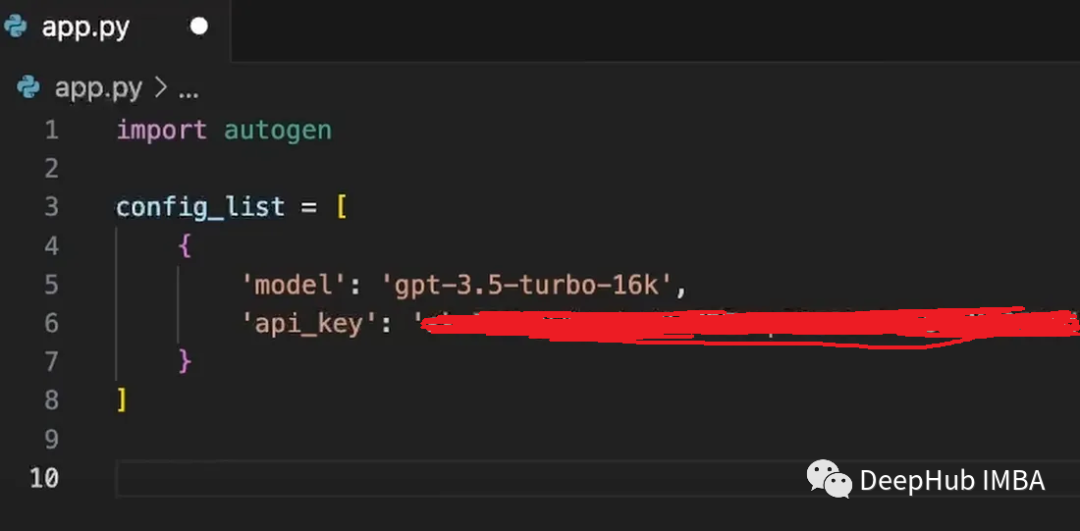

pip install pyautogenОтредактируйте скрипт Python (app.py), импортируйте Autogen и настройте конфигурацию. Эта конфигурация включает в себя определение модели, которую вы хотите использовать (например, GPT 3.5 Turbo), и предоставление ключа API.

В настоящее время AutoGen может использовать только API OpenAI, поэтому мы расскажем, как использовать местный LLM, позже.

Можно определить несколько агентов для выполнения разных ролей или задач. Например, ниже созданы 2 роли.

autogen.AssistantAgent(assistantname="CTO",Illm_config=llm_config)

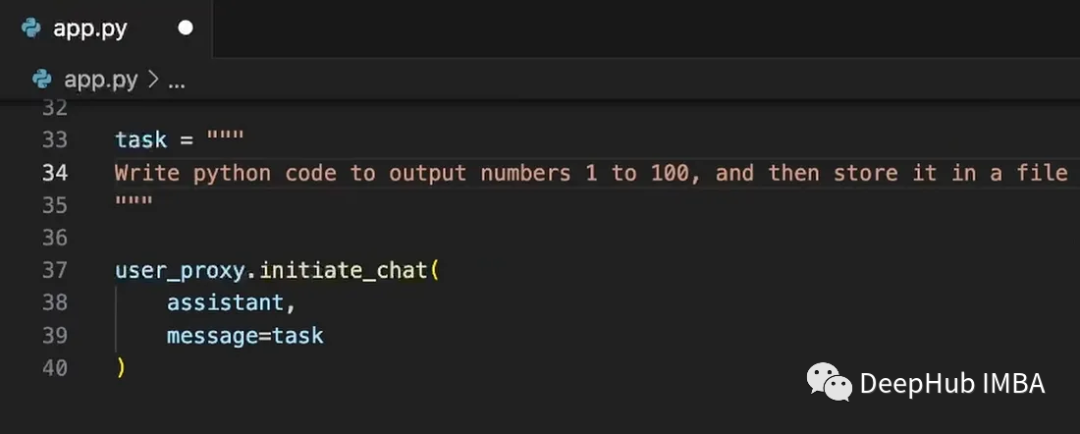

autogen.AssistantAgent(assistantname="CEO", Illm_config=llm_config)Определите задачи и инструкции: конкретные задачи, которые вы хотите, чтобы агент выполнял. Это может быть любая инструкция: от кодирования до анализа данных.

Затем агент начнет выполнять задачи в соответствии с инструкциями. Агент Assistant отвечает результатами или фрагментами кода.

Используйте местный LLM

Ниже мы покажем, как автоген Использовать местный LLM. Здесь в качестве локального средства LLM будет использоваться FastChat.

FastChat предоставляет API-интерфейс, совместимый с OpenAI, для поддерживаемых моделей, поэтому вы можете использовать FastChat в качестве встроенной замены API OpenAI. Но для правильной работы его код нуждается в небольшой модификации.

git clone https://github.com/lm-sys/FastChat.git

cd FastChatChatGLM-6B — это открытая двуязычная языковая модель, основанная на структуре General Language Model (GLM) и имеющая 6,2 миллиарда параметров. ChatGLM2-6B — продукт второго поколения.

git clone https://huggingface.co/THUDM/chatglm2-6bПосле завершения загрузки вы можете использовать его. Сначала запустите контроллер:

python -m fastchat.serve.controllerЗатем запустите рабочий поток модели.

python -m fastchat.serve.model_worker --model-path chatglm2-6bНаконец API:

python -m fastchat.serve.openai_api_server --host localhost --port 8000ПРИМЕЧАНИЕ. Если вы столкнулись с такой ошибкой

/root/anaconda3/envs/fastchat/lib/python3.9/runpy.py:197 in _run_module_as_main │

│ │

│ 194 │ main_globals = sys.modules["main"].dict │

│ 195 │ if alter_argv: │

│ 196 │ │ sys.argv[0] = mod_spec.origin │

│ ❱ 197 │ return _run_code(code, main_globals, None, │

│ 198 │ │ │ │ │ "main", mod_spec) │

│ 199 │

│ 200 def run_module(mod_name, init_globals=None, │Закомментирование всех строк, содержащих Finish_reason в fastchat/protocol/api_protocol.py и fastchat/protocol/openai_api_protocol.py, решит проблему. Модифицированный код выглядит следующим образом:

class CompletionResponseChoice(BaseModel):

index: int

text: str

logprobs: Optional[int] = None

# finish_reason: Optional[Literal["stop", "length"]]

class CompletionResponseStreamChoice(BaseModel):

index: int

text: str

logprobs: Optional[float] = None

# finish_reason: Optional[Literal["stop", "length"]] = NoneИспользуя приведенную ниже конфигурацию, autogen.oai.Completion и autogen.oai.ChatCompletion могут напрямую обращаться к модели.

from autogen import oai

# create a text completion request

response = oai.Completion.create(

config_list=[

{

"model": "chatglm2-6b",

"api_base": "http://localhost:8000/v1",

"api_type": "open_ai",

"api_key": "NULL", # just a placeholder

}

],

prompt="Hi",

)

print(response)

# create a chat completion request

response = oai.ChatCompletion.create(

config_list=[

{

"model": "chatglm2-6b",

"api_base": "http://localhost:8000/v1",

"api_type": "open_ai",

"api_key": "NULL",

}

],

messages=[{"role": "user", "content": "Hi"}]

)

print(response)Несколько моделей также могут использоваться локально:

python -m fastchat.serve.multi_model_worker \

--model-path lmsys/vicuna-7b-v1.3 \

--model-names vicuna-7b-v1.3 \

--model-path chatglm2-6b \

--model-names chatglm2-6bТогда код вывода будет следующим (обратите внимание, что вам нужно несколько карт или достаточно видеопамяти):

from autogen import oai

# create a chat completion request

response = oai.ChatCompletion.create(

config_list=[

{

"model": "chatglm2-6b",

"api_base": "http://localhost:8000/v1",

"api_type": "open_ai",

"api_key": "NULL",

},

{

"model": "vicuna-7b-v1.3",

"api_base": "http://localhost:8000/v1",

"api_type": "open_ai",

"api_key": "NULL",

}

],

messages=[{"role": "user", "content": "Hi"}]

)

print(response)Подвести итог

Агенты Autogen могут выполнять код, генерировать отчеты и автоматизировать задачи по мере необходимости. Они могут эффективно работать вместе, экономя время и энергию, а также мы рассказали, как использовать их локально, чтобы их можно было тестировать локально без необходимости использования API OpenAI.

Java перехватывает строку после определенного символа_java, как перехватить строку

Давайте кратко поговорим о технологии копирования на записи.

Выполнение собственных условий SQL-запроса в MyBatis Plus

Напоминание о выпуске общедоступной учетной записи WeChat (интерфейс сообщения шаблона общедоступной учетной записи WeChat)

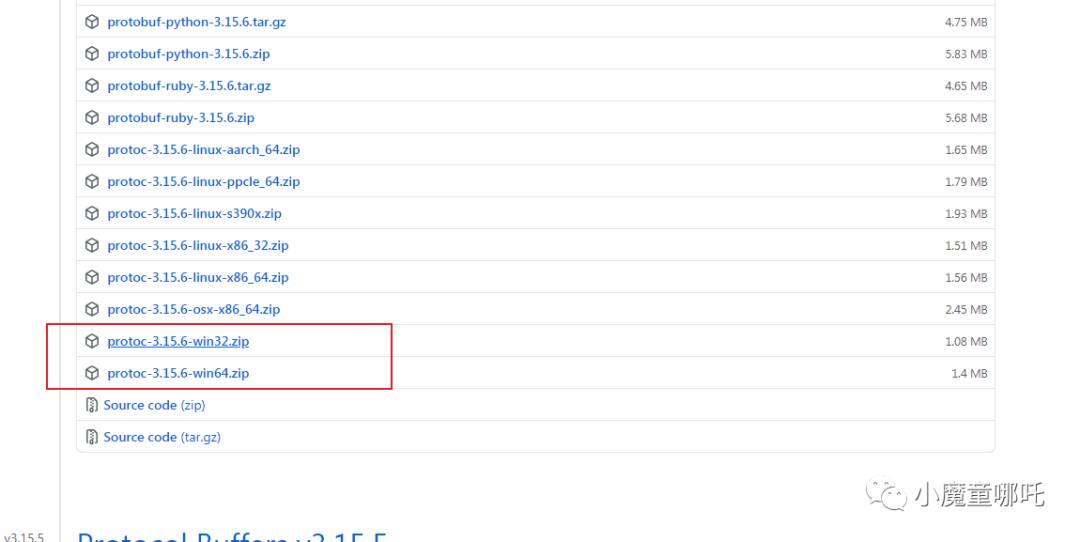

5 шагов для установки среды протокола

Наиболее полные коды состояния HTTP

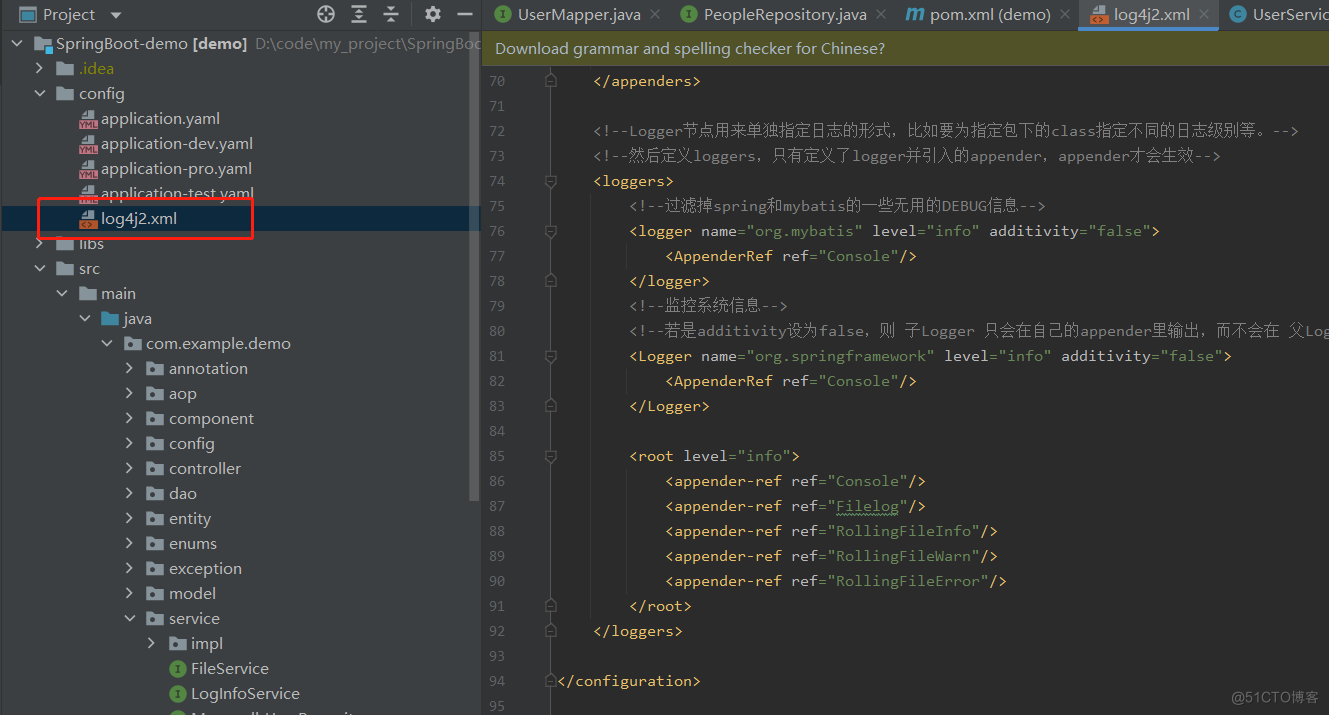

На основе языка Go мы шаг за шагом научим вас внедрять структуру системы управления серверной частью.

Эффективное управление журналами с помощью Spring Boot и Log4j2: подробное объяснение конфигурации

Что делать, если telnet не является внутренней или внешней командой [легко понять]

php-объект для анализа json_php json

Введение в принцип запуска Springboot, процесс запуска и механизм запуска.

Высокоуровневые операции Mongo, если данные не существуют, вставка и обновление, если они существуют (pymongo)

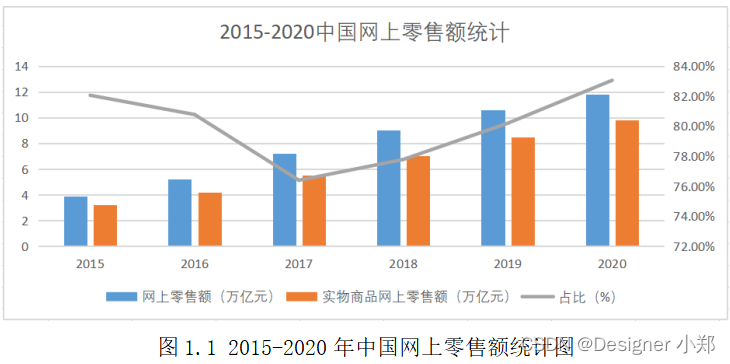

Проектирование и внедрение системы управления электронной коммерцией на базе Vue и SpringBoot.

Статья длиной в 9000 слов знакомит вас с процессом запуска SpringBoot — самым подробным процессом запуска SpringBoot в истории — с изображениями и текстом.

Как настроить размер экрана в PR. Учебное пособие по настройке размера видео в PR [подробное объяснение]

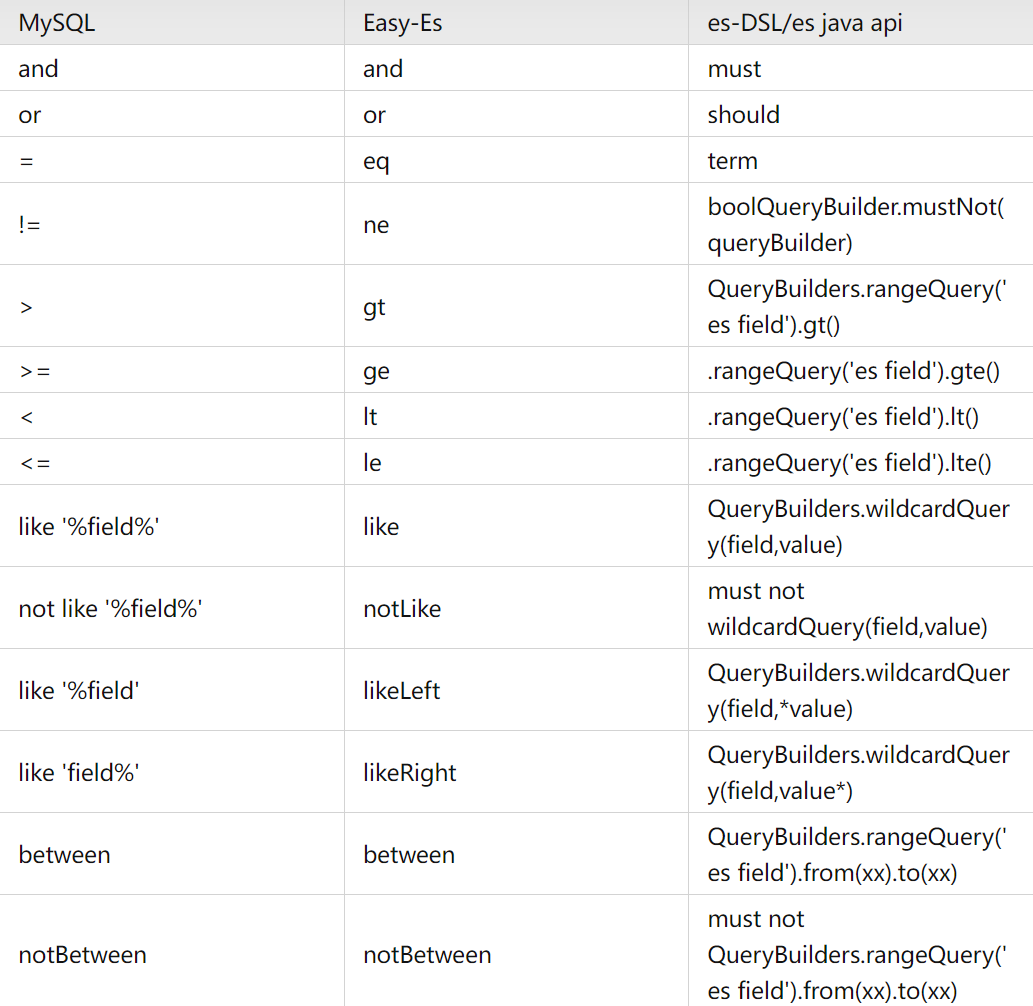

Элегантный и мощный: упростите операции ElasticSearch с помощью easy-es

Проект аутентификации по микросервисному токену: концепция и практика

【Java】Решено: org.springframework.http.converter.HttpMessageNotWritableException.

Изучите Kimi Smart Assistant: как использовать сверхдлинный текст, чтобы открыть новую сферу эффективной обработки информации

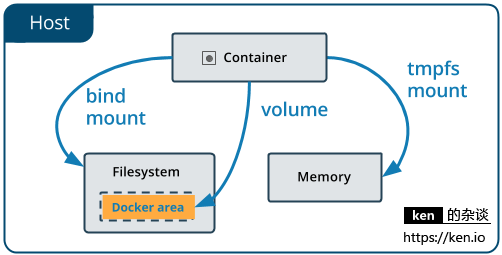

Начало работы с Docker: использование томов данных и монтирования файлов для хранения и совместного использования данных

Использование Python для реализации автоматической публикации статей в публичном аккаунте WeChat

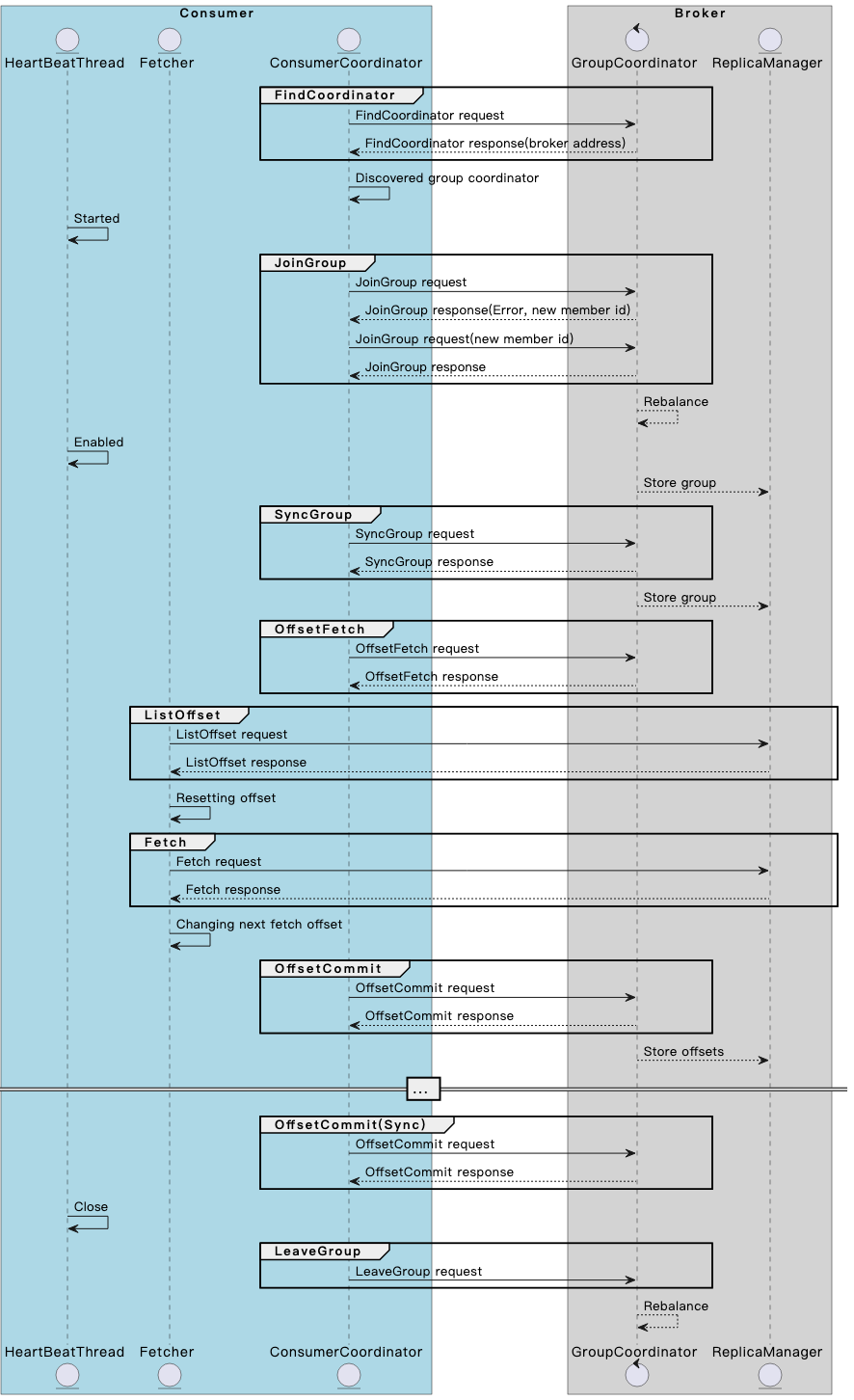

Разберитесь в механизме и принципах взаимодействия потребителя и брокера Kafka в одной статье.

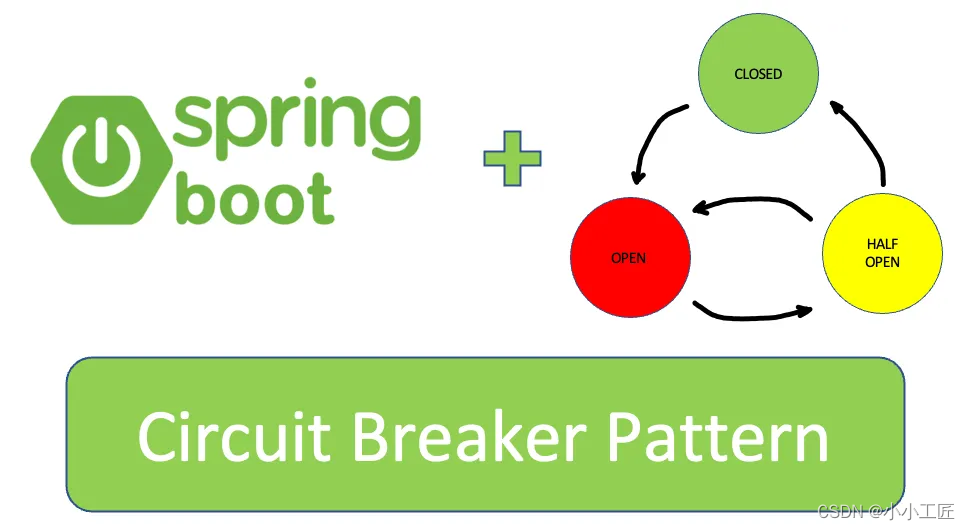

Spring Boot — использование Resilience4j-Circuitbreaker для реализации режима автоматического выключателя_предотвращения каскадных сбоев

13. Springboot интегрирует Protobuf

Примечание. Инструмент управления батареями Dell Dell Power Manager

Общая интерпретация класса LocalDate [java]

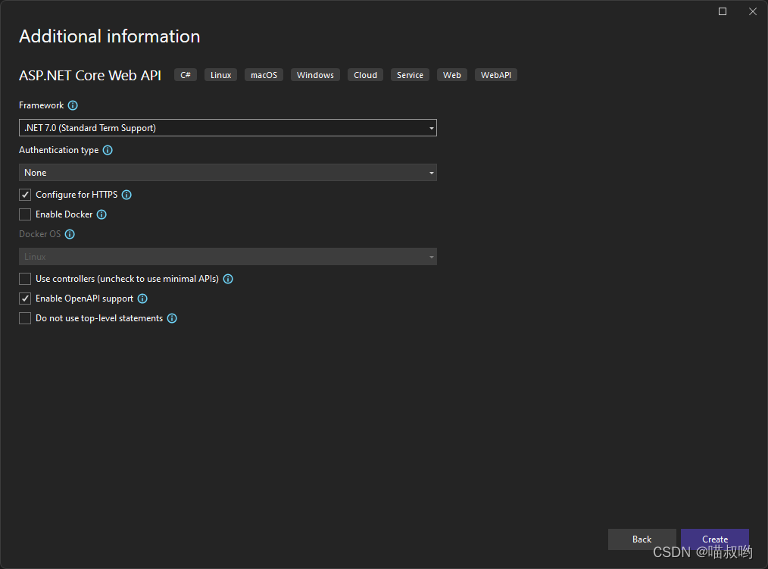

[Базовые знания ASP.NET Core] -- Веб-API -- Создание и настройка веб-API (1)

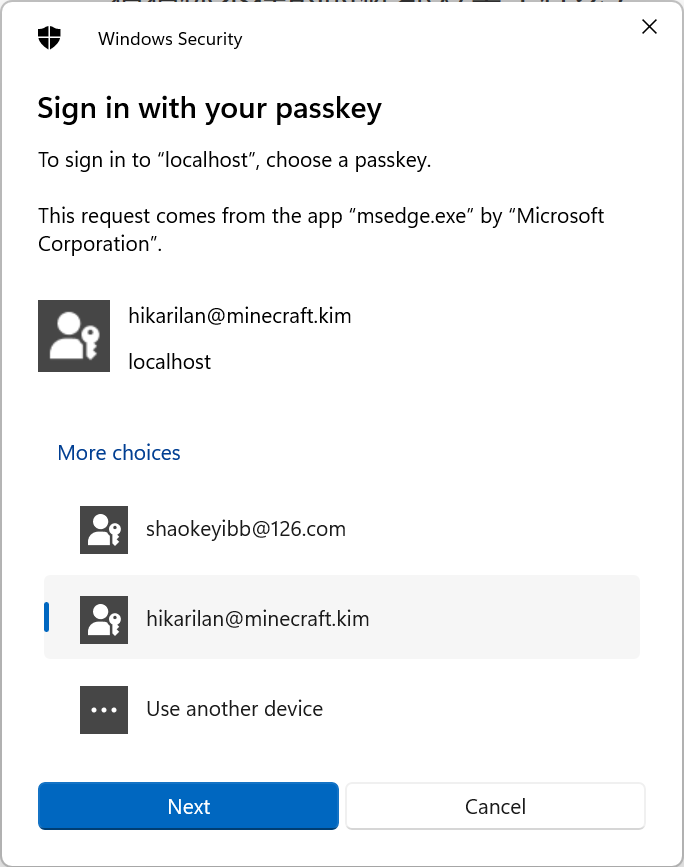

Настоящий бой! Подключите Passkey к своему веб-сайту для безопасного входа в систему без пароля.

Руководство по настройке Nginx: как найти, интерпретировать и оптимизировать настройки Nginx в Linux