Подробное объяснение основных команд Hive Beeline.

«Билайн» — это клиент Hive, который использует JDBC для подключения к HiveServer2, сервису в кластере. Команды Билайн можно выполнять на кластере для получения результатов запроса без входа в базу данных куста. При использовании команды beeline вам необходимо сначала запустить службу метаданных хранилища метаданных и службу hiveserver2, которые имеют широкий спектр сценариев применения, таких как оптимизация отображения результатов запроса, мониторинг сигналов тревоги, экспорт результатов запроса и т. д.

Ниже представлены параметры, которые можно добавить при использовании команды Beeline для достижения различных персонализированных потребностей.

использовать beeline --help Команда может быть отображена beeline помощь

[omc@hadoop102 hive]$ beeline --help

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Usage: java org.apache.hive.cli.beeline.BeeLine

-u <database url> the JDBC URL to connect to

-c <named url> the named JDBC URL to connect to,

which should be present in beeline-site.xml

as the value of beeline.hs2.jdbc.url.<namedUrl>

-r reconnect to last saved connect url (in conjunction with !save)

-n <username> the username to connect as

-p <password> the password to connect as

-d <driver class> the driver class to use

-i <init file> script file for initialization

-e <query> query that should be executed

-f <exec file> script file that should be executed

-w (or) --password-file <password file> the password file to read password from

--hiveconf property=value Use value for given property

--hivevar name=value hive variable name and value

This is Hive specific settings in which variables

can be set at session level and referenced in Hive

commands or queries.

--property-file=<property-file> the file to read connection properties (url, driver, user, password) from

--color=[true/false] control whether color is used for display

--showHeader=[true/false] show column names in query results

--escapeCRLF=[true/false] show carriage return and line feeds in query results as escaped \r and \n

--headerInterval=ROWS; the interval between which heades are displayed

--fastConnect=[true/false] skip building table/column list for tab-completion

--autoCommit=[true/false] enable/disable automatic transaction commit

--verbose=[true/false] show verbose error messages and debug info

--showWarnings=[true/false] display connection warnings

--showDbInPrompt=[true/false] display the current database name in the prompt

--showNestedErrs=[true/false] display nested errors

--numberFormat=[pattern] format numbers using DecimalFormat pattern

--force=[true/false] continue running script even after errors

--maxWidth=MAXWIDTH the maximum width of the terminal

--maxColumnWidth=MAXCOLWIDTH the maximum width to use when displaying columns

--silent=[true/false] be more silent

--autosave=[true/false] automatically save preferences

--outputformat=[table/vertical/csv2/tsv2/dsv/csv/tsv] format mode for result display

Note that csv, and tsv are deprecated - use csv2, tsv2 instead

--incremental=[true/false] Defaults to false. When set to false, the entire result set

is fetched and buffered before being displayed, yielding optimal

display column sizing. When set to true, result rows are displayed

immediately as they are fetched, yielding lower latency and

memory usage at the price of extra display column padding.

Setting --incremental=true is recommended if you encounter an OutOfMemory

on the client side (due to the fetched result set size being large).

Only applicable if --outputformat=table.

--incrementalBufferRows=NUMROWS the number of rows to buffer when printing rows on stdout,

defaults to 1000; only applicable if --incremental=true

and --outputformat=table

--truncateTable=[true/false] truncate table column when it exceeds length

--delimiterForDSV=DELIMITER specify the delimiter for delimiter-separated values output format (default: |)

--isolation=LEVEL set the transaction isolation level

--nullemptystring=[true/false] set to true to get historic behavior of printing null as empty string

--maxHistoryRows=MAXHISTORYROWS The maximum number of rows to store beeline history.

--delimiter=DELIMITER set the query delimiter; multi-char delimiters are allowed, but quotation

marks, slashes, and -- are not allowed; defaults to ;

--convertBinaryArrayToString=[true/false] display binary column data as string or as byte array

--help display this message

Example:

1. Connect using simple authentication to HiveServer2 on localhost:10000

$ beeline -u jdbc:hive2://localhost:10000 username password

2. Connect using simple authentication to HiveServer2 on hs.local:10000 using -n for username and -p for password

$ beeline -n username -p password -u jdbc:hive2://hs2.local:10012

3. Connect using Kerberos authentication with hive/localhost@mydomain.com as HiveServer2 principal

$ beeline -u "jdbc:hive2://hs2.local:10013/default;principal=hive/localhost@mydomain.com"

4. Connect using SSL connection to HiveServer2 on localhost at 10000

$ beeline "jdbc:hive2://localhost:10000/default;ssl=true;sslTrustStore=/usr/local/truststore;trustStorePassword=mytruststorepassword"

5. Connect using LDAP authentication

$ beeline -u jdbc:hive2://hs2.local:10013/default <ldap-username> <ldap-password>

Для подключения к Билайн необходимо сначала указать адрес базы данных и имя пользователя.

-u---Загрузить строку подключения JDBC:

beeline -u db_URL

-n---Загрузить имя пользователя:

beeline -n valid_user

Что-то вроде этого:

[omc@hadoop102 hive]$ beeline -u jdbc:hive2://hadoop102:10000 -n omc

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Connecting to jdbc:hive2://hadoop102:10000

Connected to: Apache Hive (version 3.1.2)

Driver: Hive JDBC (version 3.1.2)

Transaction isolation: TRANSACTION_REPEATABLE_READ

Beeline version 3.1.2 by Apache Hive

0: jdbc:hive2://hadoop102:10000>

-e---Используйте оператор запроса:

beeline -e "query_string"

Вы можете напрямую выполнить оператор sql, подобный этому

[omc@hadoop102 bin]$ beeline -u jdbc:hive2://hadoop102:10000 -n omc -e 'select * from ods.test;'

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Connecting to jdbc:hive2://hadoop102:10000

Connected to: Apache Hive (version 3.1.2)

Driver: Hive JDBC (version 3.1.2)

Transaction isolation: TRANSACTION_REPEATABLE_READ

INFO : Compiling command(queryId=omc_20220828141355_270f04a7-1b18-4e81-80b4-eaa620d56c07): select * from ods.test

INFO : Concurrency mode is disabled, not creating a lock manager

INFO : Semantic Analysis Completed (retrial = false)

INFO : Returning Hive schema: Schema(fieldSchemas:[FieldSchema(name:test.id, type:int, comment:null), FieldSchema(name:test.name, type:string, comment:null), FieldSchema(name:test.age, type:int, comment:null), FieldSchema(name:test.phonenumber, type:string, comment:null), FieldSchema(name:test.address, type:string, comment:null)], properties:null)

INFO : Completed compiling command(queryId=omc_20220828141355_270f04a7-1b18-4e81-80b4-eaa620d56c07); Time taken: 1.845 seconds

INFO : Concurrency mode is disabled, not creating a lock manager

INFO : Executing command(queryId=omc_20220828141355_270f04a7-1b18-4e81-80b4-eaa620d56c07): select * from ods.test

INFO : Completed executing command(queryId=omc_20220828141355_270f04a7-1b18-4e81-80b4-eaa620d56c07); Time taken: 0.002 seconds

INFO : OK

INFO : Concurrency mode is disabled, not creating a lock manager

+----------+-------------+-----------+-------------------+---------------+

| test.id | test.name | test.age | test.phonenumber | test.address |

+----------+-------------+-----------+-------------------+---------------+

| 1 | mba1398 | 20 | 10010 | shijiazhuang |

| 2 | datartisan | 30 | 1000 | bj |

+----------+-------------+-----------+-------------------+---------------+

2 rows selected (1.972 seconds)

Beeline version 3.1.2 by Apache Hive

Closing: 0: jdbc:hive2://hadoop102:10000

[omc@hadoop102 bin]$

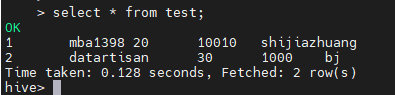

Видно, что билайн оптимизировал отображение результатов запроса, и строки и столбцы хорошо видны. По сравнению с эффектом отображения в базе данных hive, это, можно сказать, полная победа.

Помимо прямой загрузки операторов sql, он также может загружать файлы sql. Использование выглядит следующим образом:

-f---Загрузить файл: beeline -f путь к файлу для нескольких файлов

-f file1 -f file2

Пожалуйста, посмотрите следующий пример:

① Сначала создайте один sql файл сценария scrip.sql,Его содержание select * from ods.test;

② Выполнить команду Билайн.

[omc@hadoop102 bin]$ beeline -u jdbc:hive2://hadoop102:10000 -n omc -f scrip.sql

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Connecting to jdbc:hive2://hadoop102:10000

Connected to: Apache Hive (version 3.1.2)

Driver: Hive JDBC (version 3.1.2)

Transaction isolation: TRANSACTION_REPEATABLE_READ

0: jdbc:hive2://hadoop102:10000> select * from ods.test;

INFO : Compiling command(queryId=omc_20220828142440_4548355c-4ebb-4850-91b0-0ef26b374640): select * from ods.test

INFO : Concurrency mode is disabled, not creating a lock manager

INFO : Semantic Analysis Completed (retrial = false)

INFO : Returning Hive schema: Schema(fieldSchemas:[FieldSchema(name:test.id, type:int, comment:null), FieldSchema(name:test.name, type:string, comment:null), FieldSchema(name:test.age, type:int, comment:null), FieldSchema(name:test.phonenumber, type:string, comment:null), FieldSchema(name:test.address, type:string, comment:null)], properties:null)

INFO : Completed compiling command(queryId=omc_20220828142440_4548355c-4ebb-4850-91b0-0ef26b374640); Time taken: 0.151 seconds

INFO : Concurrency mode is disabled, not creating a lock manager

INFO : Executing command(queryId=omc_20220828142440_4548355c-4ebb-4850-91b0-0ef26b374640): select * from ods.test

INFO : Completed executing command(queryId=omc_20220828142440_4548355c-4ebb-4850-91b0-0ef26b374640); Time taken: 0.001 seconds

INFO : OK

INFO : Concurrency mode is disabled, not creating a lock manager

+----------+-------------+-----------+-------------------+---------------+

| test.id | test.name | test.age | test.phonenumber | test.address |

+----------+-------------+-----------+-------------------+---------------+

| 1 | mba1398 | 20 | 10010 | shijiazhuang |

| 2 | datartisan | 30 | 1000 | bj |

+----------+-------------+-----------+-------------------+---------------+

2 rows selected (0.279 seconds)

0: jdbc:hive2://hadoop102:10000>

0: jdbc:hive2://hadoop102:10000> Closing: 0: jdbc:hive2://hadoop102:10000

[omc@hadoop102 bin]$

По приведенным примерам не сложно найти проблему, то есть печатается слишком много бесполезной информации. Можно ли это уменьшить? Ответ: да.

--silent=[true/false] ---Уменьшить количество отображаемой информации:

beeline --silent=true

Эффект отображения следующий:

[omc@hadoop102 bin]$ beeline -u jdbc:hive2://hadoop102:10000 -n omc -f scrip.sql --silent=true

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

+----------+-------------+-----------+-------------------+---------------+

| test.id | test.name | test.age | test.phonenumber | test.address |

+----------+-------------+-----------+-------------------+---------------+

| 1 | mba1398 | 20 | 10010 | shijiazhuang |

| 2 | datartisan | 30 | 1000 | bj |

+----------+-------------+-----------+-------------------+---------------+

[omc@hadoop102 bin]$

beeline Помимо чтения файлов, вы также можете записывать в файл результаты запроса. посмотрите следующий пример:

[omc@hadoop102 bin]$ beeline -u jdbc:hive2://hadoop102:10000 -n omc -f scrip.sql --silent=true > result.txt

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

[omc@hadoop102 bin]$ cat result.txt

+----------+-------------+-----------+-------------------+---------------+

| test.id | test.name | test.age | test.phonenumber | test.address |

+----------+-------------+-----------+-------------------+---------------+

| 1 | mba1398 | 20 | 10010 | shijiazhuang |

| 2 | datartisan | 30 | 1000 | bj |

+----------+-------------+-----------+-------------------+---------------+

[omc@hadoop102 bin]$

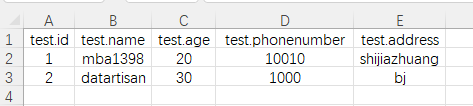

Некоторые люди могут сказать, что если объем данных большой, этот эффект отображения нелегко увидеть. Могу ли я создать файл, который можно будет открыть в Excel? Может!

Сначала настройте формат выходного файла

--outputformat=[таблица/вертикаль/csv/tsv/dsv/csv2/tsv2] ---Формат вывода:

beeline --outputformat=tsv

Во-вторых, вам необходимо настроить разделитель результатов запроса (по умолчанию |)。

--delimiterForDSV= DELIMITER ---Разделитель для формата вывода разделенных значений. По умолчанию используется символ «|».

[omc@hadoop102 bin]$ beeline -u jdbc:hive2://hadoop102:10000 -n omc -f scrip.sql --outputformat=csv2 --delimiterForDSV=',' --silent=true > result.csv

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/opt/module/hive/lib/log4j-slf4j-impl-2.10.0.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

[omc@hadoop102 bin]$ cat result.csv

test.id,test.name,test.age,test.phonenumber,test.address

1,mba1398,20,10010,shijiazhuang

2,datartisan,30,1000,bj

[omc@hadoop102 bin]$

скачать result.csv После этого используйте excel Открытый, он может отображаться нормально:

С помощью этих функций вы можете удовлетворить потребности в оптимизации отображения результатов запроса, экспорте результатов запроса и т. д., а также инкапсулировать оператор запроса в beeline shell Он также может реализовать функцию ежедневного мониторинга. Можно сказать, что. beeline Это действительно слишком мощно.

Ниже приведены некоторые менее часто используемые функции, о которых вы можете узнать по мере необходимости.

--autoCommit=[true/false] ---Войдите в режим автоматической фиксации:

beeline --autoCommit=true

--autosave=[true/false] ---Войдите в режим автосохранения:

beeline --autosave=true

--color=[true/false] ---Отобразить используемый цвет:

beeline --color=true

--fastConnect=[true/false] ---Пропустить создание объектов, таких как таблицы, при подключении:

beeline --fastConnect=false

--force=[true/false] ---нужно ли принудительно запустить скрипт:

beeline--force=true

--headerInterval=ROWS ---Формат интервала выходной таблицы, по умолчанию – 100:

beeline --headerInterval=50

--hiveconf property=value ---Установите значение свойства, чтобы предотвратить его сброс с помощью hive.conf.restricted.list:

beeline --hiveconf prop1=value1

--hivevar name=value ---Установить имя переменной:

beeline --hivevar var1=value1

--incremental=[true/false] ---Приращение вывода

--isolation=LEVEL ---Установить уровень изоляции транзакции:

beeline --isolation=TRANSACTION_SERIALIZABLE

--maxColumnWidth=MAXCOLWIDTH ---Установить максимальную ширину строкового столбца:

beeline --maxColumnWidth=25

--maxWidth=MAXWIDTH ---Установить максимальную ширину усеченных данных:

beeline --maxWidth=150

--nullemptystring=[true/false] ---Вывести пустую строку:

beeline --nullemptystring=false

--numberFormat=[шаблон] ---Использовать десятичный формат для чисел:

beeline --numberFormat="#,###,##0.00"

--showHeader=[true/false] ---Отобразить имена столбцов результатов запроса:

beeline --showHeader=false

--showNestedErrs=[true/false] ---Показать вложенные ошибки:

beeline --showNestedErrs=true

--showWarnings=[true/false] ---Показывать предупреждения:

beeline --showWarnings=true

--truncateTable=[true/false] ---Усекать ли столбцы таблицы на стороне клиента

--verbose=[true/false] ---Отображение подробной информации об ошибках и информации об отладке:

beeline --verbose=true

-d---Использовать класс драйвера:

beeline -d driver_class

На этом этапе было представлено основное использование команды beeline. Использовали ли вы ее в других сценариях? Каждый может оставить сообщение для обсуждения.

Углубленный анализ переполнения памяти CUDA: OutOfMemoryError: CUDA не хватает памяти. Попыталась выделить 3,21 Ги Б (GPU 0; всего 8,00 Ги Б).

[Решено] ошибка установки conda. Среда решения: не удалось выполнить первоначальное зависание. Повторная попытка с помощью файла (графическое руководство).

Прочитайте нейросетевую модель Трансформера в одной статье

.ART Теплые зимние предложения уже открыты

Сравнительная таблица описания кодов ошибок Amap

Уведомление о последних правилах Points Mall в декабре 2022 года.

Даже новички могут быстро приступить к работе с легким сервером приложений.

Взгляд на RSAC 2024|Защита конфиденциальности в эпоху больших моделей

Вы используете ИИ каждый день и до сих пор не знаете, как ИИ дает обратную связь? Одна статья для понимания реализации в коде Python общих функций потерь генеративных моделей + анализ принципов расчета.

Используйте (внутренний) почтовый ящик для образовательных учреждений, чтобы использовать Microsoft Family Bucket (1T дискового пространства на одном диске и версию Office 365 для образовательных учреждений)

Руководство по началу работы с оперативным проектом (7) Практическое сочетание оперативного письма — оперативного письма на основе интеллектуальной системы вопросов и ответов службы поддержки клиентов

[docker] Версия сервера «Чтение 3» — создайте свою собственную программу чтения веб-текста

Обзор Cloud-init и этапы создания в рамках PVE

Корпоративные пользователи используют пакет регистрационных ресурсов для регистрации ICP для веб-сайта и активации оплаты WeChat H5 (с кодом платежного узла версии API V3)

Подробное объяснение таких показателей производительности с высоким уровнем параллелизма, как QPS, TPS, RT и пропускная способность.

Удачи в конкурсе Python Essay Challenge, станьте первым, кто испытает новую функцию сообщества [Запускать блоки кода онлайн] и выиграйте множество изысканных подарков!

[Техническая посадка травы] Кровавая рвота и отделка позволяют вам необычным образом ощипывать гусиные перья! Не распространяйте информацию! ! !

[Официальное ограниченное по времени мероприятие] Сейчас ноябрь, напишите и получите приз

Прочтите это в одной статье: Учебник для няни по созданию сервера Huanshou Parlu на базе CVM-сервера.

Cloud Native | Что такое CRD (настраиваемые определения ресурсов) в K8s?

Как использовать Cloudflare CDN для настройки узла (CF самостоятельно выбирает IP) Гонконг, Китай/Азия узел/сводка и рекомендации внутреннего высокоскоростного IP-сегмента

Дополнительные правила вознаграждения амбассадоров акции в марте 2023 г.

Можно ли открыть частный сервер Phantom Beast Palu одним щелчком мыши? Супер простой урок для начинающих! (Прилагается метод обновления сервера)

[Играйте с Phantom Beast Palu] Обновите игровой сервер Phantom Beast Pallu одним щелчком мыши

Maotouhu делится: последний доступный внутри страны адрес склада исходного образа Docker 2024 года (обновлено 1 декабря)

Кодирование Base64 в MultipartFile

5 точек расширения SpringBoot, супер практично!

Глубокое понимание сопоставления индексов Elasticsearch.