Основы эффективного обучения больших языковых моделей: оптимизаторы AdamW и Adafator

Prerequsite:Алгоритм оптимизации Адама Алгоритм оптимизации Адама долгое время был основным алгоритмом обновления параметров, и в этой статье представлены AdamW и Adafator, используемые в процессе обучения больших моделей.

AdamW

Оригиналбумага:Decoupled Weight Decay Regularization

AdamW означает Адам + Распад веса.

Адам полагает, что многие читатели уже поняли, что распад веса относительно легко объяснить. Чтобы предотвратить переобучение, при вычислении функции потерь необходимо добавить регулярный член L2:

При расчете градиента путем вывода:

Распад веса умножается перед обычным термином на

,Используется для масштабирования воздействия обычного термина:Регуляризация L2 приведет к тому, что параметры будут приближаться к 0, а Weight Decay смягчает эту тенденцию.。

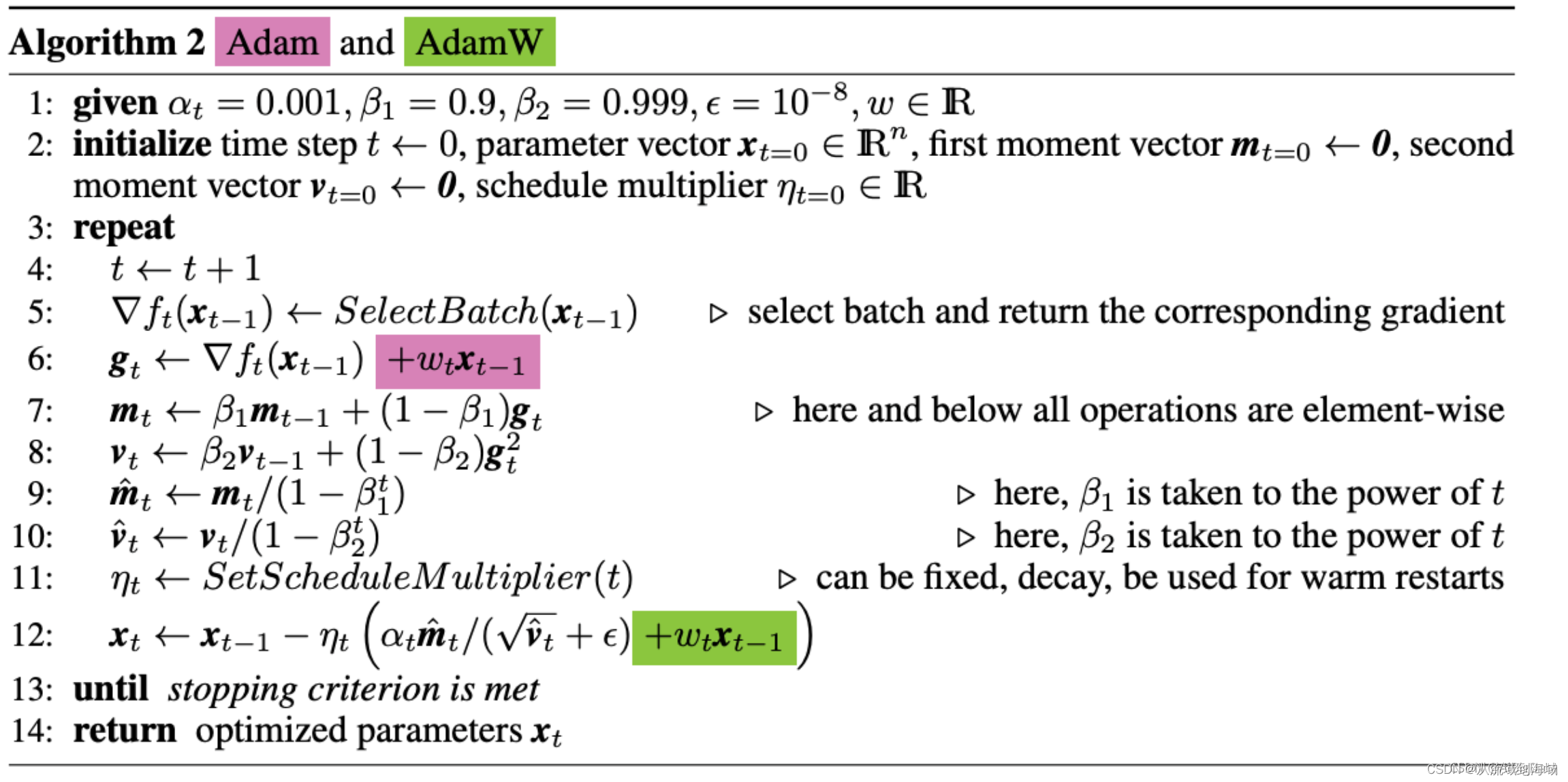

AdamW применяет Weight Decay на последнем этапе обновления параметров алгоритма оптимизации, см. рисунок ниже (w на рисунке ниже эквивалентен приведенной выше формуле).

)。

Фиолетовая и зеленая части на рисунке эквивалентны формуле 2. Фиолетовая часть — это место, где исходный Адам применяет затухание веса, а зеленая часть — это место, где AdamW применяет затухание веса.

Реализацию кода можно найти в:Понимание Адама В

Adafator

Оригиналбумага:Adafactor: Adaptive Learning Rates with Sublinear Memory Cost

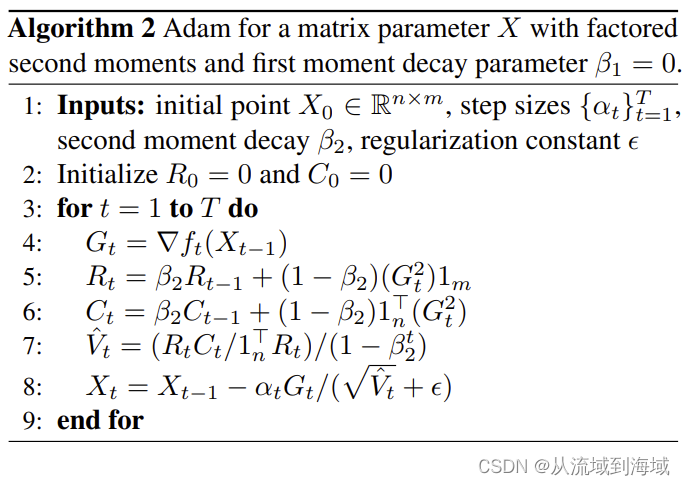

Adafator не сохраняет скользящее среднее каждого элемента весовой матрицы, как Адам, но сохраняет сумму скользящих средних измерения строки или измерения столбца, что значительно уменьшает объем памяти, необходимый при обновлении параметров.

Подробный метод расчета Адафатора показан в алгоритме ниже:

в

и

Представляет квадратный градиент измерения строки и измерения столбца.

Представляет количество строк,

представляет количество столбцов,

Чтобы представить комбинацию измерений столбца, вы можете использовать

То есть производится эквивалентная замена размеров.

Таким образом, пространство, необходимое для хранения, сокращается с

кратные

кратно, что экономит значительное пространство для хранения.

ПРИМЕЧАНИЕ. Из-за

, что эквивалентно устранению распада веса Адама. Это приводит к тому недостатку, что Adafator имеет нестабильную производительность по сравнению с алгоритмом Адама. Иногда он может сходиться быстрее, чем Адам, а иногда не может.

Ссылки

Учебное пособие по Jetpack Compose для начинающих, базовые элементы управления и макет

Код js веб-страницы, фон частицы, код спецэффектов

【новый! Суперподробное】Полное руководство по свойствам компонентов Figma.

🎉Обязательно к прочтению новичкам: полное руководство по написанию мини-программ WeChat с использованием программного обеспечения Cursor.

[Забавный проект Docker] VoceChat — еще одно приложение для мгновенного чата (IM)! Может быть встроен в любую веб-страницу!

Как реализовать переход по странице в HTML (html переходит на указанную страницу)

Как решить проблему зависания и низкой скорости при установке зависимостей с помощью npm. Существуют ли доступные источники npm, которые могут решить эту проблему?

Серия From Zero to Fun: Uni-App WeChat Payment Practice WeChat авторизует вход в систему и украшает страницу заказа, создает интерфейс заказа и инициирует запрос заказа

Серия uni-app: uni.navigateЧтобы передать скачок значения

Апплет WeChat настраивает верхнюю панель навигации и адаптируется к различным моделям.

JS-время конвертации

Обеспечьте бесперебойную работу ChromeDriver 125: советы по решению проблемы chromedriver.exe не найдены

Поле комментария, щелчок мышью, специальные эффекты, js-код

Объект массива перемещения объекта JS

Как открыть разрешение на позиционирование апплета WeChat_Как использовать WeChat для определения местонахождения друзей

Я даю вам два набора из 18 простых в использовании фонов холста Power BI, так что вам больше не придется возиться с цветами!

Получить текущее время в js_Как динамически отображать дату и время в js

Вам необходимо изучить сочетания клавиш vsCode для форматирования и организации кода, чтобы вам больше не приходилось настраивать формат вручную.

У ChatGPT большое обновление. Всего за 45 минут пресс-конференция показывает, что OpenAI сделал еще один шаг вперед.

Copilot облачной разработки — упрощение разработки

Микросборка xChatGPT с низким кодом, создание апплета чат-бота с искусственным интеллектом за пять шагов

CUDA Out of Memory: идеальное решение проблемы нехватки памяти CUDA

Анализ кластеризации отдельных ячеек, который должен освоить каждый&MarkerгенетическийВизуализация

vLLM: мощный инструмент для ускорения вывода ИИ

CodeGeeX: мощный инструмент генерации кода искусственного интеллекта, который можно использовать бесплатно в дополнение к второму пилоту.

Машинное обучение Реальный бой LightGBM + настройка параметров случайного поиска: точность 96,67%

Бесшовная интеграция, мгновенный интеллект [1]: платформа больших моделей Dify-LLM, интеграция без кодирования и встраивание в сторонние системы, более 42 тысяч звезд, чтобы стать свидетелями эксклюзивных интеллектуальных решений.

LM Studio для создания локальных больших моделей

Как определить количество слоев и нейронов скрытых слоев нейронной сети?