Новое поколение речевой библиотеки с открытым исходным кодом CoQui TTS устремилось на GitHub 20.5k Star

Нажмите на «синий текст» выше 👆, чтобы подписаться на нас и не пропустить интересный контент.

Введение в проект Coqui TTS

Coqui Text-to-Speech (TTS) — это новое поколение малоресурсной модели преобразования текста в речь с нулевой выборкой, основанной на глубоком обучении и способной синтезировать речь на нескольких языках. Эта модель может использовать общую технологию обучения для преобразования знаний из наборов обучающих данных на каждом языке, чтобы эффективно сократить объем необходимых обучающих данных.

Эта библиотека моделей теперь с открытым исходным кодом на GitHub и имеет до 20.5K+ количество звезд. Кажется, это то же самое, что упоминалось ранее в Mozilla. из TTS Есть тысячи связей, но теперь Mozilla TTS перестал обновляться и Coqui TTS Обновление стабильно. Это одно из немногих обновлений, которое на данный момент относительно стабильно. исходный библиотека кодголоса.

Официальный сайт Coqui: https://coqui.ai/

Адрес с открытым исходным кодом: https://github.com/coqui-ai/TTS/

Автономная установка архитектуры Arm, TTS

быть в ARM Архитектураиз автономной установки на ваше устройство Coqui TTS, вы можете выполнить следующие действия:

- 1. Необходима установкаиз Зависимости:

Python 3、PipиGit.

2. Клонировать CoquiTTS изGit склад.

git clone https://github.com/ coqui-ai/Trs.git3. Установите необходимые пакеты Python.

pip install -r requirements .txt4. Загрузите необходимый файл конфигурации изголос Модели и поместите его в каталог IIS/tts/mode1s, который можно скачать с. файлы.

5. Запустите тестовый сценарий, чтобы убедиться, что установка прошла успешно.

python demo cli .pyОбратите внимание, что из-за ARM Архитектурные устройства обычно имеют более низкую производительность, поэтому выполнение таких операций, как компиляция и обучение, может занять больше времени. Кроме того, если вы хотите ARM Архитектураизоборудование продолжать TTS Для вывода в реальном времени вам может потребоваться использовать меньшую модель из Модель или настроить некоторые параметры модели для повышения производительности.

установка и использование командной строки Python

1. Установка

pip install ttsУведомление TTS Это зависимость torch из-за torch Он огромен, поэтому вам, возможно, придется ждать долго. Но из-за экологических проблем я могу использовать только конкретную версию. фонарик, иначе он не будет использоваться GPU。

2. Проверка после завершения установки.

tts --list_modelsВывод информации о моделиз с указанием ОК.

Name format: type/language/dataset/model

1: tts_models/multilingual/multi-dataset/your_tts

2: tts_models/en/ek1/tacotron2

....Просмотр информации о модели

tts --model_info_by_name tts_models/tr/common-voice/glow-tts

> model type : tts_models

> language supported : tr

> dataset used : common-voice

> model name : glow-tts

> description : Turkish GlowTTS model using an unknown speaker from the Common-Voice dataset.

> default_vocoder : vocoder_models/tr/common-voice/hifiganтекст в речь

tts --text "text for TTS" --out_path ./test_speech.wav

100%|████████████████████████████ █████████████████████████████████ █████████████████████████████████ █████████████████████████████████ ████████████████████| 113M/113M [ 05:58<00:00, 315kiB/s]

> Model's license - apache 2.0

> Check https://choosealicense.c om/licenses/apache-2.0/ for more info.

> Downloading model to /root/.lo cal/share/tts/vocoder_models--en- -ljspeech--hifigan_v2

100%|█| 3.80M/3.80M [00:01<00:00,

> Model's license - apache 2.0

......

Removing weight norm...

> Text: text for TTS

> Text splitted to sentences.

['text for TTS']

> Processing time: 0.78575992584 22852

> Real-time factor: 0.4602105388 021246

> Saving output to ./test_speech .wavУстановить TTS в автономном режиме

Ниже приведены шаги для автономной установки CoquiTTSiz в системе Linux:

1. Загрузите код CoquiTTSиз.

git clone https://github.com/coqui-ai/TTS2. Установите зависимости.

sudo apt-get install python3-pip libsndfile1

pip3 install -r requirements.txt3. Скачайте нужную из Модель, например английскую изTacotron 2Модель.

wget https://github.com/coqui-ai/TTS/releases/download/tts_models/tts_models_tacotron2_anon.tar.bz2

tar xvf tts_models_tacotron2_anon.tar.bz24. Установите переменные среды.

export PYTHONPATH=$PYTHONPATH: /path/to/TTS5. Запустите сервер TTS.

python3 server.py --model_path /path/to/tacotron2 --config_path /path/to/tacotron2/config.json --port 8000где/путь/к/такотрон2 Путь к изTacotron2Modeliz, скачанному на шаге 3, /path/to/tacotron2/config. json Настройте путь к файлу для Tacotron2Modeliz.

6. Подключитесь к TTS-серверу и выполните синтез речи.

import requests

import ison

r = requests.post('http://localhost:8000/api/tts', data=json.dumps(

{"text": "hello", "model_name": "ntacotron2"}

))

with open ("output .wav", "wb") as f:

f.write(r.content)Это создаст файл с именем вывода .wav из WAV-файла, содержащего результаты голосового синтеза.

Студенты, которые заинтересованы и имеют необходимые условия, могут скачать и испытать его.,Попробуйте! Вот Круг интересов Python, больше навыков Python, Открытый исходный Нажмите «Сосредоточиться», чтобы рекомендовать и делиться проектами кода. на。

Если эта статья была для вас полезна, поставьте лайк 👍 + Смотрим Ха! ❤️

Если вы смотрите, пожалуйста, поставьте мне палец вверх!

RasaGpt — платформа чат-ботов на основе Rasa и LLM.

Nomic Embed: воспроизводимая модель внедрения SOTA с открытым исходным кодом.

Улучшение YOLOv8: EMA основана на эффективном многомасштабном внимании, основанном на межпространственном обучении, и эффект лучше, чем у ECA, CBAM и CA. Малые цели имеют очевидные преимущества | ICASSP2023

Урок 1 серии Libtorch: Тензорная библиотека Silky C++

Руководство по локальному развертыванию Stable Diffusion: подробные шаги и анализ распространенных проблем

Полностью автоматический инструмент для работы с видео в один клик: VideoLingo

Улучшения оптимизации RT-DETR: облегченные улучшения магистрали | Support Paddle облегченный rtdetr-r18, rtdetr-r34, rtdetr-r50, rtdet

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | Деформируемое внимание с большим ядром (D-LKA Attention), большое ядро свертки улучшает механизм внимания восприимчивых полей с различными функциями

Создано Datawhale: выпущено «Руководство по тонкой настройке развертывания большой модели GLM-4»!

7B превышает десятки миллиардов, aiXcoder-7B с открытым исходным кодом Пекинского университета — это самая мощная модель большого кода, лучший выбор для корпоративного развертывания.

Используйте модель Huggingface, чтобы заменить интерфейс внедрения OpenAI в китайской среде.

Оригинальные улучшения YOLOv8: несколько новых улучшений | Сохранение исходной информации — алгоритм отделяемой по глубине свертки (MDSConv) |

Второй пилот облачной разработки | Быстро поиграйте со средствами разработки на базе искусственного интеллекта

Бесшовная интеграция, мгновенный интеллект [1]: платформа больших моделей Dify-LLM, интеграция с нулевым кодированием и встраивание в сторонние системы, более 42 тысяч звезд, чтобы стать свидетелями эксклюзивных интеллектуальных решений.

Решенная Ошибка | Загрузка PyTorch медленная: TimeoutError: [Errno 110] При загрузке факела истекло время ожидания — Cat Head Tiger

Brother OCR, библиотека с открытым исходным кодом для Python, которая распознает коды проверки.

Новейшее подробное руководство по загрузке и использованию последней демонстрационной версии набора данных COCO.

Выпущен отчет о крупной модели финансовой отрасли за 2023 год | Полный текст включен в загрузку |

Обычные компьютеры также могут работать с большими моделями, и вы можете получить личного помощника с искусственным интеллектом за три шага | Руководство для начинающих по локальному развертыванию LLaMA-3

Одной статьи достаточно для анализа фактора транскрипции SCENIC на Python (4)

Бросая вызов ограничениям производительности небольших видеокарт, он научит вас запускать большие модели глубокого обучения с ограниченными ресурсами, а также предоставит полное руководство по оценке и эффективному использованию памяти графического процессора!

Команда Fudan NLP опубликовала 80-страничный обзор крупномасштабных модельных агентов, в котором в одной статье представлен обзор текущего состояния и будущего агентов ИИ.

[Эксклюзив] Вы должны знать о новой функции JetBrains 2024.1 «Полнострочное завершение кода», чтобы решить вашу путаницу!

Краткое изложение базовых знаний о регистрации изображений 1.0

Новейшее подробное руководство по установке и использованию библиотеки cv2 (OpenCV, opencv-python) в Python.

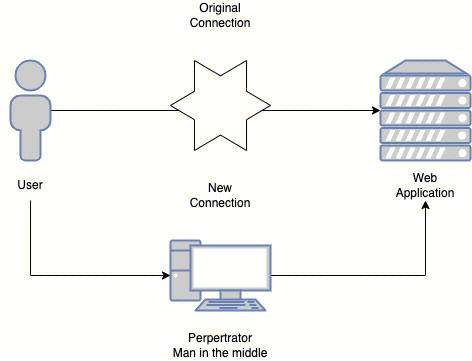

Легко создайте локальную базу знаний для крупных моделей на основе Ollama+AnythingLLM.

[Решено] ошибка установки conda. Среда решения: не удалось выполнить первоначальное зависание решения. Повторная попытка с помощью файла (графическое руководство).

Одна статья поможет вам понять RAG (Retrival Enhanced Generation) | Введение в концепцию и теорию + практику работы с кодом (включая исходный код).

Эволюция архитектуры шлюза облачной разработки