Локальное развертывание Llama3, самой мощной в истории большой модели с открытым исходным кодом, за 5 минут.

Несколько дней назад компания Meta выпустила Llama3, самую мощную большую модель с открытым исходным кодом в истории. Если вы хотите использовать Llama3 бесплатно, а также использовать ее онлайн на официальном сайте https://llama.meta.com/llama3/. , вы также можете развернуть его локально.

Существует множество способов локального развертывания. Ниже приведены три распространенных способа:

1. После клонирования хранилища GitHub установите пакеты, связанные с Python и PIP, по адресу https://github.com/meta-llama/llama3. Введите личную информацию онлайн на официальном сайте, чтобы подать заявку на ссылку для скачивания модели.

2. LM-studio

3. ollama

Среди них развертывание олламы является наиболее удобным и дружелюбным, а время развертывания может быть завершено в течение 5 минут. В этой статье описывается локальное развертывание модели llama3 в компании ollama.

Шаг 1. Загрузите ollama с официального сайта ollama (https://ollama.com/download). Существует три версии для Mac, Windows и Linux. Выберите версию, подходящую для вашего компьютера, загрузите и установите ее.

Шаг 2. Выполните команду ollama, запустите llama3 в командной строке (по умолчанию загружается модель 8b, если вы хотите загрузить модель 70b, выполните команду ollama, запустите llama3:70b)

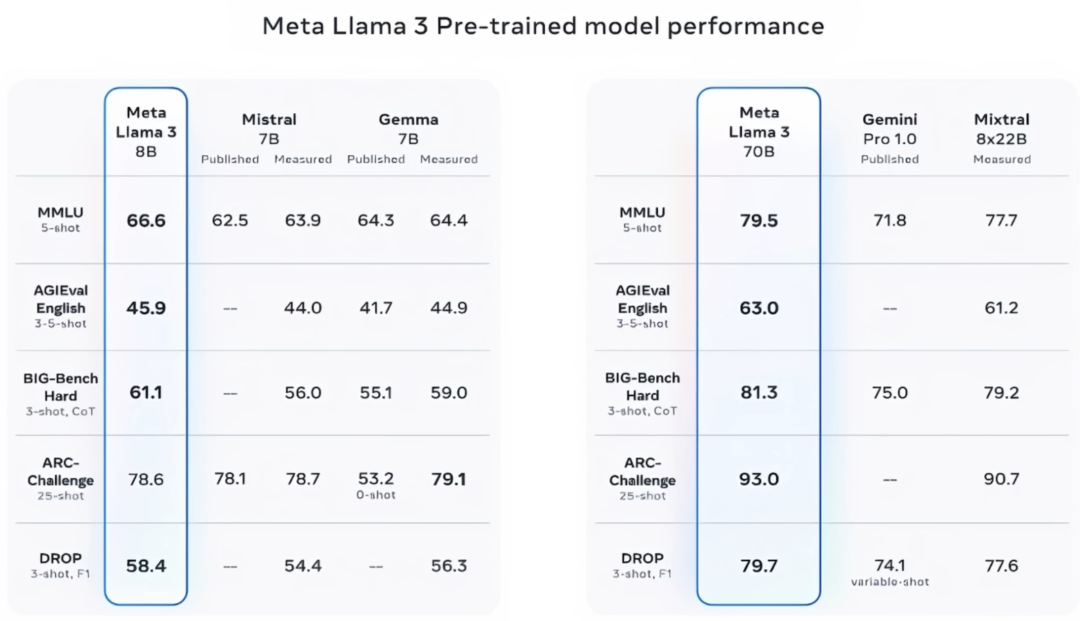

Самые маленькие версии Llama3, 8B и 70B, уже полностью опережают большие модели с открытым исходным кодом других конкурентов. Среди них модель 70B эквивалентна уровню GPT-4. И 8B, и 70B можно запускать на персональном ПК. 8B — это модель с 8 миллиардами параметров, для бесперебойной работы которой требуется только видеопамять 8G+. с 70 миллиардами параметров. Хотя утверждается, что для него требуется видеопамять 40 ГБ+, было проверено, что он может работать на персональном компьютере с видеопамятью 16 ГБ, но скорость произнесения ниже.

После загрузки модели вы войдете в интерактивный интерфейс командной строки и в это время сможете общаться с llama3.

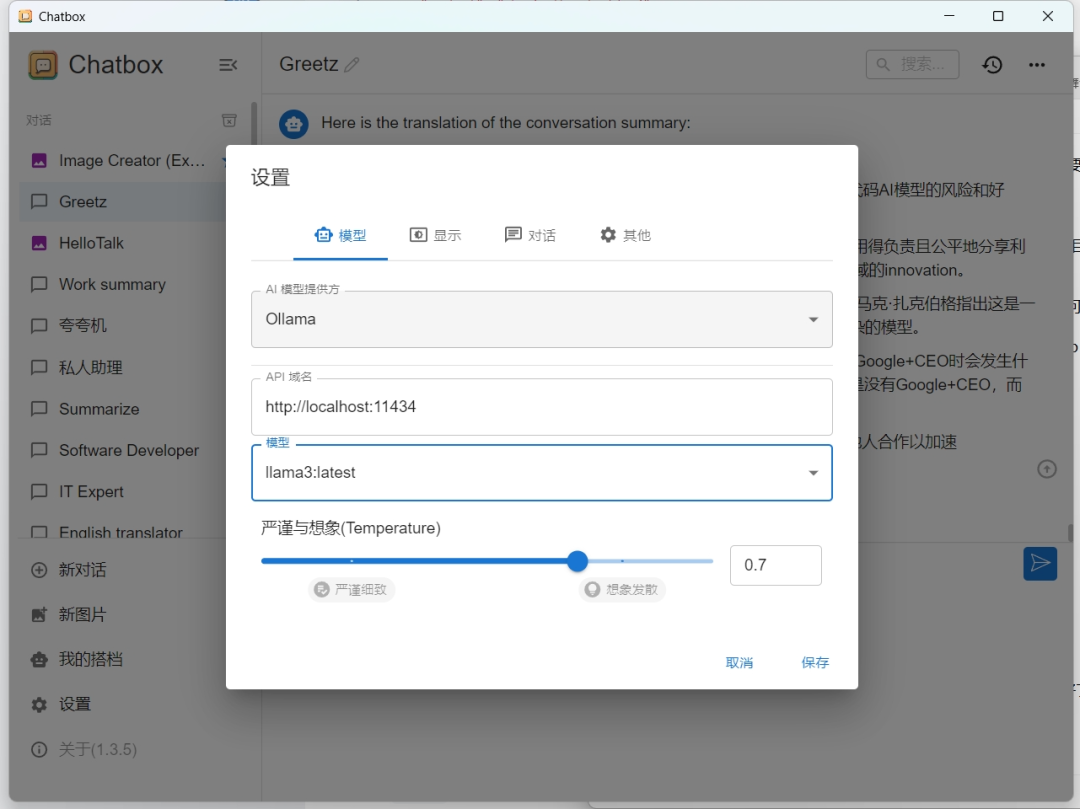

шаг 3 (необязательно): В конце концов, взаимодействие с командной строкой не так удобно, как с графическим интерфейсом. Вы можете выбрать любой интерфейс. В настоящее время на рынке существует очень много интерфейсов. В качестве примера мы возьмем чат-окно с открытым исходным кодом: https://github.com/Bin-Huang/chatbox/releases.

После скачивания и установки войдите в настройки и настройте модель llama3 с помощью локальной олламы, и тогда вы сможете счастливо общаться.

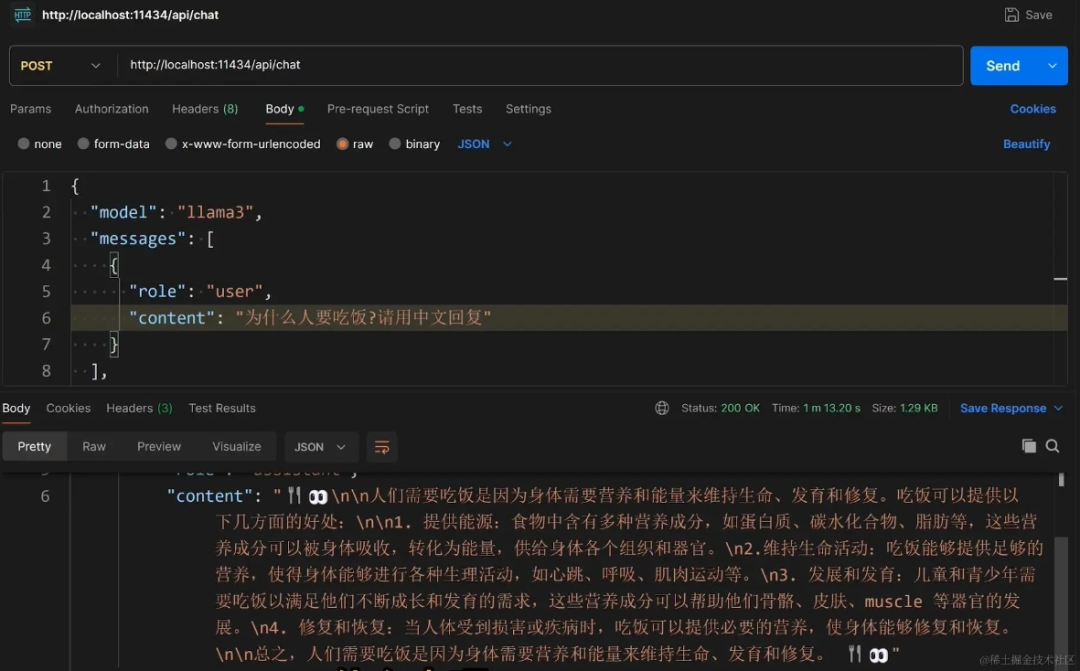

Помимо общения с Llama3 через графический интерфейс, вы также можете программно вызывать rest API Llama3, автоматически позволяя ИИ выполнять множество локальных задач.

Чтобы вызвать rest api llama3, обратитесь к инструкциям официального сайта: https://github.com/ollama/ollama/blob/main/docs/api.md

curl http://localhost:11434/api/chat -d '{

"model": "llama3",

"messages": [

{

"role": "user",

"content": "why is the sky blue?"

}

],

"stream": false

}'

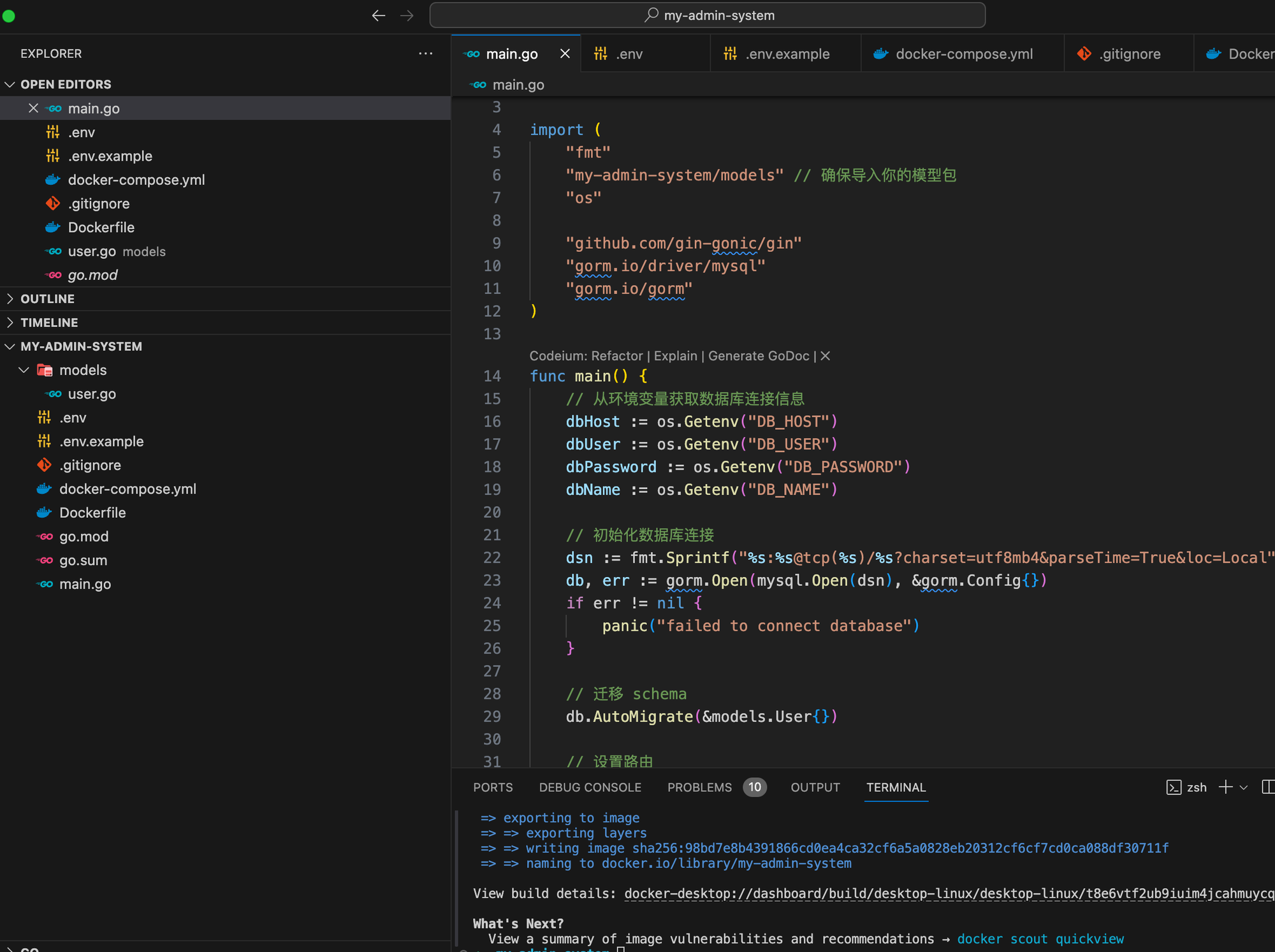

На основе языка Go мы шаг за шагом научим вас внедрять структуру системы управления серверной частью.

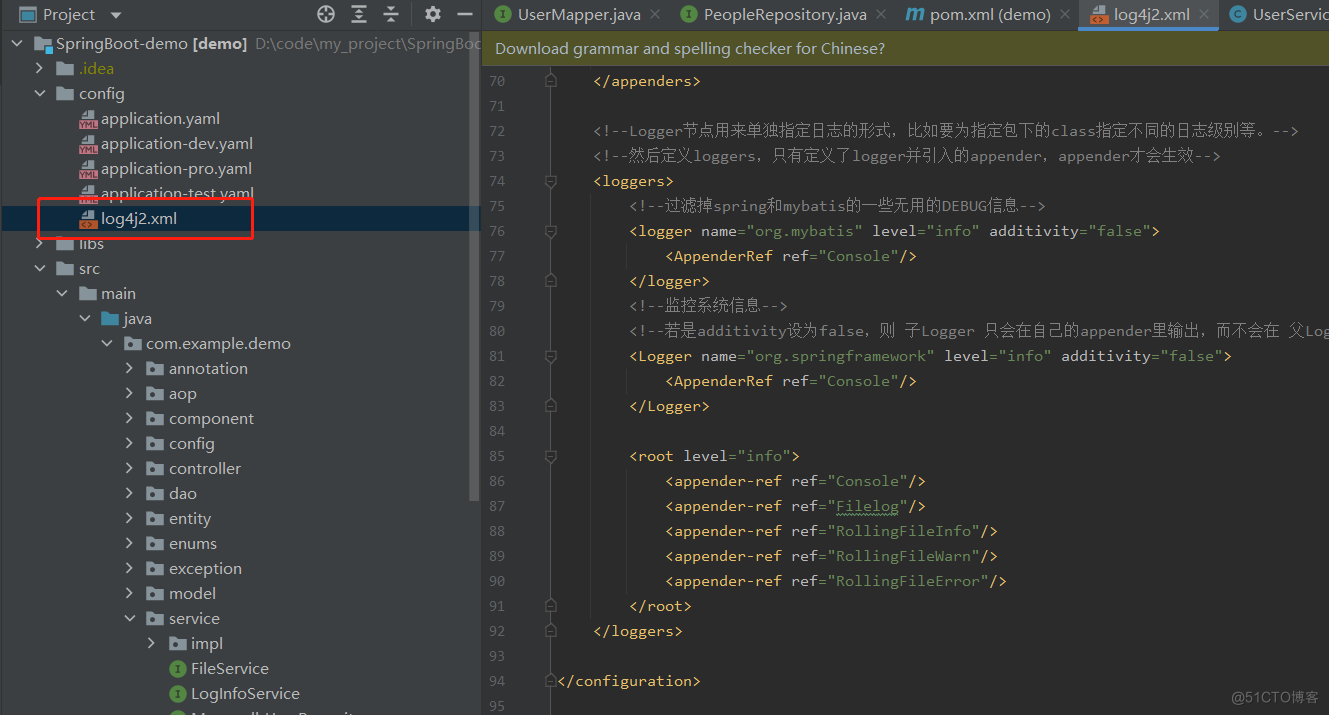

Эффективное управление журналами с помощью Spring Boot и Log4j2: подробное объяснение конфигурации

Что делать, если telnet не является внутренней или внешней командой [легко понять]

php-объект для анализа json_php json

Введение в принцип запуска Springboot, процесс запуска и механизм запуска.

Высокоуровневые операции Mongo, если данные не существуют, вставка и обновление, если они существуют (pymongo)

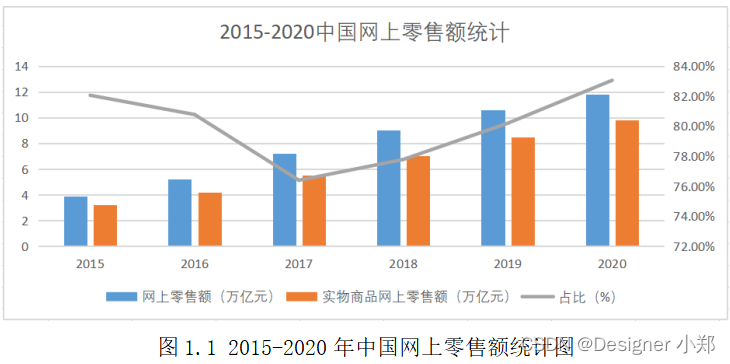

Проектирование и внедрение системы управления электронной коммерцией на базе Vue и SpringBoot.

Статья длиной в 9000 слов знакомит вас с процессом запуска SpringBoot — самым подробным процессом запуска SpringBoot в истории — с изображениями и текстом.

Как настроить размер экрана в PR. Учебное пособие по настройке размера видео в PR [подробное объяснение]

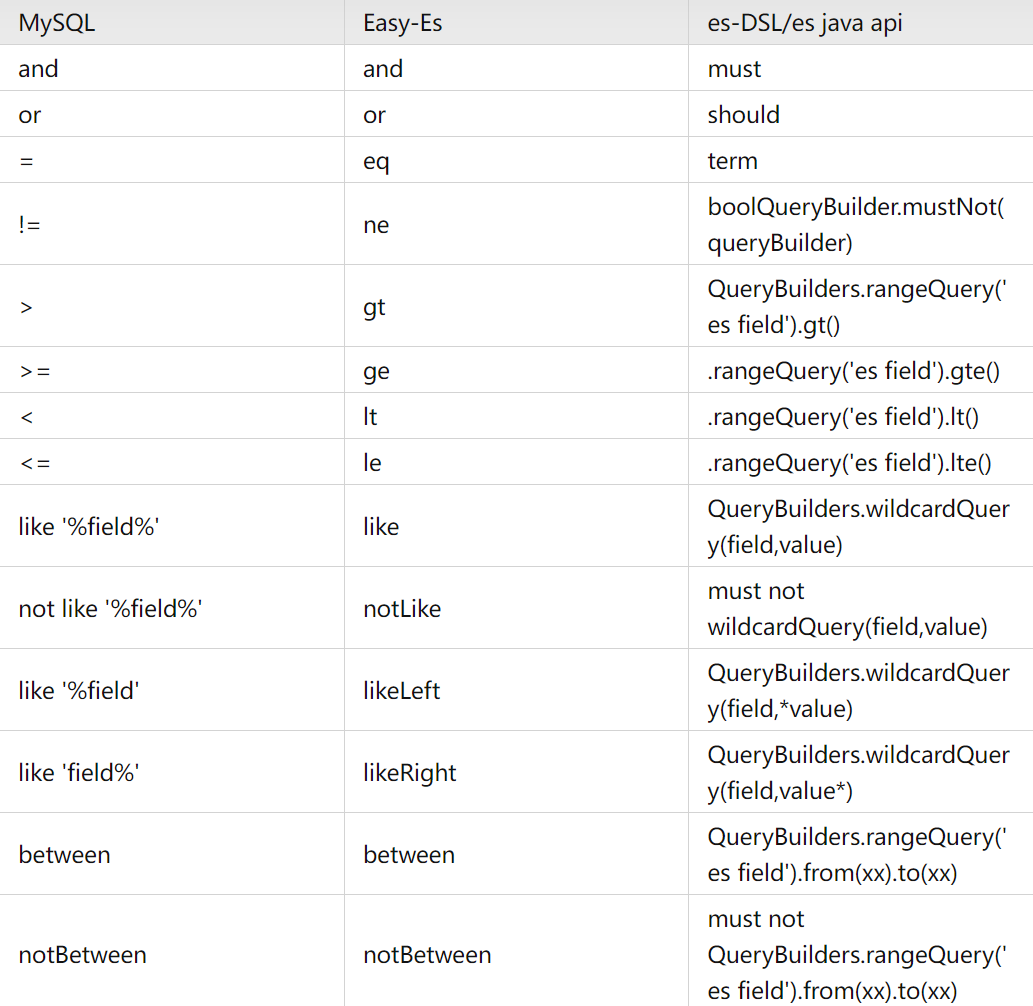

Элегантный и мощный: упростите операции ElasticSearch с помощью easy-es

Проект аутентификации по микросервисному токену: концепция и практика

【Java】Решено: org.springframework.http.converter.HttpMessageNotWritableException.

Изучите Kimi Smart Assistant: как использовать сверхдлинный текст, чтобы открыть новую сферу эффективной обработки информации

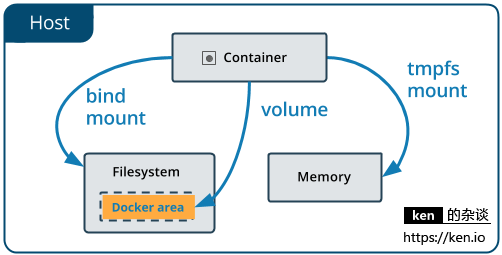

Начало работы с Docker: использование томов данных и монтирования файлов для хранения и совместного использования данных

Использование Python для реализации автоматической публикации статей в публичном аккаунте WeChat

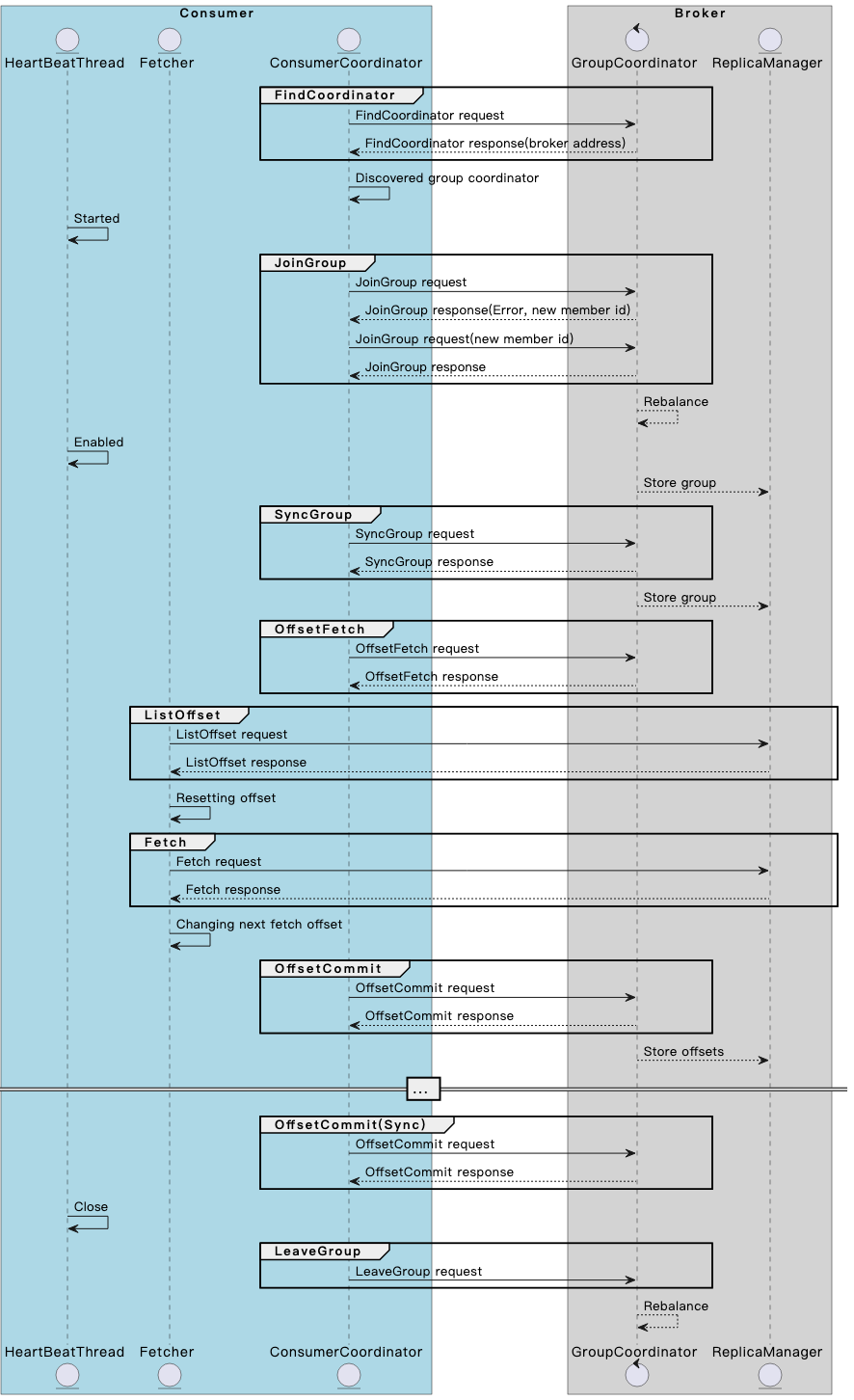

Разберитесь в механизме и принципах взаимодействия потребителя и брокера Kafka в одной статье.

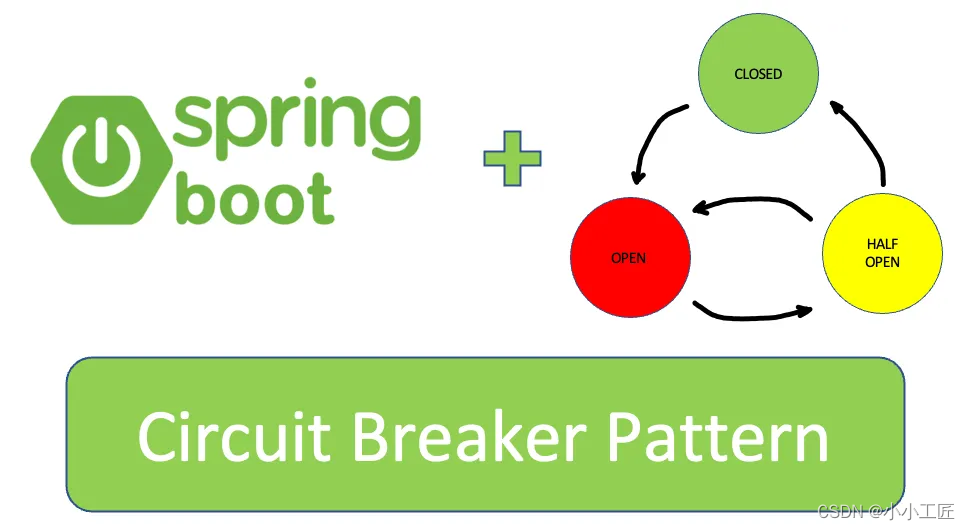

Spring Boot — использование Resilience4j-Circuitbreaker для реализации режима автоматического выключателя_предотвращения каскадных сбоев

13. Springboot интегрирует Protobuf

Примечание. Инструмент управления батареями Dell Dell Power Manager

Общая интерпретация класса LocalDate [java]

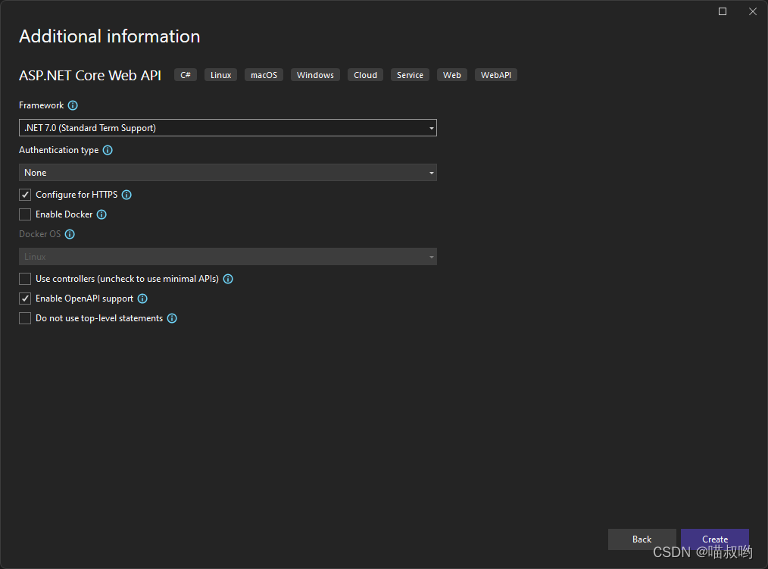

[Базовые знания ASP.NET Core] -- Веб-API -- Создание и настройка веб-API (1)

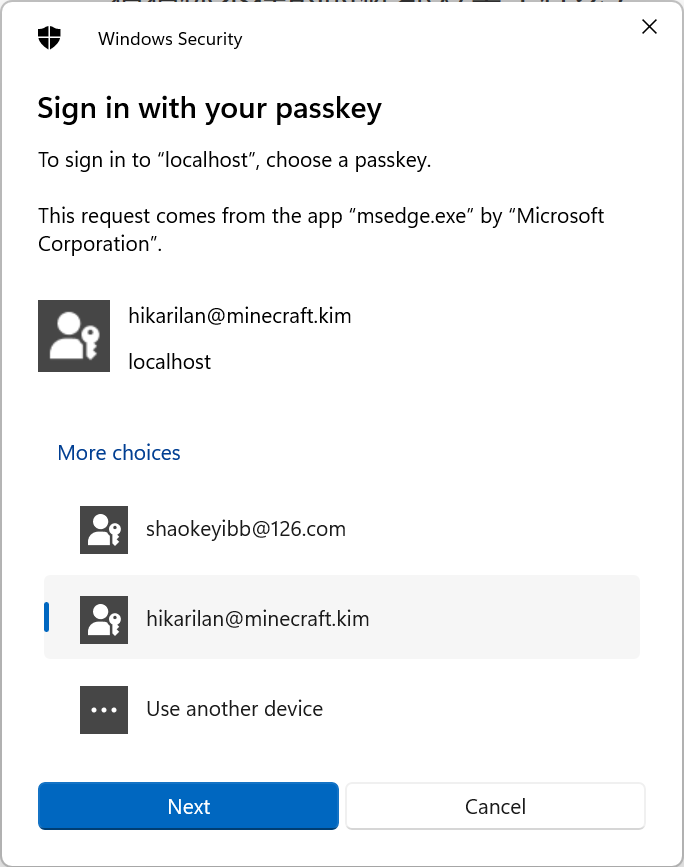

Настоящий бой! Подключите Passkey к своему веб-сайту для безопасного входа в систему без пароля.

Руководство по настройке Nginx: как найти, интерпретировать и оптимизировать настройки Nginx в Linux

Typecho отображает использование памяти сервера

Как вставить элемент перед указанным ключом в ассоциативный массив в PHP

swagger2 экспортирует API как текстовый документ (реализация Java) [легко понять]

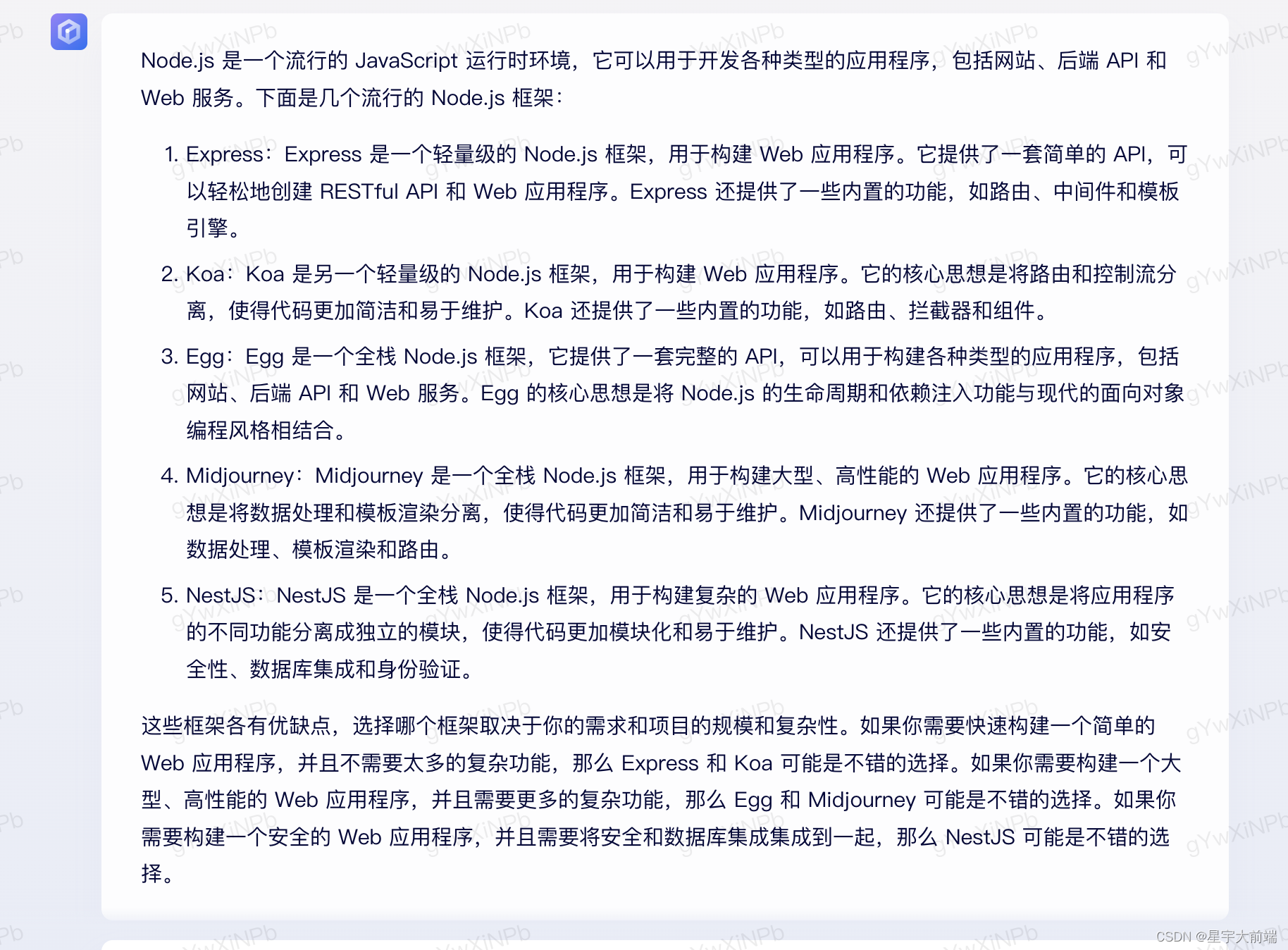

Выбор фреймворка nodejs Express koa egg MidwayJS сравнение NestJS

Руководство по загрузке, установке и использованию SVN «Рекомендуемая коллекция»

Интерфейс PHPforwarding_php отправляет запрос на получение