Llama3.1 Развертывание приложения местной базы знаний

1. Знакомство с окружающей средой

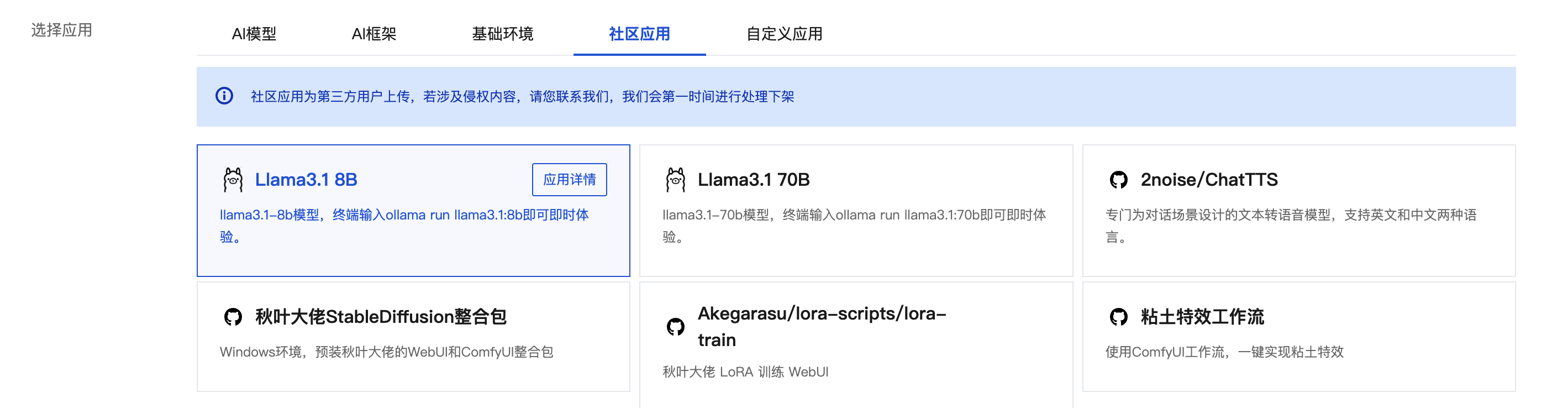

Служба высокопроизводительных приложений HAI имеет богатый набор предустановленных приложений, которые могут быстро превратить передовые модели сообщества с открытым исходным кодом в ваши собственные методы развертывания, которые можно запускать и использовать «из коробки» всего одним щелчком мыши. Теперь поддерживается поиск входа в такие приложения, как Llama 3.1, в приложении сообщества на странице покупки HAI. После простого выбора вы можете запустить сервис вывода одним щелчком мыши.

Знакомство с проектом чата

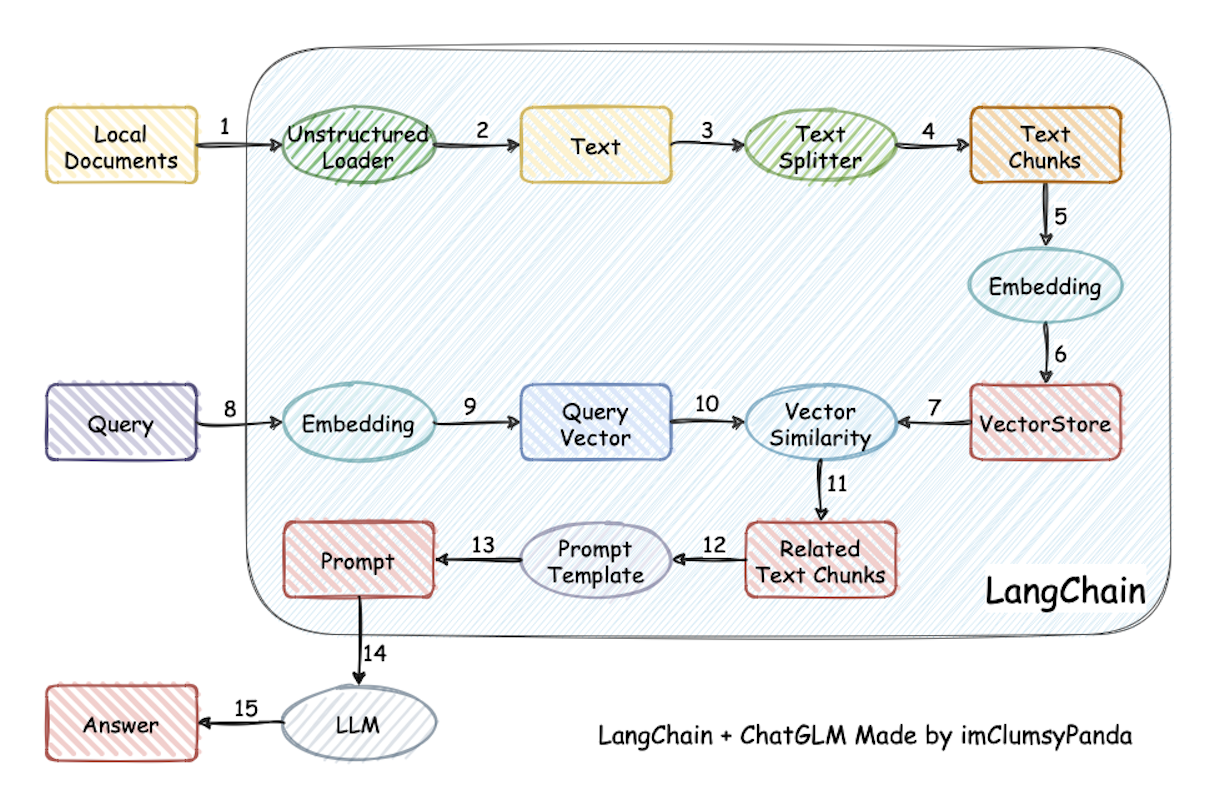

В этом проекте используются идеи Лангчейна для реализации приложения вопросов и ответов на основе местной базы знаний. Поддерживает основной поток с открытым исходным кодом на рынке. LLM、 Embedding База данных моделей и векторов,Все доступноОткрытый исходный кодМодельАвтономное частное развертывание。в то же время,Проект также поддерживает вызов OpenAI GPT API.

Принцип реализации проекта показан на рисунке ниже. Процесс включает в себя загрузку файлов. -> читать текст -> сегментация текста -> Векторизация текста -> векторизация вопросов -> Сопоставьте текстовый вектор, который наиболее похож на вектор вопроса. top к -> Соответствующий текст добавляется в качестве контекста вместе с вопросом. в оперативном режиме -> Отправить в LLM генерирует ответы.

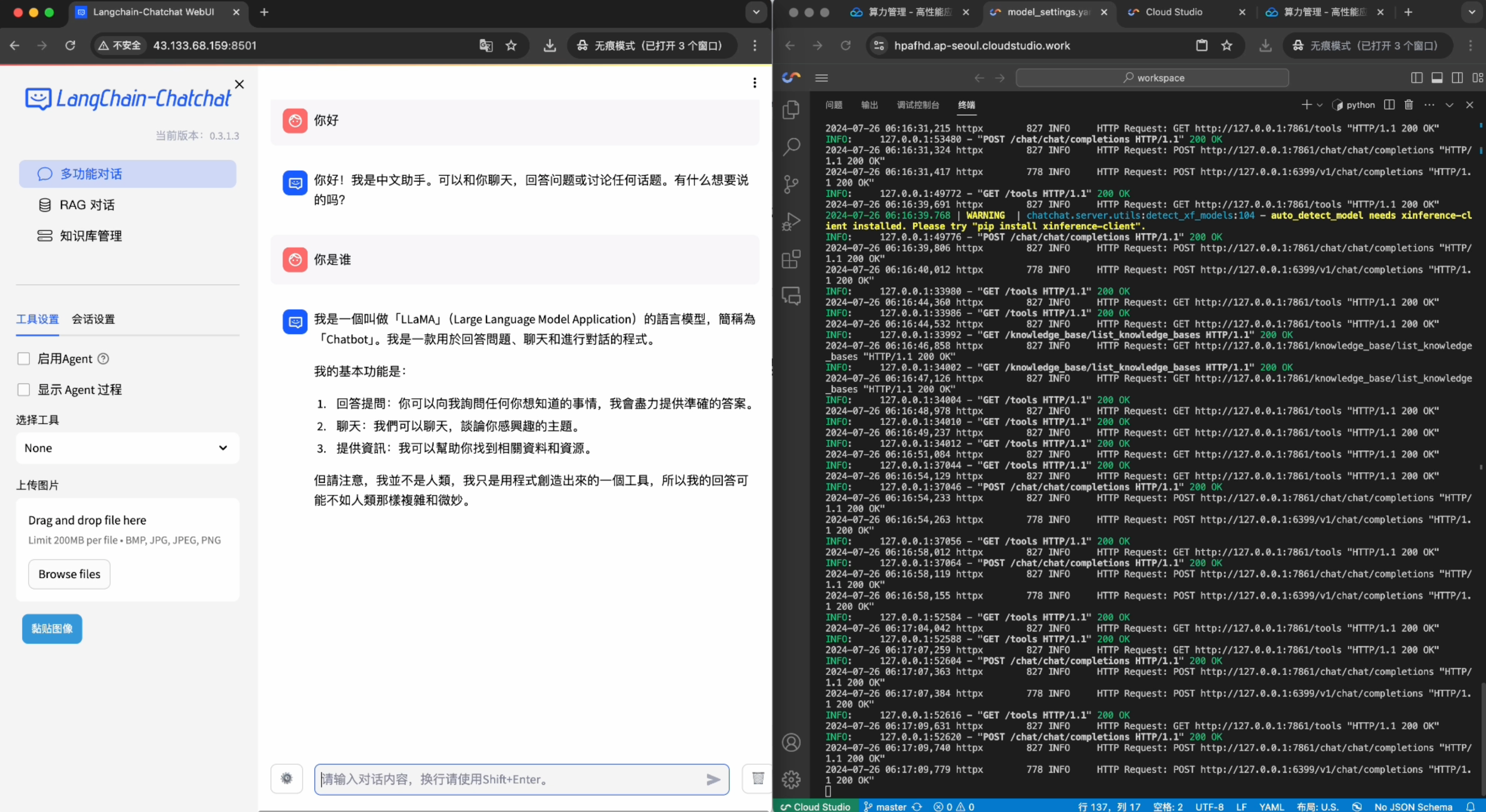

Отображение эффекта завершения развертывания

2. Инструкция по применению

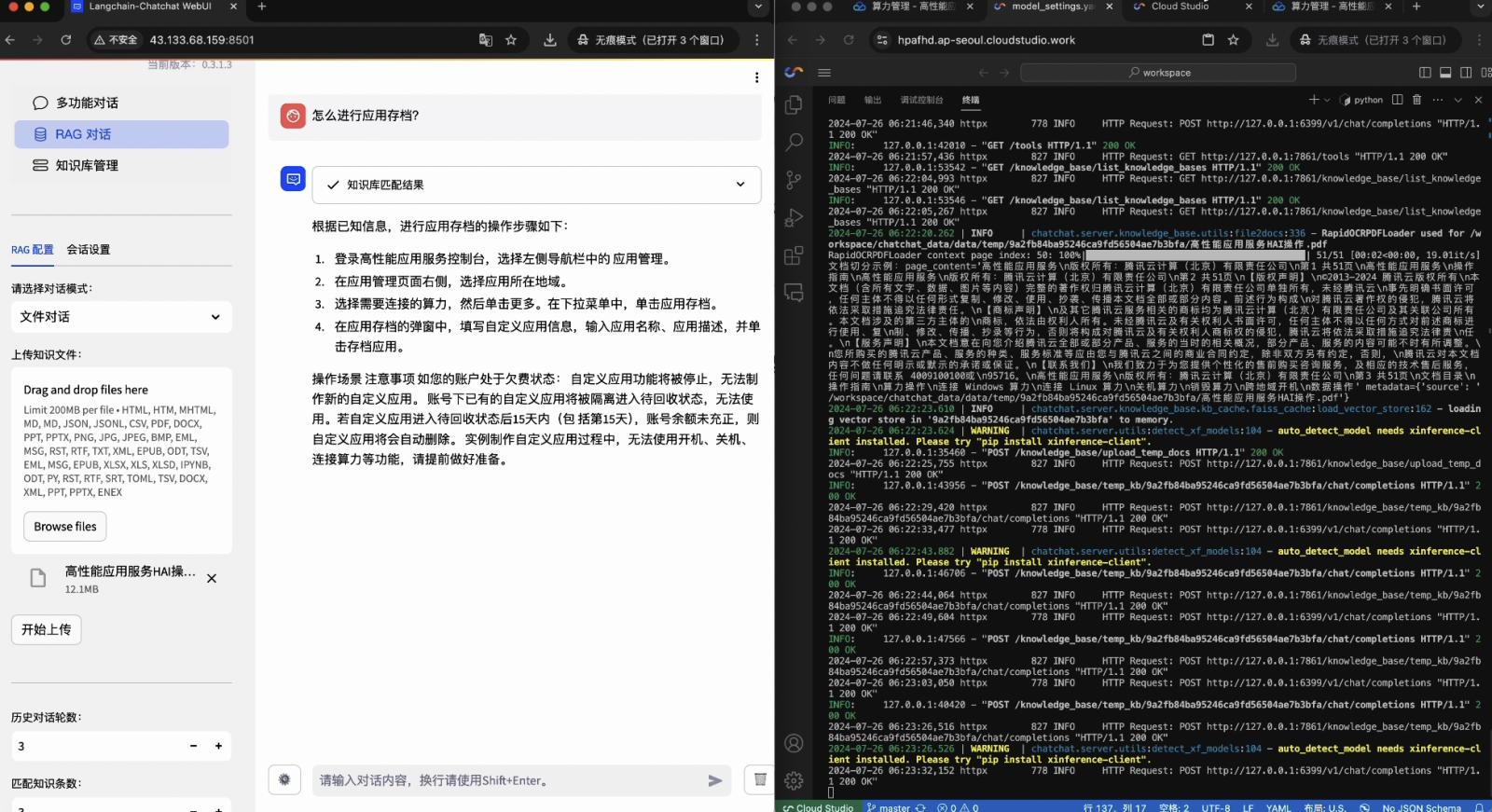

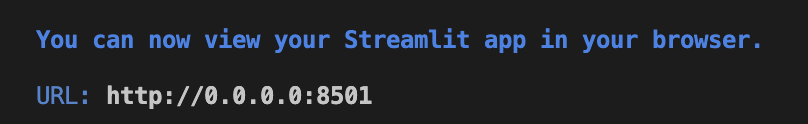

1. Войдите на страницу покупки HAI, выберите приложение сообщества «Langchain-Chachat-llama3.1» и создайте экземпляр. После создания экземпляра нажмите на метод подключения вычислительной мощности, выберите jupyterlab и войдите в терминал. Скопируйте и вставьте приведенный ниже код в терминал и нажмите Enter для выполнения. Когда вы увидите содержимое, показанное на рисунке ниже, это означает, что запуск приложения завершен.

export CHATCHAT_ROOT=/root/chatchat_data

chatchat init

chatchat kb -r

chatchat start -a

2. Используйте общедоступный IP-адрес экземпляра вместо 0.0.0.0 в URL-адресе и вставьте его в панель навигации, чтобы получить к нему доступ. Локальные файлы могут быть загружены по запросу для взаимодействия с вопросами и ответами.

Приложение: Несколько поз для использования llama3.1 на HAI

Тестирование модели

Вы можете быстро протестировать эффективность модели вопросов и ответов на основе базовой среды llama3.1 в HAI.

Тонкая настройка

Путем дальнейшего обучения модели llama3.1 на данных для конкретной задачи или области сделайте ее более подходящей для конкретных приложений. Например, текстовые данные, специфичные для предметной области, можно использовать для точной настройки модели для повышения ее производительности в этой предметной области.

Mount RAG (дополненная генерация извлечения)

Сочетание технологии поиска информации и технологии генерации позволяет модели извлекать соответствующую информацию и генерировать более точные ответы при ответе на вопросы. Этот подход обычно используется для задач, требующих получения точной информации в режиме реального времени.

Интеграция внешних баз знаний

Объединение моделей с внешними базами знаний, такими как графики знаний, позволяет им использовать структурированные данные для предоставления более точных и полных ответов.

Более

Разработайте агент на основе llama3.1, разверните его в HAI в виде API и подключите к своему приложению, чтобы облегчить разработку приложения.

Учебное пособие по Jetpack Compose для начинающих, базовые элементы управления и макет

Код js веб-страницы, фон частицы, код спецэффектов

【новый! Суперподробное】Полное руководство по свойствам компонентов Figma.

🎉Обязательно к прочтению новичкам: полное руководство по написанию мини-программ WeChat с использованием программного обеспечения Cursor.

[Забавный проект Docker] VoceChat — еще одно приложение для мгновенного чата (IM)! Может быть встроен в любую веб-страницу!

Как реализовать переход по странице в HTML (html переходит на указанную страницу)

Как решить проблему зависания и низкой скорости при установке зависимостей с помощью npm. Существуют ли доступные источники npm, которые могут решить эту проблему?

Серия From Zero to Fun: Uni-App WeChat Payment Practice WeChat авторизует вход в систему и украшает страницу заказа, создает интерфейс заказа и инициирует запрос заказа

Серия uni-app: uni.navigateЧтобы передать скачок значения

Апплет WeChat настраивает верхнюю панель навигации и адаптируется к различным моделям.

JS-время конвертации

Обеспечьте бесперебойную работу ChromeDriver 125: советы по решению проблемы chromedriver.exe не найдены

Поле комментария, щелчок мышью, специальные эффекты, js-код

Объект массива перемещения объекта JS

Как открыть разрешение на позиционирование апплета WeChat_Как использовать WeChat для определения местонахождения друзей

Я даю вам два набора из 18 простых в использовании фонов холста Power BI, так что вам больше не придется возиться с цветами!

Получить текущее время в js_Как динамически отображать дату и время в js

Вам необходимо изучить сочетания клавиш vsCode для форматирования и организации кода, чтобы вам больше не приходилось настраивать формат вручную.

У ChatGPT большое обновление. Всего за 45 минут пресс-конференция показывает, что OpenAI сделал еще один шаг вперед.

Copilot облачной разработки — упрощение разработки

Микросборка xChatGPT с низким кодом, создание апплета чат-бота с искусственным интеллектом за пять шагов

CUDA Out of Memory: идеальное решение проблемы нехватки памяти CUDA

Анализ кластеризации отдельных ячеек, который должен освоить каждый&MarkerгенетическийВизуализация

vLLM: мощный инструмент для ускорения вывода ИИ

CodeGeeX: мощный инструмент генерации кода искусственного интеллекта, который можно использовать бесплатно в дополнение к второму пилоту.

Машинное обучение Реальный бой LightGBM + настройка параметров случайного поиска: точность 96,67%

Бесшовная интеграция, мгновенный интеллект [1]: платформа больших моделей Dify-LLM, интеграция без кодирования и встраивание в сторонние системы, более 42 тысяч звезд, чтобы стать свидетелями эксклюзивных интеллектуальных решений.

LM Studio для создания локальных больших моделей

Как определить количество слоев и нейронов скрытых слоев нейронной сети?