Контрастная потеря

Contrastive Loss(Потеря контраста) — разновидность функции потерь, обычно используемая для тренировки контрастного обучения (Contrastive Модели обучения, предназначенные для изучения сходств и различий в данных. В этой статье записан соответствующий контент.

Введение

Contrastive Loss(Потеря контраста) — разновидность функции потерь, обычно используемая для тренировки контрастного обучения (Contrastive Модели обучения, предназначенные для изучения сходств и различий в данных. Основная цель контрастного обучения — сопоставить похожие пары образцов с близкими местоположениями и несходные пары образцов с удаленными местами. Контрастный Loss помогите достичь этой цели.

Контрастную потерю можно рассматривать как тип потери рейтинга. Когда мы обычно выполняем задачи ML, наиболее часто используемыми являются потеря перекрестной энтропии или потеря MSE. Должна быть четкая цель, например, определенное значение или определенная классификационная категория. Но потеря рейтинга на самом деле является своего рода обучением показателям. Они изучают относительные расстояния и корреляции, но не очень заботятся о конкретных значениях.

Потеря контраста

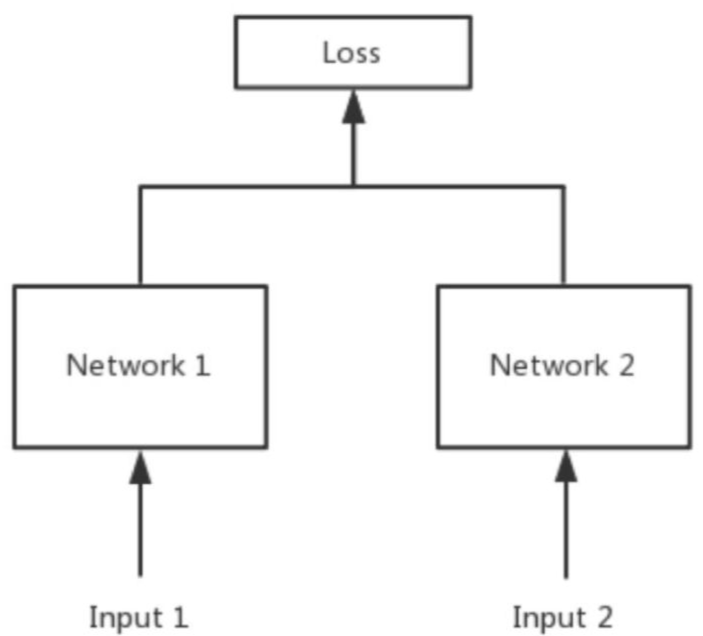

Потеря контраста чаще всего используется в сети близнецов (сиамские сеть), эта функция потерь может эффективно обрабатывать парную нейронную сеть Связь между данными (формально это не обязательно должно быть две Сети, это может быть и одна Сеть и два Выхода. Можно считать, что Сеть1 и 2 на приведенной схеме одинаковые или не одинаковые). контрастный Выражение потерь следующее:

в

Эта функция потерь была первоначально получена из «Уменьшения размерности» Янна Лекуна путем изучения инвариантного отображения. Она в основном используется при уменьшении размерности, то есть после уменьшения размерности (извлечения признаков) исходно похожих выборок в пространстве признаков два образца по-прежнему остаются похожими. ; хотя исходно несходные выборки, после уменьшения размерности эти две выборки все еще различаются в пространстве признаков.

Наблюдая за выражением контрастной потери выше, мы можем обнаружить, что эта функция потерь может хорошо выражать степень совпадения парных выборок, а также может быть хорошо использована для обучения моделей для извлечения признаков.

- когда y=1 (т.е. когда выборки похожи), остается только функция потерь ∑ y d^ 2 ,То есть исходный аналогичный образец,Если евклидово расстояние в пространстве признаков велико,Это значит, что когда до из Модель это не хорошо,тем самым увеличивая потери.

- когда y=0 (то есть выборки не похожи), функция потерь равна ∑ ( 1 − y )\max ( m a r g i n − d , 0 ) ^2 ,То есть, когда образцы не похожи,Его характерное пространство меньше евклидова расстояния.,Сумма потерь станет больше,Это также точно символизирует наши требования.

в margin является суперпараметром, который эквивалентен заданию loss 定了一个上界(margin квадрат), если d Больше или равно margin ,Тогда это значит, что уже очень хорошо.,loss=0 。

На рисунке ниже показана связь между значением потерь и евклидовым расстоянием выборочного объекта.,Красная пунктирная линия указывает на то, что из — величина потерь аналогичных образцов.,Синяя сплошная линия представляет значение потерь разнородных образцов.

Contrastive Loss Цель состоит в том, чтобы свести к минимуму расстояние или сходство между парами положительных образцов, гарантируя при этом, что расстояние или сходство между парами отрицательных образцов превышает определенный порог. margin . Таким образом, модель учится лучше различать похожие и непохожие образцы в пространстве внедрения.

Ссылки

Ссылка на статью: https://cloud.tencent.com/developer/article/2372744

Неразрушающее увеличение изображений одним щелчком мыши, чтобы сделать их более четкими артефактами искусственного интеллекта, включая руководства по установке и использованию.

Копикодер: этот инструмент отлично работает с Cursor, Bolt и V0! Предоставьте более качественные подсказки для разработки интерфейса (создание навигационного веб-сайта с использованием искусственного интеллекта).

Новый бесплатный RooCline превосходит Cline v3.1? ! Быстрее, умнее и лучше вилка Cline! (Независимое программирование AI, порог 0)

Разработав более 10 проектов с помощью Cursor, я собрал 10 примеров и 60 подсказок.

Я потратил 72 часа на изучение курсорных агентов, и вот неоспоримые факты, которыми я должен поделиться!

Идеальная интеграция Cursor и DeepSeek API

DeepSeek V3 снижает затраты на обучение больших моделей

Артефакт, увеличивающий количество очков: на основе улучшения характеристик препятствия малым целям Yolov8 (SEAM, MultiSEAM).

DeepSeek V3 раскручивался уже три дня. Сегодня я попробовал самопровозглашенную модель «ChatGPT».

Open Devin — инженер-программист искусственного интеллекта с открытым исходным кодом, который меньше программирует и больше создает.

Эксклюзивное оригинальное улучшение YOLOv8: собственная разработка SPPF | SPPF сочетается с воспринимаемой большой сверткой ядра UniRepLK, а свертка с большим ядром + без расширения улучшает восприимчивое поле

Популярное и подробное объяснение DeepSeek-V3: от его появления до преимуществ и сравнения с GPT-4o.

9 основных словесных инструкций по доработке академических работ с помощью ChatGPT, эффективных и практичных, которые стоит собрать

Вызовите deepseek в vscode для реализации программирования с помощью искусственного интеллекта.

Познакомьтесь с принципами сверточных нейронных сетей (CNN) в одной статье (суперподробно)

50,3 тыс. звезд! Immich: автономное решение для резервного копирования фотографий и видео, которое экономит деньги и избавляет от беспокойства.

Cloud Native|Практика: установка Dashbaord для K8s, графика неплохая

Краткий обзор статьи — использование синтетических данных при обучении больших моделей и оптимизации производительности

MiniPerplx: новая поисковая система искусственного интеллекта с открытым исходным кодом, спонсируемая xAI и Vercel.

Конструкция сервиса Synology Drive сочетает проникновение в интрасеть и синхронизацию папок заметок Obsidian в облаке.

Центр конфигурации————Накос

Начинаем с нуля при разработке в облаке Copilot: начать разработку с минимальным использованием кода стало проще

[Серия Docker] Docker создает мультиплатформенные образы: практика архитектуры Arm64

Обновление новых возможностей coze | Я использовал coze для создания апплета помощника по исправлению домашних заданий по математике

Советы по развертыванию Nginx: практическое создание статических веб-сайтов на облачных серверах

Feiniu fnos использует Docker для развертывания личного блокнота Notepad

Сверточная нейронная сеть VGG реализует классификацию изображений Cifar10 — практический опыт Pytorch

Начало работы с EdgeonePages — новым недорогим решением для хостинга веб-сайтов

[Зона легкого облачного игрового сервера] Управление игровыми архивами