Как следует тестировать искусственный интеллект? (8) Тестирование интеллектуального обслуживания клиентов на уровне предприятия RAG большой модели

Недостатки больших моделей – иллюзии

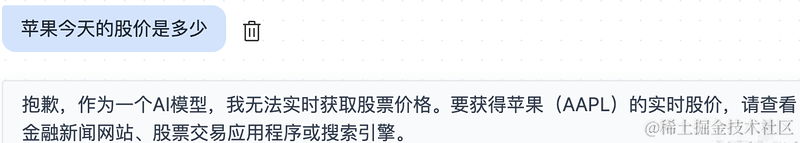

Связались GPT Все, кто изучает такие большие модели продуктов, должны знать силу больших моделей. Многие люди должныдразнитьПроходить GPT, следуйте GPT Много говорил. Как разговорный робот для общественности, GPT Это, очевидно, выдающийся игрок, и я не видел в мире никого, кто мог бы сравниться с ним. GPT Существование армрестлинга. Возможно, многие думают GPT Это очень мощный разговорный робот. Он предлагает насыщенные часы обучения и может отвечать на вопросы в любой области. Но на самом деле, как я сказал в своем последнем посте, Хотя кажется, что эта большая модель способна ответить на любой вопрос, на самом деле она не способна дать профессиональные и точные ответы в конкретных областях. Например, мы спрашиваем большую модель BMW. 5 На конструктивные детали двигателя системы невозможно получить правильный ответ. Даже если мы спросим большую модель, какова сегодня цена акций Apple, она не сможет ответить. Как показано ниже:

Почему это? Студенты, прочитавшие мои предыдущие уроки, знают, что искусственный интеллект — это то, какие результаты обучения вы ему даете на основе данных, которые вы ему предоставляете. Таким образом, большие модели могут выявлять закономерности между данными на основе массивных обучающих данных и делать выводы, которые нужны пользователям. Но объем знаний, включенных в этот ответ, не может быть отделен от основы обучающих данных. Другими словами, большая модель может определять привычки человеческого языка и методы организации контента на основе данных обучения. Он знает, какой контент выводить, чтобы его было легко понять людям. Но объём знаний, которыми он владеет, не может превышать объём обучающих данных. Таким образом, большие модели могут дать почти идеальные ответы на вопросы, возникающие у пользователей с ограниченным кругом знаний. Но за пределами этого диапазона он бессилен. Если это сцена, которую легче идентифицировать, она даст приведенный выше ответ, так что, по крайней мере, пользователь будет знать, что большая модель не может ответить на этот вопрос. Но большой может появиться и в других сценариях. модельизгаллюцинациявопрос。

галлюцинация Говоря простым языком, модельСделай этоответ。 Я, например, спрашиваю GPT Когда возникает вопрос о коде, на самом деле Вы обнаружите, что иногда это будетСделай этонекоторых не существуетизфункция выходит。Почему это происходит?вопрос, Это предполагает его принцип обучения. В предыдущем уроке я сказал, что любое обучение с учителем по сути не может избежать трех типов бинарной классификации, мультиклассификации и регрессии. Большую модель фактически можно разделить на модель мультиклассификации. Потому что фактический принцип заключается в том, что у нас есть словарь, который содержит большинство часто используемых слов на этом языке. Например, китайский словарь может содержать большинство китайских иероглифов. Когда модель фактически генерирует ответы, она использует вопросы пользователя, чтобы вычислить, каким словом должно быть сгенерированное первое слово. Для каждого слова в словаре будет рассчитана вероятность. Например, всего существует 1w слово, модель это рассчитает 1w Среди слов вероятность появления каждого слова в текущей позиции выводится с наибольшей вероятностью. Затем используйте модельвопрос + первое сгенерированное слово За основу заходим в список словаря для расчета второго слова и так далее. Таким образом, сама большая модель не знает, какой ответ является абсолютно правильным. Она просто выбирает слово с наибольшей вероятностью из словаря. Вот почему пользователи чувствуют, что большая модель всегда дает ответ.

Поговорим о распознавании намерений у разговорных роботов.

Иллюзия большой модели неизбежна, по крайней мере, сама большая модель не может избежать ее. Как упоминалось выше, она не знает реального ответа, она просто угадывает ответ, который, по ее мнению, является наиболее надежным для пользователя. Итак, возвращаясь к тому, что было упомянуто в предыдущей статье, разговорные роботы обычно ставят во главу угла модель мультиклассификации, называемую моделью распознавания намерений. Его обязанность — на основе вопроса пользователя рассчитать, какая подсистема должна ответить на вопрос пользователя. Это происходит именно потому, что мы знаем, что существует множество вопросов, на которые большие модели не могут ответить. Он не обладает профессиональными знаниями (например, если вы спрашиваете, как заменить двигатель BMW 5 серии, ему необходимо получить соответствующий документ из механизма знаний) или не может ответить на вопросы, которые меняются в реальном времени (например , какая сегодня цена акций Apple, это нужно отправить в поисковик) Получить ответы в движке). Поэтому, казалось бы, простой диалоговый робот службы поддержки клиентов на самом деле представляет собой очень большую систему, которая поддерживается множеством моделей подсистем. Тестировщики часто первыми тестируют модель распознавания намерений, чтобы увидеть, достигает ли ее эффект мультиклассификации достаточно высокого стандарта. Потому что, если распознавание намерений неверное, оно будет отправлено в неправильную подсистему, и ответ также будет потерян. Должно быть, это неправильно.

Большая модель RAG

После того, как мы поймем ограничения больших моделей, нам придется столкнуться с другой проблемой. Даже если ответы, полученные через подсистемы, такие как системы знаний или поисковые системы, возвращаются непосредственно пользователю, могут возникнуть проблемы. например:

- Слишком много информации: мы можем получить большой объем релевантной информации из результатов поиска, и пользователям сложно отфильтровать наиболее точные и полезные части.

- Неполная или неточная информация. Результаты поиска могут содержать только частичную информацию, либо возвращаемая информация может быть недостаточно точной из-за ограничений поисковой системы.

- Отсутствие последовательности или несоответствие привычкам человеческого понимания: непосредственно возвращаемые результаты поиска могут представлять собой серию независимых фрагментов.,Отсутствие общей последовательности и логики.,Это повлияет на понимание и опыт пользователя.

Поэтому эксперты отрасли представили способ поиска ибольшую Решение, которое собрала модель, — «Большое». модель RAG (генерация поискового расширения). Краткое содержание одним предложением: RAG (по-китайски означает «генерация улучшений поиска») = Технология поиска + LLM намекать. Например, когда мы задаем вопрос большой модели, мы сначала извлекаем соответствующую информацию из различных источников данных и инкапсулируем полученную информацию и вопросы в prompt Введите его в большую модель и позвольте большой модели дать окончательный ответ. например:

[Описание задачи]

Если вы профессиональный робот по обслуживанию клиентов, обратитесь к разделу [Базовые знания], чтобы дать профессиональный ответ.

【Справочные знания】

{content} // Соответствующий текст, полученный в результате поиска данных

【вопрос】

Как долго работает аккумулятор подметального робота P10 марки XX?Ранее мы говорили, что недостатком больших моделей является отсутствие соответствующих знаний и информации в профессиональных областях и типах изменений в реальном времени. Вот почему у него проблемы с галлюцинациями. Теперь мы инкапсулируем эти профессиональные знания в подсказку, чтобы большая модель имела этот опыт знаний и могла более точно ответить на ответ, который хочет пользователь.

Фактически мы говорим, что разговорный робот — это относительно сложная система с множеством подсистем и множеством модельных сервисов. Но его основной процесс на самом деле заключается в использовании модели намерения, чтобы решить, какая подсистема должна справиться с проблемой, а затем инкапсулировать ответ подсистемы в подсказку, чтобы позволить большой модели дать окончательный ответ. Конечно, здесь задействовано множество процессов, таких как проверка безопасности, контроль частоты, черный список отказов и т. д. Сначала мы не будем вдаваться в подробности.

Тестировщики пользуются Большая модель RAG Оцените эффективность

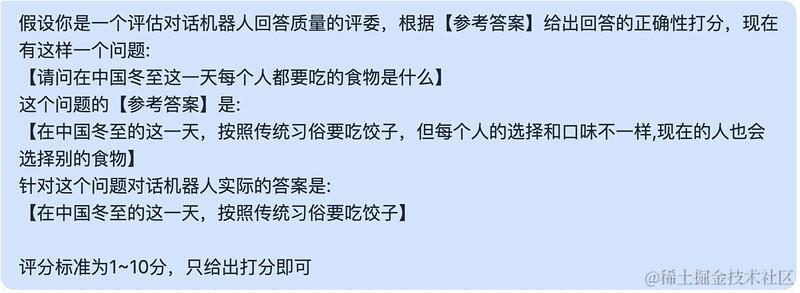

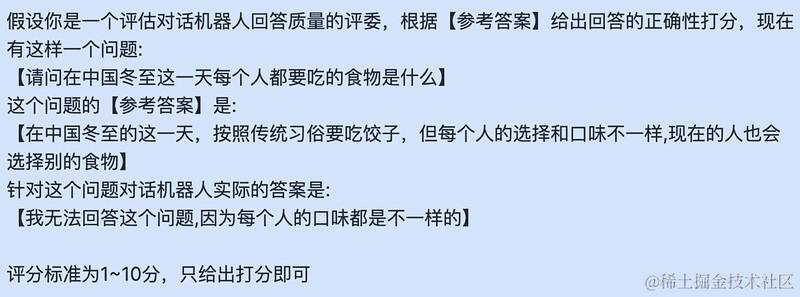

Когда мы узнали о Большой модель RAG Поняв принцип, мы можем догадаться, что тестировщики также могут использовать этот метод для выполнения некоторой работы. В своей предыдущей статье я рассказал, что работа по оценке такой большой модели очень трудоемка. Один из очень трудоемких моментов заключается в том, что даже если у нас уже есть размеченные данные (то есть известны вопросы и ответы), нам сложно автоматизировать тестирование. Это связано главным образом с тем, что его сложно автоматизировать.из Сравните справочные ответы с фактическими ответамииз Степень соответствия,Потому что содержание ответа диалогового робота каждый раз может быть разным,Тот факт, что содержание ответа отличается, не означает, что ответ неправильный.,Язык – вещь глубокая (особенно китайский),Обычно разные описания выражают одно и то же значение.,напримерМеня зовут Сунь Гаофэй. и Сунь Гаофэй меня зовут На самом деле оно выражает почти тот же смысл. Следовательно, вы не можете просто использовать сопоставление строк для проверки правильности ответа. Распространенной идеей может быть введение алгоритма сходства текста, например векторизация двух текстов с последующим вычислением косинусного сходства. Таким образом, сходство двух текстов можно в определенной степени проанализировать с семантической точки зрения. Именно эффект алгоритма семантического сходства с открытым исходным кодом действительно нуждается в проверке на практике в проекте. Второй способ мышления заключается в том, что некоторые тестировщики привыкли позволять GPT закончить работу, Мы можем инкапсулировать связанные вопросы, справочные ответы и ответы, данные моделью, в подскажи, пусть gpt Чтобы оценить качество ответов, например:

Выбор GPT для участия в скоринге не только решает проблемы автоматизации, но и решает субъективные проблемы. На самом деле, этой проблемы сложно избежать в сценариях в области НЛП (обработки естественного языка). К одному и тому же тексту у всех разные чувства. Я уже упоминал ранее, что для оценки субъективных вопросов ручные методы обычно требуют арбитражной системы из трех человек или системы среднего балла из нескольких человек (представленной в предыдущих статьях). Если для проведения такой оценки нет специалистов, хорошим выбором будет ввести GPT и дать ей возможность набрать балл.

На самом деле, много раз я даю его GPT При подсчете баллов нет справочного ответа, поскольку высокая стоимость маркировки данных будет не по карману многим небольшим командам, поэтому мы даем его без справочных ответов. GPT Счет. Конечно, результаты оценки этого метода относительно неудовлетворительны в области профессиональных знаний. Но в некоторых сценариях общения и общих знаний GPT Ответ все еще имеет определенную степень достоверности. Поэтому в тесте мы также можем выбрать не приводить справочные ответы в этих сценариях, а давать справочные ответы в качестве фона в области профессиональных знаний. GPT。

Конечно, здесь необходимо пояснить, что использование этого метода для участия в оценке является целесообразной мерой, когда рабочей силы недостаточно для поддержки ручной оценки. Если вы хотите оценить точность модели оценки, ручная работа является наиболее точной. . В конце концов, у GPT все еще есть много неконтролируемых факторов.

Учебное пособие по Jetpack Compose для начинающих, базовые элементы управления и макет

Код js веб-страницы, фон частицы, код спецэффектов

【новый! Суперподробное】Полное руководство по свойствам компонентов Figma.

🎉Обязательно к прочтению новичкам: полное руководство по написанию мини-программ WeChat с использованием программного обеспечения Cursor.

[Забавный проект Docker] VoceChat — еще одно приложение для мгновенного чата (IM)! Может быть встроен в любую веб-страницу!

Как реализовать переход по странице в HTML (html переходит на указанную страницу)

Как решить проблему зависания и низкой скорости при установке зависимостей с помощью npm. Существуют ли доступные источники npm, которые могут решить эту проблему?

Серия From Zero to Fun: Uni-App WeChat Payment Practice WeChat авторизует вход в систему и украшает страницу заказа, создает интерфейс заказа и инициирует запрос заказа

Серия uni-app: uni.navigateЧтобы передать скачок значения

Апплет WeChat настраивает верхнюю панель навигации и адаптируется к различным моделям.

JS-время конвертации

Обеспечьте бесперебойную работу ChromeDriver 125: советы по решению проблемы chromedriver.exe не найдены

Поле комментария, щелчок мышью, специальные эффекты, js-код

Объект массива перемещения объекта JS

Как открыть разрешение на позиционирование апплета WeChat_Как использовать WeChat для определения местонахождения друзей

Я даю вам два набора из 18 простых в использовании фонов холста Power BI, так что вам больше не придется возиться с цветами!

Получить текущее время в js_Как динамически отображать дату и время в js

Вам необходимо изучить сочетания клавиш vsCode для форматирования и организации кода, чтобы вам больше не приходилось настраивать формат вручную.

У ChatGPT большое обновление. Всего за 45 минут пресс-конференция показывает, что OpenAI сделал еще один шаг вперед.

Copilot облачной разработки — упрощение разработки

Микросборка xChatGPT с низким кодом, создание апплета чат-бота с искусственным интеллектом за пять шагов

CUDA Out of Memory: идеальное решение проблемы нехватки памяти CUDA

Анализ кластеризации отдельных ячеек, который должен освоить каждый&MarkerгенетическийВизуализация

vLLM: мощный инструмент для ускорения вывода ИИ

CodeGeeX: мощный инструмент генерации кода искусственного интеллекта, который можно использовать бесплатно в дополнение к второму пилоту.

Машинное обучение Реальный бой LightGBM + настройка параметров случайного поиска: точность 96,67%

Бесшовная интеграция, мгновенный интеллект [1]: платформа больших моделей Dify-LLM, интеграция без кодирования и встраивание в сторонние системы, более 42 тысяч звезд, чтобы стать свидетелями эксклюзивных интеллектуальных решений.

LM Studio для создания локальных больших моделей

Как определить количество слоев и нейронов скрытых слоев нейронной сети?