Как быстро установить Hadoop под Linux

Все заинтересованы в больших данных,Но никто не думает о том, как это реализовать на практике.,Как реализовать обучение Hadoop,Когда мы изучаем любую технологию,Не нужно об этом думать,Я обязательно зашёл в Установить,затем попрактикуйся,Должен сказать,Теперь вы ищете в Интернете,как Установить Hadoop, многие из них взяты из Unbutu Многие пояснения по установке под систему не очень понятны. Любитель тоже хочет узнать, поэтому подготовил, как установить. Hadoop из Linux из Учебное пособие, каждый может научиться этому, как только начнет. Фанат начал писать для всех «Установить» Hadoop из Учебное пособие。

Подготовка

1. Сначала мы можем перейти в Alibaba Cloud или Huawei Cloud, чтобы арендовать сервер.,Ведь это младшая версия сервера,Не так уж и дорого,Фанат до сих пор пользуется тем, который я арендовал раньше.,мы выбираем Установить Linux8 из версии, если это родная из версии, то ее нужно скачать CentOS8 из образа, а затем через виртуальную машину Установить в VM Просто загрузите его. Как только установка будет завершена, мы сможем начать установку. Hadoop Понятно

Давайте сначала поговорим о том, что может Hadoop и что люди часто неправильно понимают в Hadoop.

Hadoop — это в основном среда распределенных вычислений и хранения данных, поэтому рабочий процесс Hadoop в основном опирается на HDFS (распределенную файловую систему Hadoop). Mapreduce.

Но многие люди будут правы Hadoop Есть недоразумение, некоторые люди очень льстит Hadoop Люди скажут: Hadoop Все можно сделать. На самом деле это не одно и то же. Каждая появляющаяся технология соответствует решению разных задач. Например, мы собираемся учиться дальше. Hadoop . Hadoop подходит для анализа данных, но это определенно не так. BI ,Традиция BI Он принадлежит к уровню представления данных (Data Presentation),Hadoopто есть фокусируется на полуструктурированных и неструктурированных данных и носителях данных.,Это концепция другого уровня, чем BI.

Другие говорят Hadoop то есть ETL , что эквивалентно обработке данных, но Hadoop Не в абсолютном смысле ETL 。

Установите руководство по Hadoop

1. Установите SSH

yum install openssh-server

OpenSSH безопасен Реализация Shellizan с открытым исходным кодом, После завершения установки OpenSSH Server в каталог /etc/init.d следует добавить службу с именем sshdiz.,Через мгновение мы поместим сгенерированный ключ в указанное место, а затем будем использовать его для последующей аутентификации.

2. Установите рсинк

yum -y install rsync

3. создайте SSH-ключ для продолжения последующей аутентификации.

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

4. Поместите сгенерированный ключ в лицензионный документ.

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

Установить Hadoop

Установить Hadoop До этого нам нужно сначала JDK Установить Окей, настраиваем переменные окружения. Если это выглядит так, значит. JDK уже Установить Заканчивать Понятно。

1. Разархивируйте Hadoop

Мы должны сначала Hadoop на нашем сервере,Прямо как А Фен,

Затем разархивируйте tar zxvf hadoop-3.3.1.tar.gz

2. Измените файл bashrc.

vim ~/.bashrc

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64/

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-DJava.library.path=$HADOOP_HOME/lib"

export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRARY_PATH

Скопировать в файл, сохранить и выйти

3. Действительные документы

source ~/.bashrc

4. Измените файл конфигурации etc/hadoop/core-site.xml.

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!-- Путь хранения кэша -->

<property>

<name>hadoop.tmp.dir</name>

<value>/app/hadooptemp</value>

</property>

5. Измените файл etc/hadoop/hdfs-site.xml.

<!-- По умолчанию — 3. Поскольку это одна машина, настройте 1. -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- Настроить адрес доступа http -->

<property>

<name>dfs.http.address</name>

<value>0.0.0.0:9870</value>

</property>

6. Измените файл etc/hadoop/hadoop-env.sh.

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.212.b04-0.el7_6.x86_64

7. Измените файл etc/hadoop/yarn-env.sh.

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.212.b04-0.el7_6.x86_64

8. Измените файл sbin/stop-dfs.sh и добавьте его вверху.

HDFS_NAMENODE_USER=root

HDFS_DATANODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

YARN_RESOURCEMANAGER_USER=root

YARN_NODEMANAGER_USER=root

- Измените файл sbin/start-dfs.sh и добавьте

HDFS_NAMENODE_USER=root

HDFS_DATANODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

YARN_RESOURCEMANAGER_USER=root

YARN_NODEMANAGER_USER=root

9-1 Измените файл start-yarn.sh.

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

9-2. Измените файл stop-yarn.sh.

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

Вышеуказанные команды в основном используются при запуске Hadoop При этом появится сообщение, что аутентификация не пройдена.

10.Форматирование,Войдите в папку Hadoop,Выполните следующую команду

./hdfs namenode -format

11. Войдите в папку sbin и запустите Hadoop.

./start-dfs.sh

Вы также можете запустить их все напрямую ./start-all.sh

Затем напрямую получите доступ к порту 8088.

12. Откройте конечный порт на брандмауэре. Если вы используете облачный сервер, добавьте конечный порт 9870 ко входу группы безопасности.

//Добавляем порт 9870конец в брандмауэр

firewall-cmd --zone=public --add-port=9870/tcp --permanent

//Перезапускаем брандмауэр

firewall-cmd --reload

13. Введите jps. Если это 4 или 5, настройка прошла успешно и продолжайте.

Доступ к Hadoop через Интернет, адрес доступа: http://IP-адрес: 9870.

Когда мы видим это,Это значит, что мы добились успеха. Уведомление,Hadoop3.x Версию см. Hadoop Вебконецизконец рот не изменился, но HDFS конец затем 50070 становиться Понятно 9870 Вам нужно обратить на это внимание. Вы научились это делать?

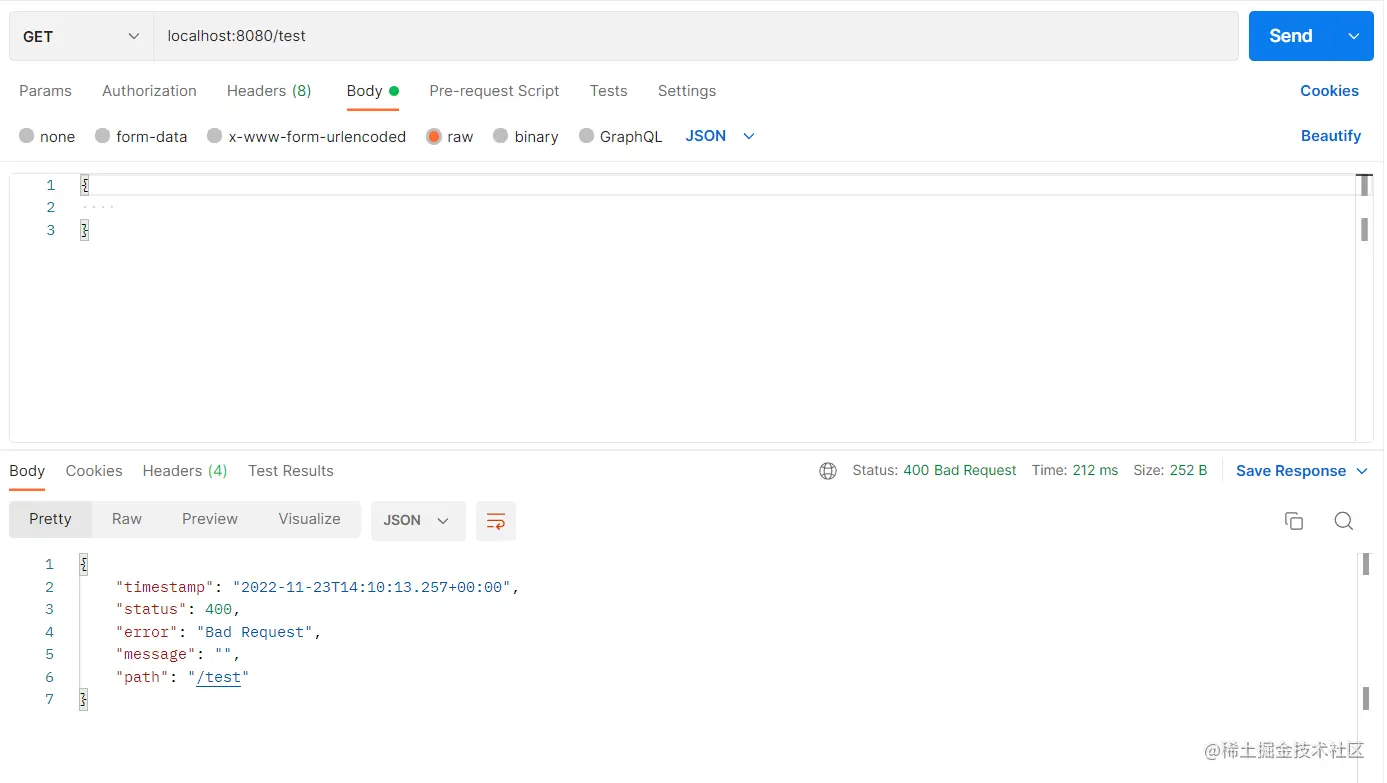

[Спецификация] Результаты и исключения возврата интерфейса SpringBoot обрабатываются единообразно, поэтому инкапсуляция является элегантной.

Интерпретация каталога веб-проекта Flask

Что такое подробное объяснение файла WSDL_wsdl

Как запустить большую модель ИИ локально

Подведение итогов десяти самых популярных веб-фреймворков для Go

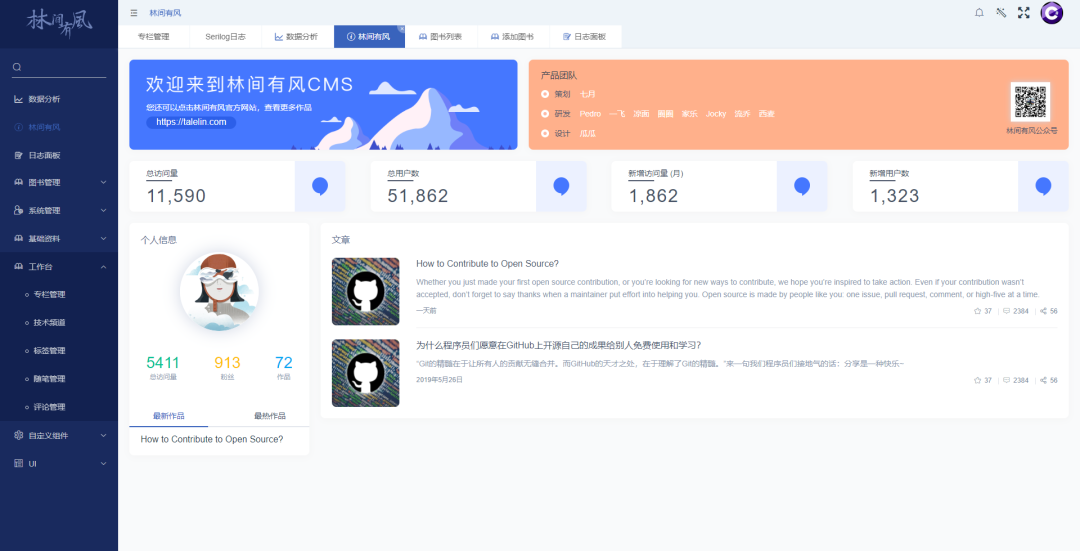

5 рекомендуемых проектов CMS с открытым исходным кодом на базе .Net Core

Java использует httpclient для отправки запросов HttpPost (отправка формы, загрузка файлов и передача данных Json)

Руководство по развертыванию Nginx в Linux (Centos)

Интервью с Alibaba по Java: можно ли использовать @Transactional и @Async вместе?

Облачный шлюз Spring реализует примеры балансировки нагрузки и проверки входа в систему.

Используйте Nginx для решения междоменных проблем

Произошла ошибка, когда сервер веб-сайта установил соединение с базой данных. WordPress предложил решение проблемы с установкой соединения с базой данных... [Легко понять]

Новый адрес java-библиотеки_16 топовых Java-проектов с открытым исходным кодом, достойных вашего внимания! Обязательно к просмотру новичкам

Лучшие практики Kubernetes для устранения несоответствий часовых поясов внутри контейнеров

Введение в проект удаления водяных знаков из коротких видео на GitHub Douyin_TikTok_Download_API

Весенние аннотации: подробное объяснение @Service!

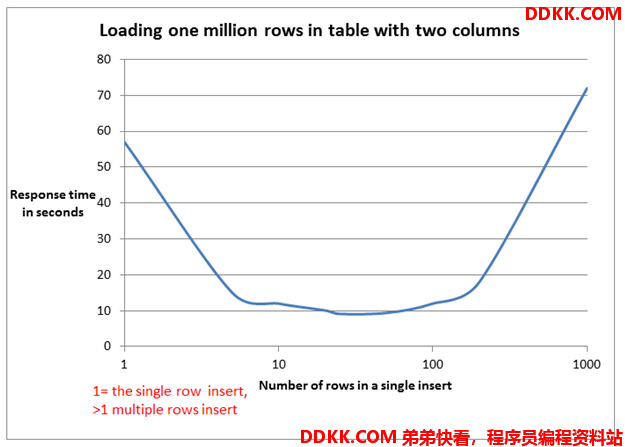

Пожалуйста, не используйте foreach для пакетной вставки в MyBatis. Для 5000 фрагментов данных потребовалось 14 минут. .

Как создать проект Node.js с помощью npm?

Mybatis-plus использует typeHandler для преобразования объединенных строк String в списки списков.

Не удалось установить программное обеспечение Mitsubishi. Возможно, возникла проблема с реестром.

Разрешение ошибок проекта SpringBoot 3 mybatis-plus: org.apache.ibatis.binding.BindingException: неверный оператор привязки

Более краткая проверка параметров. Для проверки параметров используйте SpringBoot Validation.

Поиграйтесь с интеграцией Spring Boot (платформа запланированных задач Quartz)

Несколько популярных режимов интерфейса API: RESTful, GraphQL, gRPC, WebSocket, Webhook.

Redis: практика публикации (pub) и подписки (sub)

Подробное объяснение пакета Golang Context

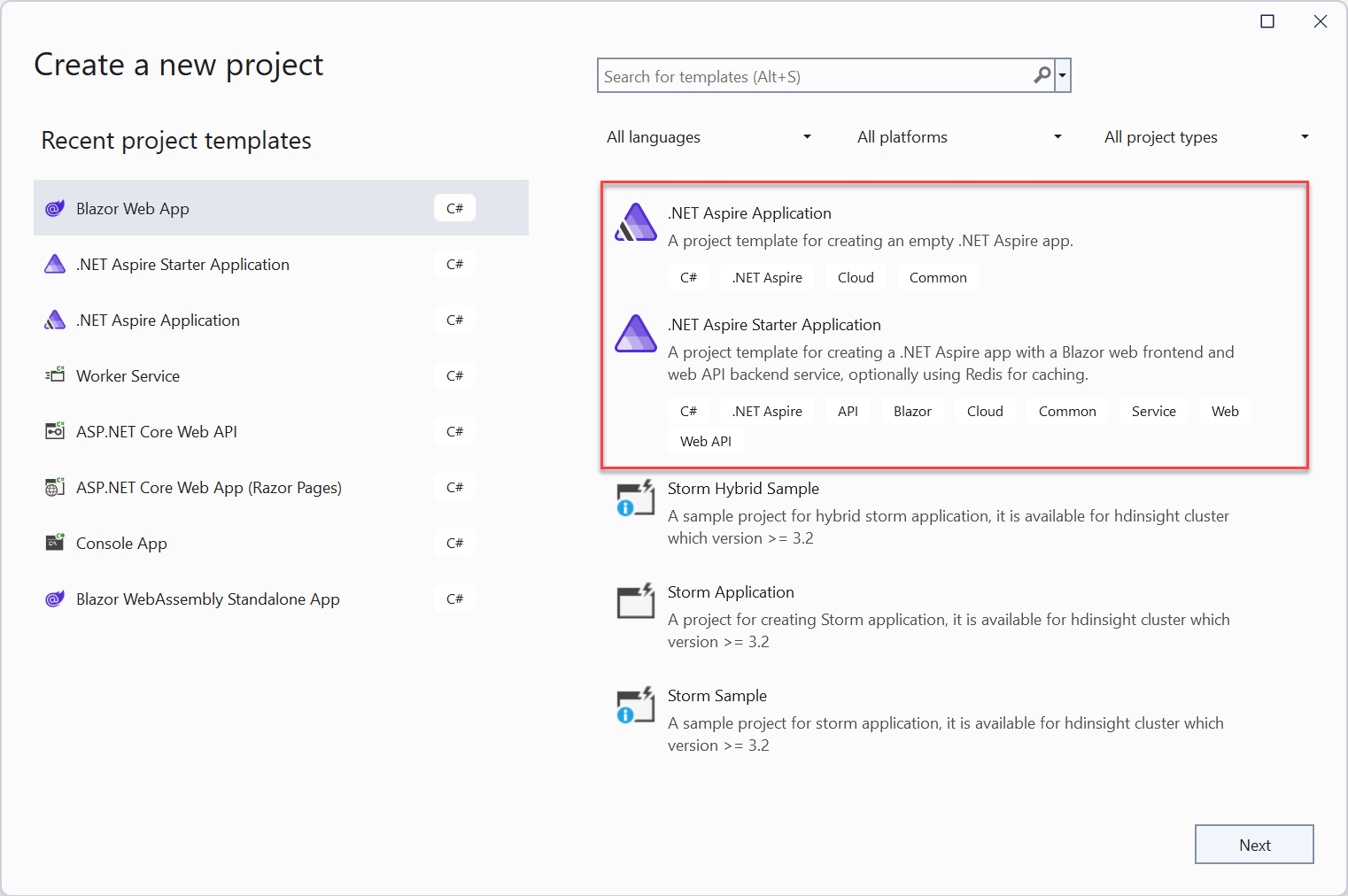

Краткое руководство: создайте свое первое приложение .NET Aspire

Краткое обсуждение метода пакетной вставки MyBatis: обработка 100 000 фрагментов данных занимает всего 2 секунды.

[Инструмент] Используйте nvm для управления переключением версий nodejs, это так здорово!