Используйте API-интерфейс Кими бесплатно, kimi-free-api — это действительно вкусно.

В этом году, благодаря открытому исходному коду основных моделей GLM и повышению вычислительной мощности, особенно недавно популярной модели Кими «Тёмная сторона Луны», появились различные агенты в сценариях применения ИИ. Многие студенты выразили желание присоединиться к изучению и тестированию приложений ИИ. Однако бесплатные токены API, предоставляемые крупными поставщиками моделей, имеют различные ограничения с точки зрения количества и других аспектов, что доставляет большие проблемы тем из нас, кто работает. бесплатно вызвало некоторые неудобства. Сегодня на GitHub я обнаружил проект под названием kimi-free-api, который обеспечивает нам большое удобство в изучении и тестировании использования моделей GLM.

Введение в проект

Он поддерживает высокоскоростной потоковый вывод, несколько раундов диалога, онлайн-поиск, интерпретацию длинных документов, анализ изображений, развертывание без настройки, поддержку многоканальных токенов и автоматическую очистку трассировок сеансов.

Полностью совместим с интерфейсом ChatGPT.

Адрес Github: https://github.com/LLM-Red-Team/kimi-free-api.

Хотя новые пользователи Kimi после регистрации получат бесплатный кредит в размере 15 юаней. Если квота подарков израсходована, но вы все еще хотите продолжить бесплатное использование, попробуйте этот проект с открытым исходным кодом. То же самое касается следующих больших моделей.

Интерфейс StepChat для API Step-Free-Api: https://github.com/LLM-Red-Team/step-free-api

Интерфейс Али Тонги (Qwen) для API qwen-free-api: https://github.com/LLM-Red-Team/qwen-free-api

Интерфейс ZhipuAI (Zhipu Qingyan) для API glm-free-api: https://github.com/LLM-Red-Team/glm-free-api

Интерфейс Metaso AI (metaso) для API Metaso-free-api: https://github.com/LLM-Red-Team/metaso-free-api

Интерфейс Lingxin Intelligence (Emohaa) для API emohaa-free-api: https://github.com/LLM-Red-Team/emohaa-free-api

Подготовка доступа

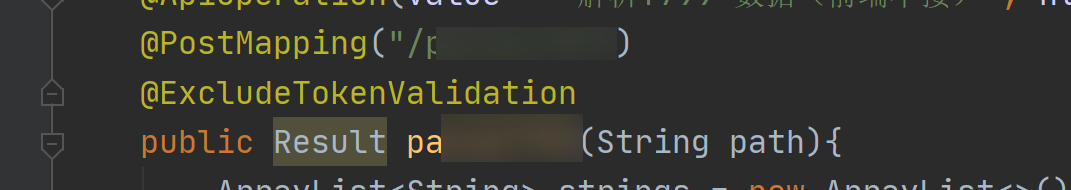

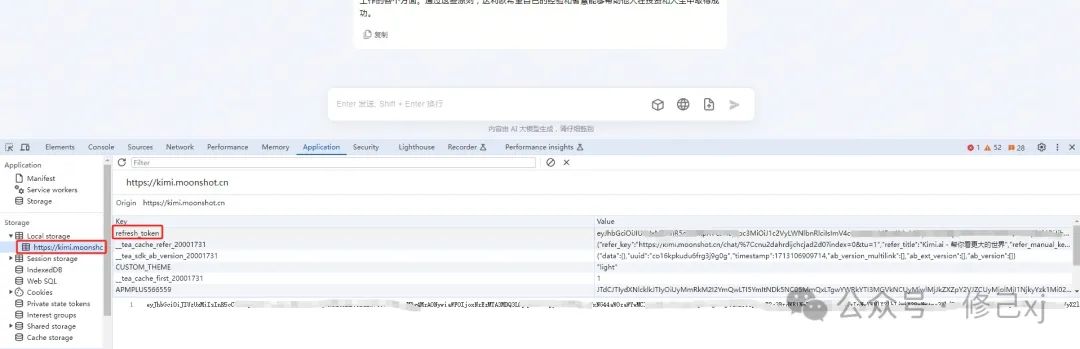

- Получите обновленный токен с https://kimi.moonshot.cn.

Введите kimi, чтобы начать разговор, затем F12, чтобы открыть инструменты разработчика, нажмите «Приложение». > Local Найдите значение обновления_токена в хранилище, которое будет служить носителем авторизации. Токен: Авторизация: Bearer TOKEN

- Доступ к нескольким аккаунтам

В настоящее время Кими ограничивает обычные учетные записи только 30 раундами длинных текстовых вопросов и ответов каждые 3 часа (нет ограничений на короткие тексты. Вы можете предоставитьrefresh_tokens для нескольких учетных записей и использовать их, а объединение обеспечивает:

Authorization: Bearer TOKEN1,TOKEN2,TOKEN3

Один из них будет выбираться каждый раз при запросе услуги.

Служба развертывания Docker-compose

- Создайте файл docker-compose.yml.

Создайте файл docker-compose.yml в каталоге развертывания и напишите следующее содержимое:

version: '3.3'

services:

kimi-free-api:

container_name: kimi-free-api

image: vinlic/kimi-free-api:latest

restart: always

ports:

- "8000:8000"

environment:

- TZ=Asia/Shanghai

- запускать Служить

Используйте следующую команду, чтобы запустить службу в том же каталоге, что и файл docker-compose.yml.

docker-compose up -d

Использовать интерфейс

- Конфигурация Модель

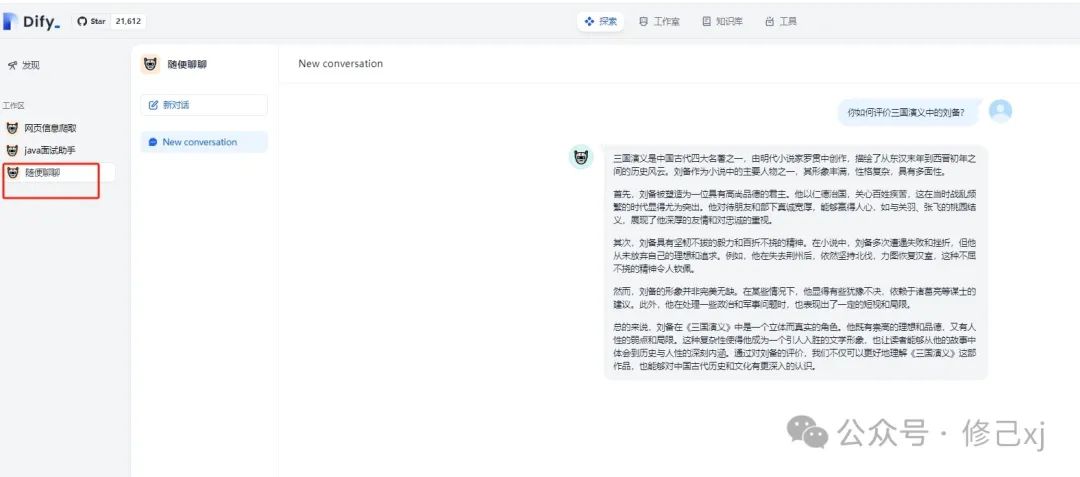

Вот мы здесьdifyиспользован в качестве примера,Также можно использовать другие открытые исходные коды.,напримерchatgpt-next-web-proxy,lobe-chatждать。

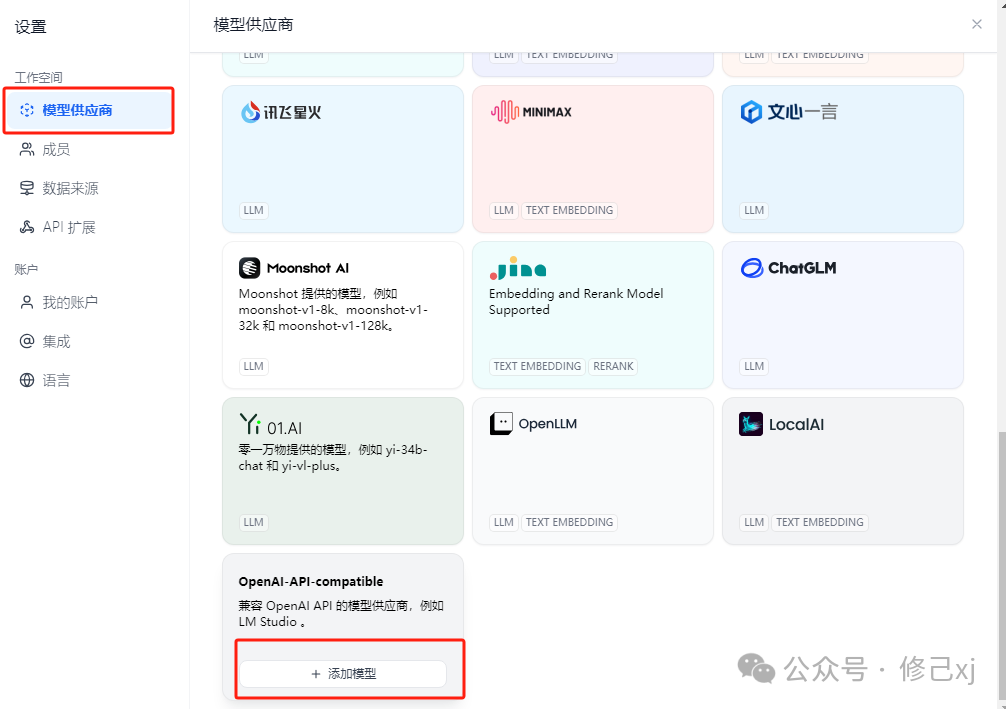

существоватьdifyнастройки-->Модельпоставщик->Модель Выбрать из спискаOpenAI-API-compatible->добавить в Модель

Добавьте следующее:

После заполнения содержимого нажмите «Сохранить», чтобы наша модель была настроена.

- протестировать API

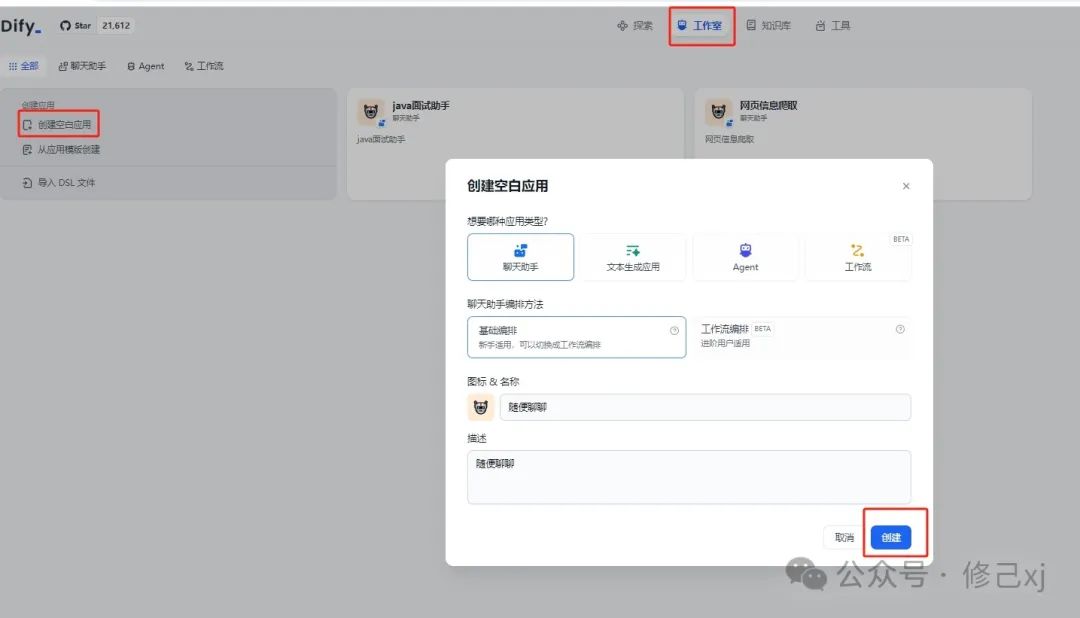

После настройки модели создаем простое приложение для чата в студии diffy.

Публикуйте после создания, мы используем это приложение в исследовании.

Как видите, мы уже можем использовать этот интерфейс API.

Подвести итог

Появление проекта Kimi-free-api не только обеспечивает удобство для энтузиастов и разработчиков искусственного интеллекта, но и способствует развитию сообщества открытого исходного кода. С помощью этих инструментов мы можем более удобно исследовать безграничные возможности искусственного интеллекта и с нетерпением ждем новых сюрпризов, которые принесет технология искусственного интеллекта в будущем.

Артефакт, который делает код элегантным и лаконичным: программирование на Java8 Stream

Spring Boot(06): Spring Boot в сочетании с MySQL создает минималистскую и эффективную систему управления данными.

Как использовать ArrayPool

Интегрируйте iText в Spring Boot для реализации замены контента на основе шаблонов PDF.

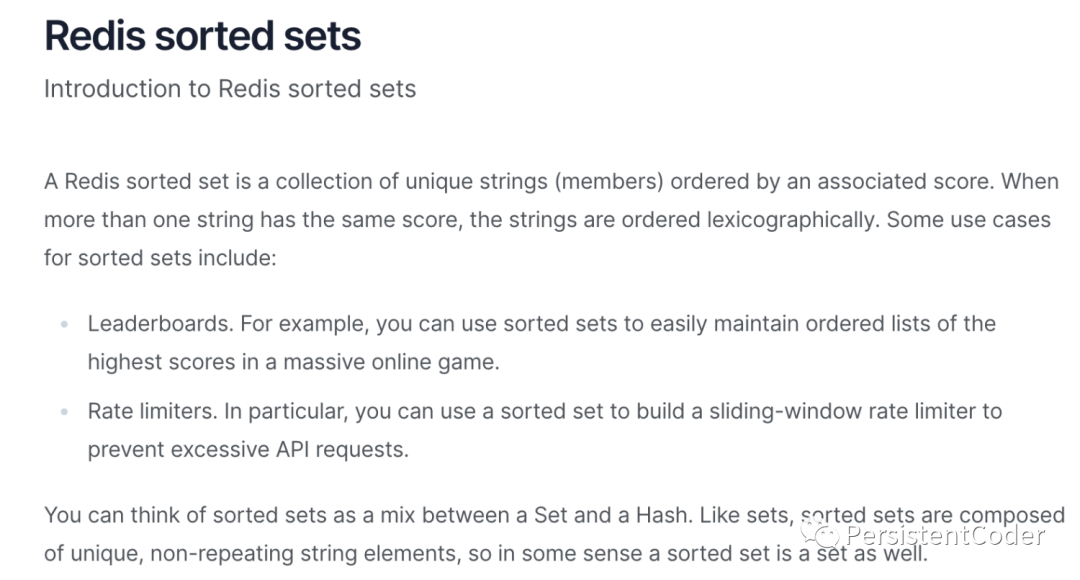

Redis реализует очередь задержки на основе zset

Получить текущий пакет jar. path_java получает файл jar.

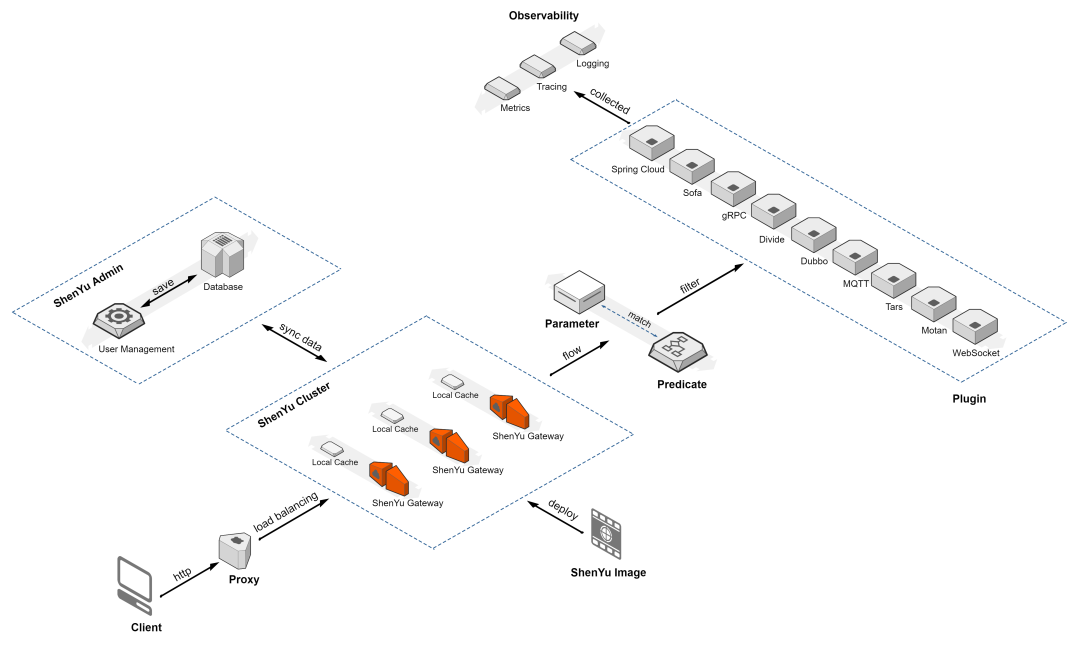

Краткое обсуждение высокопроизводительного шлюза Apache ShenYu

Если вы этого не понимаете, то на собеседовании даже не осмелитесь сказать, что знакомы с Redis.

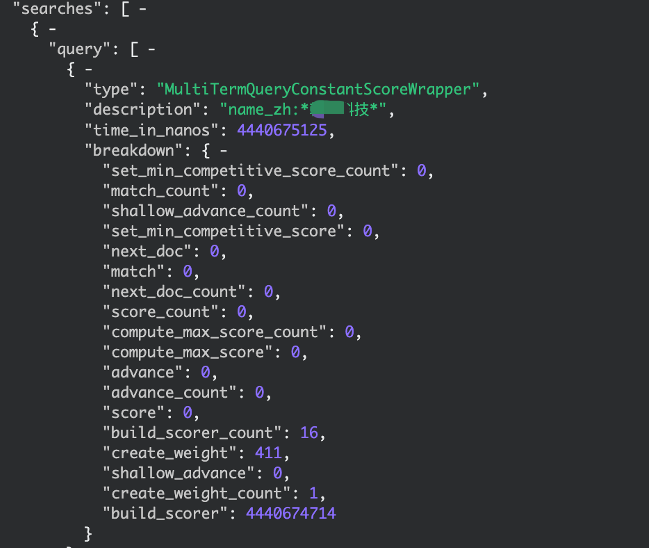

elasticsearch медленный запрос, устранение неполадок записи, запрос с подстановочными знаками

По какому стандарту взимается плата за обслуживание программного обеспечения?

IP-адрес Получить

【Java】Решено: org.springframework.web.HttpRequestMethodNotSupportedException

Native js отправляет запрос на публикацию_javascript отправляет запрос на публикацию

.net PDF в Word_pdf в Word

[Пул потоков] Как Springboot использует пул потоков

Подробное объяснение в одной статье: Как работают пулы потоков

Серия SpringCloud (6) | Поговорим о балансировке нагрузки

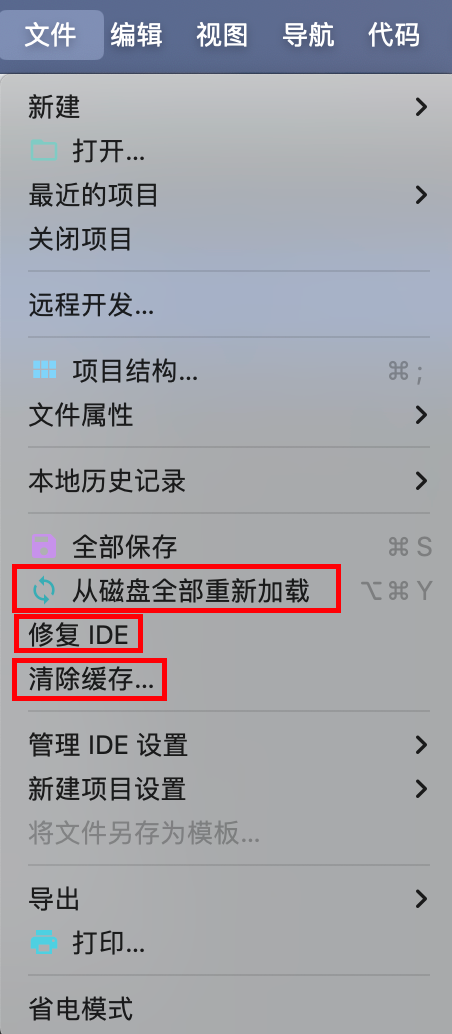

IDEA Maven может упаковать все импортное полностью красное решение — универсальное решение.

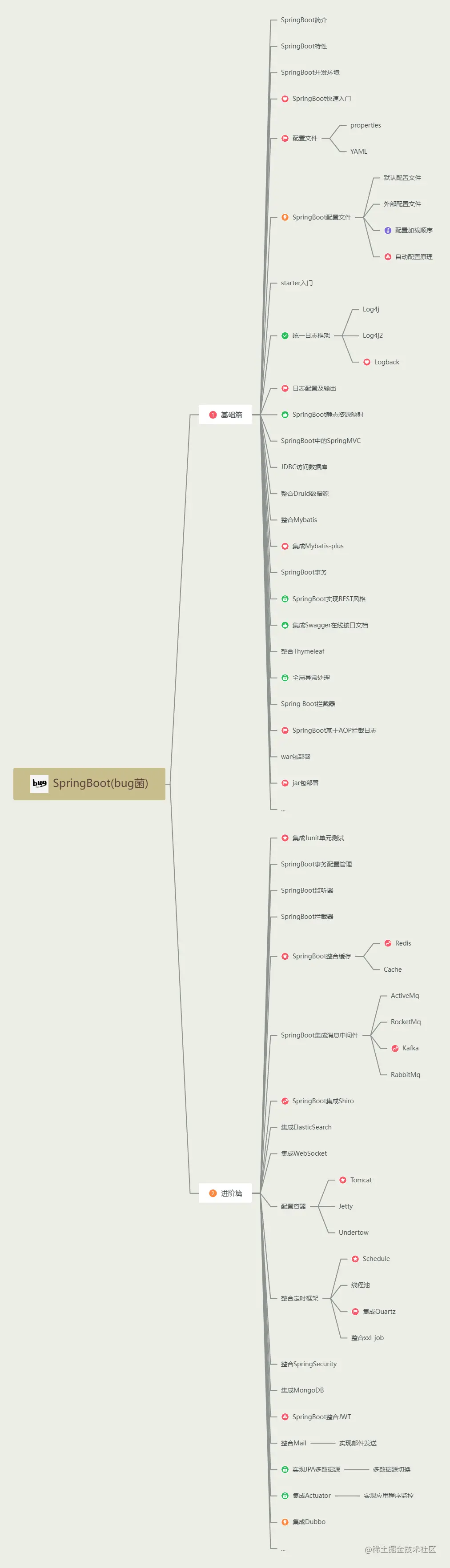

Последний выпуск 2023 года, самое полное руководство по обучению Spring Boot во всей сети (с интеллект-картой).

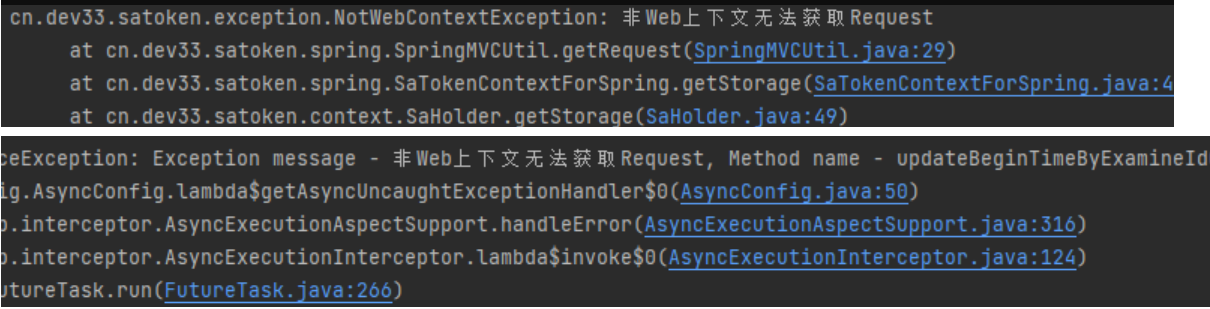

[Решено — Практическая работа] SaTokenException: запрос не может быть получен в контексте, отличном от Интернета. Решение проблем — Практическая работа.

HikariPool-1 - Connection is not available, request timed out after 30000ms

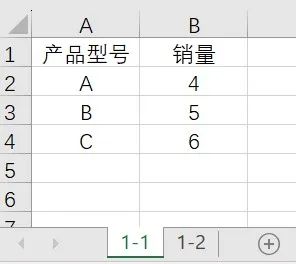

Power Query: автоматическое суммирование ежемесячных данных с обновлением одним щелчком мыши.

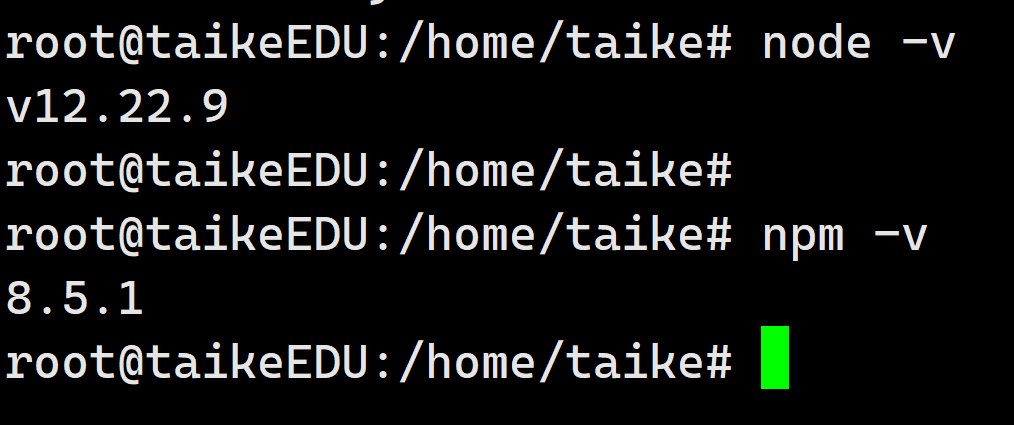

установка Ubuntu в среде npm

3 Бесплатные системы управления складом (WMS) .NET с открытым исходным кодом

Глубокое погружение в библиотеку Python Lassie: мощный инструмент для автоматизации извлечения метаданных

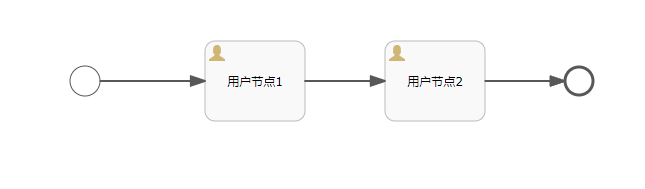

Объяснение прослушивателя серии Activiti7 последней версии 2023 года

API-интерфейс Jitu Express для электронных счетов-Express Bird [просто для понимания]

Каковы архитектуры микросервисов Java. Серверная часть плавающей области обслуживания

Описание трех режимов жизненного цикла службы внедрения зависимостей Asp.net Core.