ГАН! Полномасштабное введение и практическое применение генеративно-состязательной сети GAN.

Эта статья представляет собой комплексное, углубленное и практическое руководство для исследователей и практиков генеративно-состязательных сетей (GAN). Благодаря теоретическому объяснению и практическому руководству по эксплуатации этой статьи читатели смогут освоить основные концепции GAN, понять принцип ее работы, научиться проектировать и обучать свою собственную модель GAN, а также иметь возможность эффективно анализировать и оценивать результаты. Автор, TechLead, имеет более чем 10-летний опыт работы в области архитектуры интернет-сервисов, опыт разработки продуктов искусственного интеллекта и опыт управления командой. Он имеет степень магистра Университета Тунцзи в Университете Фудань, член Лаборатории интеллекта роботов Фудань, старший архитектор, сертифицированный Alibaba. Клауд, профессионал в области управления проектами и менеджер по исследованиям и разработкам продуктов с доходом в сотни миллионов.

1. Введение

1.1 Введение в генеративно-состязательные сети

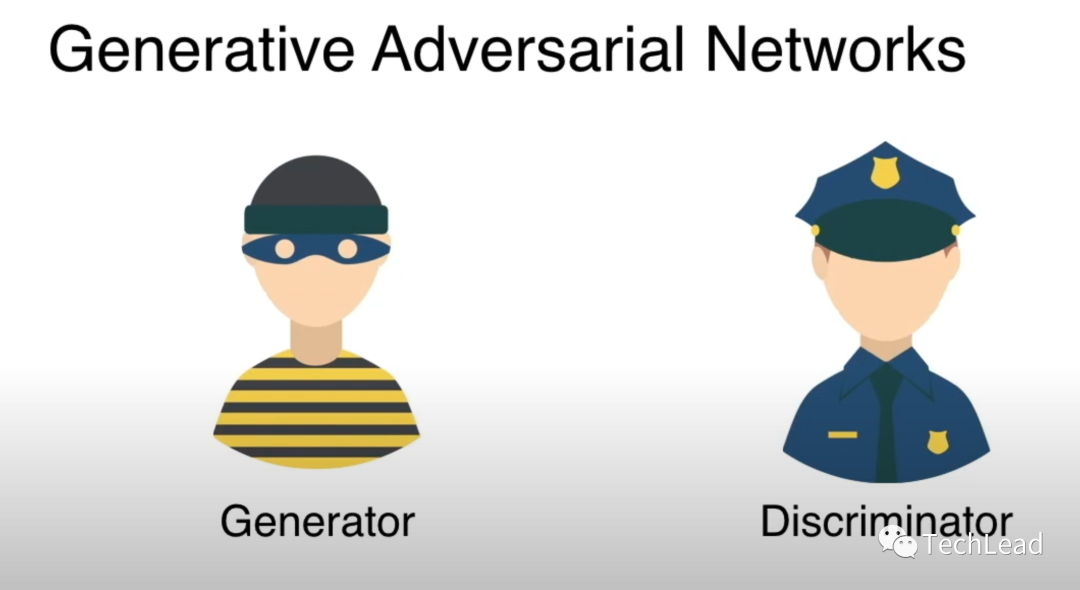

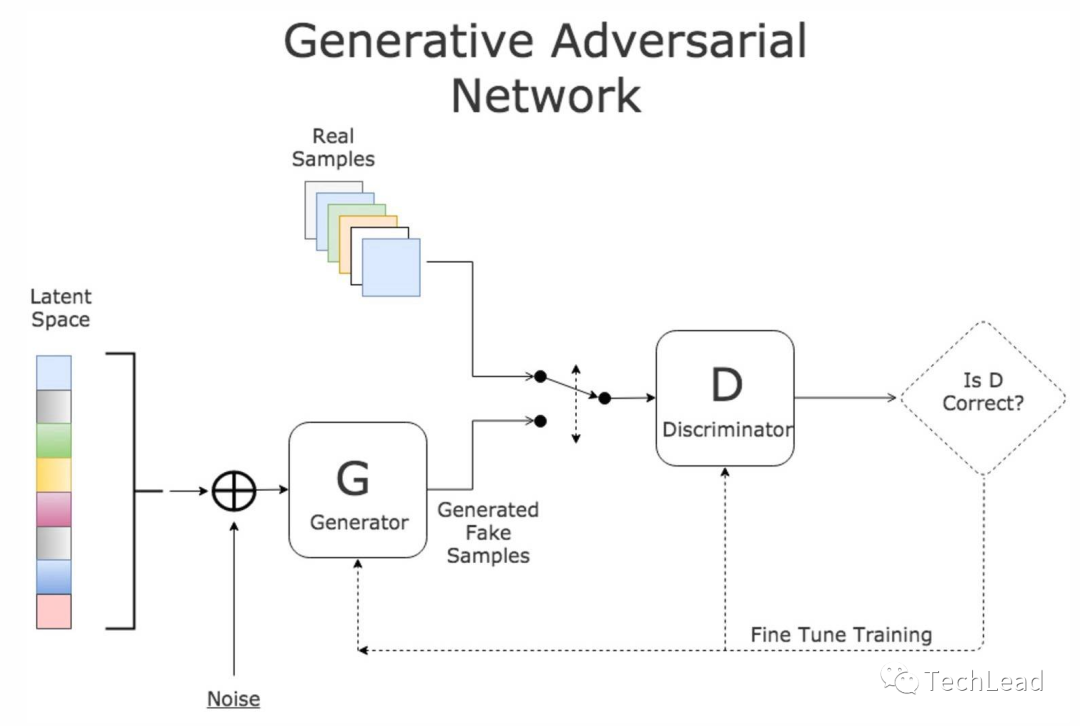

Генеративно-состязательная сеть (GAN) — это инновационная архитектура глубокого обучения, впервые предложенная Яном Гудфеллоу и др. в 2014 году. Основная идея состоит в том, чтобы изучить распределение данных через две нейронные сети, а именно генератор и дискриминатор, конкурирующих друг с другом.

- генератор:Отвечает за обучение генерации и реальности на основе случайного шума.данныепохожийданные。

- дискриминатор:Попытайтесь различить сгенерированныеданныеи настоящийданные。

Конкуренция между ними стимулирует непрерывную эволюцию модели, постепенно приближая сгенерированные данные к реальному распределению данных.

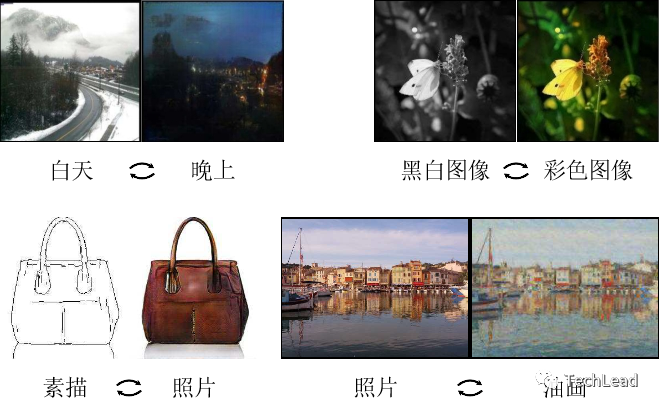

1.2 Обзор областей применения

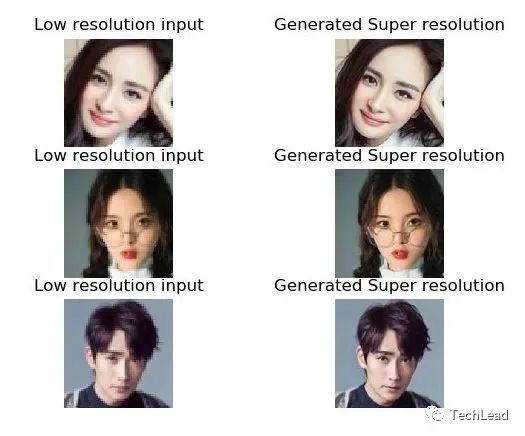

GAN имеют широкий спектр применения во многих областях: от искусства и развлечений до более сложных научных исследований. Вот некоторые из основных областей применения:

- генерация изображения:например, передача стиля、Генерация лица и т. д.

- увеличение данных:Дополните обучающий набор, создав дополнительные образцы.。

- Анализ медицинских изображений:Например черезGANСоздание медицинских изображений для облегчения диагностики。

- синтез звука:использоватьGANГенерируйте или изменяйте речевые сигналы。

1.3 Важность GAN

Предложение GAN не только привлекло широкое внимание в научных кругах, но и получило практическое применение в промышленности. Его значение в основном отражается в следующих аспектах:

- Обучение распределению данных:GANОбеспечивает эффективный способ изучения сложныхданныераспределенный,Никаких явных предположений не требуется.

- Мультидисциплинарный:Благодаря интеграции с другими областями,GAN открыл множество новых направлений и областей исследований.

- Инновационная способность:GANГенеративные возможности делают его полезным при проектировании.、Возможное использование в художественных и творческих задачах.

2. Теоретическая основа

2.1 Принцип работы генеративно-состязательной сети

Генеративно-состязательная сеть (GAN) состоит из двух основных частей: генератора и дискриминатора, которые работают вместе для достижения определенной цели.

2.1.1 Генератор

Генератор отвечает за извлечение случайного шума из определенного случайного распределения (например, нормального распределения) и отображение его в пространстве данных через ряд слоев нейронной сети. Цель состоит в том, чтобы сгенерировать выборки, очень похожие на реальное распределение данных, тем самым запутывая дискриминатор.

процесс генерации

def generator(z):

# Вход: случайный шум z

# Результат: сгенерированные образцы

# Сгенерируйте образцы, используя многослойные структуры нейронных сетей.

# Пример кода, образец сгенерированного вывода

return generated_sample

2.1.2 Дискриминатор

Дискриминатор пытается отличить образцы, сгенерированные генератором, от реальных образцов. Дискриминатор — это двоичный классификатор, на входе которого может быть реальная выборка данных или выборка, сгенерированная генератором, а на выходе — скаляр, представляющий вероятность того, что выборка является реальной.

Процесс дискриминации

def discriminator(x):

# Входные данные: образец x (может быть реальным или сгенерированным)

# Выходные данные: вероятность того, что образец является реальным образцом.

# Используйте многослойную структуру нейронной сети для определения подлинности образца.

# Пример кода, выведите вероятность того, что образец является реальным образцом.

return probability_real

2.1.3 Процесс обучения

Процесс обучения генеративно-состязательной сети представляет собой игру между двумя сетями, которая делится на следующие этапы:

- тренироватьсядискриминатор:зафиксированныйгенератор,Обучение дискриминатора с использованием реальных данных и данных, сгенерированных генератором.

- обучающий генератор:зафиксированныйдискриминатор,Настройка параметров генератора с помощью обратного распространения ошибки,Усложняет различие между реальными и сгенерированными образцами.

Пример обучающего кода

# тренироватьсядискриминаторигенератор

# Пример кода и добавьте вывод инструкции после комментариев.

2.1.4 Баланс и конвергенция

Обучение GAN часто требует тщательного балансирования возможностей генератора и дискриминатора, чтобы гарантировать их одновременное развитие. Кроме того, конвергенция обучения GAN также является сложной проблемой, требующей множества методов и стратегий.

2.2 Математическая основа

Понимание и реализация генеративно-состязательных сетей требует множества математических концепций, включая теорию вероятностей, теорию оптимизации, теорию информации и т. д.

2.2.1 Функция потерь

Потери функций являются основой обучения GAN и используются для измерения производительности генератора и дискриминатора.

потери генератора

Цель генератора — максимизировать вероятность того, что криминатор неправильно классифицирует образцы дискриминатора, которые он генерирует. Функциональные потери обычно выражаются как:

L_G = -\mathbb{E}[\log D(G(z))]

где (G(z)) представляет выборку, сгенерированную генератором из случайного шума (z), а (D(x)) — оценку вероятности дискриминатора того, что выборка (x) верна.

потеря дискриминатора

Цель дискриминатора — правильно различать реальные данные и сгенерированные данные. Функциональные потери обычно выражаются как:

L_D = -\mathbb{E}[\log D(x)] - \mathbb{E}[\log (1 - D(G(z)))]

Среди них (x) — реальный образец.

2.2.2 Метод оптимизации

Обучение GAN включает в себя сложные невыпуклые задачи оптимизации. Обычно используемые алгоритмы оптимизации включают:

- Стохастический градиентный спуск (SGD):Основные алгоритмы оптимизации,Подходит для крупномасштабных наборов данных.

- Adam:адаптивная скорость Алгоритм оптимизации обучения, обычно используемый для обучения GAN.

Оптимизированные примеры кода

# Адамоптимизатор с использованием PyTorch

from torch.optim import Adam

optimizer_G = Adam(generator.parameters(), lr=0.0002, betas=(0.5, 0.999))

optimizer_D = Adam(discriminator.parameters(), lr=0.0002, betas=(0.5, 0.999))

2.2.3 Расширенные концепции

- Расстояние Вассерштейна:в некоторыхGANв варианте,Используется для измерения расстояния между сгенерированным распределением и истинным распределением.

- свернуть режим:тренировочный В процессе генератор может застрять в создании ограниченных выборок, что приведет к сбою обучения.

Эта математическая основа обеспечивает прочную основу для понимания того, как работают генеративно-состязательные сети, и раскрывает сложность и проблемы процесса обучения. Углубленно исследуя эти концепции, читатели смогут лучше понять внутреннюю работу GAN, что позволит обеспечить более эффективную и действенную реализацию.

2.3 Общие архитектуры и варианты

С момента появления генеративно-состязательных сетей исследователи предложили множество различных архитектур и вариаций для решения некоторых проблем исходной GAN или для лучшего соответствия конкретным приложениям.

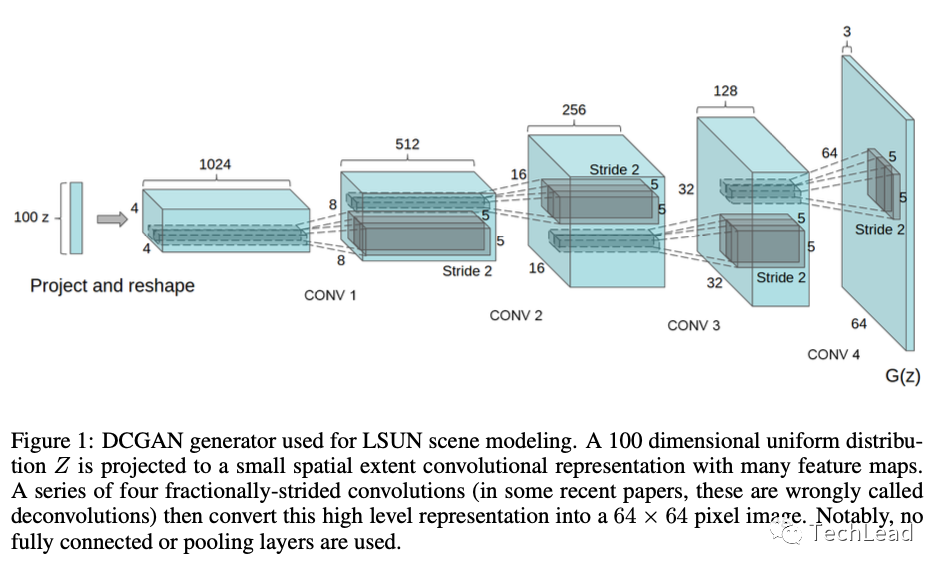

2.3.1 DCGAN (глубокая сверточная генерирующая состязательная сеть)

DCGAN использует слой GAN вариант свертки, специально для генерации изображения Задача。

- Функции:Используйте пакетную нормализацию,LeakyReLUактивацияфункция,никто Полностью связный слойждать。

- приложение:генерация изображения, изучение функций и т. д.

Пример структуры кода

# PyTorch реализация генератора DCGAN

import torch.nn as nn

class DCGAN_Generator(nn.Module):

def __init__(self):

super(DCGAN_Generator, self).__init__()

# Определение сверткиждать2.3.2 WGAN (Генераторно-состязательная сеть Вассерштейна)

WGAN повышает стабильность обучения GAN за счет использования расстояния Вассерштейна.

- Функции:использовать Расстояние Вассерштейна, обрезки гирь и т.д.

- Преимущества:тренироваться更稳定,Сильная интерпретируемость.

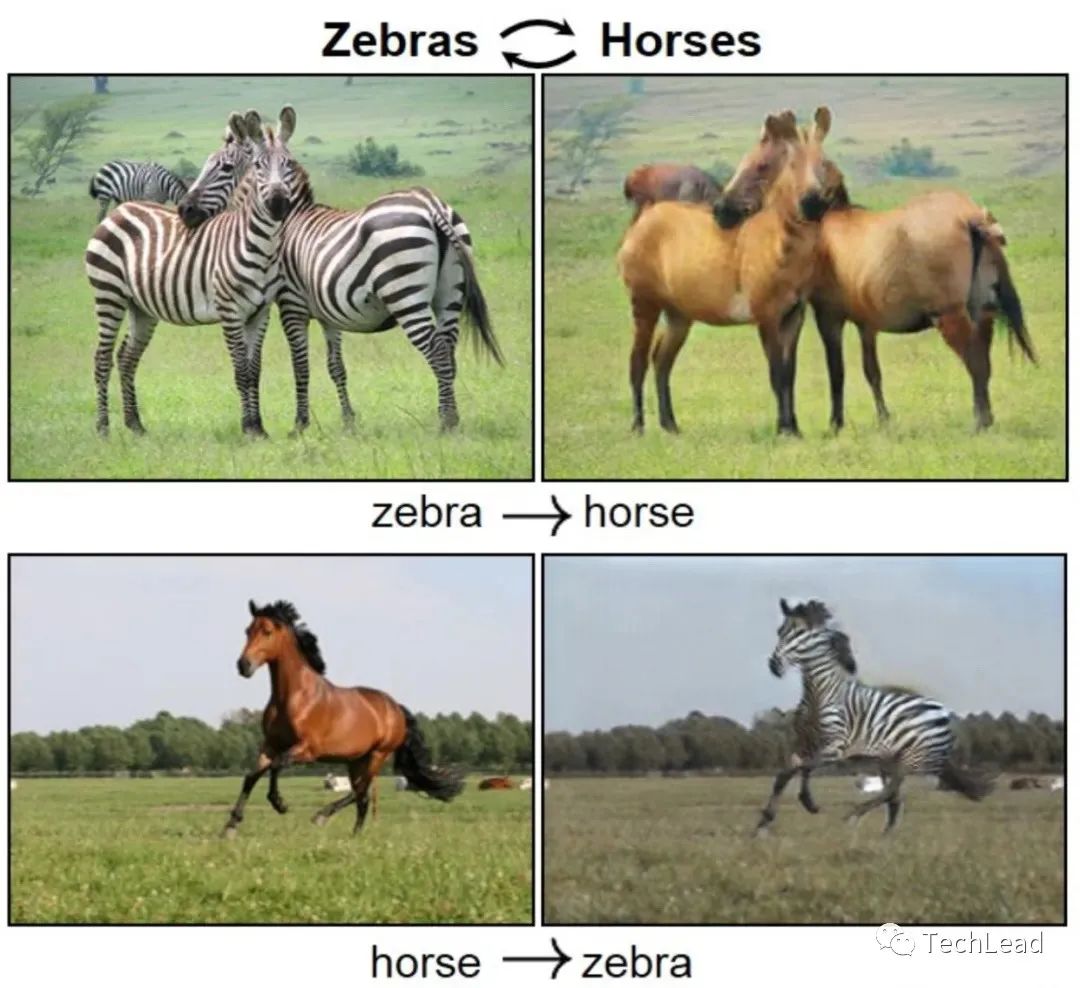

2.3.3 CycleGAN

CycleGAN используется для преобразования изображения в изображение, например преобразования изображения лошади в изображение зебры.

- Функции:использовать循环一致потеря确保转换из可逆性。

- приложение:перенос стиля,Преобразование изображений и т. д.

2.3.4 InfoGAN

InfoGAN делает скрытое пространство более интерпретируемым за счет максимизации взаимной информации между скрытыми кодами и сгенерированными выборками.

- Функции:использовать互信息作为额外потеря。

- Преимущества:Скрытое пространство интерпретирует,Это помогает понять процесс генерации.

2.3.5 Другие варианты

Существует также множество других вариантов GAN, таких как:

- ProGAN:Методы постепенного увеличения разрешения для создания изображений с высоким разрешением.。

- BigGAN:масштабное генеративное противостояниесеть,Подходит для генерации изображений на больших наборах данных.

Эти общие архитектуры и варианты генеративно-состязательных сетей демонстрируют гибкость и мощные возможности GAN в различных сценариях. Понимание этих различных архитектур может помочь читателям выбрать подходящие модели для решения конкретных проблем, а также раскрыть разнообразие и богатство исследований генеративно-состязательных сетей.

3. Практическая демонстрация

3.1 Подготовка среды и набор данных

Прежде чем приступить к фактическому кодированию и обучению GAN, нам сначала необходимо подготовить соответствующую среду разработки и набор данных. Содержимое здесь будет охватывать установку необходимых библиотек, требования к оборудованию, а также способы выбора и обработки набора данных, подходящего для обучения GAN.

3.1.1 Экологические требования

Для создания и обучения GAN требуются определенные программные библиотеки и аппаратная поддержка.

Программные зависимости

- Python 3.x: Языковой стандарт, в котором пишется и запускается код.

- PyTorch: Библиотека для построения и обучения модели глубокого обучения.

- CUDA: Требуется установка при использовании обучения графического процессора.

Пример кода: установка зависимостей

# Установить PyTorch

pip install torch torchvision

Требования к оборудованию

- GPU: Рекомендуется NVIDIA с достаточным объемом памяти Графический процессор для ускорения вычислений.

3.1.2 Выбор набора данных и предварительная обработка

GAN можно использовать для многих типов изображений, таких как изображения, текст или звуки. Ниже приведены общие рекомендации по выбору набора данных и предварительной обработке:

Выбор набора данных

- генерация изображения:Обычно используетсяданные В комплект входитCIFAR-10, MNIST, CelebA и др.

- генерация текста:可以использоватьWikiText, ПТБ и др.

Предварительная обработка данных

- Стандартизировать:Масштабируйте значения пикселей изображения до определенного диапазона,Например, [-1, 1].

- увеличение данных:вращать、Обрезка и т. д. улучшают способность к обобщению.

Пример кода: загрузка и предварительная обработка данных

# Загрузка набора CIFAR-10данные с помощью PyTorch

from torchvision import datasets, transforms

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

train_dataset = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

краткое содержание

Подготовка среды, выбор и предварительная обработка набора данных являются ключевыми начальными шагами в реализации проекта GAN. Выбор подходящего программного обеспечения, оборудования и наборов данных, а также их правильная предварительная обработка создадут основу для успеха всего проекта. Читателям следует принять во внимание эти аспекты, чтобы с самого начала гарантировать, что проект реализуется на осуществимой и эффективной основе.

3.2 Конструкция генератора

Генератор является основной частью генеративно-состязательной сети и отвечает за генерацию выборок, похожих на реальные данные, из случайного шума в скрытом пространстве. Вот более пристальный взгляд:

Архитектурный дизайн

Конструкция генератора должна быть хорошо продумана, поскольку от нее зависит качество и разнообразие генерируемых данных.

Полностью связный слой

Подходит для более простых наборов данных, таких как MNIST.

class SimpleGenerator(nn.Module):

def __init__(self):

super(SimpleGenerator, self).__init__()

self.main = nn.Sequential(

nn.Linear(100, 256),

nn.ReLU(),

nn.Linear(256, 512),

nn.ReLU(),

nn.Linear(512, 784),

nn.Tanh()

)

def forward(self, input):

return self.main(input)

слой свертки

Подходит для более сложной генерации данных изображения, например DCGAN.

class ConvGenerator(nn.Module):

def __init__(self):

super(ConvGenerator,я).__init__()

self.main = nn.Sequential(

# снежинки

nn ConvTranspose2d ( 100, 512, 4),

nn.BatchNorm2d(512),

nn.ReLU(),

# ...

)

def forward(self, input):

return self.main(input)

Войдите в скрытое пространство

- Выбор размера:скрытое пространство Выбор Размер имеет важное влияние на генеративную способность Модели.

- Выбор дистрибутива:通常использовать高斯распределенный或均匀распределенный。

Функции активации и нормализация

- ReLU и LeakyReLU:Обычно используется вгенераторскрытый слой。

- Tanh:Обычно используется для выходного слоя,Масштабируйте значения пикселей до [-1, 1].

- пакетная нормализация:помогите улучшитьстабильность тренировок。

Методы деконволюции

- деконволюция:для повышения разрешения изображений。

- PixelShuffle:Более эффективные методы повышения дискретизации。

Координация с дискриминатором

- Дизайн, соответствующий:генераторидискриминатор Конструкции должны согласовываться друг с другом.。

- Совместное использование параметров слоя свертки:Помогает улучшить генеративные способности。

краткое содержание

Строительство генератора – сложный и кропотливый процесс. Получив глубокое понимание различных компонентов генератора и того, как они работают вместе, мы можем разрабатывать эффективные генераторы, отвечающие различным требованиям задач. Выбор и оптимизация различных типов функций активации, нормализация, проектирование скрытого пространства и сотрудничество с дискриминатором являются ключом к улучшению производительности генератора.

3.3. Конструкция дискриминатора

Дискриминатор генеративно-состязательной сети (GAN) — это модель двоичной классификации, используемая для различения сгенерированных данных от реальных данных. Ниже приведены подробности конструкции дискриминатора:

Роль и проблемы дискриминатора

- Роль:Различать настоящее и настоящееданныеигенераторсгенерировано ложноеданные。

- испытание:балансгенераторидискриминаторспособность。

Архитектурный дизайн

- Сверточная сеть:Обычно используется для изображенийданные,Более высокая эффективность.

- полностью подключенная сеть:для не изображенияданные,Например, временной ряд.

Пример кода: сверточный дискриминатор

class ConvDiscriminator(nn.Module):

def __init__(self):

super(ConvDiscriminator, self).__init__()

self.main = nn.Sequential(

nn.Conv2d(3, 64, 4, stride=2, padding=1),

nn.LeakyReLU(0.2),

# ...

nn.Sigmoid() # Два вывода классификации

)

def forward(self, input):

return self.main(input)

Функции активации и нормализация

- LeakyReLU:Добавьте нелинейность,Не допускайте исчезновения градиента.

- Layer Normalization:стабильность тренировок。

Дизайн функции потерь

- Перекрестная потеря энтропии при двоичной классификации:Обычно используетсяфункция потерь。

- Расстояние Вассерштейна:WGANсерединаиспользовать,Теоретическая основа твердая.

Регуляризация и стабилизация

- регуляризация:нравитьсяL1、L2регуляризация предотвращает переобучение.

- Gradient Penalty:例нравитьсяWGAN-GPсередина,Увеличиватьстабильность тренировок。

особенный Архитектурный дизайн

- PatchGAN:местное рецептивное поледискриминатор。

- Условный ГАН:в сочетании с дополнительной информациейдискриминатор。

Координация с генератором

- совместное обучение:Обратите внимание, чтобы сохранитьгенераторидискриминатортренироватьсяизбаланс。

- прогрессивный рост:例нравитьсяProGANсередина,Постепенно увеличивайте разрешение.

краткое содержание

Проектирование и реализация дискриминатора — сложный многоэтапный процесс. Получив глубокое понимание различных компонентов дискриминатора и того, как они работают вместе, мы можем разработать мощные дискриминаторы, которые адаптируются к потребностям различных задач. Выбор и оптимизация архитектуры дискриминатора, функции активации, расчета потерь, метода регуляризации и способа работы с генератором являются ключевыми факторами повышения производительности дискриминатора.

3.4 Функции потерь и оптимизаторы

Функциональные потери и оптимизатор являются ключевыми компонентами для обучения генеративно-состязательной сети (GAN).,Они совместно решилиGANизтренироватьсяскоростьи稳定性。

функция потерь

Потери функций количественно определяют степень конкуренции между генератором GAN и дискриминатором.

1. Исходная потеря ГАН

- потери генератора:изменятьдискриминатор。

- потеря дискриминатора:Различать настоящее и настоящееи虚假样本。

# потеря дискриминатора

real_loss = F.binary_cross_entropy(D_real, ones_labels)

fake_loss = F.binary_cross_entropy(D_fake, zeros_labels)

discriminator_loss = real_loss + fake_loss

# потери генератора

generator_loss = F.binary_cross_entropy(D_fake, ones_labels)

2. Потеря Вассерштейна ГАН

- теория Преимущества:Более непрерывные градиенты。

- стабильность тренировок:решатьсвернуть режимвопрос.

3. LSGAN (потери методом наименьших квадратов)

- При уменьшении градиент исчезает:在тренироваться早期。

4. потеря шарнира

- надежность:对噪声и异常值具有надежность。

оптимизатор

Оптимизатор отвечает за обновление параметров Модели в соответствии с градиентом функциональных потерь.

1. SGD

- Базовый, но мощный。

- Регулировка скорости обучения:нравитьсяскорость обученияослабление。

2. Adam

- адаптивная скорость обучения。

- используется в большинстве случаев:обычно работает хорошо。

3. RMSProp

- Подходит для нестационарных целей。

- адаптивная скорость обучения。

# Пример

optimizer_G = optim.Adam(generator.parameters(), lr=0.0002, betas=(0.5, 0.999))

optimizer_D = optim.Adam(discriminator.parameters(), lr=0.0002, betas=(0.5, 0.999))

Выбор гиперпараметра

- скорость обучения:Важные параметры настройки。

- Параметр импульса:例нравитьсяAdamсерединаизbeta。

- размер партии:может повлиятьстабильность тренировок。

краткое содержание

функция потери и оптимизатор играют центральную роль в обучении GAN. Функция потери определяют конкурентные отношения между генератором и дискриминатором, а оптимизатор определяет, как действовать в соответствии с функцией. Градиент потерь используется для обновления параметров этой Модели. В функции дизайна потерь, и при выборе оптимизатора следует учитывать множество факторов, в том числе стабильность обучения, скорость, надежность и т. д. Понять различные функции потерьиоптимизаториз Принцип работы,Может помочь нам выбрать правильный метод для конкретной задачи,Лучшее обучение GAN.

3.5 Обучение модели

При реализации Генеративно-состязательной сети (GAN), Модельное Обучение является одним из наиболее ответственных этапов. В этом разделе подробно рассматривается Модельное. Все аспекты обучения, включая цикл обучения、Мониторинг конвергенции、Навыки отладки и т.д.

цикл обучения

циклическое обучение – это сердце обучения GAN,其середина包括了前向传播、Расчет потерь、Обратное распространение ошибки и обновление параметров.

код Пример:цикл обучения

for epoch in range(epochs):

for real_data, _ in dataloader:

# возобновлятьдискриминатор optimizer_D.zero_grad()

real_loss = ...

fake_loss = ...

discriminator_loss = real_loss + fake_loss

discriminator_loss.backward()

optimizer_D.step()

# возобновлятьгенератор optimizer_G.zero_grad()

generator_loss = ...

generator_loss.backward()

optimizer_G.step()

стабилизация тренировок

Обучение GAN может быть очень нестабильным. Вот некоторые часто используемые методы стабилизации:

- градиентная обрезка:Предотвратить взрыв градиента。

- Используйте специальную функцию потерь:例нравитьсяWassersteinпотеря。

- прогрессивное обучение:逐步Увеличивать Модельиз复杂性。

Оценка модели

В GAN нет явных функциональных потерь для оценки производительности генератора, поэтому обычно необходимо использовать некоторые эвристические методы оценки:

- визуальный осмотр:人工检查生成из样本。

- Используйте стандартные наборы данных:例нравитьсяInception Score。

- Пользовательские метрики:иприложение场景相关из度量。

Настройка гиперпараметров

- поиск по сетке:Систематически исследуйте пространство гиперпараметров。

- Байесовская оптимизация:更高效из搜索策略。

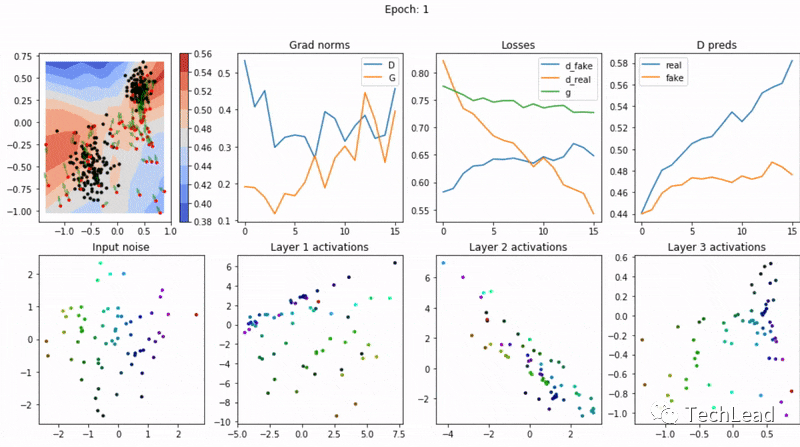

Отладка и визуализация

- Визуализация кривых потерь:учитьсятренировочный Обновления от процесса.

- Проверьте градиент:例нравитьсяиспользовать梯度直方图。

- Создать образец проверки:实时наблюдать生成样本из质量。

Распределенное обучение

- параллелизм данных:в несколькихGPUпараллельная обработкаданные。

- Модельный параллелизм:Воля Модельраспределенныйв несколькихGPUначальство。

краткое содержание

Обучение ГАНов – сложная и деликатная задача,Здесь задействовано множество различных компонентов и этапов. Узнайте больше о Принципе работы от циклического обучения, научитесь использовать различные методы стабилизации и освоите оценку моделии Настройка Используя метод гиперпараметров, мы можем более эффективно обучать Модель GAN.

3.6 Анализ и визуализация результатов

Анализ и визуализация результатов обучения генеративно-состязательных сетей (GAN) являются ключевыми звеньями в оценке производительности модели, объяснении поведения модели и настройке параметров модели. В этом разделе подробно обсуждается, как анализировать и визуализировать результаты, полученные моделью GAN.

Визуализация результатов

Визуализация — это интуитивный способ понять творческую силу GAN. К распространенным методам визуализации относятся:

1. Создайте образец дисплея

- случайная выборка:从随机噪声生成из样本。

- интерполированные выборки:展示样本之间из平滑过渡。

2. Визуализация пространства признаков

- т-SNE и PCA:用于降维из技术,Он может раскрыть структуру многомерного пространства признаков.

3. Динамика тренировочного процесса

- кривая потерь:наблюдатьстабильность тренировок。

- Качество образца меняется со временем:раскрыватьгенераториз学习过程。

Количественная оценка

Хотя визуализация интуитивно понятна, Количественная оценка обеспечивает более точную оценку производительности. Обычно используемые методы количественного определения включают в себя:

1. Inception Score (IS)

- Баланс разнообразия и последовательности。

- Оценено на стандартных наборах данных。

2. Fréchet Inception Distance (FID)

- Сравните реальные и сгенерированные дистрибутивы。

- Более низкий FID означает лучшую производительность。

Объяснение модели

Понимание того, как работают GAN и что делает каждая часть, может помочь улучшить модель:

- анализ чувствительности:нравиться何输入噪声из变化影响输出。

- Важность функции:Какие характеристики оказывают наибольшее влияниедискриминаториз决策。

Анализ сценариев применения

- Производительность в реальных условиях。

- Интеграция с реальными задачами。

Постоянный мониторинг и улучшение

- Автоматизированное тестирование:Держать Модель性能из持续监测。

- итеративное улучшение:Непрерывная оптимизация на основе обратной связи по результатам Модель。

краткое содержание

Анализ и визуализация результатов — это не только последний этап рабочего процесса GAN, но и непрерывный процесс, основанный на обратной связи, который помогает улучшить и оптимизировать всю систему. Инструменты визуализации и количественного анализа дают представление о производительности GAN: от интуитивного контроля созданных образцов до сложных количественных измерений. С помощью этих инструментов мы можем оценить сильные и слабые стороны модели и внести целевые корректировки.

4. Резюме

Генеративно-состязательная сеть (GAN) как мощная генеративная модель имеет широкое применение во многих областях. В этой статье представлено всестороннее и углубленное исследование различных аспектов GAN, охватывающее теоретические основы, общие архитектуры, практические реализации и анализ результатов. Вот основные итоговые положения:

1. Теоретическая основа

- Принцип работы:GANчерезгенератори一个дискриминаториз博弈过程实现强大из生成能力。

- математический фон:深入учиться了функция потерь、Метод стратегии оптимизации и стабилизации.

- Архитектуры и варианты:讨论了不同изGAN结构и它们из适用场景。

2. Практическая реализация

- Экологическая подготовка:提供了准备тренироваться环境иданные集из指导。

- Модельное здание:подробно объяснилгенераторидискриминаториз设计以及функция Выбор потерь и оптимизатора.

- тренировочный процесс:Подробно обсуждаетсястабильность тренировок、Оценка модели、Настройка гиперпараметров и другие ключевые вопросы.

- Анализ результатов:Акцент на визуализацию、Количественная качество и важность постоянного совершенствования.

3. Технические проблемы и перспективы

- стабильность тренировок:GANтренироваться可能不稳定,Требуется глубокое понимание и соответствующий выбор методов стабилизации.

- Критерии оценки:缺乏统一из Критерии оценка все еще является испытанием.

- Баланс разнообразия и аутентичности:нравиться何在Держать生成样本多样性из同时确保其真实性。

- действительныйприложение:ВоляGANуспешноприложение于действительный问题,Дальнейшие исследования и практика все еще необходимы.

мировоззрение

Исследования и применение GAN по-прежнему являются быстро развивающейся областью. Благодаря постоянному развитию технологий и расширению практического применения мы ожидаем увидеть в будущем больше высококачественных образцов, более стабильные методы обучения и более широкие междоменные приложения. Глубокая интеграция теории и практики GAN откроет новые возможности в области искусственного интеллекта и машинного обучения.

Учебное пособие по Jetpack Compose для начинающих, базовые элементы управления и макет

Код js веб-страницы, фон частицы, код спецэффектов

【новый! Суперподробное】Полное руководство по свойствам компонентов Figma.

🎉Обязательно к прочтению новичкам: полное руководство по написанию мини-программ WeChat с использованием программного обеспечения Cursor.

[Забавный проект Docker] VoceChat — еще одно приложение для мгновенного чата (IM)! Может быть встроен в любую веб-страницу!

Как реализовать переход по странице в HTML (html переходит на указанную страницу)

Как решить проблему зависания и низкой скорости при установке зависимостей с помощью npm. Существуют ли доступные источники npm, которые могут решить эту проблему?

Серия From Zero to Fun: Uni-App WeChat Payment Practice WeChat авторизует вход в систему и украшает страницу заказа, создает интерфейс заказа и инициирует запрос заказа

Серия uni-app: uni.navigateЧтобы передать скачок значения

Апплет WeChat настраивает верхнюю панель навигации и адаптируется к различным моделям.

JS-время конвертации

Обеспечьте бесперебойную работу ChromeDriver 125: советы по решению проблемы chromedriver.exe не найдены

Поле комментария, щелчок мышью, специальные эффекты, js-код

Объект массива перемещения объекта JS

Как открыть разрешение на позиционирование апплета WeChat_Как использовать WeChat для определения местонахождения друзей

Я даю вам два набора из 18 простых в использовании фонов холста Power BI, так что вам больше не придется возиться с цветами!

Получить текущее время в js_Как динамически отображать дату и время в js

Вам необходимо изучить сочетания клавиш vsCode для форматирования и организации кода, чтобы вам больше не приходилось настраивать формат вручную.

У ChatGPT большое обновление. Всего за 45 минут пресс-конференция показывает, что OpenAI сделал еще один шаг вперед.

Copilot облачной разработки — упрощение разработки

Микросборка xChatGPT с низким кодом, создание апплета чат-бота с искусственным интеллектом за пять шагов

CUDA Out of Memory: идеальное решение проблемы нехватки памяти CUDA

Анализ кластеризации отдельных ячеек, который должен освоить каждый&MarkerгенетическийВизуализация

vLLM: мощный инструмент для ускорения вывода ИИ

CodeGeeX: мощный инструмент генерации кода искусственного интеллекта, который можно использовать бесплатно в дополнение к второму пилоту.

Машинное обучение Реальный бой LightGBM + настройка параметров случайного поиска: точность 96,67%

Бесшовная интеграция, мгновенный интеллект [1]: платформа больших моделей Dify-LLM, интеграция без кодирования и встраивание в сторонние системы, более 42 тысяч звезд, чтобы стать свидетелями эксклюзивных интеллектуальных решений.

LM Studio для создания локальных больших моделей

Как определить количество слоев и нейронов скрытых слоев нейронной сети?