Эта статья даст вам полное представление об алгоритме адаптивного повышения AdaBoost | ключевые моменты, основные принципы, преимущества, недостатки и практическое применение AdaBoost.

1. Ключевые моменты

AdaBoost,то есть адаптивное улучшение(Adaptive Boosting)алгоритмизаббревиатура,это своего рода Boosting Стратегия ансамблевого метода обучения,направленный наУменьшить предвзятость。AdaBoost из «Адаптивный» Второе слово означает, что он может корректировать экземпляр обучающих данных и ссосре доточиться после каждой итерации. на степень (особенно те выборки, которые ранее были неверно предсказаны) и обновляют веса слабых учащихся.

и Случайный лес аналогичен,AdaBoost также является одним из типичных инструментов интегрированного обучения.,и относится кКлассификацияивозвращатьсяЗадача。Boosting методы последних летиз Несколькоданные Отличные результаты на соревнованияхизсчет,Идея, стоящая за этим, не сложна. Метод построен в простой и понятной форме, состоит из шагов из Модель.,Эти простые инструменты затем объединяются в мощные обучающие программы.

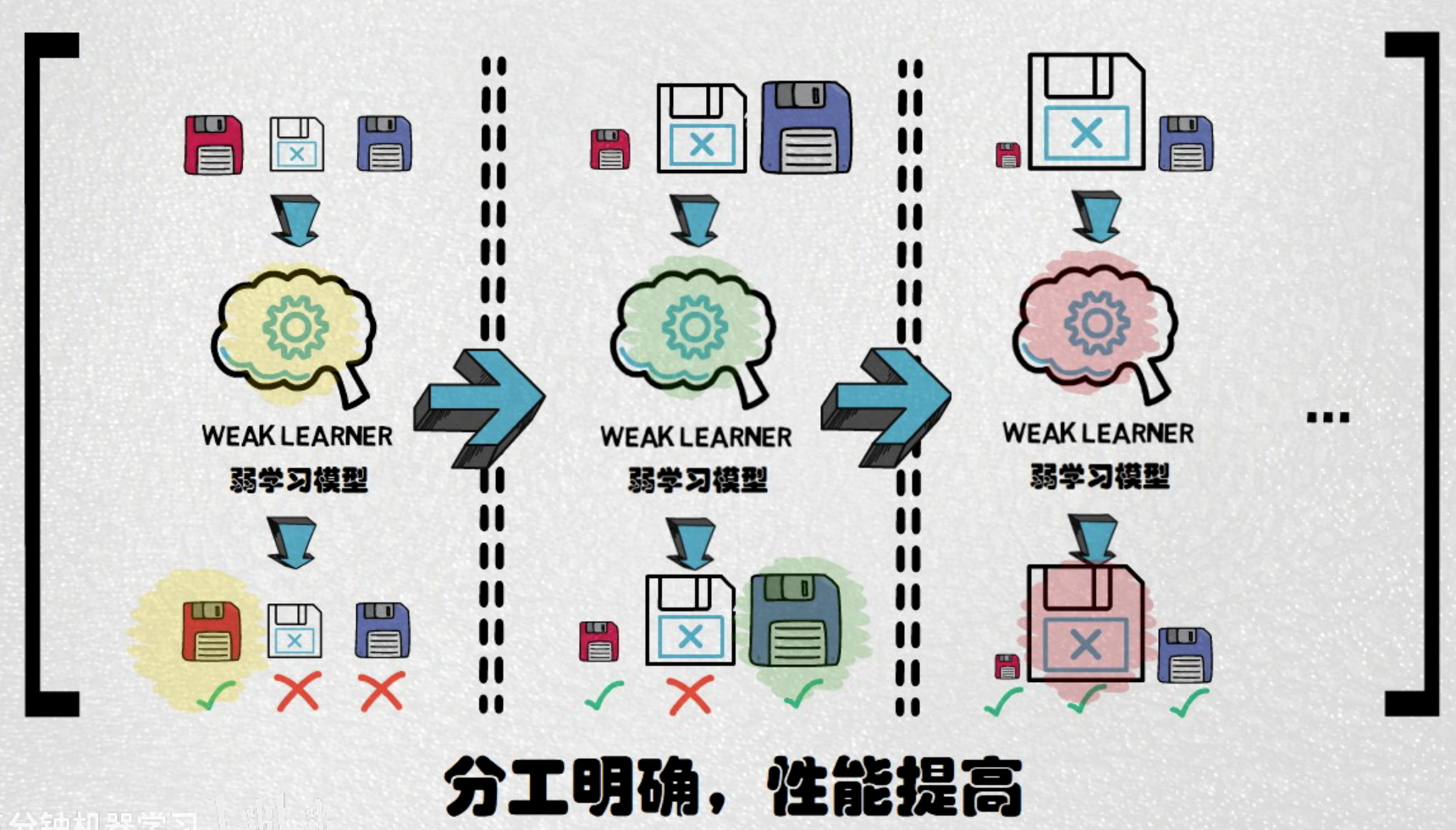

когда Bagging Если метод не работает эффективно, это может привести к тому, что все генераторы классификации будут выдавать неправильные результаты классификации в одной и той же области. Повышение За методомиз Интуитивная идея – это,Нам нужно обучать модель последовательно, а не параллельно.。каждый Модельследует сосредоточиться на предыдущем Классификация Плохая производительностьизплощадь образца。По сравнению с каждым деревом в случайном лесу решенийизвзаимная независимость,AdaBoost демонстрирует последовательное обучение и каскадную структуру.。существовать AdaBoost , последующее обучение Модельиз основано на предыдущем результате прогнозирования Модельиз, образуя отношение зависимости. этот каскадный метод позволяет AdaBoost Сосредоточьтесь больше на решении проблемы, с которой ранее не удавалось правильно спрогнозировать выборки, и постепенно оптимизируйте прогнозирование производительности. Ада Буст Голос каждого слабого ученика полностью учитывается, что отличается от случайного леса и простого голосования для расчета среднего значения.

AdaBoost изосновная идеясуществовать В:Обновляйте веса выборки и веса слабых учащихся после каждой итерации.(здесьиз Слабые ученики обычно используютдерево решенийкуча,дерево Стопка решений относится к одному слою дерева решений), тем самым достигая общей производительности, оптимизации и улучшения. Основная логика заключается в «Предки сажали деревья, а будущие поколения наслаждаются тенью». То есть старшее поколение создает условия для молодого поколения, а молодое поколение на этой основе совершенствуется. существовать AdaBoost , мы сначала обучаем слабого ученика и оцениваем его прогноз производительности. После каждой итерации мы обновляем выборку по весу, то есть меняем выборку по сложности. Уменьшите количество правильно предсказанных выборок на, в то время как ошибка прогноза по выборке увеличивается на, чтобы новая Модель могла больше сосредоточиться на преодолении неспособности предыдущей из Модели правильно прогнозировать сложные выборки.

финальный,Мы присваиваем разные веса разным слабым ученикам,и эффективно комбинировать их,Успешно построена мощная модель ансамблевого обучения. Эта модель интеграции охватывает не только работу с простыми образцами, но и модель,Также включает обработку сложных образцов.из Модель。Таким образом, AdaBoost значительно улучшает возможности прогнозирования Моделииз.。

[Примечание: прилагаемое изображение представляет собой скриншот из B стоять UP хозяин —— Пять минут машинного обученияизв видеоизопределенная часть,Ссылка на видео есть:https://www.bilibili.com/video/BV1iA411e76Y/。очень хорошийизделиться,Ставьте лайк и голосуйте за поддержку. 】

2. Основные принципы и процесс моделирования AdaBoost.

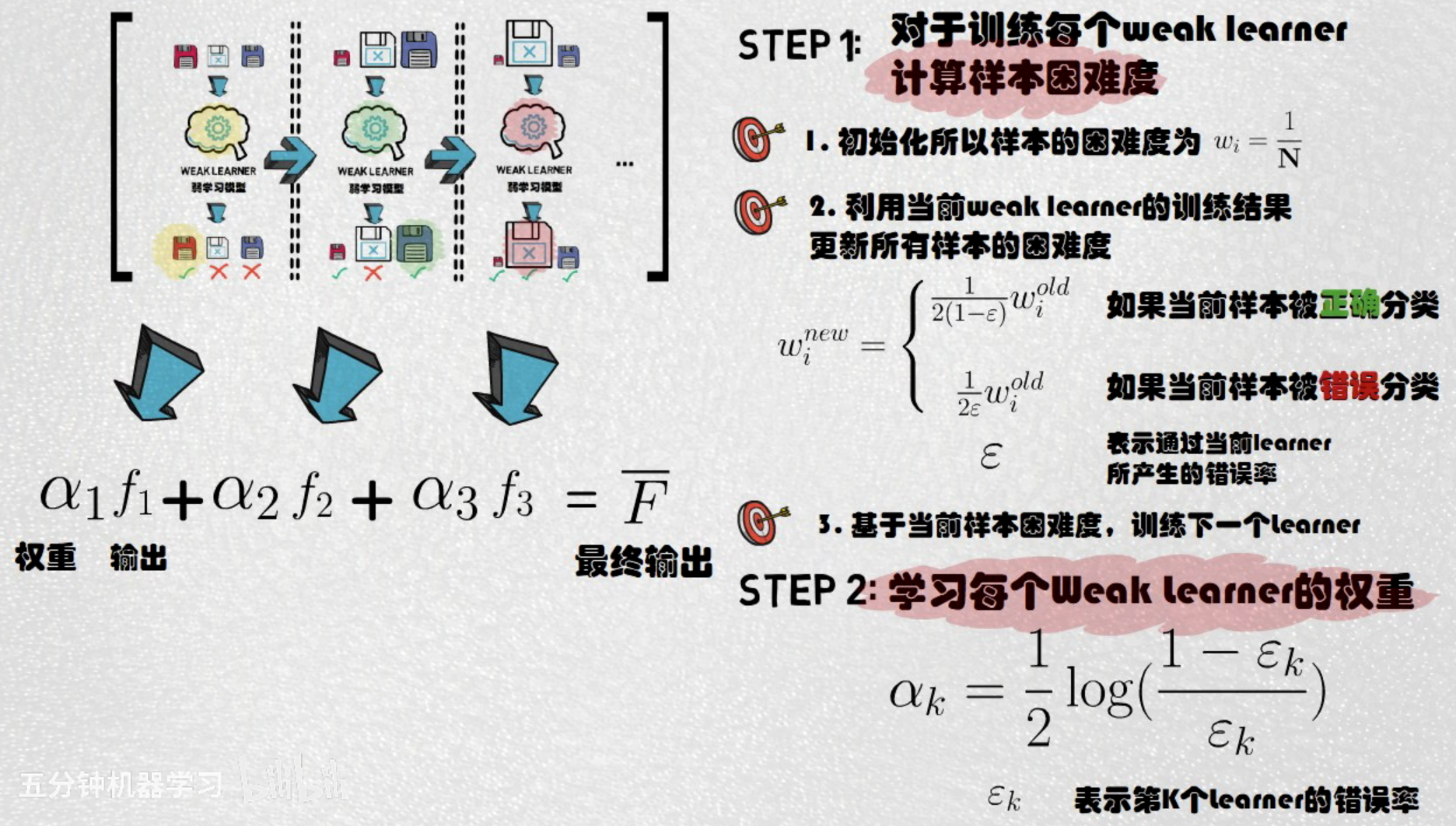

Наша первая задача — как оценить сложность выборки.。в целом,Во время обучения AdaBoost из первой модели,Мы присвоим значение сложности каждой точке выборки.,Это значение равноданныеконцентрированныйОбщее количество образцов из обратных。Первый после тренировки Модельназад,Мы оценим все точки отбора проб,Узнайте предсказанные правильные и неправильные выборки. Для правильного прогноза по выборке,Мы уменьшим его значение сложности и ошибки прогнозирования по выборкам;,затем увеличьте значение сложности。Обновлять веса выборки после каждой итерации。

На этом основании,Обучаем вторую Модель,и снова оцените все точки выборки. С момента обучения второй Модели,Мы улучшили баллы на сложных образцах, сосредоточьтесь на,Поэтому некоторые из ранее неправильно предсказанных выборок теперь могут быть предсказаны правильно.。Мы используемисначала тренируйся Модельтакой жеиз Стратегия:Правильно для прогнозаизобразец,Уменьшите значение сложности для ошибки прогнозирования по выборкам;,увеличьте значение сложности(Это эквивалентно корректировке распределения обучающих данных.)。Этот процесс будет продолжаться,пока оно не дойдет до насПредустановленное количество учащихся。К тому времени,AdaBoost будет содержать несколько моделей.

Объедините разных слабых учащихся, присвоив им разные веса.。большинствоназад,Нам необходимо интегрировать каждый результат Моделиза. Отличие от простого голосования и расчета среднего значения в случайном лесу,AdaBoost необходимо оценить производительность прогнозирования каждой модели.,Определить вес разных слабых учеников.。большинствоназад,Используйте эти веса, чтобы разделить всех слабых учащихся наиз Результат интегрирован в единое целое。Выше это обучение AdaBoost из Базовая логика.

AdaBoost использоватьэкспоненциальная функция потерь(exponential loss function):

в,

— фактическая метка (принимает значение -1 или 1),

это образец пары моделей

изпрогнозируемое значение。AdaBoost обучает каждого слабого ученика, минимизируя взвешенную экспоненциальную потерю.,и корректируяобразец Сосредоточьтесь на весесосредоточиться Ошибка велика по выборке. хотя AdaBoost в целом Не используйте градиентный спуск напрямую для оптимизации функции потерь.,Но этот процесс можно рассматривать как особую форму градиентного спуска. Конкретно,В каждом раунде выбирается слабый обучающийся, чтобы минимизировать сумму взвешенных экспоненциальных потерь для всех предыдущих выборок, когда,Это можно рассматривать как шаг к уменьшению общей ошибки в пространстве потерь.

По сравнению с каждым деревом в случайном лесу решенийизвзаимная независимость,AdaBoost демонстрирует последовательное обучение и каскадную структуру.。случайный лесизпроизводительностьограничен своей параллельной структурой,что приводит к относительно низкому потолку производительности,Похоже на сотрудничество трёх отморозков,Хотя есть улучшение,Но когда сталкиваешься с особенно трудными задачами, на него все равно невозможно дать правильный ответ. И в Ада Бост,Последующее обучение Моделиза основано на предыдущем результате предсказания Моделиза.,зависимости формы。Этот каскадный метод позволяет AdaBoost больше фокусироваться на изучении образцов, которые ранее не могли быть правильно предсказаны.,Оптимизируйте прогнозы шаг за шагомпроизводительность。AdaBoost полностью учитывает голос каждого слабого ученика,Отличается от случайного леса простым голосованием или вычислением среднего значения.

Это означает, что для сложных данных,Модельиз предсказывает, что производительность может быть ограничена за пределами случайного леса。Однако,Чрезмерное стремление к правильным прогнозам для сложных выборок,Иногда это может привести к переобучению модели.,сделать его уязвимым для исключенийобразец点过В敏感。AdaBoost изпроизводительность имеет более высокий верхний предел, но также и нижний нижний предел. Кроме того, из-за AdaBoost из Специальная структура,Последующее обучение Модельиз основано на предыдущем результате прогнозирования Модельиз.,Это приводит к МодельизСкорость обучения относительно низкая。

AdaBoost можно использовать в дополнение к задачам классификации.,также может быть выполненопрогноз регрессии(Прямо сейчас AdaBoost.R2),Хотя в миссиях это не распространено. В AdaBoost появился,Функция потерь может использовать взвешенную среднеквадратическую ошибку.,Эта ошибка количественно определяет разницу между истинным значением и прогнозируемым значением. как метаоценщик,AdaBoost возвращатьсяустройствопервыйсуществоватьоригинальныйданные Сосредоточьтесь на подготовке фундаментавозвращатьсяустройство,Затем обучите несколько реплик этого процесса на одном и том же наборе данных.,AdaBoost В каждый момент обучения веса выборки корректируются на основе предыдущей ошибки прогнозирования. Поэтому последующее извозвращаться будет более сосредоточенно. Эти ошибки прогнозирования представляют собой большие и сложные выборки.

3. Преимущества и недостатки AdaBoost

AdaBoost из Преимущества:

- Высокая точность:проходитьсуществоватькаждая итерацияназад Приспосабливайтесь к тренировкамданные Примеризсосредоточиться (особенно те выборки, которые ранее были неверно предсказаны) и обновляют веса слабых учащихся и, наконец, объединяют разных слабых учащихся с разными весами для вывода окончательного результата прогнозирования. Ада Буст Обычно можно добиться лучших прогнозов.

- Легко кодировать:По сравнению с другими комплексамиалгоритм,AdaBoost алгоритм легко реализовать. А параметры по умолчанию позволяют добиться хороших результатов.

- Автоматически обрабатывать выбор функций:AdaBoost Действительные функции могут выбираться автоматически, а нерелевантные или шумные функции игнорироваться.

- гибкость:Можетиразличные типыданныеи不同类型问题配合использовать。

- Меньше склонен к переоснащению:существоватьво многих практиках,Несмотря на дополнительную сложность,но AdaBoost Зачастую переобучиться непросто.

AdaBoost из Недостаточно:

- чувствительность к шуму:шуметьи Чувствителен к выбросам。потому чтоалгоритмдаст неправильные прогнозыобразецбольший вес,Поэтому шум и выбросы могут привести к плохой работе модели.

- Большой объем расчета:Хотя один Модель Может Может быть простым,но Необходимо тренировать несколько последовательно Модель Может Может привести к увеличению объема вычислений。потому что AdaBoost Это итеративный метод, который требует последовательного обучения большого числа слабых учеников, поэтому при работе с крупномасштабными многомерными функциями объем вычислений может стать довольно большим.

- Проблема дисбаланса данных:существовать Столкнувшись с крайним дисбалансомданныевремя производительности Можетплохая производительность。

По сути, AdaBoost — это простой и эффективный изалгоритм.,Подходит в качестве отправной точки для решения задач Классификациииз. Однако,при подаче заявления,Обратите внимание на его чувствительность к шуму и выбросам.

4. Практическое применение AdaBoost

система распознавания лиц:Представьте себе систему контроля доступа, которой необходимо распознавать лица, чтобы решить, разрешить ли вход.。каждый Человеческие лица имеют множество характеристик:размер глаз、форма носа、Положение рта и т. д. AdaBoost можно сделать шаг за шагом "сосредоточиться на" Трудно различать части человеческих лиц (например, у некоторых людей глаза похожи по форме), а точность системы в распознавании лиц постепенно улучшается.

кредитный рейтинг:Банку необходимо решить, одобрить ли заявку на кредит.。их Может以использовать AdaBoost Чтобы спрогнозировать вероятность дефолта заявителя путем объединения нескольких простых показателей (например, на основе таких факторов, как возраст заявителя, доход, кредитная история и т. д.). Благодаря непрерывной итерации AdaBoost Возможность более точно определить, какие клиенты являются заемщиками с меньшими рисками безопасности.

Прогноз оттока клиентов:компанияв целом О каких клиентах вы хотите знать?Может能会停止использовать其服务илипродукт。использовать AdaBoost Анализируйте данные клиентов (включая историю покупок). использования услуги、Отзывы клиентов и т.д.),Может помочь компаниям выявить потенциальных потерянных клиентов,и принять меры для их сохранения.

AdaBoost Это мощный и гибкий инструмент машинного обучения, который широко используется во многих областях. Он непрерывно повторяет и обновляет выборку и веса слабых обучающихся после каждой итерации, объединяя разных слабых обучающихся с разными весами для вывода окончательного результата прогнозирования. Этот метод эффективно повышает точность и надежность прогноза. Будь то распознавание лиц, кредитный рейтингвсе еще Прогноз оттока клиенты и другие вопросы, AdaBoost может предложить эффективные решения.

📚️ Ссылки по теме:

- [Пять минут машинного обучения] Adaboost: Люди в прошлом сажали деревья, а люди в будущем смогут наслаждаться тенью.

- Самый полезный метод повышения в машинном обучении: повышение и AdaBoost

- Подробное объяснение принципа алгоритма AdaBoost и процесса построения за 7 шагов (с кодом)

- AdaBoost алгоритм расшифровки: комплексный анализ от основ до применения

- CAO Ying, MIAO Qi-Guang, LIU Jia-Chen, GAO Lin. Advance and Prospects of AdaBoost Algorithm. ACTA AUTOMATICA SINICA, 2013, 39(6): 745-758. doi: 10.3724/SP.J.1004.2013.00745

Знание создания образов Docker: подробное объяснение команды Dockerfile.

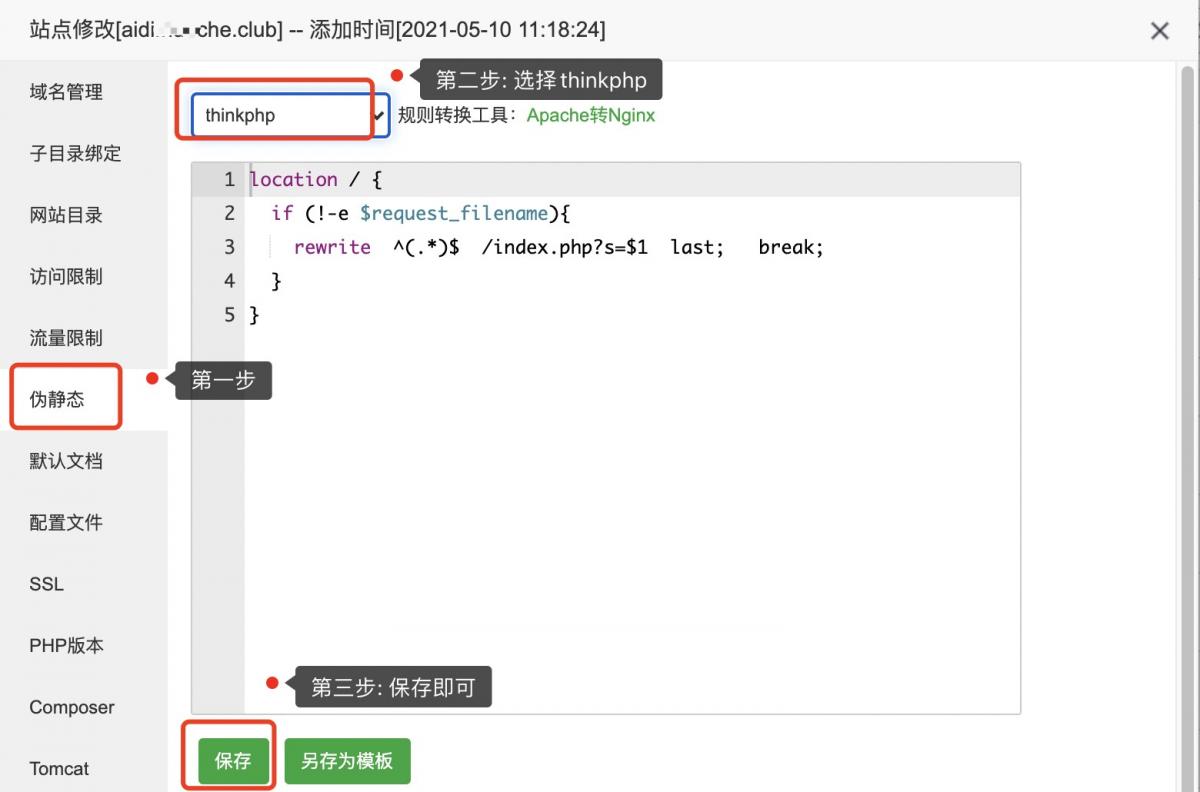

Псевдостатическая конфигурация ThinkPHP

Код изображения для загрузки апплета WeChat: последний доступный (код серверной части + код внешнего интерфейса)

Используйте растровое изображение Redis для реализации эффективной функции статистики регистрации пользователей.

[Nginx29] Обучение Nginx: буфер прокси-модуля (3) и обработка файлов cookie

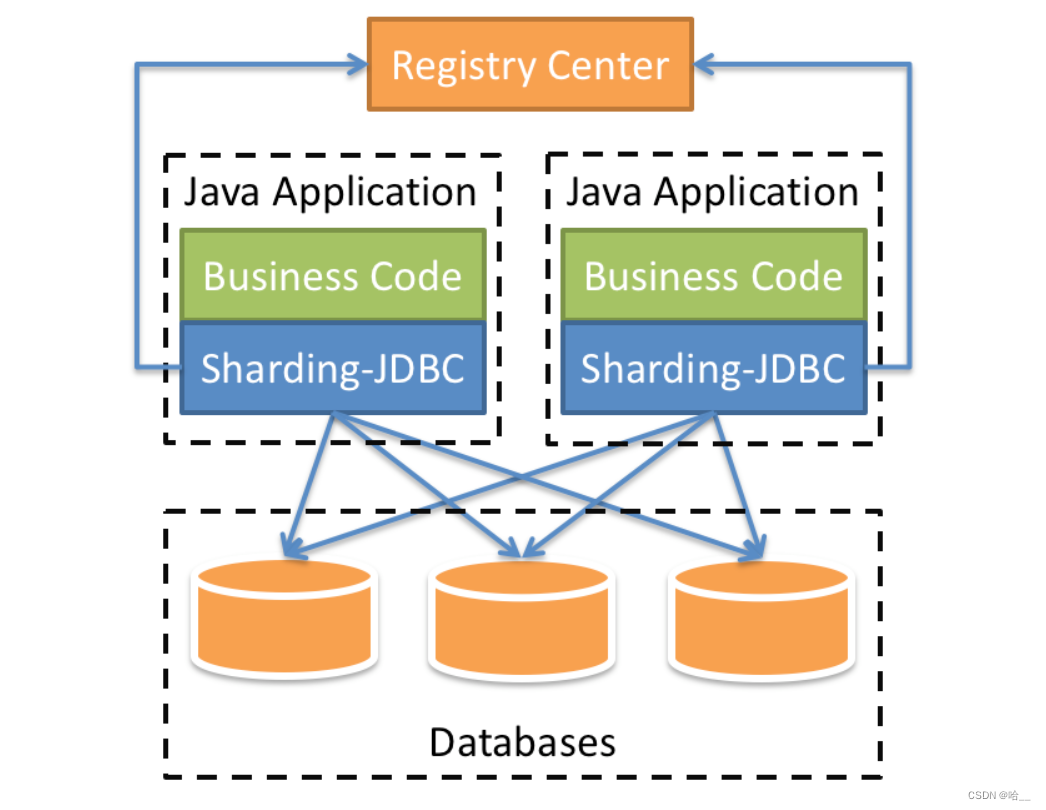

[Весна] SpringBoot интегрирует ShardingSphere и реализует многопоточную вставку 10 000 фрагментов данных в пакетном режиме (выполнение операций с базой данных и таблицами).

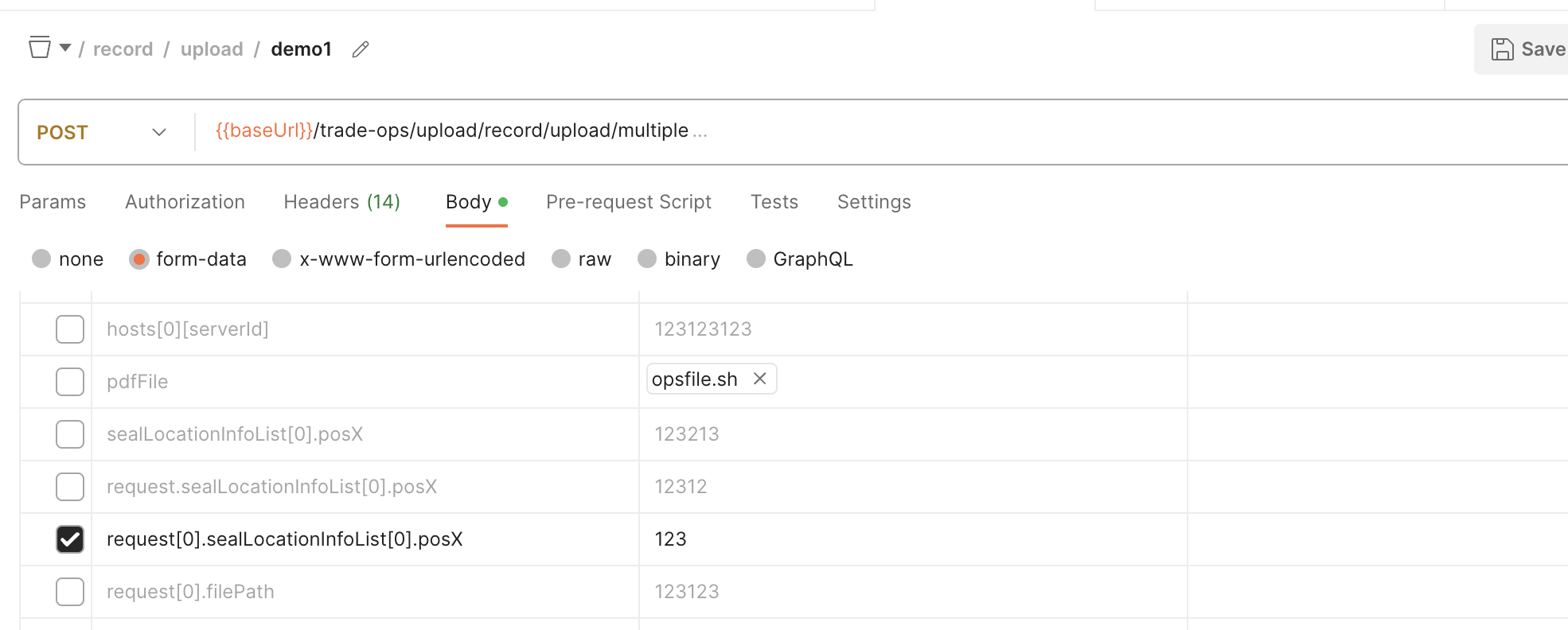

SpringBoot обрабатывает форму данных формы для получения массива объектов

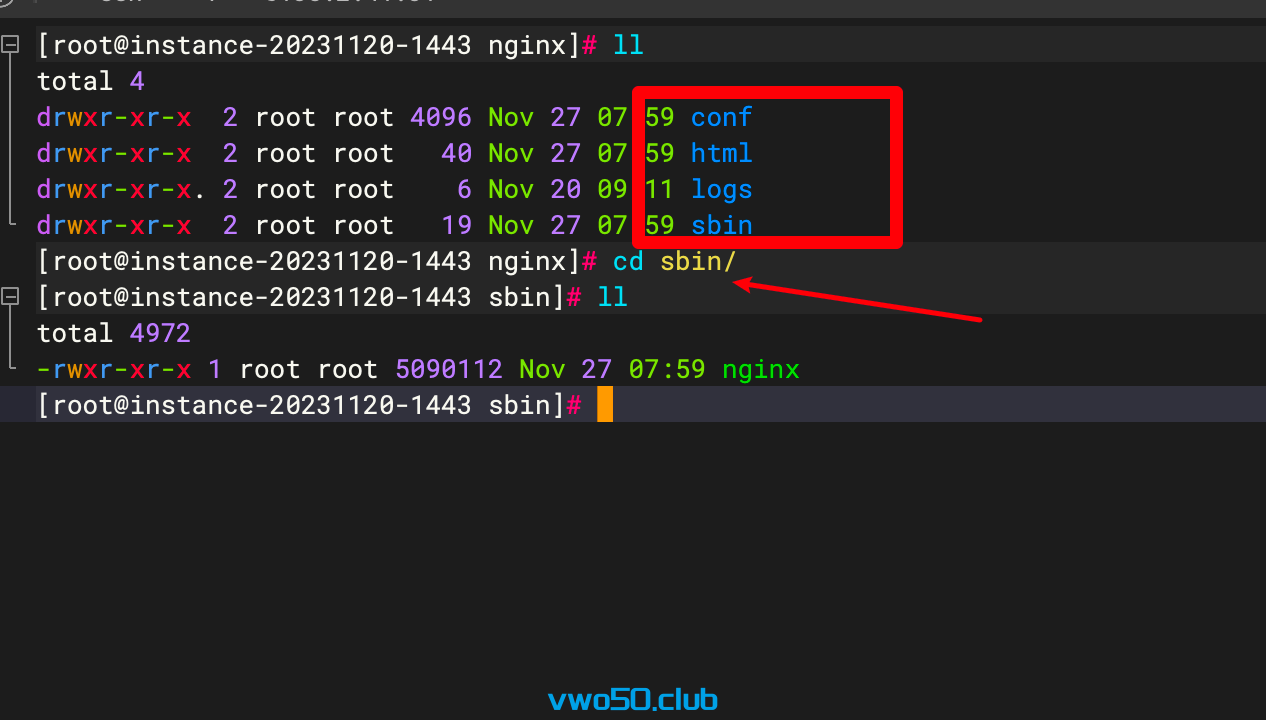

Nginx от новичка до новичка 01 - Установка Nginx через установку исходного кода

Проект flask развертывается на облачном сервере и получает доступ к серверной службе через доменное имя.

Порт запуска проекта Spring Boot часто занят, полное решение

Java вызывает стороннюю платформу для отправки мобильных текстовых сообщений

Практическое руководство по серверной части: как использовать Node.js для разработки интерфейса RESTful API (Node.js + Express + Sequelize + MySQL)

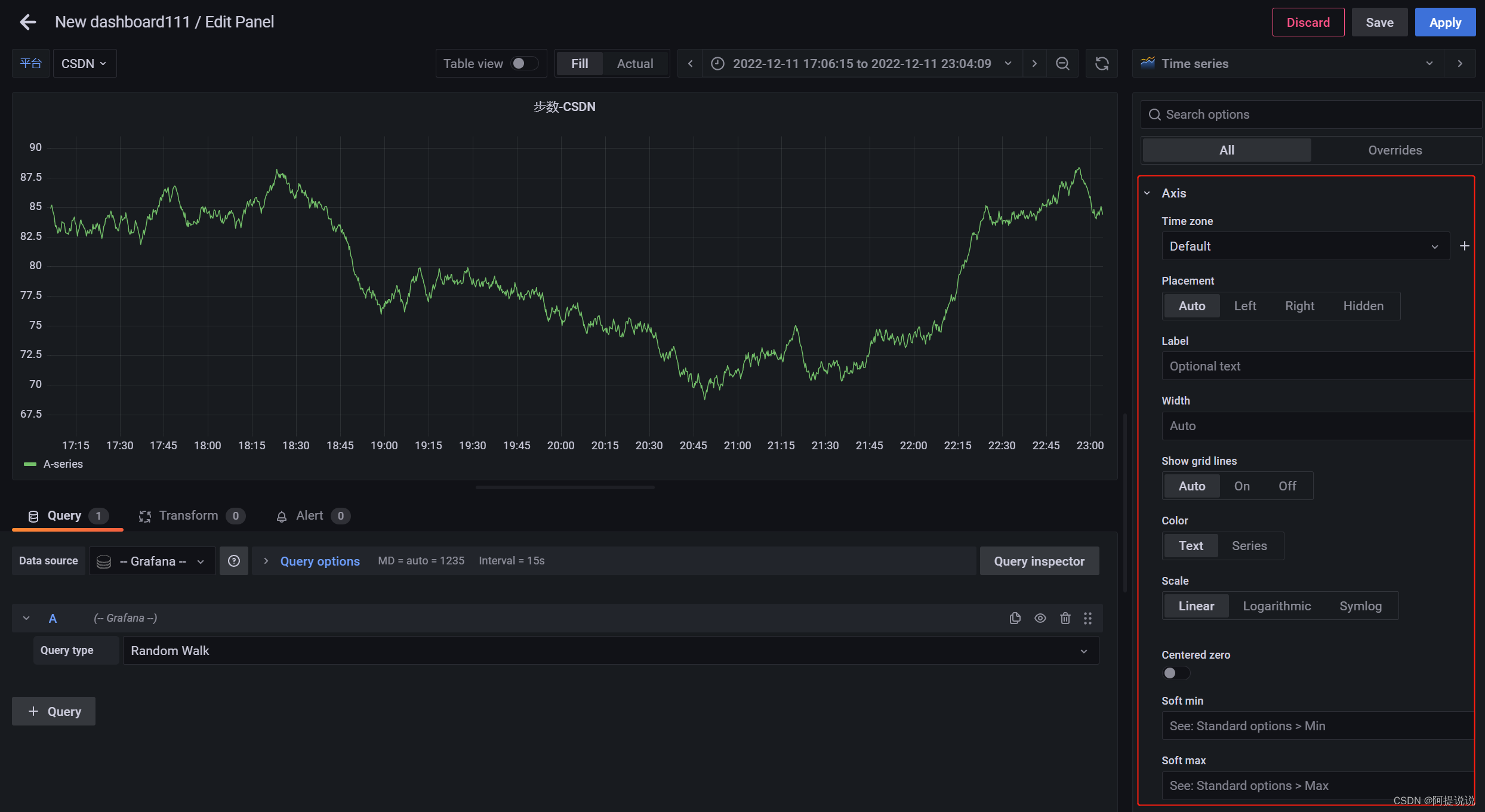

Введение в параметры конфигурации большого экрана мониторинга Grafana (2)

В статье «Научно-популярная статья» подробно объясняется протокол NTP: анализ точной синхронизации времени.

Пример разработки: серверная часть Java и интерфейсная часть vue реализуют функции комментариев и ответов.

Nodejs реализует сжатие и распаковку файлов/каталогов.

SpringBootИнтегрироватьEasyExcelСложно реализоватьExcelлистимпортировать&Функция экспорта

Настройка среды под Mac (используйте Brew для установки go и protoc)

Навыки разрешения конфликтов в Git

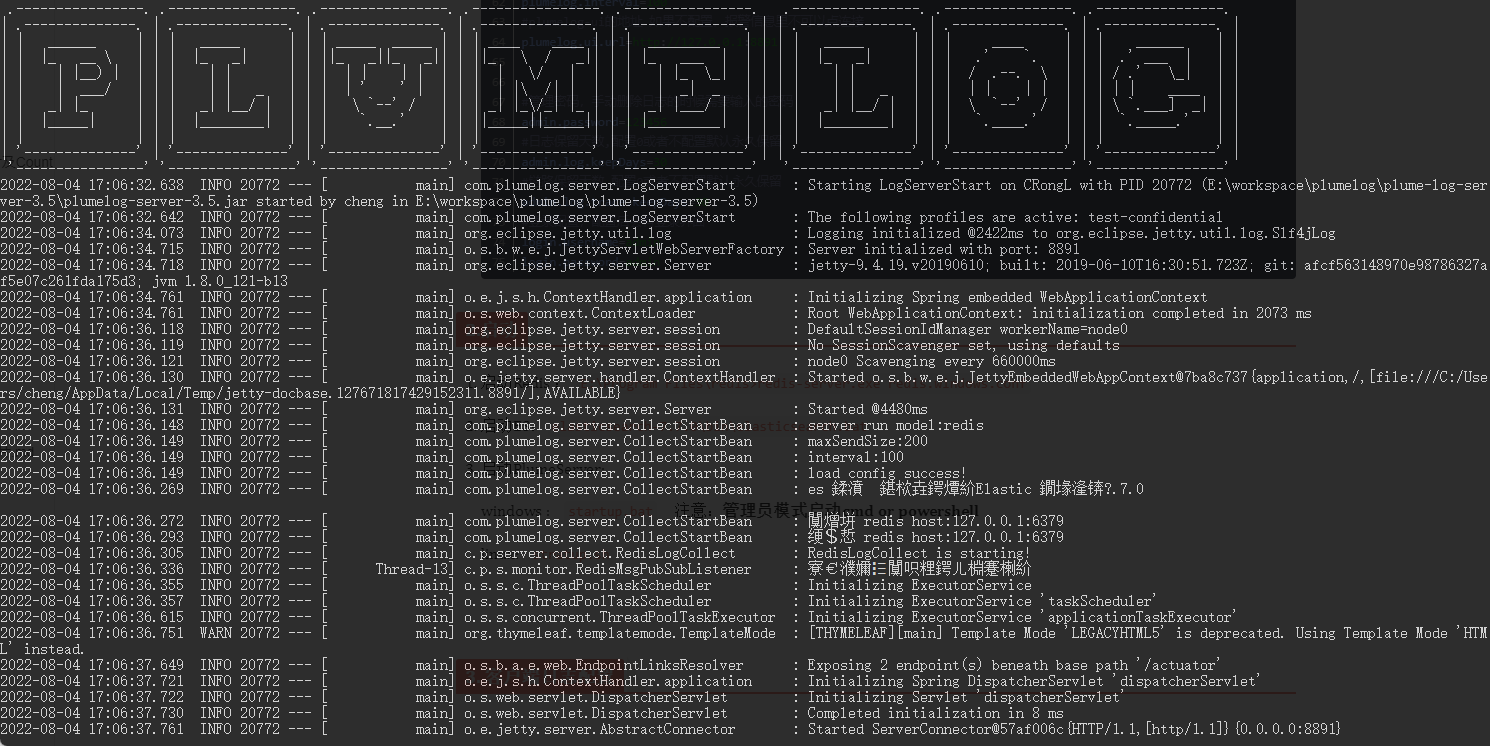

Распределенная система журналов: развертывание Plumelog и доступ к системе

Артефакт, который делает код элегантным и лаконичным: программирование на Java8 Stream

Spring Boot(06): Spring Boot в сочетании с MySQL создает минималистскую и эффективную систему управления данными.

Как использовать ArrayPool

Интегрируйте iText в Spring Boot для реализации замены контента на основе шаблонов PDF.

Redis реализует очередь задержки на основе zset

Получить текущий пакет jar. path_java получает файл jar.

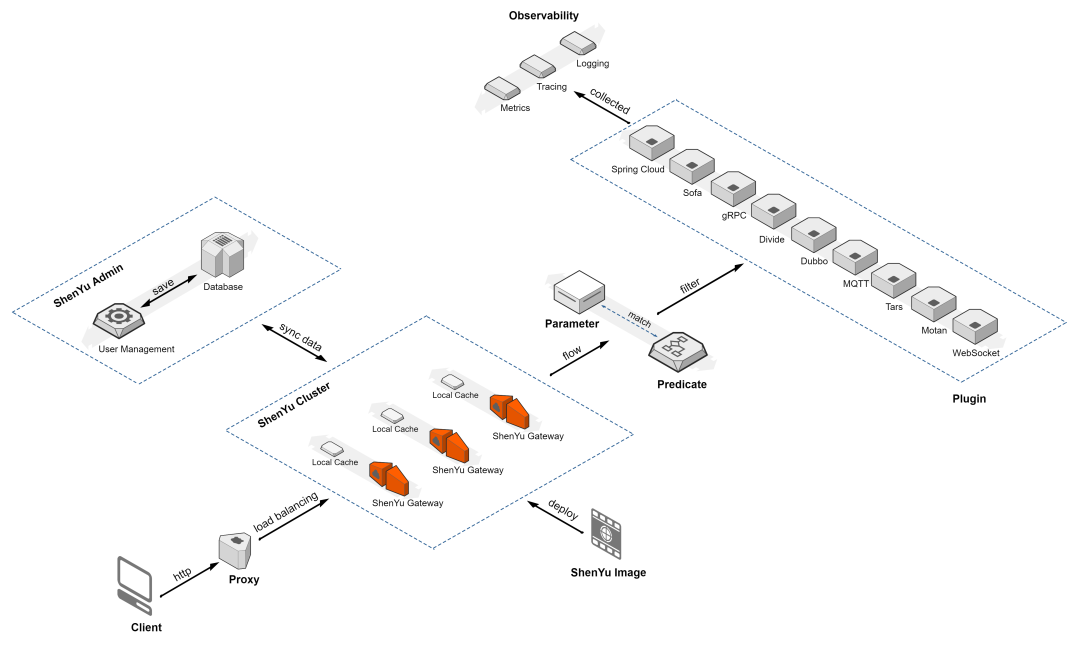

Краткое обсуждение высокопроизводительного шлюза Apache ShenYu

Если вы этого не понимаете, то на собеседовании даже не осмелитесь сказать, что знакомы с Redis.

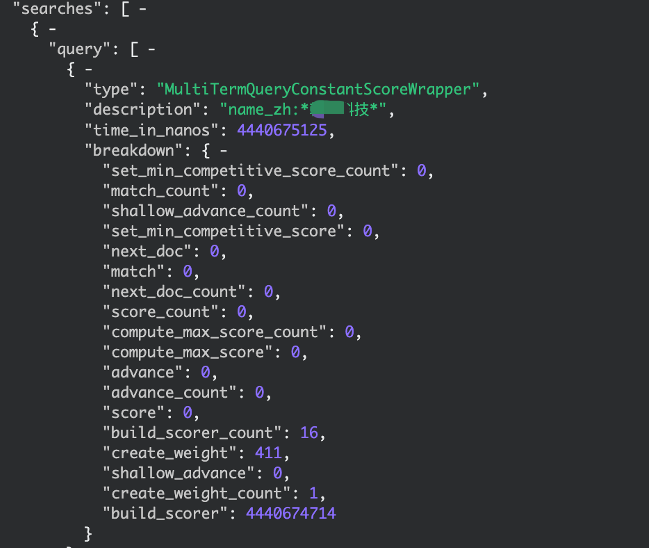

elasticsearch медленный запрос, устранение неполадок записи, запрос с подстановочными знаками