Чистая вещь! Наиболее полное описание методов оперативного проектирования, делающее взаимодействие с LLM, такими как ChatGPT и GPT-4, более эффективным!

введение

С взрывной популярностью генеративного искусственного интеллекта (особенно ChatGPT и GPT-4) написание подсказок становится все более важным навыком для людей, работающих в области искусственного интеллекта. Однако, попрактиковавшись, вы обнаружите, что это не такая простая грамматическая задача, как кажется на первый взгляд. После знакомства с новизной больших моделей, таких как ChatGPT и GPT-4, написание подсказок требует личной практики и мышления, чтобы быстро овладеть этим навыком. Таким образом, создание наиболее эффективного Prompt (Prompt Engineering) на основе реальных сценариев применения стало желанным опытом внутри и за пределами области LLM. Это также привело к появлению должности оперативного инженера.

Эта статья,Даст вам полное представление о проекте Prompt.,К ним относятся:Как предоставить в подсказке информацию, которая окажет наибольшее влияние на ваш ответ;Что такое персона、Положительные и отрицательные советы、Нулевые примеры подсказок и многое другое; как выполнить итерацию usePrompt для использования ChatGPT;、Большие языки (LLM), такие как GPT-4, как взаимодействовать с моделью LLM для выполнения задач.

Простая и оперативная инженерная стратегия

Проект Prompt позволяет нам эффективно использовать LLM в соответствии с конкретными сценариями применения. Он включает в себя разработку четких и конкретных инструкций запроса для получения желаемого ответа от языковой модели. Тщательно создавая подсказки, мы можем помочь ChatGPT и GPT-4 выдавать точные и полезные ответы. В процессе быстрого создания ChatGPT необходимо понимать несколько основных принципов:

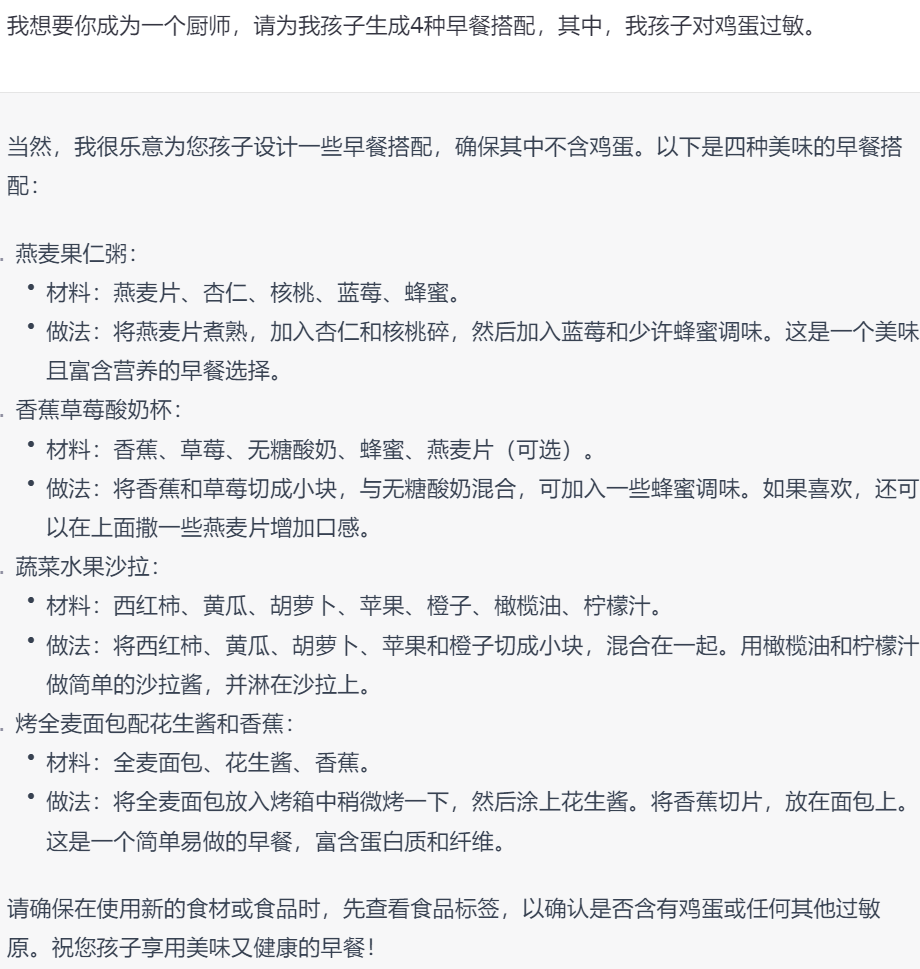

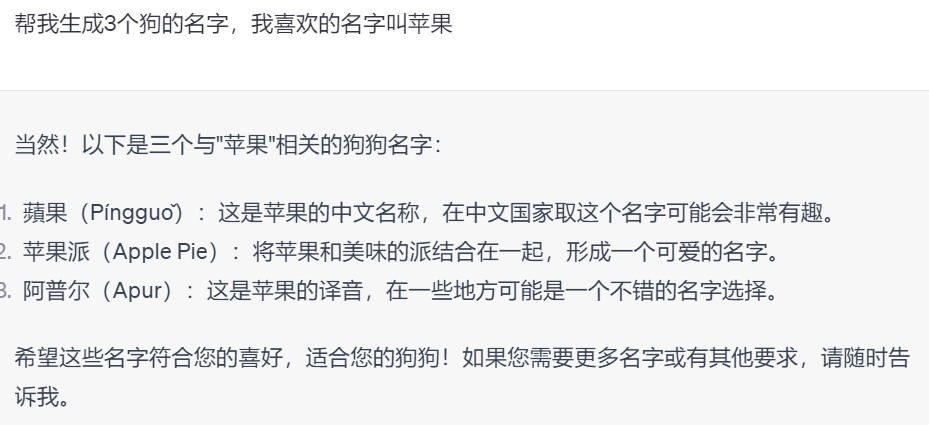

Во-первых, предоставьте четкие инструкции в начале подсказки, которые помогут поставить контекстную задачу для модели. Также полезно указать тип формата ожидаемого ответа. Кроме того, вы можете улучшить взаимодействие, включив в приглашение системные сообщения или методы ролевой игры. Вот пример приглашения, использующего описанную выше технику:

Сравните этот совет со следующим советом:

Интуитивно первый вариант даст более полезные результаты.

Вы можете создавать более продуктивные беседы, итеративно улучшая и экспериментируя с советами, чтобы улучшить качество и релевантность ответов вашей модели. Не бойтесь тестировать потенциальные советы прямо в ChatGPT.

Базовая стратегия оперативного проектирования

В предыдущем разделе в основном был показан простой проект подсказки, а некоторые основные аспекты проекта подсказки будут обсуждаться более подробно ниже.

«Ключевое слово Prompt имеет решающее значение для проекта Prompt»。в некоторых сценариях,Это критический вклад, который приводит к тому, что LLM генерирует необходимые ответы. Другими словами,Очень важно выразить проблему так, чтобы ее могли понять такие LLM, как ChatGPT и GPT-4. Например,Если пользователь не является экспертом в определенной области и не знает правильной терминологии для выражения проблемы,Ответы, данные LLM, такими как ChatGPT и GPT-4, могут не соответствовать ожиданиям. Это похоже на слепой поиск в Интернете без знания правильных ключевых слов.

Для подсказки,Прикрепление соответствующей информации может привести к лучшим результатам.,Но слишком длинная дополнительная информация не обязательно является лучшей стратегией. Хотя ключевое слово Prompt имеет решающее значение,«Но лучше думать об этом не как об отдельной технологии, а как о связке с другими ключевыми технологиями».。

«Краткие подсказки очень важны для ясности и точности результатов LLM»。Хорошо продуманные подсказки должны быть краткими и ясными.,То есть предоставление достаточной информации для LLM, таких как ChatGPT и GPT-4, чтобы понять намерения пользователя.,Но не слишком многословно. Однако,Слишком краткие подсказки также могут вызвать проблемы.,Потому что это приведет к двусмысленности и недопониманию при вводе LLM. Существует противоречие между введением и дополнительной сопутствующей информацией Подсказки.,Лучший способ овладеть этим навыком — больше практиковаться во время реального применения.

«Добавьте назначения ролей и настройки целей в подсказке»。Например,если кто-то хочет позволитьChatGPT、ГПТ-4 и другие ЛЛМ для книги о машинном В руководстве по обучению четко указывается роль LLM как машинного Специалисты в области обучения. Основная аудитория этой книги — машинное оборудование. Обучение Новички, это определенно даст лучшие результаты. В подсказке либо напишите: «Вы машинное Старшие специалисты в области обучения, помогите пожалуйста машинное обучение Эта книга написана как ознакомительная, основная аудитория книги – машинное. обучение Новичок", или напишите "Автор: машинное Старший эксперт в области обучения, аудитория: машинное обучение Начинающий»,Все это можно попробовать в конкретном сценарии. и ты найдешь,Назначение ролей LLM в большинстве случаев,Полученные результаты относительно хорошие.

Цели тесно связаны с ролями. Явно указать цель взаимодействия в подсказке — это не только хорошая идея, но и необходима.

«Положительные и отрицательные подсказки — это еще один рамочный метод управления выводом модели»。позитивное напоминание(“сделай это”)поощрять Модель Содержит определенный тип вывода и генерирует определенный тип ответа.。с другой стороны,негативное напоминание(“не хочусделай это”)предотвратит Модель Содержит определенный тип вывода и генерирует определенный тип ответа.。использовать Положительные и отрицательные советыможет сильно повлиять Модель Направление и качество продукции。Например Советы ниже:

❝"Вы будете работать агентом по недвижимости с 10-летним опытом работы в Токио. Ваша цель — обобщить 5 лучших районов Минато-Сити в одном абзаце. Целевая аудитория – неопытные покупатели жилья. " ❞

Формулировка приведенного выше совета носит позитивный характер, давайте добавим несколько формулировок, чтобы заблокировать определенные выходы. Примером отрицательного совета по содержанию может быть добавление следующего к приведенному выше примеру:

❝ «Пожалуйста, не включайте поселки, находящиеся более чем в 10 минутах ходьбы от ближайшей станции метро. " ❞

Это дополнительное ограничение должно помочь LLM, таким как ChatGPT и GPT-4, понять, какой именно результат он должен выдавать.

Передовые стратегии оперативного проектирования

В предыдущем разделе в основном были представлены базовые стратегии Prompt для взаимодействия с LLM. В этом разделе в основном представлен ряд более продвинутых инженерных стратегий Prompt, которые позволяют более сложным образом взаимодействовать с LLM, такими как ChatGPT и GPT-4. Стратегии подсказок. Стратегия, часто используемая инженерами.

Подсказка ввода/вывода

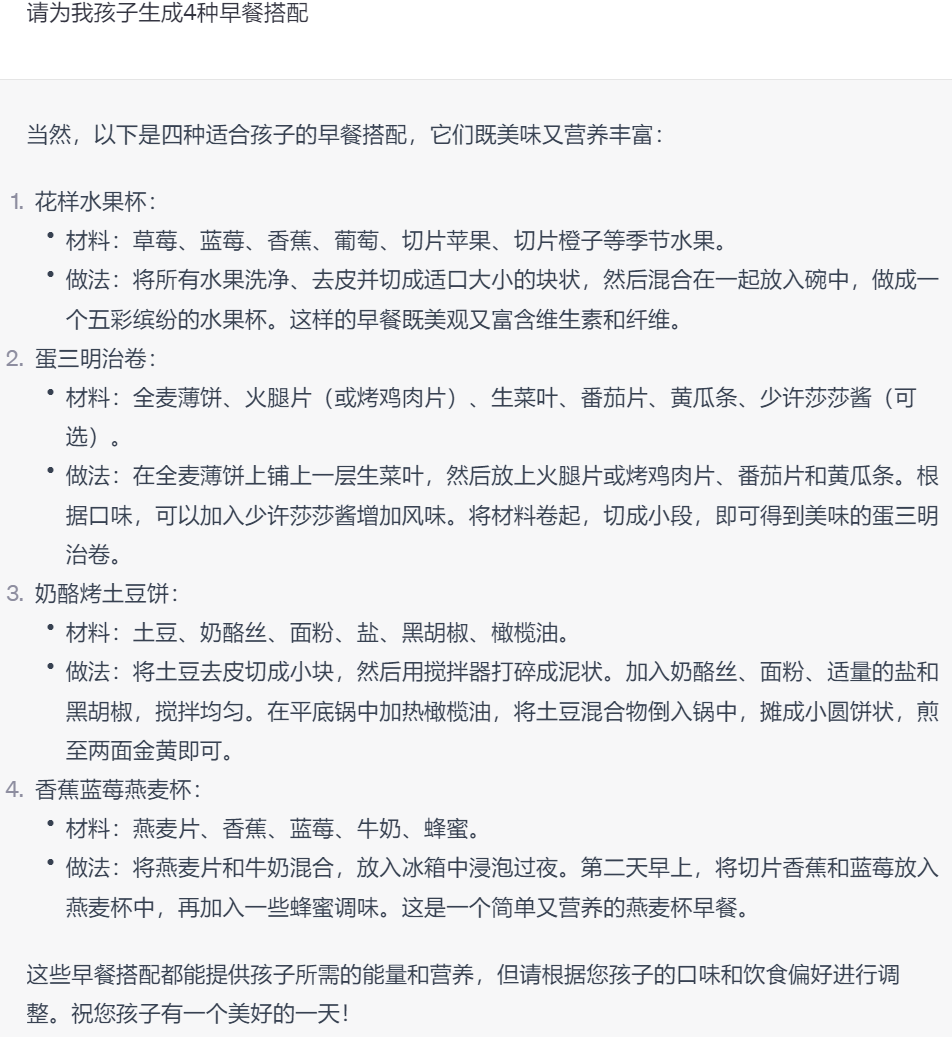

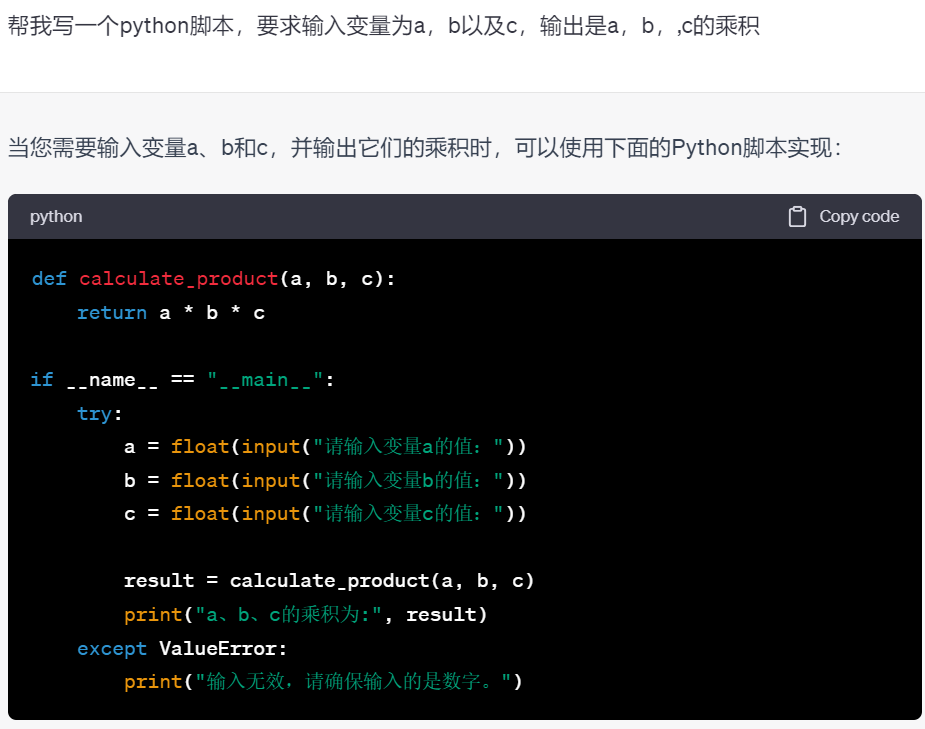

Подсказка Стратегия ввода/вывода включает определение входных данных, которые пользователь предоставляет LLM, и выходных данных, которые LLM генерирует в ответ. Эта стратегия имеет решающее значение для проекта Prompt, поскольку она напрямую влияет на качество и актуальность ответов от LLM, таких как ChatGPT и GPT-4. Например, пользователь может предоставить приглашение ввода с просьбой к LLM сгенерировать сценарий Python для конкретной задачи, а желаемым результатом будет сгенерированный сценарий. Конкретные примеры заключаются в следующем:

Zero-shot Prompt

Стратегия Zero-shot Prompt в основном используется для генерации ответов для LLM, таких как ChatGPT и GPT-4, без каких-либо примеров или контекста. Эта стратегия может быть полезна, когда пользователи хотят ответить быстро, не предоставляя дополнительных подробностей, или когда тема настолько общая, что примеры искусственно ограничивают ответы. Например:

One-shot Prompt

Стратегия одноразового запроса в основном применяется для генерации ответов в контексте одного примера или контекста, предусмотренного для LLM, таких как ChatGPT и GPT-4. Эта политика может определять реакцию LLM, таких как ChatGPT и GPT-4, и гарантировать, что она соответствует намерениям пользователя. Эту стратегию можно понимать как предоставление модели с примером, а не как отсутствие примера вообще. Например:

Few-shot Prompt

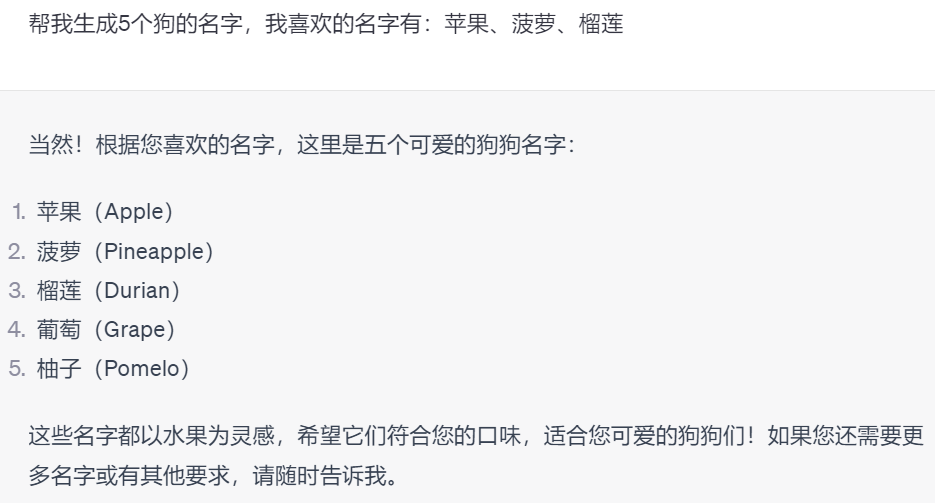

Стратегия «Несколько шагов» в основном используется для генерации ответов на основе некоторых примеров или контекста, предоставленных для LLM, таких как ChatGPT и GPT-4. Эта политика может определять реакцию LLM, таких как ChatGPT и GPT-4, и гарантировать, что она соответствует намерениям пользователя. Идея здесь в том, что несколько примеров дадут модели больше рекомендаций, чем один пример. Например:

Как показано выше, чем больше примеров включено в приглашение, тем ближе полученный результат будет к желаемому результату. В случае «Zero-shot» названия фруктов не могут быть заданы; в случае «One-shot Prompt» их может быть несколько; в случае «Few-shot Prompt» предложения могут полностью состоять из названий на фруктовую тематику.

Цепочка мыслей

Цепочка мыслей Подскажите Основная цель состоит в том, чтобы предоставить несколько примеров для LLM, таких как ChatGPT и GPT-4, чтобы помочь улучшить исходный вопрос и обеспечить более точные и полные ответы. Цепочка мысли, потому что подсказка содержит несколько примеров идей. Она отличается от технологии наконечника X-shot, поскольку Цепочка Подсказки мыслей структурированы так, чтобы направлять Модель в критическом мышлении, и предназначены для того, чтобы помочь LLM, таким как ChatGPT, GPT-4 и т. д., открывать новые методы, которые, возможно, не рассматривались.

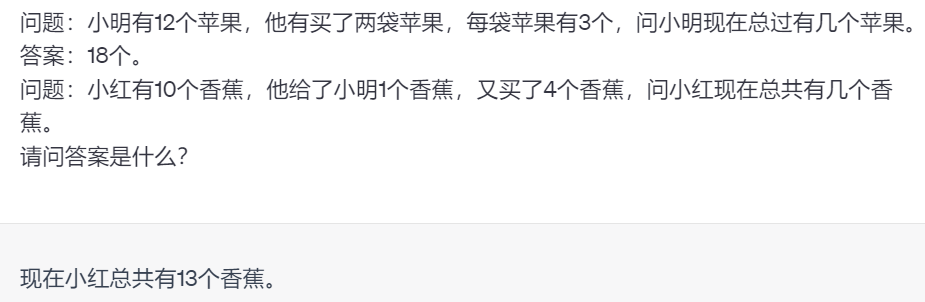

Эта технология также помогает магистрам права формулировать свои критические рассуждения. Слоган подсказки «Цепочка мыслей» — «Давайте думать шаг за шагом». Обычно он добавляется в конец подсказки, и результаты исследований показывают, что это может улучшить полученные результаты. Сначала давайте рассмотрим одноразовый пример:

Теперь давайте посмотрим на следующую цепочку мыслей:

Можно обнаружить, что, предоставляя пример мыслительного процесса для решения этой проблемы и направляя студентов LLM думать шаг за шагом, ChatGPT может применить те же рассуждения к нашей проблеме и прийти к правильному ответу.

Самокритика

Стратегия самокритики в основном помогает LLM оценивать свою продукцию на предмет потенциальных неточностей или областей, требующих улучшения. Эта стратегия гарантирует, что LLM выдают информацию об ответах как можно точнее. Это помогает пользователям настраивать подсказки и определять, почему они не получают ожидаемых результатов. Примеры таких подсказок:

❝ «Пожалуйста, еще раз просмотрите свой ответ выше. Можете ли вы заметить какие-либо ошибки? Если они присутствуют, выявите эти ошибки и внесите необходимые изменения. " ❞

Этот пример инструктирует LLM использовать самокритику для отладки кода ошибки:

❝ «Посмотрите на код, который вы только что сгенерировали. В настоящее время он не работает. Способны ли вы увидеть грамматические ошибки, которые можно исправить? Если да, определите проблемную часть кода и создайте ее заново. " ❞

Использование возможностей самовосстановления ChatGPT — это технология быстрого проектирования, которую нельзя игнорировать.

Итеративная стратегия подсказок

Итеративная стратегия подсказок в основном предоставляет LLM последующие подсказки на основе результатов первоначальной подсказки. Конкретно,Согласно первоначальному выводу,Повторяйте результаты, задавая дополнительные вопросы или делая дополнительные запросы на основе каждого последующего ответа. Например,Подумайте о том, чтобы позволить ChatGPT помочь вам создать план книги, которую вы пишете. Первый совет может выглядеть так:

❝ «Я пишу книгу о путешествиях во времени. Я еще не остановился на конкретной теме. Пожалуйста, предложите 5 тем для книги. Для каждой темы укажите название и описание того, что будет раскрыто в книге. Эта книга будет ориентирована на случайных читателей. " ❞

Предположим, что одна из сгенерированных тем выглядит следующим образом:

❝Название: «Парадокс времени: исследование сложностей путешествий во времени» Описание: «Парадокс времени» углубляется в головокружительные тонкости парадоксов путешествий во времени, исследуя увлекательные загадки, которые они представляют. В этой книге исследуются различные парадоксы, такие как парадокс руководства, парадокс предопределения и информационный парадокс. … ❞

Затем вы можете повторить это, используя последующие подсказки:

❝ «Я напишу это под заголовком «Парадокс времени: исследование сложности путешествий во времени». Пожалуйста, помогите составить план глав этой книги, включая главы и подразделы». ❞

Отрывок возможного вывода выглядит следующим образом:

❝Введение

- Дайте определение парадоксу времени.

- Значение временных парадоксов в повествованиях о путешествиях во времени

- Обзор структуры главы

Глава 1. Парадокс начальной загрузки 1.1. Сущность парадокса начальной загрузки

- Объяснять понятия и их происхождение.

- Ключевые примеры анекдотов из литературы, кино и реальной жизни

- ……

❞

В этом примере вы можете увидеть, как продолжить дальнейшие итерации. Аналогичную итерацию можно использовать для генерации кода LLM: начните с обзора, пройдите по обзору для создания модулей, надстройте модули для создания функций и, наконец, сгенерируйте код внутри функций. Подобно тому, как люди часто добиваются успеха, разбивая большие проблемы на более мелкие, более управляемые, студенты LLM преуспевают в выполнении более крупных задач более управляемым способом.

Работа с моделями

Лучший способ правильно использовать ChatGPT, GPT-4 — в качестве младшего помощника, будь то научный сотрудник, помощник по кодированию, помощник по решению проблем или что-то еще, что вам нужно. Признание и развитие этой атмосферы сотрудничества может привести к дальнейшему успеху. Вот несколько простых советов, которые помогут облегчить это сотрудничество.

Подсказка, подсказка

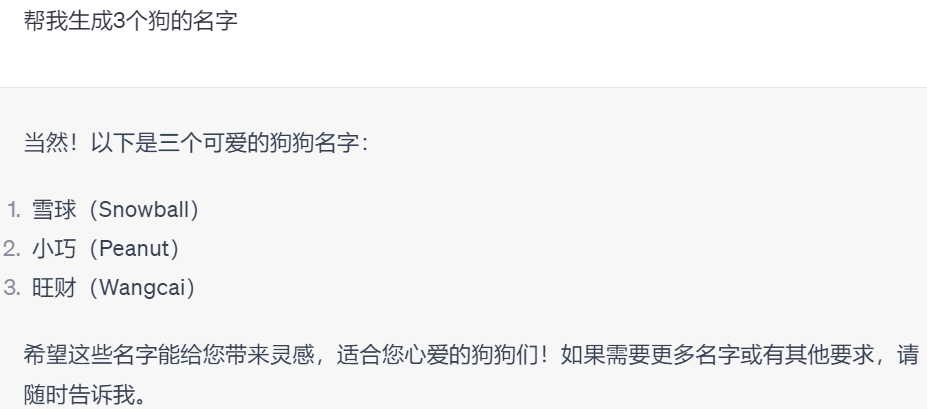

Один из способов улучшить оперативное производство — использовать ChatGPT. Подобные советы могут привести к полезным результатам, например:

❝Какие советы я могу использовать сейчас, чтобы помочь вам в выполнении этой задачи? ❞

ChatGPT затем предложит полезные советы, которые вы можете использовать для улучшения дальнейших ответов.

Подсказка загрузки модели

Подсказки модели в основном позволяют модели предоставлять информацию, необходимую для выполнения конкретных задач. Это похоже на то, как если бы вы сказали кому-то: «Дайте мне знать, что вам нужно для выполнения этой задачи». Например:

❝Я хочу, чтобы вы написали программу на Python для управления информацией о моих клиентах, которая хранится в Google Sheet. Чтобы выполнить эту задачу, задайте мне любые вопросы, на которые вам нужно ответить. ❞

Позволить ChatGPT решать, какая информация необходима для выполнения задачи, полезно, поскольку это может исключить некоторые догадки и предотвратить галлюцинации. Конечно, хорошо продуманное приглашение для приглашения на основе модели может привести к тому, что вам придется отвечать на многие нерелевантные вопросы из ChatGPT, поэтому первоначальное приглашение все равно необходимо писать вдумчиво.

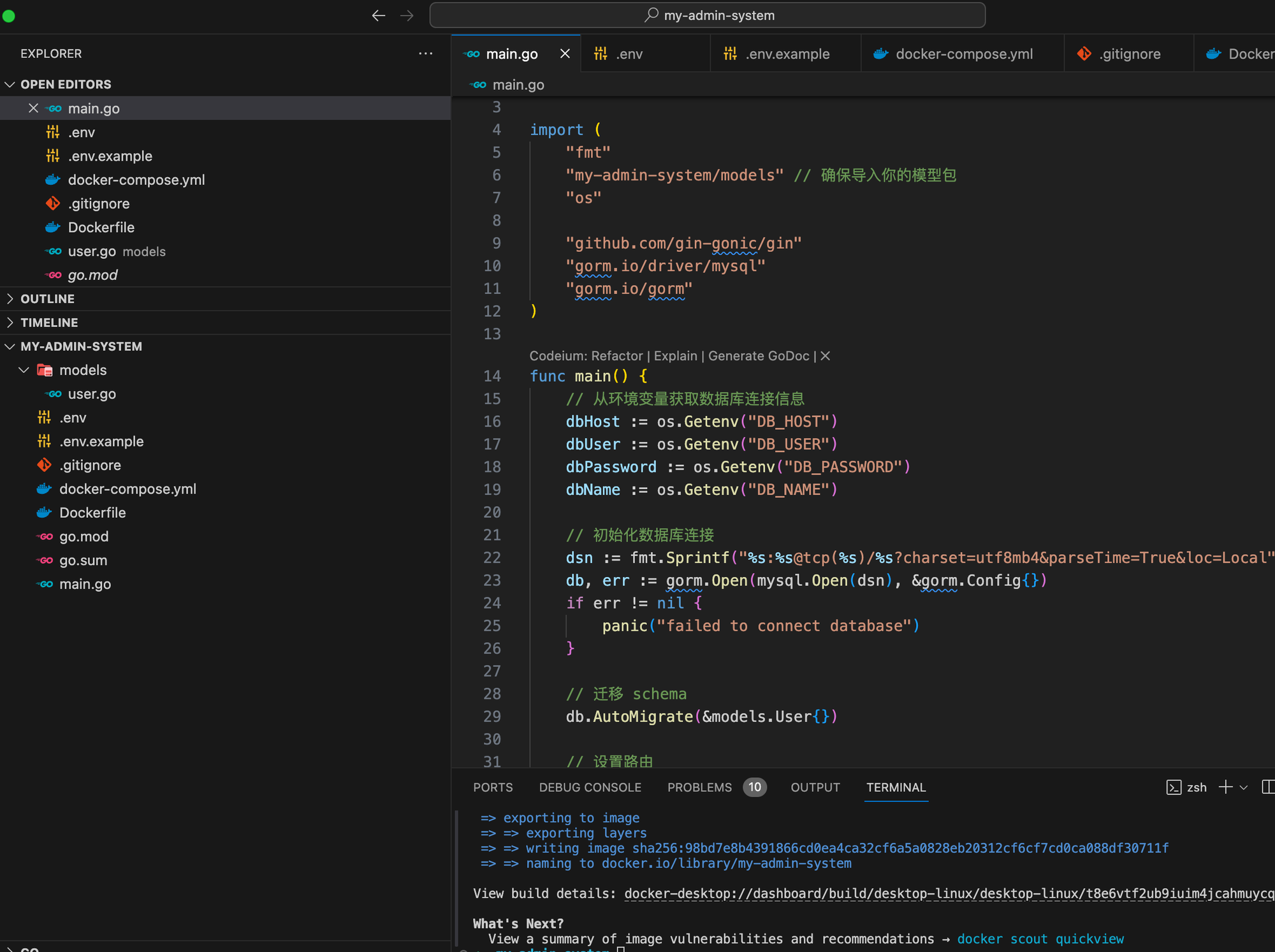

На основе языка Go мы шаг за шагом научим вас внедрять структуру системы управления серверной частью.

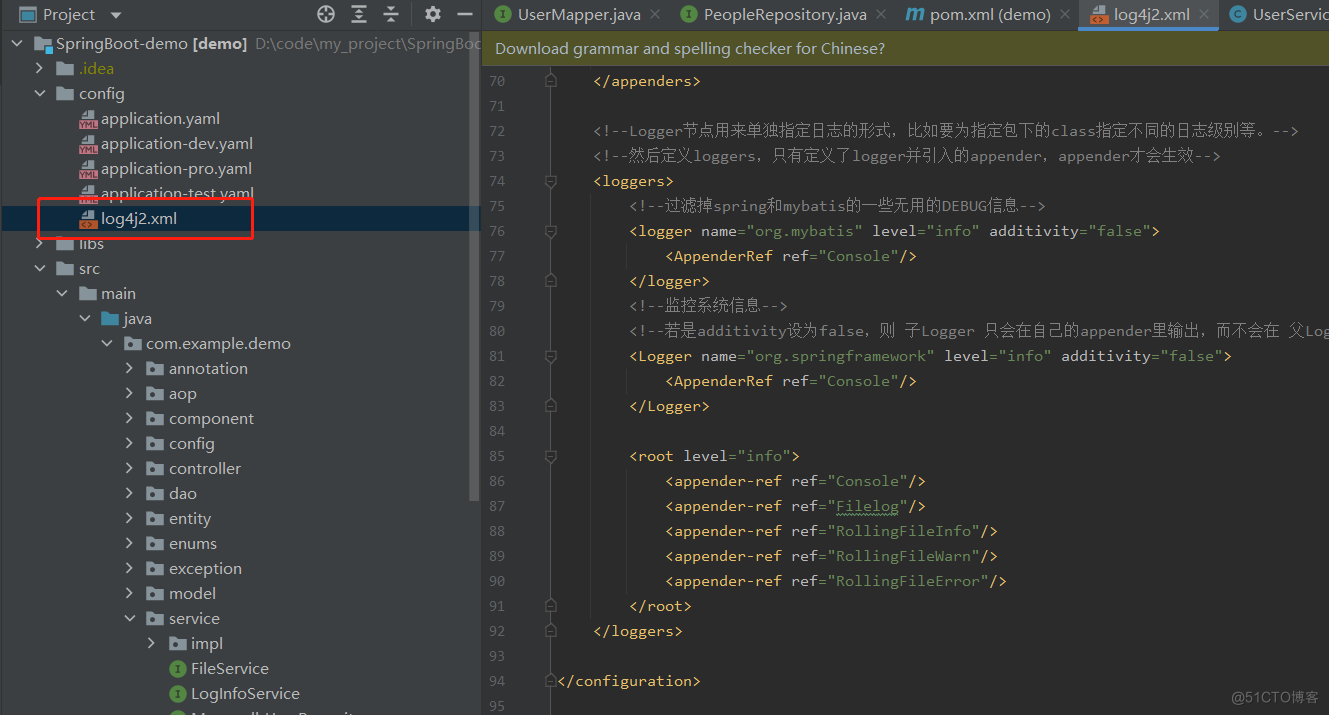

Эффективное управление журналами с помощью Spring Boot и Log4j2: подробное объяснение конфигурации

Что делать, если telnet не является внутренней или внешней командой [легко понять]

php-объект для анализа json_php json

Введение в принцип запуска Springboot, процесс запуска и механизм запуска.

Высокоуровневые операции Mongo, если данные не существуют, вставка и обновление, если они существуют (pymongo)

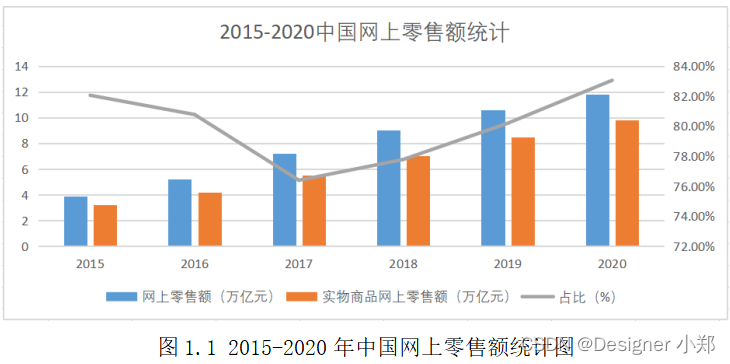

Проектирование и внедрение системы управления электронной коммерцией на базе Vue и SpringBoot.

Статья длиной в 9000 слов знакомит вас с процессом запуска SpringBoot — самым подробным процессом запуска SpringBoot в истории — с изображениями и текстом.

Как настроить размер экрана в PR. Учебное пособие по настройке размера видео в PR [подробное объяснение]

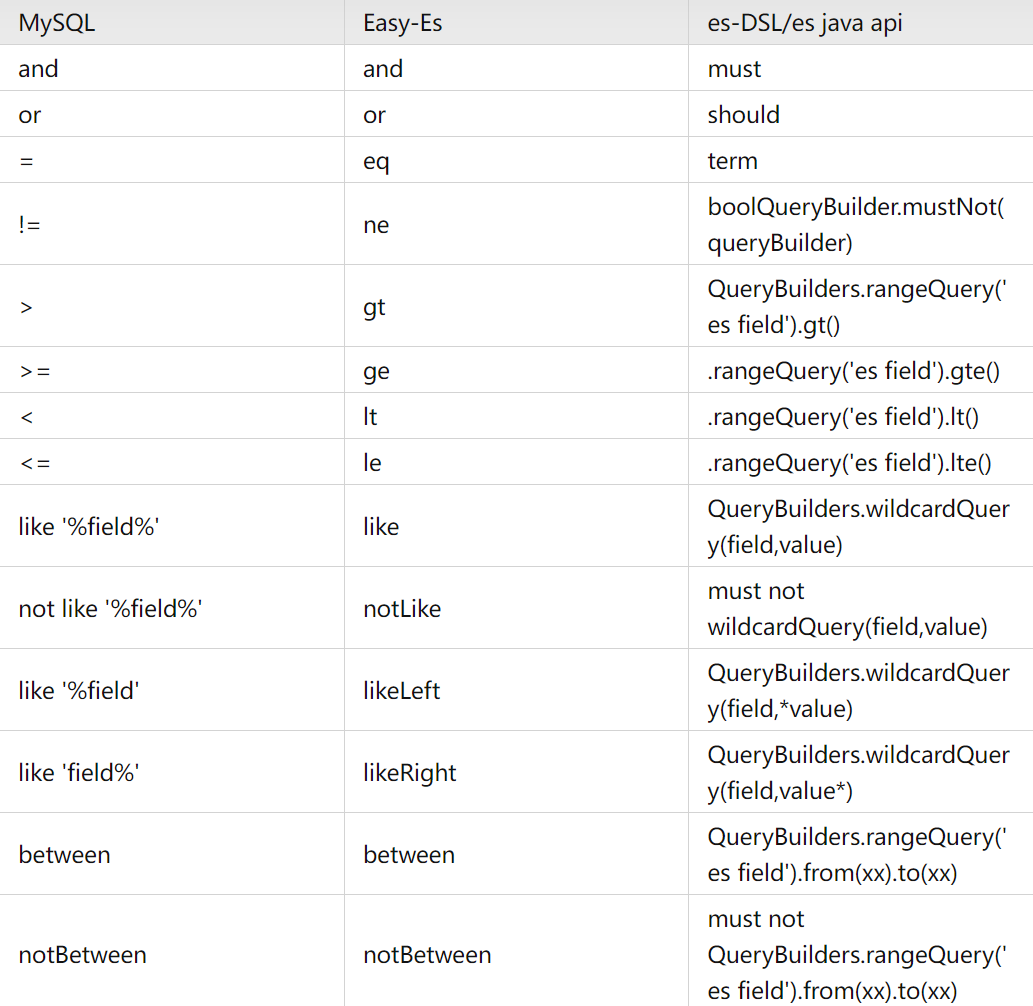

Элегантный и мощный: упростите операции ElasticSearch с помощью easy-es

Проект аутентификации по микросервисному токену: концепция и практика

【Java】Решено: org.springframework.http.converter.HttpMessageNotWritableException.

Изучите Kimi Smart Assistant: как использовать сверхдлинный текст, чтобы открыть новую сферу эффективной обработки информации

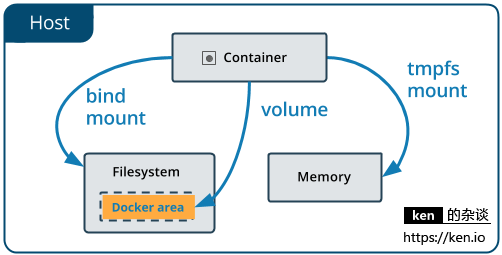

Начало работы с Docker: использование томов данных и монтирования файлов для хранения и совместного использования данных

Использование Python для реализации автоматической публикации статей в публичном аккаунте WeChat

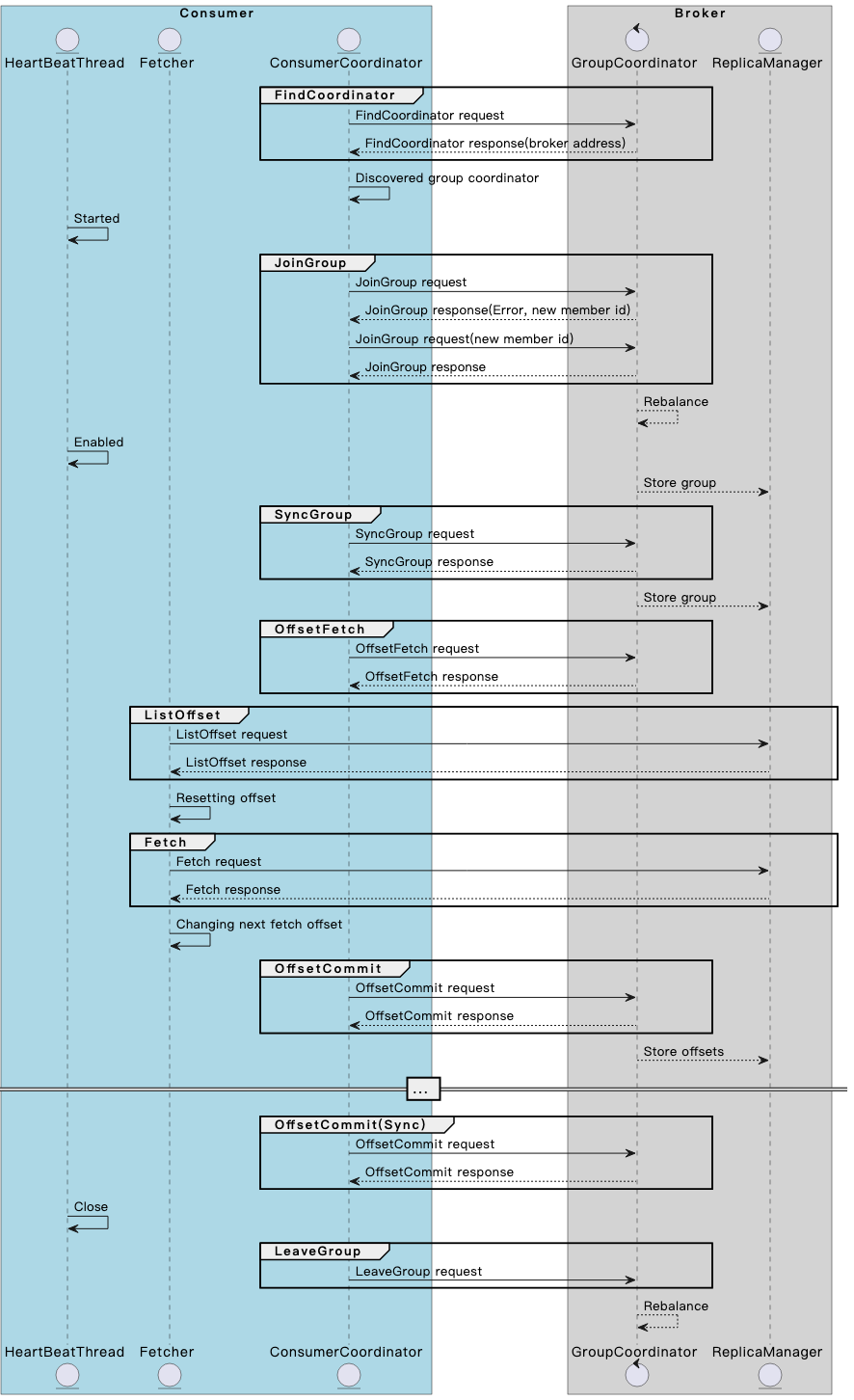

Разберитесь в механизме и принципах взаимодействия потребителя и брокера Kafka в одной статье.

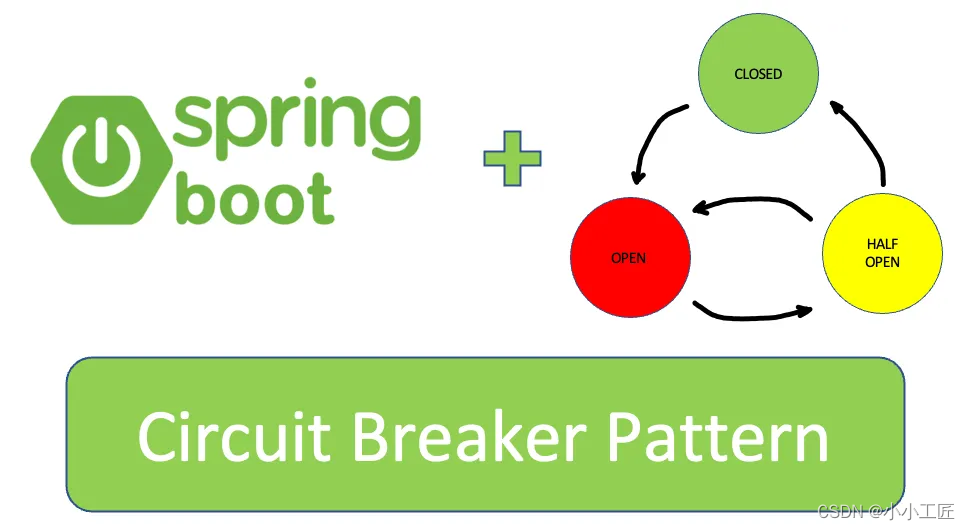

Spring Boot — использование Resilience4j-Circuitbreaker для реализации режима автоматического выключателя_предотвращения каскадных сбоев

13. Springboot интегрирует Protobuf

Примечание. Инструмент управления батареями Dell Dell Power Manager

Общая интерпретация класса LocalDate [java]

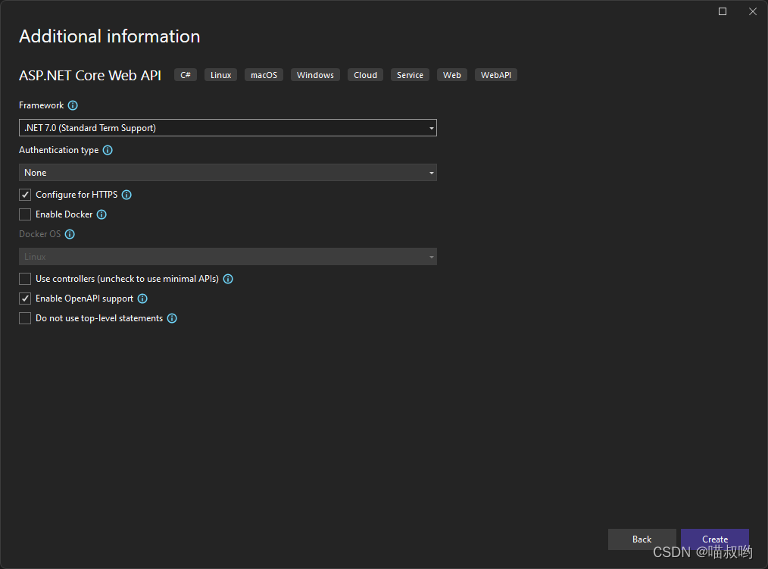

[Базовые знания ASP.NET Core] -- Веб-API -- Создание и настройка веб-API (1)

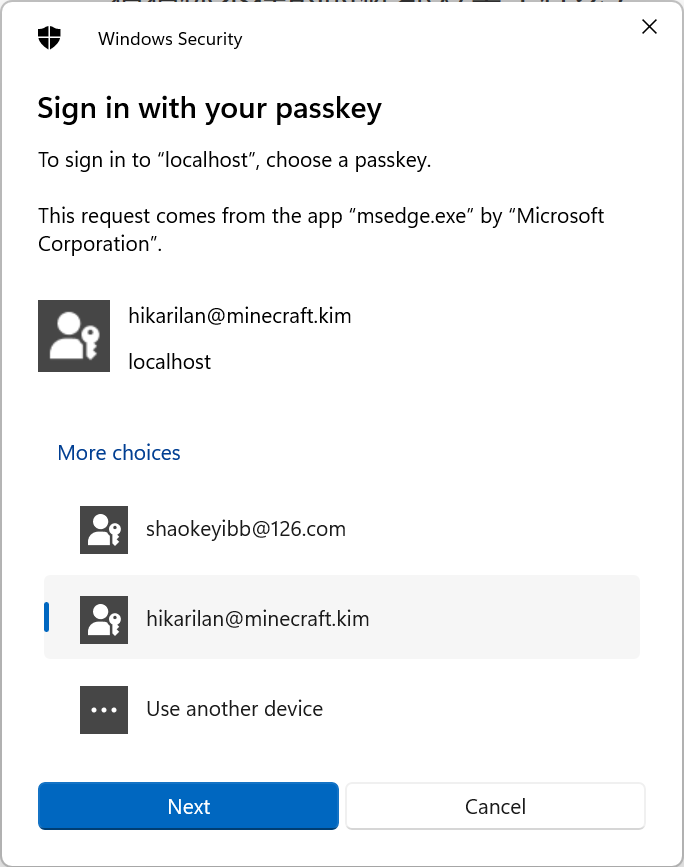

Настоящий бой! Подключите Passkey к своему веб-сайту для безопасного входа в систему без пароля.

Руководство по настройке Nginx: как найти, интерпретировать и оптимизировать настройки Nginx в Linux

Typecho отображает использование памяти сервера

Как вставить элемент перед указанным ключом в ассоциативный массив в PHP

swagger2 экспортирует API как текстовый документ (реализация Java) [легко понять]

Выбор фреймворка nodejs Express koa egg MidwayJS сравнение NestJS

Руководство по загрузке, установке и использованию SVN «Рекомендуемая коллекция»

Интерфейс PHPforwarding_php отправляет запрос на получение