30 000 слов подробного анализа последней обзорной работы Университета Цинхуа: обзор эффективного вывода больших моделей.

Глубокое обучение обработке естественного языка Оригинал Автор: fanmetasy

Крупные модели привлекли всеобщее внимание благодаря своим отличным характеристикам в различных задачах. Однако огромные требования к вычислительным ресурсам и памяти для вывода больших моделей создают проблемы для их развертывания в сценариях с ограниченными ресурсами. Отрасль усердно работает над разработкой методов, предназначенных для повышения эффективности вывода больших моделей. В этой статье представлен всесторонний обзор и краткое изложение существующей литературы по эффективному выводу больших моделей. Сначала анализируются основные причины низкой эффективности рассуждений больших моделей, а именно большой размер параметров модели, квадратичная сложность операции вычисления внимания и метод авторегрессионного декодирования. Затем вводится комплексная таксономия, которая делит существующие усилия по оптимизации на оптимизацию на уровне данных, уровне модели и оптимизации на уровне системы. Кроме того, в этой статье также проводятся сравнительные эксперименты по репрезентативным методам в ключевых областях, анализируется и дается определенная информация. Наконец, подводятся итоги соответствующей работы и обсуждаются будущие направления исследований.

бумага:A Survey on Efficient Inference for Large Language Models адрес:https://arxiv.org/abs/2404.14294

1 Introduction

В последние годы большие модели привлекли широкое внимание научных кругов и промышленности.

Область LLM пережила значительный рост и заметные достижения. Появилось множество LLM с открытым исходным кодом, в том числе серии gpt (GPT-1, GPT-2 и GPT-3), OPT, серии lama (LLaMA, LLaMA 2, BaiChuan 2, Vicuna, LongChat), BLOOM, FALCON, GLM и Мтаистраль [12], они используются для академических исследований и коммерческого внедрения. Успех больших моделей обусловлен их мощной способностью решать различные задачи, такие как понимание нейронного языка (NLU), генерация нейронного языка (NLG), вывод и генерация кода [15], что позволяет реализовать такие влиятельные проекты, как ChatGPT, Copilot, и приложение Бинг. Все больше и больше людей считают, что [16] рост и достижения ученых LMM знаменуют собой большой шаг человечества вперед к общему искусственному интеллекту (AGI).

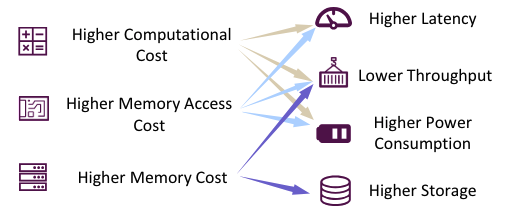

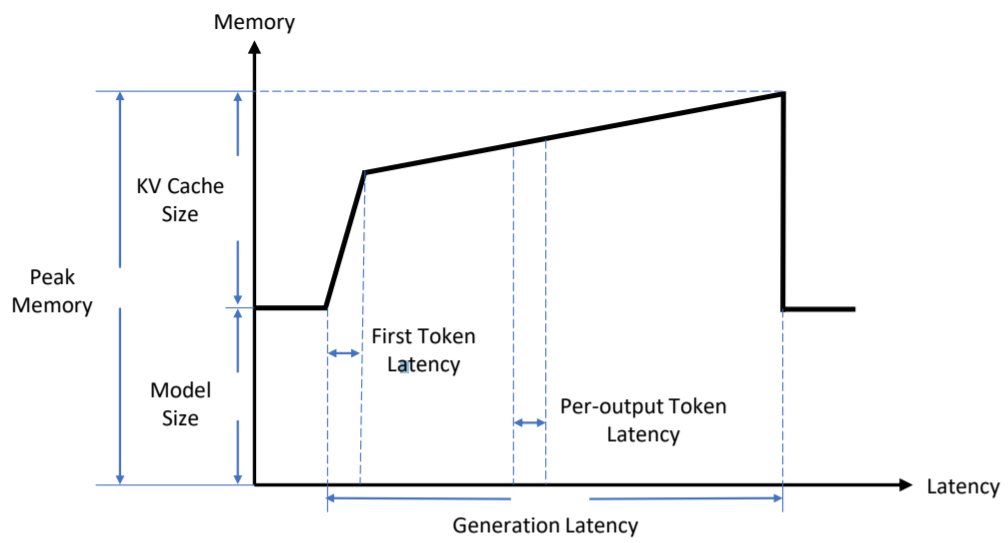

Рисунок 1. Проблемы развертывания большой модели

Однако внедрение LLM не всегда проходит гладко. Как показано на рисунке 1, в процессе вывода использование LLM обычно требует более высоких вычислительных затрат, стоимости доступа к памяти и объема памяти. (Анализ первопричин см. в разделе 2.3.) Эффективность вывода также будет снижена в сценариях с ограниченными ресурсами (например, задержка, пропускная способность, энергопотребление и хранилище). Это создает проблемы для применения LLM как в терминальных, так и в облачных сценариях. Например, огромные требования к объему памяти делают непрактичным развертывание модели с параметрами 70B на персональном ноутбуке для помощи в разработке. Более того, если LLM используется для каждого запроса поисковой системы, низкая пропускная способность приведет к огромным затратам, что приведет к значительному снижению прибыли поисковых систем.

К счастью, было предложено большое количество методов для достижения эффективного вывода LLM. Чтобы получить всестороннее понимание существующих исследований и стимулировать дальнейшие исследования, в этой статье используется иерархическая классификация и систематическое резюме текущей эффективной работы по выводам LLM. В частности, существующая работа разделена и организована на оптимизацию на уровне данных, модели и системы. Кроме того, в статье представлен экспериментальный анализ репрезентативных методов в ключевых областях для консолидации знаний, даны практические рекомендации и рекомендации для будущих исследований.

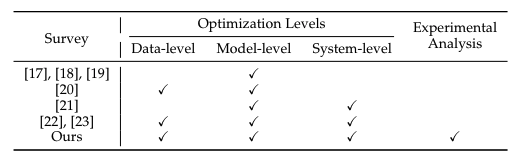

Таблица 1: Итоговое сравнение

В настоящее время обзоры [17], [18], [19], [20], [21], [22] посвящены области LLM. Эти обзоры в основном сосредоточены на различных аспектах эффективности LLM, но предоставляют возможности для дальнейших улучшений. Чжу и др. [17], Парк и др. [18] и Ван и др. [19] сосредоточили обзор на технологии сжатия моделей, которая представляет собой оптимизацию на уровне модели. Динг и др. [20] сосредоточились на архитектуре данных и моделей. Мяо и др. [21] изучили эффективное обоснование LLM с точки зрения исследования систем машинного обучения (MLSys). Напротив, в этой статье представлен более полный объем исследований, которые касаются оптимизации на трех уровнях: уровне данных, уровне модели и уровне системы, а также охватывают недавние исследовательские усилия. Ван и др. [22] и Сюй и др. [23] также провели комплексный обзор эффективных исследований LLM. На основе экспериментального анализа, проведенного в нескольких ключевых областях, таких как количественная оценка моделей и сервер моделей, в этой статье представлены практические идеи и предложения путем интеграции сравнительных экспериментов. Как показано в Таблице 1, представлены сравнения различных обзоров.

Структура этой статьи разделена следующим образом: Глава 2 знакомит с основными понятиями и знаниями LLM, а также проводит подробный анализ узких мест эффективности в процессе рассуждения LLM. В главе 3 представлена таксономия, предложенная в этой статье. В главах 4–6 представлены и обсуждаются соответствующие работы на трех разных уровнях оптимизации. В главе 7 представлено более широкое обсуждение нескольких ключевых сценариев применения. В главе 8 суммированы основные положения данного обзора.

2 Preliminaries

2.1 LLM архитектуры трансформатора

Языковое моделирование, как основная функция языковой модели, включает моделирование вероятности последовательностей слов и прогнозирование распределения вероятностей последующих слов. В последние годы исследователи обнаружили, что увеличение размера языковых моделей не только улучшает возможности языкового моделирования, но и создает возможность решать более сложные задачи в дополнение к традиционным задачам НЛП [24]. языковые модели (LLM).

Крупные модели массового спроса разрабатываются на основе архитектуры Transformer [25]. Типичная модель архитектуры трансформатора состоит из нескольких блоков трансформаторов, расположенных друг над другом. Обычно блок трансформатора состоит из модуля многоголового самообслуживания (MHSA), нейронной сети прямого распространения (FFN) и уровня LayerNorm (LN). Каждый блок трансформатора получает выходные характеристики предыдущего блока трансформатора в качестве входных данных, последовательно отправляет характеристики в каждый субмодуль и, наконец, выводит их. В частности, перед первым блоком преобразователя необходимо использовать токенизатор для преобразования традиционного входного предложения в последовательность токенов, а затем использовать слой внедрения для преобразования последовательности токенов во входные функции. К входной функции добавляется дополнительное позиционное внедрение для кодирования порядка входных токенов.

Ядром архитектуры Transformer является механизм самообслуживания, который используется в модуле многоголового самообслуживания (MHSA). Вход пары модулей MHSA

После линейного преобразования получаются векторы Q, K и V, как показано в формуле (1):

в

это входная функция,

для первого

Матрица трансформации головы внимания. Затем к каждому применяется операция самообслуживания (

) кортеж и получить

Характеристики головы внимания

, как показано в формуле (2):

в

Размерность запроса (ключа). Вычисления с самообслуживанием включают умножение матриц, вычислительная сложность которых квадратична длине входных данных. Наконец, модуль MHSA объединяет характеристики всех головок внимания и выполняет над ними преобразование матрицы отображения, как показано в формуле (3):

в

является матрицей отображения. Механизм самообслуживания позволяет модели определять важность различных входных частей без учета расстояния и, таким образом, может получать зависимости на больших расстояниях и сложные взаимосвязи входных предложений.

Еще один важный модуль трансформаторного блока: FFN устанавливается после модуля многоголовочного самообслуживания (MHSA) и содержит две нелинейные функции активации. Он получает выходные характеристики модуля MHSA.

Как показано в формуле (4), расчет производится:

в,

и

- весовая матрица двух линейных слоев,

это функция активации.

2.2 Процесс вывода большой модели

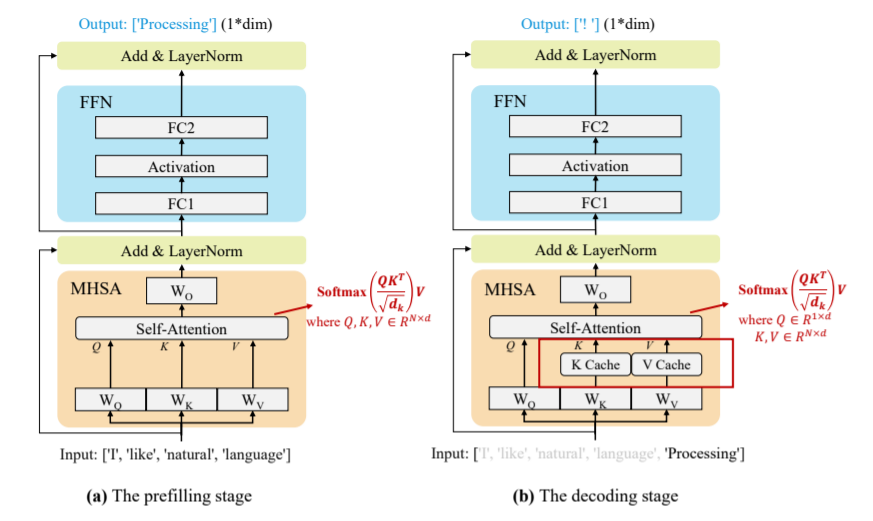

Наиболее популярные большие модели, например модели с архитектурой только декодера, обычно используют авторегрессионные методы для генерации выходных операторов. Авторегрессионный метод выводит токены один за другим. На каждом этапе генерации большая модель принимает в качестве входных данных все предыдущие последовательности токенов, включая входной токен и только что сгенерированный токен, и генерирует следующий токен. По мере увеличения длины последовательности существенно возрастают и временные затраты на генерацию текста. Для решения этой проблемы предлагается ключевая технология — кэш-ключ-значение (KV) для ускорения генерации текста.

Технология кэширования KV,Включено в блок Бычьего внимания к себе (MHSA).,Сохраните и повторно используйте вектор ключа (K) и вектор значений (V), соответствующий предыдущему токену. Эта технология широко использовалась в рассуждениях по большим моделям.,Потому что он реализует огромную оптимизацию задержки генерации текста. На основе этой технологии,Процесс рассуждения Большой Модели можно разделить на два этапа:

- ①prefillingэтап:большой Модель Посчитать и объединитьхранилищеисходный вводtokenизKVкэш,и сгенерируйте первый выходной токен,Как показано на рисунке 2(а)

- ②decodingэтап:большой МодельиспользоватьKV Кэш выводит токены один за другим и обновляет кэш KV парами K, V (ключ-значение) вновь сгенерированных токенов.

Рисунок 2. Принципиальная схема применения технологии KV-кэша при рассуждениях на больших моделях.

Как показано на рисунке 3, показаны ключевые показатели повышения эффективности рассуждений. По горизонтальной оси Latency (задержка, на этапе предварительного заполнения (предзаполнения) первого token Задержка записывается как время генерации первого токена на этапе декодирования для каждого вывода; token Задержка записывается как среднее время создания токена. Кроме того, поколение задержка представляет собой время вывода всей последовательности токенов. Для вертикальной оси Память (память), модель размер используется для представления размера памяти и напряжения, необходимого для хранения весов модели. cache size представляет размер памяти для хранения кэша KV. Кроме того, пик Память представляет собой максимальную память, необходимую для проекта генерации. Это примерно модель размер и КВ cache и размер. Память для Модели веса и КВ кэша. Если не считать задержки, пропускная способность тоже большая. обслуживания Широко используемый индикатор в рассуждениях. жетон пропускная способность представляет собой количество токенов, генерируемых в секунду, запрос Пропускная способность представляет собой количество выполненных запросов в секунду.

2.3 Анализ эффективности рассуждений

В сценариях с ограниченными ресурсами,Развертывание больших данных и поддержание их эффективности и производительности являются огромными проблемами для промышленности и научных исследований. Например,Развертывание LLaMA-2-70B с 70 миллиардами параметров,Для загрузки весов в формате данных FP16 требуется 140 ГБ видеопамяти (VRAM).,Для рассуждения необходимо не менее 6 карточек. RTX 3090Ti Графический процессор (одна карта памяти 24 ГБ) или 2 NVIDIA A100 Графический процессор (одна карта памяти 80 ГБ). Что касается задержки вывода, 2 NVIDIA A100 Генерация токена на графическом процессоре занимает 100 миллисекунд. Таким образом, генерация последовательности с сотнями токенов занимает более 10 секунд. Помимо занятости Памяти и задержки вывода, необходимо учитывать пропускную способность и энергопотребление. Процесс рассуждения большой В моделях на приведенные выше показатели сильно повлияют три важных фактора. вычислительная стоимость стоимость), стоимость доступа к памяти (память access cost)и Памятьиспользовать(memory использование). Основная причина неэффективности вывода больших моделей требует сосредоточения внимания на трех ключевых факторах:

①Model Size:主流большой Модельв целом包含数十亿甚至万亿из参数。Например,LLaMA-70BМодель включает 70 миллиардов параметров.,GPT-3 имеет 175 миллиардов параметров. в процессе рассуждения,Размер модели оказывает существенное влияние на вычислительные затраты, стоимость доступа к Память и использование Память.

②Внимание! Операция: Как описано в 2.1 и 2.2.,На этапе предварительного заполнения,Вычислительная сложность операции самообслуживания равна квадрату входной длины.,Поэтому входная длина увеличивается,Затраты на вычисления, стоимость доступа к Память и использование Память значительно возрастут.

③Decoding Подход: авторегрессионное декодирование генерируется токен за токеном. в каждом декодировании step,Все веса моделей взяты из внешнего HBM чипа графического процессора.,Стоимость доступа к Память огромна. также,Кэш KV растет с длиной ввода,Может привести к разбросу Память и нерегулярному доступу к Память.

3 TAXONOMY

В приведенном выше разделе описаны ключевые факторы, влияющие на эффективность вывода Большой модели.,Например, стоимость расчета, стоимость доступа к Память и использование Память.,и дополнительно проанализировали основные причины:Model Size、Attention OperationиDecoding Подход. Было проведено множество исследований по оптимизации эффективности рассуждений с разных точек зрения. Отзыв от iПодвести Подводя итог этим исследованиям, в статье они разделены на три уровня оптимизации, а именно: оптимизация на уровне данных, Оптимизация. уровня моделии Оптимизация на уровне системы (показано на рисунке 4):

Рисунок 4. Классификация оптимизации производительности вывода большой модели

- Оптимизация уровня данных:Прямо сейчаспроходитьоптимизациявходитьprompt(Например,сжатие входных данных) или лучше организовать выходной контент (например,,выходная организация). Этот тип оптимизации обычно не меняет исходную Модель.,Поэтому для Модели(в,Возможно, потребуется обучить небольшое количество вспомогательных Моделей, но стоимость обучения большой Модели соизмерима со стоимостью обучения большой С сравнения.,Эту стоимость можно игнорировать).

- Оптимизация уровня модели: то есть во время вывода Модели путем разработки эффективной структуры Модели (например, эффективного структурного проектирования) или сжатия предварительно обученной Модели (например, Сжатие модели) для оптимизации рассуждений, эффективности. Первый тип оптимизации обычно требует дорогостоящего предварительного обучения или небольшой тонкой настройки для сохранения или восстановления стоимости возможностей Модели, в то время как второй тип обычно приводит к снижению производительности Модели.

- Оптимизация на уровне системы:Прямо сейчасоптимизациямашина устройство или сервисная система. машина выводаизоптимизация Нет необходимости продолжать Модельтренироваться,Оптимизация сервисной системы еще более безопасна для производительности Модели. также,В статье также кратко представлен проект аппаратного ускорения эскадрильи в главе 6.3.

4. Оптимизация уровня данных

Оптимизация уровня данных Работу этого года можно разделить на две категории.,Например, оптимизация сжатия ввода или организация вывода. Технология сжатия входных данных напрямую сокращает длину входных данных модели, чтобы уменьшить потери при рассуждениях. Технология организации одновременного вывода обеспечивает пакетный (параллельный) вывод путем организации структуры выходного контента.,Этот метод может улучшить использование оборудования и уменьшить задержку генерации модели.

4.1 Сжатие входных данных

При практическом применении больших моделей слова-подсказки имеют решающее значение. Во многих работах предложены новые методы разработки слов-подсказок. Они на практике показали, что тщательно разработанные подсказки могут повысить производительность больших моделей. Например, контекстное обучение (In-Context Обучение) рекомендует включать в подсказку несколько соответствующих примеров. Этот метод может стимулировать обучение больших моделей по аналогии. Цепочка мыслей, COT)технология则是существовать上下文из示例中加入一系列中间израссуждение步骤,Используется, чтобы помочь большой модели выполнить сложные рассуждения. Однако,Эти связанные методы работы с ключевыми словами неизбежно приводят к созданию более длинных ключевых слов.,это вызов,Потому что вычислительные затраты во время предварительного заполнения увеличатся вдвое (как показано в разделе 2.3).

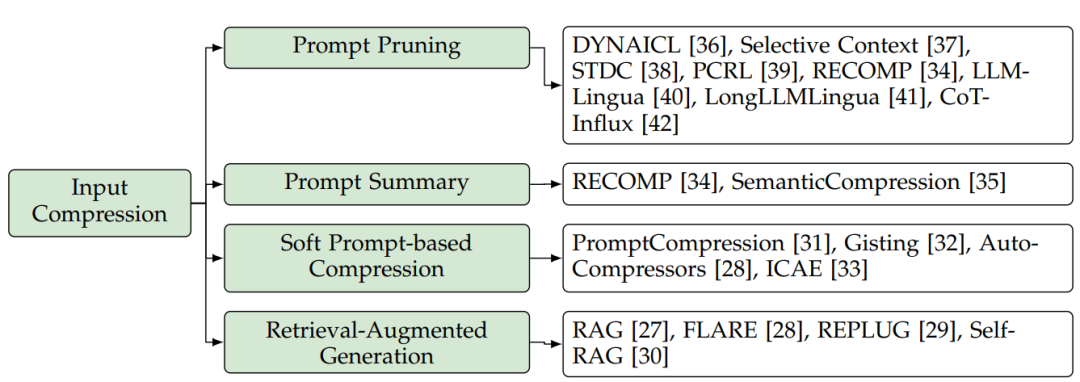

Чтобы решить эту проблему, была предложена технология сжатия входных подсказок, позволяющая сократить длину слов подсказки без существенного влияния на качество ответа большой модели. С точки зрения этой технологии, соответствующие исследования можно разделить на четыре аспекта, как показано на рисунке 5: Быстрое вырезание слов (подсказка обрезка), подсказка краткого описания слов (подсказка резюме), мягкое сжатие на основе подсказок (мягкое prompt-based compression)и Генерация улучшения поиска (поиск augmented generation, RAG)。

Рисунок 5. Классификация методов сжатия входных данных для больших моделей.

4.1.1 Своевременная обрезка

Основная идея обрезки слов в подсказке заключается в удалении неважных токенов, утверждений или документов онлайн из подсказки ввода на основе заранее определенных или изученных ключевых показателей. DYNAICL предлагает динамически определять оптимальное количество примеров контекста для данного ввода с помощью обученного контроллера на основе большой модели. Селективный Контекст В этом документе предлагается объединить токены в несколько единиц, а затем использовать индикатор, основанный на собственной информации (например, отрицательный log Подскажите отсечение на уровне единицы для вероятности). STDCбумага выполняет оперативное сокращение слов на основе дерева синтаксического анализа, которое итеративно удаляет узлы фраз, которые вызывают минимальное снижение производительности после сокращения. PCRLбумага представляет схему сокращения на уровне токена, основанную на обучении с подкреплением. Основная идея PCRL заключается в обучении политики путем объединения точности и сжатия С выравнивания в функцию вознаграждения. Точность измеряется путем расчета сходства между обрезанной выходной подсказкой и исходным словом подсказки. Метод RECOMP реализует стратегию сокращения на уровне предложений для сжатия языка с расширенными поисковыми возможностями. Language Models, РАЛМ) советы. Метод заключается в использовании предварительно обученного кодировщика для кодирования входного вопроса и документа в скрытую форму. встраивание. Затем он решает, какие документы удалить, основываясь на том, насколько похоже встраивание документа на проблемное встраивание. LLMLingua представляет схему обрезки от грубого к мелкому для быстрого сжатия. Первоначально он выполняет сокращение на демонстрационном уровне, а затем сокращение на уровне токена на основе недоумения. Для повышения производительности LLMLingua предлагает контроллер бюджета, который динамически распределяет бюджет обрезки между различными частями слова-подсказки. Кроме того, он использует итеративный алгоритм сжатия на уровне токена для устранения неточностей, вызванных предположением условной независимости. LLMLingua также использует стратегию выравнивания распределения, чтобы согласовать выходное распределение целевой большой модели с меньшей большой моделью, используемой для расчета недоумения. LongLLMLingua[41] вносит некоторые усовершенствования на основе LLMLingua: (1) Он использует условие недоумения для входного вопроса в качестве индикатора быстрого вырезания слов. (2) Он назначает разные коэффициенты обрезки различным представлениям и меняет их порядок в окончательных ключевых словах в соответствии с их индексными значениями. (3) Восстановите исходный контент на основе ответа. CoT-Influx представляет метод использования обучения с подкреплением для выполнения грубой и мелкозернистой адаптации слов-подсказок цепочки мыслей (CoT). В частности, сначала будут удалены неважные примеры, а затем продолжится удаление неважных токенов из оставшихся примеров.

4.1.2 Краткое описание

Основная идея сводки слов-подсказки состоит в том, чтобы сжать исходные слова-подсказки в более короткое резюме, сохраняя при этом аналогичную семантическую информацию. Эти методы также можно использовать в качестве методов онлайн-сжатия подсказок. В отличие от ранее упомянутого метода обрезки слов подсказки, который оставляет необрезанные пометки, этот однострочный подход преобразует всю подсказку в краткое изложение. RECOMP [34] представляет абстрактный компрессор (Abstract Compressor), который принимает входной вопрос и полученные документы в качестве входных данных и генерирует краткое резюме. В частности, он извлекает легкие компрессоры из массивной модели Подвести. итог Работа. SemanticCompression предлагает метод семантического сжатия. Сначала он разбивает текст на предложения. Затем он группирует предложения по теме. итоговые предложения в каждой группе.

4.1.3 Сжатие на основе мягких подсказок

Основная идея этой технологии сжатия заключается в разработке мягкого слова-подсказки, которое намного короче исходного слова-подсказки, в качестве входных данных большой модели. Мягкие слова-подсказки определяются как серия обучаемых последовательных токенов. Некоторые технологии используют автономное сжатие для слов подсказки с фиксированными префиксами (например, слова системной подсказки, слова подсказки для конкретной задачи). Например, PromptCompression обучает мягкие подсказки имитировать заранее определенные слова системных подсказок. Метод заключается в добавлении нескольких программных токенов перед входным токеном и позволяет корректировать эти программные токены во время обратного распространения ошибки. После точной настройки набора контрольных данных последовательность программных маркеров действует как программируемое контрольное слово. Gisting представляет метод, который использует настройку префиксных слов для сжатия слов подсказки, специфичных для задачи, в краткий набор токенов gist. Учитывая, что подсказки для конкретной задачи будут различаться от задачи к задаче, настройка префиксного слова будет использоваться индивидуально для каждой задачи. Для повышения эффективности Gisting дополнительно представляет метод метаобучения для прогнозирования новых невидимых токенов gist на основе токенов gist в предыдущих задачах.

Другие методы выполняют онлайн-сжатие каждого нового входного слова подсказки. Например, AutoCompressors обучает предварительно обученную языковую модель сжатию слов-подсказок в сводные векторы посредством обучения без учителя. ICAE обучает автокодировщик сжимать необработанный контекст в короткие слоты памяти. В частности, ICAE использует большую модель, адаптированную к LoRA, в качестве кодера, а целевую большую модель — в качестве декодера. Добавьте набор жетонов памяти и закодируйте их в слот памяти перед вводом токена.

4.1.4 Поисковая расширенная генерация (RAG)

Расширенный поиск Generation, RAG) направлен на повышение качества ответов на большие Модели за счет интеграции внешних источников знаний. RAG также можно рассматривать как метод повышения эффективности вывода при обработке больших объемов данных. RAG не объединяет всю информацию в одну слишком длинную подсказку,Вместо этого полученная соответствующая информация добавляется в исходное приглашение.,Это гарантирует, что Модель получит необходимую информацию, при этом значительно уменьшив длину слов подсказки. FLARE использует предсказания предстоящих предложений, чтобы заранее решить, когда и какую информацию получить. REPLUG рассматривает большую Модель как черный ящик.,И расширьте его с помощью настраиваемого поиска Модель. Он добавляет полученные документы на вход замороженного черного ящика. Большая модель.,И далее используйте большую Модель для контроля поиска Модели. Self-RAG повышает качество и достоверность результатов поиска за счет самоанализа. Он вводит токен обратной связи,Сделайте большую Модель управляемой на этапе рассуждения.

4.2 Организация вывода

Процесс вывода традиционных больших моделей генерируется полностью последовательно, что приводит к большим затратам времени. Методы организации вывода направлены на (частичное) распараллеливание производства путем организации структуры выходного контента.

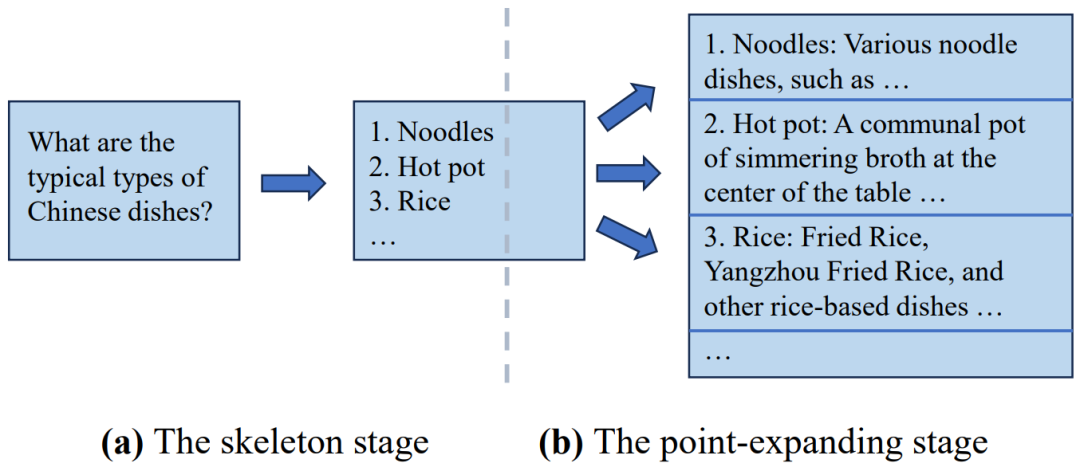

Скелет мысли (SoT) является пионером в этом направлении. Основная идея SoT — использовать новые возможности больших моделей для планирования структуры выходного контента. В частности, SoT состоит из двух основных этапов. На первом этапе (т. е. этапе формирования) SoT направляет большую модель для создания краткой структуры ответа с использованием заранее определенных «слов-подсказок для рамки». Например, если задать такой вопрос, как «Какие типичные виды китайских блюд?», результатом этого этапа будет список блюд (например, лапша, горячее, рис) без подробных описаний. Затем, на втором этапе (то есть этапе расширения точек), SoT направляет большую модель на использование «подсказки расширения точек» для одновременного расширения каждой точки в скелете, а затем соединяет эти расширения для формирования окончательного ответа. При применении к моделям с открытым исходным кодом его можно масштабировать с помощью точек выполнения пакетного вывода, что может улучшить использование оборудования и сократить общую задержку сборки при использовании тех же вычислительных ресурсов для сокращения дополнительных вычислений. Процесс рассуждения SoT показан на рисунке 6:

Накладные расходы, вызванные дополнительными словами подсказки (такими как слова подсказки скелета и слова подсказки расширения точки).,SoT обсудил возможность совместного использования KV-кэшей общих префиксов ключевых слов между несколькими узлами на этапе расширения узла. также,SoT использует Модель маршрутизации, чтобы решить, подходит ли SoT для решения конкретной проблемы.,Цель состоит в том, чтобы ограничить его использование соответствующими ситуациями. результат,SoT добился ускорения вывода в 2,39 раза на недавно выпущенной модели 12 больших моделей.,И улучшите качество ответов, увеличив разнообразие и актуальность ответов.

SGD еще больше расширяет идею SoT,Он организует подпроблемные точки в ориентированный ациклический граф (DAG).,И отвечайте на логически независимые подвопросы параллельно в течение раунда. Похоже на: Со Т,SGD также использует новые возможности Big Model.,Создайте структуру вывода, предоставив несколько примеров слов-подсказок, которые вы сами придумали. SGD ослабляет строгое предположение о независимости между различными точками.,улучшить качество ответов,Особенно по вопросам математики и кодирования. Сравнимо с SoT-сравнением,SGD отдает приоритет качеству ответа, а не скорости. также,SGD представляет метод адаптивного выбора модели,назначить оптимальный размер Модели для каждой подзадачи на основе ее предполагаемой сложности,тем самым еще больше повышая эффективность.

APAR использует идею, аналогичную SoT, используя большие модели для вывода специальных управляющих токенов (таких как , [fork]) для автоматического и динамического запуска параллельного декодирования. Чтобы эффективно использовать распараллеливаемую структуру, присущую выходному содержимому, и точно генерировать токены управления, APAR настраивает большие модели, которые выполняются на тщательно разработанных данных, сформированных в определенной древовидной структуре. В результате APAR достигает среднего ускорения от 1,4 до 2,0 раз по всем тестам с незначительным влиянием на качество ответа. Более того, APAR сравнивает свой метод декодирования с умозрительным. Сочетание технологии декодирования (например, Medusa) и структуры рассуждения (например, vLLM),Для дальнейшего улучшения задержки вывода и системы Пропускная способность。

SGLang в Python Примитивы функций представляют предметно-ориентированный язык (DSL), который гибко упрощает крупномасштабное программирование. Основная идея SGLang — автоматически анализировать зависимости между различными вызовами генерации и на этой основе выполнять пакетный вывод и совместное использование KV-кеша. Используя этот язык, пользователи могут легко реализовать различные стратегии подсказок и воспользоваться преимуществами автоматической оптимизации эффективности SGLang (например, SoT, ToT). Кроме того, SGLang также представляет и сочетает в себе несколько методов компиляции на системном уровне.,Например, перемещение кода и предварительная выборка комментариев.

4.3 Выводы, рекомендации и будущие направления

Растет потребность в больших моделях для обработки более длинных входных данных и генерации более длинных выходных данных.,Это подчеркивает важность технологии оптимизации на уровне данных. среди этих технологий,Основная цель метода сжатия входных данных — повысить эффективность этапа предварительного заполнения за счет снижения вычислительных затрат, вызванных операциями внимания. также,Для большой модели на основе API,Эти методы могут снизить затраты на API, связанные с входными токенами. На этапе С выравнивать,Метод организации вывода направлен на улучшение этапа декодирования за счет снижения существенных затрат на доступ к Память, связанных с методами авторегрессионного декодирования.

Поскольку большие модели становятся более мощными, их можно будет использовать для сжатия входных подсказок или структурирования выходного содержимого. Недавние достижения в методах организации вывода также продемонстрировали эффективность использования больших моделей для организации выходного контента в независимые точки или графики зависимостей, тем самым облегчая пакетный вывод для уменьшения задержки генерации. Эти методы используют присущую параллелизуемую структуру выходного контента, позволяя большим моделям выполнять параллельное декодирование, тем самым улучшая использование оборудования и, таким образом, уменьшая задержку сквозной генерации.

В последнее время различные конвейеры подсказок (например, ToT , GoT)и Появляется агентская структура. Хотя эти нововведения расширяют возможности больших моделей, они также увеличивают длину ввода, что приводит к увеличению вычислительных затрат. Для решения этой проблемы многообещающим решением является применение методов сжатия входных данных для уменьшения их длины. В то же время эти конвейерные структуры естественным образом привносят больше параллелизма в структуру вывода, увеличивая параллельное декодирование и распределяя KV по разным потокам декодирования. cacheиз可能性。SGLang支持灵活избольшой Модельпрограммирование,И предоставляет возможности для оптимизации внешнего и внутреннего взаимодействия.,Это закладывает основу для дальнейшего расширения и совершенствования в этой области. Суммируя,Оптимизация уровня данных,Включает методы сжатия ввода и организации вывода.,в обозримом будущем,Чтобы повысить эффективность рассуждений больших моделей,станет все более необходимым.

В дополнение к эффективности рассуждений существующих структур,Некоторые исследования также направлены на непосредственное проектирование более эффективных структур агентов. Например,FrugalGPT предлагает каскад моделей, состоящий из больших моделей разных размеров.,Если Модель достигает достаточного уровня уверенности в ответе,Тогда процесс рассуждения прекратится раньше времени。该методпроходитьиспользовать分层из Модель Архитектураина основе Модель置信度估计из智能рассуждение终止来提高效率。и Модель级别издинамическое рассуждение Технология (раздел 5.2.5) По сравнению с С выравниванием, FrugalGPT реализован на уровне конвейера динамическое рассуждение。

5 Оптимизация уровня модели

Оптимизация больших моделей эффективных рассуждений уровня Модели в основном фокусируются на оптимизации структуры модели или представления данных. Оптимизация структуры модели включает в себя непосредственно разработку эффективной структуры модели и изменение исходной модели для корректировки структуры времени рассуждения. С точки зрения оптимизации представления данных обычно используется Модель Количественная. оценка Технологии.

В этом разделе мы классифицируем методы оптимизации на уровне модели в соответствии с необходимыми дополнительными затратами на обучение. Первая категория включает в себя разработку более эффективных структур моделей (также называемую эффективным структурным проектированием). Модели, разработанные с использованием этого подхода, часто необходимо обучать с нуля. Вторая категория фокусируется на сжатии предварительно обученных моделей (так называемое сжатие модели). Модели сжатия в этой категории обычно требуют лишь минимальной тонкой настройки для восстановления своей производительности.

5.1 Эффективное структурное проектирование

в настоящий момент,Большая модель SOTA обычно использует архитектуру Transformer.,Как описано в разделе 2.1. Однако,Ключевые компоненты большой модели на базе трансформатора,Включает сеть прямой связи (FFN) и операции внимания.,в процессе рассуждения Есть проблема с эффективностью。文章认为原因нравиться下:

- FFN вносит большую часть параметров модели в большую модель на основе трансформатора.,Это приводит к значительным затратам на доступ к Память и использованию Память.,Особенно на этапе декодирования. Например,Модуль FFN занимает 63,01% в LLaMA-7BМодель,Составляет 71,69% в LLaMA-70BМодель.

- Сложность операции внимания квадратична от входной длины.,Это приводит к значительным вычислительным затратам.,Особенно при работе с более длинными контекстами ввода.

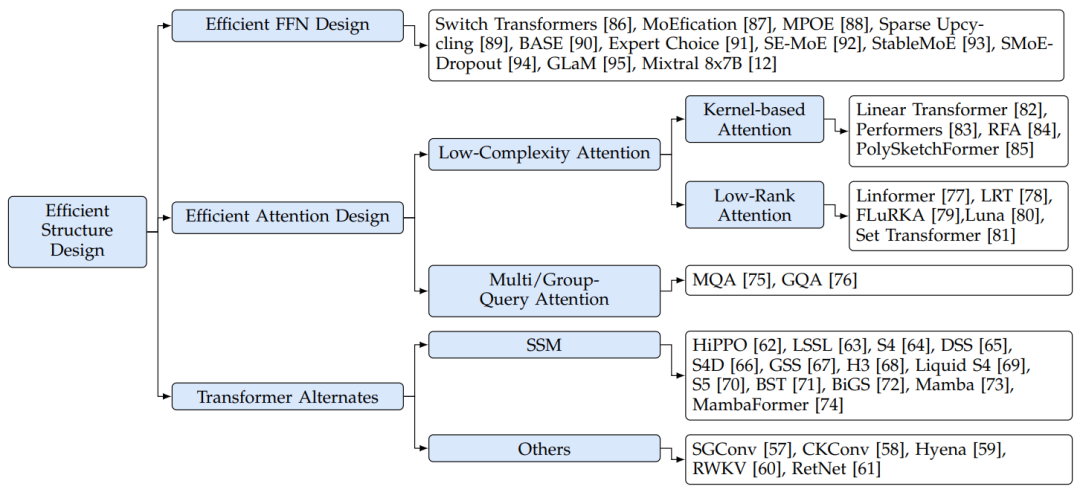

Чтобы решить эти проблемы эффективности вычислений, некоторые исследования были сосредоточены на разработке более эффективных структур Модели. В статье соответствующие исследования разделены на три группы (как показано на рисунке 7): Эффективная конструкция FFN, эффективный дизайн внимания и Альтернатива трансформатору。

Рисунок 7. Классификация эффективного структурного проектирования больших моделей.

5.1.1 Эффективная конструкция FFN

В этом отношении многие исследования были сосредоточены на интеграции методов смешанных экспертов (MoE) в большие модели для повышения производительности больших моделей при сохранении вычислительных затрат. Основная идея MoE заключается в динамическом распределении различных бюджетов при работе с разными входными токенами. В трансформаторах на базе МЭ несколько параллельных сетей прямого аудита (FFN), то есть экспертов, используются вместе с обучаемыми модулями маршрутизации. Во время вывода модель выборочно активирует конкретных экспертов для каждого токена, контролируемого модулем маршрутизации.

Некоторые исследования сосредоточены на работе экспертов FFN, в основном оптимизируя процесс получения экспертных весов или делая экспертов более легкими для повышения эффективности. Например, компания MoEfication разработала метод преобразования больших моделей, не относящихся к MoE, в версии MoE с использованием предварительно обученных весов. Такой подход устраняет необходимость дорогостоящего предварительного обучения моделей МО. Чтобы реализовать эту технологию, MoEfication сначала разделила FFN-нейроны предварительно обученной большой модели на несколько групп. Внутри каждой группы нейроны обычно активируются функциями активации одновременно. Затем он реорганизует каждую группу нейронов в качестве эксперта. Редкий Upcycling представляет метод инициализации весов LLM на основе MoE непосредственно из контрольной точки плотной модели. При таком подходе эксперты LLM на базе Министерства образования являются точными копиями FFN в плотной модели. Используя эту простую инициализацию, Sparse Апсайклинг может эффективно обучать модели МО достижению высокой производительности. MPOE предложил использовать оператор матричного произведения (Matrix Product Operators, MPO)分解来减少на основеMoEизбольшой Модельиз参数。Этот метод будетFFNиз每个масса矩阵分解为一个包含公共信息из全局共享открыть量и一组捕获特定特征из局部辅助открыть量。

Другое исследование посвящено совершенствованию конструкции модулей (или стратегий) маршрутизации в моделях МО. В предыдущей модели MoE модуль маршрутизации был склонен к проблемам с дисбалансом нагрузки, что означало, что некоторым экспертам назначалось большое количество токенов, в то время как другие эксперты обрабатывали лишь небольшое количество токенов. Этот дисбаланс не только растрачивает недостаточно используемые экспертные возможности и ухудшает производительность модели, но также ухудшает качество логических выводов. Текущие реализации Министерства образования часто используют пакетное матричное умножение для одновременного вычисления всех экспертов FFN. Для этого необходимо, чтобы входная матрица каждого эксперта имела одинаковую форму. Однако из-за проблемы дисбаланса нагрузки входной набор токенов необходимо заполнить для тех недостаточно используемых экспертов, чтобы удовлетворить ограничениям формы, что приводит к непроизводительным затратам вычислений. Таким образом, основная цель разработки модуля маршрутизации — добиться лучшего баланса в распределении токенов среди экспертов МЧС. Выключатель Трансформаторы вносят дополнительные потери, а именно потери балансировки нагрузки, в конечную функцию потерь, чтобы наказать несбалансированное распределение модуля маршрутизации. Эта потеря выражается как масштабированное скалярное произведение дробного вектора распределения токенов и вектора равномерного распределения. Следовательно, потери минимизируются только тогда, когда распределение токенов сбалансировано между всеми экспертами. Такой подход побуждает модуль маршрутизации равномерно распределять токены между экспертами, облегчая балансировку нагрузки и, в конечном итоге, улучшая производительность и эффективность модели. BASE изучает встраивание каждого эксперта сквозным способом, а затем назначает экспертам токены на основе сходства встраивания. Чтобы обеспечить балансировку нагрузки, BASE формулирует задачу линейного распределения и использует алгоритм аукциона для эффективного решения этой проблемы. Эксперт Choice представляет простую, но эффективную стратегию, обеспечивающую идеальную балансировку нагрузки моделей на основе MoE. В отличие от предыдущих методов назначения экспертов на токены, Expert Выбор позволяет каждому эксперту самостоятельно выбирать топ-k токенов на основе встроенного сходства. Такой подход гарантирует, что каждый эксперт обрабатывает фиксированное количество токенов, хотя каждый токен может быть назначен разному количеству экспертов.

Помимо вышеупомянутых исследований, посвященных самой архитектуре модели, ведется также соответствующая работа по совершенствованию методов обучения моделей на основе Министерства образования. SE-MoE вводит новую вспомогательную потерю, называемую маршрутизатором. z-loss, цель которого — повысить стабильность обучения модели без ущерба для производительности. SE-MoE обнаружило, что в модуле маршрутизации экспоненциальная функция, введенная операцией softmax, усугубляет ошибку округления и приводит к нестабильному обучению. Чтобы решить эту проблему, маршрутизатор Z-потери наказывают большие вероятности ввода в экспоненциальную функцию, тем самым сводя к минимуму ошибку округления во время обучения. StableMoE отметил, что большая Модель, основанная на MoE, имеет проблему колебаний маршрутизации, то есть распределение экспертов непоследовательно на этапах обучения и вывода. Один и тот же входной токен при обучении назначается разным экспертам, но при выводе активируется только один эксперт. Чтобы решить эту проблему, StableMoE предлагает более последовательный подход к обучению. Сначала он изучает политику маршрутизации, а затем сохраняет фиксированную политику маршрутизации на этапе обучения и вывода модели. SMoE-Dropout разрабатывает метод обучения для большой Модели на основе MoE, который предлагает постепенно увеличивать количество активированных экспертов в процессе обучения. Этот подход улучшает масштабируемость вывода Модели на основе MoE и последующей тонкой настройки. GLaM предварительно обучил и выпустил серию Моделей с разными размерами параметров, которые продемонстрировали свою производительность, сравнимую с плотной большой Моделью, на задачах с несколькими выстрелами. В этой серии Моделей самая большая Модель имеет параметры до 1,2 триллиона. Микстрал 8x7B — недавно выпущенная привлекательная модель с открытым исходным кодом. Во время вывода он использует только 13 миллиардов активных параметров и обеспечивает лучшую производительность, чем модель LLaMA-2-70B в различных тестах. Микстрал Каждый уровень 8x7B состоит из 8 экспертов сети прямой связи (FFN), и каждый токен назначается двум экспертам в процессе вывода.

5.1.2 Эффективный дизайн внимания

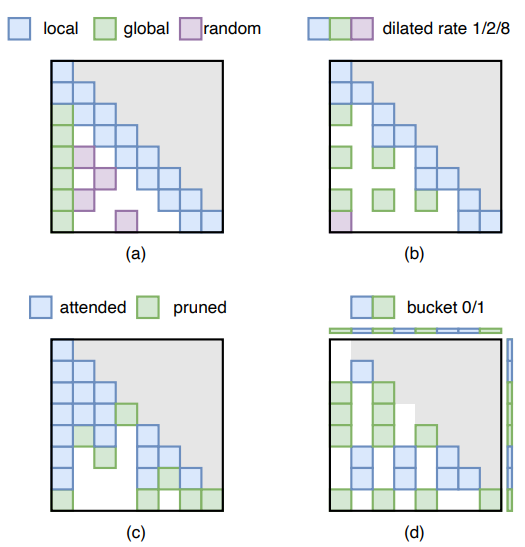

Операция внимания является ключевой частью архитектуры Transformer. Однако,Его вычислительная сложность квадратично связана с входной длиной.,Это приводит к значительным вычислительным затратам, затратам на доступ и использование,Особенно при работе с длинными контекстами. Чтобы решить эту проблему,Исследователи изучают более эффективные способы приблизить функциональность первоначальной операции внимания. Эти исследования можно условно разделить на две основные ветви: внимание с несколькими запросами и внимание низкой сложности.

①Multi-Query Attention。Multi-Query Внимание (MQA) оптимизирует внимание, разделяя кэш KV между разными головками внимания. действовать. Эта стратегия эффективно снижает стоимость доступа и использования Память во время вывода, а также помогает повысить производительность модели Transformer. Как упоминалось в разделе 2.2, большая модель трансформаторного типа обычно использует работу с несколькими головками (MHA). Эта операция требует сохранения и извлечения пар KV для каждой головки внимания на этапе декодирования, что приводит к значительному увеличению стоимости доступа и использования. MQA решает эту проблему, используя одну и ту же пару KV на разных головках, сохраняя при этом разные значения добротности. Благодаря обширному тестированию было доказано, что MQA значительно снижает требования к Памяти с небольшим влиянием на производительность Модели, что делает его ключевой технологией для повышения эффективности вывода. Групповой запрос attention(GQA)дальнейшее расширениеMQAиз概念,Его можно рассматривать как гибрид MHAиMQA. Конкретно,GQA делит головы внимания на разные группы,Затем сохраните набор значений КВ для каждой группы. Этот метод не только сохраняет преимущества MQA в сокращении накладных расходов на Память.,Это также усиливает баланс между скоростью вывода и качеством вывода.

②Low-Complexity Attention。Low-Complexity Attentionметод旨существовать设计新из机制来降低每个注意力头из计算复杂度。Чтобы упростить обсуждение,Здесь предполагается, что размеры матриц Q (запрос), K (ключ) и V (значение) одинаковы.,Прямо сейчас

. Поскольку следующая работа не предполагает изменение количества голов внимания, таких как MQA, обсуждение здесь сосредоточено на механизме внимания внутри каждой головы. Как упоминалось в разделе 2.2, вычислительная сложность традиционного механизма внимания составляет

, что эквивалентно квадратичному росту по мере увеличения входной длины. Чтобы решить проблему низкой эффективности, используется ядро AttentionиLow-Rank Был предложен метод Attention, который сводит сложность к

。

- Kernel-based Attention。на основе核из注意力设计了一个核

, путем преобразования линейного скалярного произведения между картами объектов, например,

, чтобы приблизить

нелинейная операция softmax. Он рассчитывается путем расстановки приоритетов

, а затем объединить его с

умноженный на

Связанные традиционные квадратичные вычисления. В частности, входная матрица QиK сначала передается через функцию ядра

отображается в пространстве ядра,Но сохраните первоначальные размеры. Затем используйте корреляционные свойства матричного умножения,Разрешите умножить KиV, прежде чем взаимодействовать с Q. Поэтому механизм внимания переформулируется как:

в,

. Этот метод эффективно снижает вычислительную сложность до

, что делает его линейно связанным с входной длиной. Linear Transformer — первая работа, предлагающая внимание на основе ядра. он использует

Как функция ядра, в

Представляет экспоненциальную линейную функцию активации единицы. PerformersиRFA предлагает использовать карты случайных признаков, чтобы лучше аппроксимировать функцию softmax. PolySketchFormer использует полиномиальную функцию и технологию создания эскизов для аппроксимации функции softmax.

- Low-Rank Attention。 Low-Rank Технология Attention преобразует размерность токена матрицы KиV (например,

) сжимается до меньшей фиксированной длины (т.е. если

). Этот метод основан на

Признание того, что матрицы внимания часто обладают свойствами низкого ранга.,Сделать возможным сжатие его в измерении токена. Основное внимание в этом направлении исследований уделяется разработке эффективных методов сжатия.,в

Это может быть матрица контекста или матрица KиV:

Один из методов — использовать линейную проекцию для сжатия размера токена. Это делается путем объединения матрицы KиV с матрицей отображения

Делается путем умножения. Таким образом, вычислительная сложность расчета внимания сводится к

,Линейно входной длине. Линформер впервые заметил и проанализировал низкоранговую природу внимания.,Предлагается структура внимания низкого ранга. LRT предлагает применить низкоранговую трансформацию к модулю внимания и FFN одновременно,для дальнейшего повышения эффективности вычислений. FLURKA включает преобразование низкого ранга и кернеризацию в матрицу внимания.,Эффективность еще больше повышается. Конкретно,Сначала уменьшается размерность токена матрицы KиV.,Затем примените функцию ядра к матрице Qи низкого ранга K. Помимо линейного отображения, также были предложены другие методы сжатия размеров токенов. Лунаи Сет Transformer уделяет дополнительное внимание вычислению небольших запросов для эффективного сжатия матрицы KV. Luna использует дополнительную фиксированную длину, поскольку

матрица запроса. Небольшой запрос использует исходную контекстную матрицу для выполнения вычислений внимания, называемых пакетным вниманием, для сжатия контекстной матрицы до размера

. Впоследствии регулярные вычисления внимания, называемые распаковкой Внимание, применяет вычисления внимания к исходной матрице Q и сжатой матрице K и V. Дополнительные матрицы запроса могут быть обучаемыми параметрами или получены из предыдущего уровня. Набор Transformer представляет фиксированную длину

Вектор,Были разработаны аналогичные методы. FunnelTransformer отличается от предыдущего сжатия KиV Работа,Он использует операции объединения для постепенного сжатия длины последовательности матрицы Q.

5.1.3 Замена трансформатора

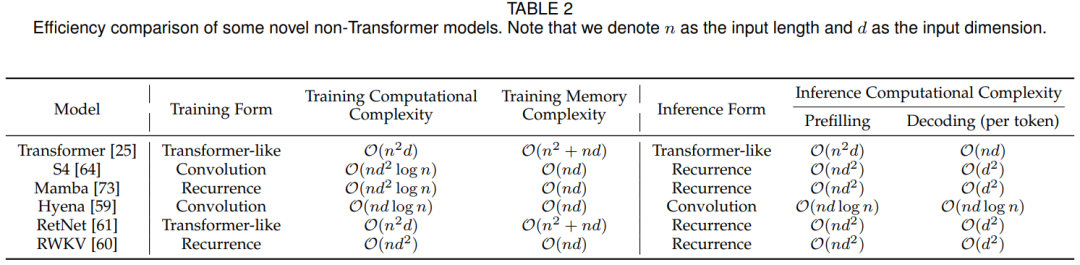

Помимо сосредоточения внимания на оптимизации операций внимания,Недавние исследования также позволили разработать новаторские эффективные и действенные архитектуры моделирования последовательностей. В таблице 2 С сравнение сравниваются некоторые типичные нетрансформаторные архитектуры. Модель производительности во время обучения и вывода.,Модели этих архитектур демонстрируют меньшую, чем квадратичную вычислительную сложность с точки зрения длины последовательности.,Позволяет большой модели значительно увеличить длину контекста.

Сравнение производительности типичных моделей архитектуры без трансформатора

Среди этих исследований можно выделить два выдающихся направления исследований, привлекших большое внимание. на. В одном из исследований основное внимание уделяется модели пространства состояний (State Space Model, SSM), эта модель рассматривает моделирование последовательностей как рекурсивное преобразование, основанное на теории HiPPO. Кроме того, другие исследования в основном сосредоточены на использовании длинных сверток или разработке формул, похожих на внимание, для моделирования последовательностей.

State Space Model:государственное пространство Модель(SSM)в некоторыхNLPиCV任务中из建模能力极具竞争力。ина основе注意力изTransformerВзаимно Сравнивать,SSM демонстрирует линейную сложность вычислений и хранения в зависимости от длины входной последовательности.,Это улучшает его способность обрабатывать длинные контекстные последовательности. В этом обзоре,SSM относится к серии архитектур моделей, которые удовлетворяют следующим двум свойствам:

(1) Они моделируют последовательность на основе следующей формулы, предложенной HiPPOиLSSL:

в,

представляет собой матрицу передачи.

является промежуточным состоянием,

это входная последовательность.

(2) Они разработали матрицу переноса A на основе теории HiPPO. В частности, HiPPO предлагает сжимать входную последовательность в последовательность коэффициентов, отображая ее в набор полиномиальных оснований (т.е.

)。

На основе вышеизложенной структуры,Некоторые исследования в основном сосредоточены на улучшении параметризации или инициализации матрицы передачи A. Это включает в себя переопределение того, как матрица формулируется или инициализируется в SSM.,Чтобы повысить эффективность решения задач моделирования последовательностей и производительности, LSSL впервые предложила оптимальную матрицу переноса, разработанную с помощью HiPPO.

Инициализируйте А. Кроме того, LSSL также обучает SSM сверточным способом, расширяя формулу (7). В частности, определив ядро свертки как

, формулу (7) можно переписать в виде

,Его также можно эффективно рассчитать с помощью быстрого преобразования Фурье (БПФ). Однако,Вычисление этого ядра свертки стоит дорого.,Потому что для этого требуется несколько раз A. с этой целью,S4, DSSиS4D предлагает диагонализировать матрицу A,Это ускоряет расчеты. Это можно рассматривать как метод параметризации матрицы преобразования A. Предыдущие SSM обрабатывали каждое входное измерение независимо.,Это приводит к большому количеству обучаемых параметров. с целью повышения эффективности,S5 предлагает использовать набор параметров для одновременной обработки всех входных измерений. На основе этой структуры,S5 представляет метод параметризации и инициализации A на основе стандартной матрицы HiPPO. Liquid S4иMamba параметризует матрицу перехода в зависимости от входных данных.,Это еще больше расширяет возможности моделирования SSM. также,S5 и Mamba используют технологию параллельного сканирования.,Операция свертки не требуется Прямой сейчас可进行有效из Модельтренироваться。这种технологиясуществовать现代GPU硬件上извыполнитьи Преимущества в развертывании。

Другим типом направления исследований является разработка лучшей архитектуры модели на основе SSM. GSS и BiGS сочетают в себе блок Gated Attention Unit (GAU) и SSM. Они заменяют операции внимания в ГАУ операциями ССМ. BST объединяет модель SSM с предлагаемым блоком, используя сильную предвзятость локального измерения. Трансформатор комбинированный. H3 отмечает, что SSM плохо запоминает старые токены в последовательностях С сравнивать. С этой целью рекомендуется добавить операцию сдвига SSM перед стандартной операцией SSM, чтобы напрямую перевести входной токен в состояние. MambaFormer объединяет стандартный Transformer и модель SSM, заменяя слой FFN в Transformer слоем SSM. Jamba представляет еще один способ объединения Transformer и SSM Model путем добавления четырех слоев Transformer в SSM Model. DenseMamba исследует проблему скрытой деградации состояния в традиционном SSM и вводит плотные соединения в архитектуру SSM для сохранения детализированной информации на более глубоких уровнях Модели. Блэк Мамбаи МО- мамба предложила использовать смесь экспертов, Технология MoE) улучшает модель SSM, сохраняя при этом производительность модели при оптимизации обучения и эффективности вывода.

Другие замены:КромеSSMснаружи,Существует несколько других эффективных альтернатив, которые также привлекают большое внимание.,Включая длинную свертку и рекурсивные операции, подобные вниманию. В некоторых исследованиях длинные свертки использовались при моделировании длинных последовательностей. Эти работы в основном касаются параметризации параметров свертки. Например,Hyena применяет параметрический подход, зависящий от данных,Для длинных сверток используются мелкие нейронные сети прямого распространения (FFN). Другие операции по проектированию,Но его можно включить в исследования кругового подхода.,Это обеспечивает эффективное обучение и эффективное рассуждение. Например,РВКВ построен на базе АФТ.,AFT предлагает заменить операцию внимания в Модели Трансформатора на следующую формулу:

в,

иTransformerТакой же , соответственно запрос, ключ, значение,

это обучаемое попарное смещение позиции

является нелинейной функцией. В частности, он дополнительно перепараметризирует отклонение положения,

,Таким образом, уравнение (8) можно переписать в рекурсивную форму. так,RWKV может сочетать эффективные функции параллельного обучения Transformer и эффективные возможности рассуждения RNN.

Анализ эффекта:Статья в таблице2средний анализи Сравниватьсравнивать了几种创新изи具有代表性из非Transformer架构из Модельиз计算и Памятьсложность。существоватьтренироваться时间方面,много Модель(нравитьсяS4, Hyena, RetNet) Они поддерживают параллелизм обучения, используя такие формы обучения, как свертки или внимание. Стоит отметить, что Mamba использует технологию параллельного сканирования для обработки входной последовательности, тем самым также используя обучающий параллелизм.

с другой стороны,в процессе рассуждения,В большинстве исследований выбирают циклическую архитектуру для поддержания линейной сложности вычислений на этапе предварительного заполнения и сохранения независимости длины контекста на этапе декодирования. и,На этапе декодирования,Эти новые архитектуры устраняют необходимость в кэшировании и загрузке функций исторических токенов (аналогично кэшу KV в модели языка на основе Transformer).,Это существенно экономит затраты на доступ к Память.

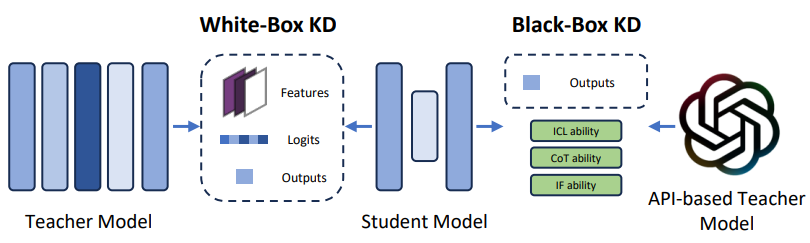

5.2 Сжатие модели

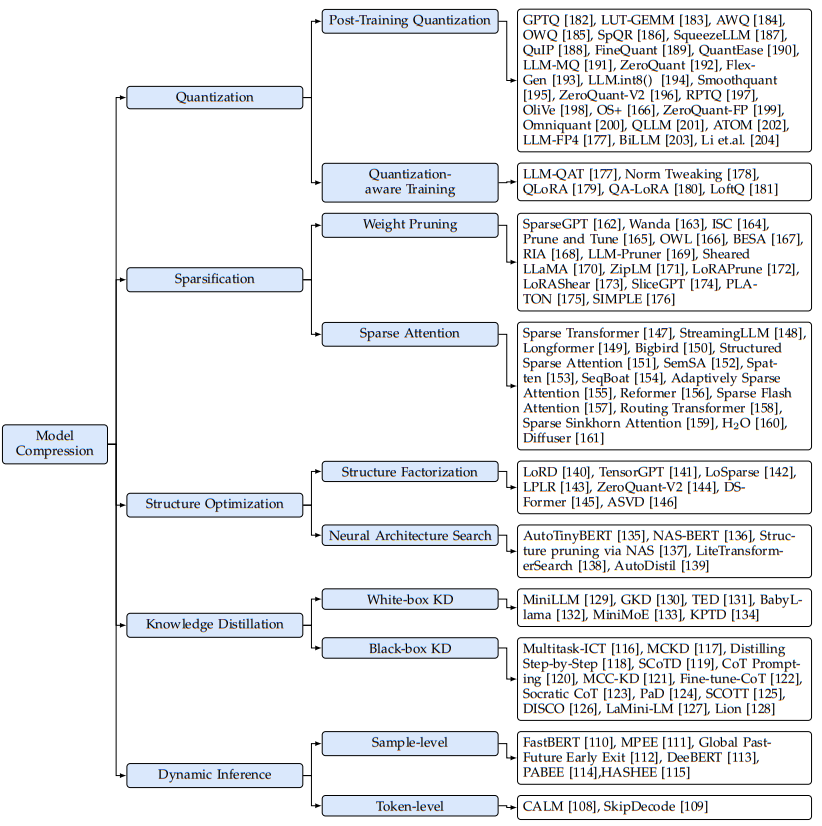

Сжатие Модели включают в себя ряд представлений данных, предназначенных для предварительного обучения путем изменения Модели (например, Количественная оценку) или изменить архитектуру модели (например, разрежение, оптимизация структуры). рассуждение) для повышения эффективности рассуждений, как показано на рисунке 8.

Рисунок 8. Классификация методов сжатия моделей для больших моделей.

5.2.1 Количественная оценка

Количественная Оценка — это широко используемый метод снижения вычислительных затрат больших Модель и Память путем преобразования весов и активаций Модели из представления с высокой разрядностью в представление с низкой разрядностью. В частности, многие методы включают преобразование тензоров FP16 Количественная Оценка представляет собой низкоразрядный целочисленный тензор, который можно выразить следующей формулой:

в

Представляет 16-битное значение с плавающей запятой (FP16),

Представляет целочисленное значение низкой точности.

представляет количество цифр,

и

Представляет коэффициент масштабирования и нулевую точку.

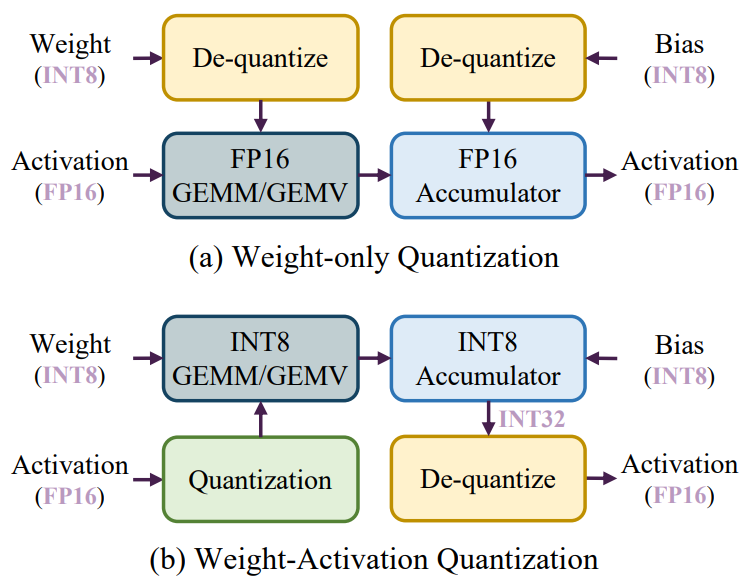

Далее статья начинается с анализа эффективности, чтобы проиллюстрировать, как методы квантования могут уменьшить задержку сквозного вывода для больших моделей. Позже будут подробно представлены два различных количественных рабочих процесса: Quantization (PTQ)иQuantization-Aware Training (QAT)。

анализ эффективности:нравиться2.2описано в разделе,Процесс рассуждения большой Модели состоит из двух этапов: этапа предварительного заполнения и этапа декодирования. На этапе предварительного заполнения,Большая модель обычно обрабатывает длинные последовательности токенов.,Основная операция — общее матричное умножение (GEMM). Задержка фазы предварительного заполнения в основном ограничивается вычислительными операциями, выполняемыми высокоточным ядром CUDA. Чтобы решить эту проблему,现有из研究методверномассаиактивация Количественная возможность использования низкоточных тензорных ядер для ускорения вычислений. Как показано на рисунке 9. Как показано на (b), квантование активации выполняется онлайн перед каждой операцией GEMM, что позволяет использовать для вычислений ядра тензора низкой точности (такие как INT8). Этот метод квантования называется квантованием активации веса.

。

Напротив, на этапе декодирования большие модели обрабатывают только один токен за шаг генерации, используя общее умножение матрицы-вектора (GEMV) в качестве основной операции. На задержку на этапе декодирования в основном влияет загрузка тензоров большого веса. Чтобы решить эту проблему, существующие методы сосредоточены только на квантованных весах для ускорения доступа к памяти. Этот метод называется

, сначала квантовать веса в автономном режиме, а затем деквантовать веса низкой точности в формат FP16 для расчета, как показано на рисунке 9 (a).

Рисунок 9: (a) Процесс рассуждения о количественном определении чистого веса. (б) Процесс количественного рассуждения активации веса.

Post-Training Quantization: PTQ предполагает проведение Количественной предварительной подготовки Модель повышение квалификации без необходимости переобучения, которое может оказаться дорогостоящим процессом. Хотя метод PTQ был хорошо изучен в меньшей Модели, добавление существующей Количественной Существуют трудности с непосредственным применением технологии оценки к большим моделям. Это происходит главным образом потому, что веса и активации больших Моделей обычно демонстрируют больше выбросов и имеют более широкий диапазон распределения, чем меньшие, что делает их Количественную оценка является более сложной задачей. Короче говоря, сложный характер большой Модели, характеризующийся ее размером и сложностью, требует специализированных методов для эффективного управления Количественной моделью. процесс оценки. Наличие выбросов и более широкий диапазон распределения в крупных Модель требует разработки индивидуальной Количественной модели. технология повышения качества, позволяющая обрабатывать эти уникальные характеристики, не влияя на производительность или эффективность модели.

Большое количество исследований было посвящено разработке эффективных алгоритмов квантования для сжатия больших моделей. В этой статье представлен синтез репрезентативных алгоритмов, классифицированных по четырем измерениям в таблице 3. Для типов квантованных тензоров некоторые исследования сосредоточены только на весовых показателях. квантование, в то время как многие другие исследования сосредоточены на весе и активации Количественная оценка. Стоит отметить, что в большой Модели кэш KV представляет собой уникальный компонент, влияющий на доступ к Памяти Память. Поэтому в некоторых исследованиях предлагается выполнять Количественную работу на КВ-кэше. оценка。существовать Количественная Что касается формата оценки, то для облегчения аппаратной реализации большинство алгоритмов используют унифицированный формат. О Количественной Для определения параметров (таких как коэффициенты масштабирования, нулевые точки) большинство исследований полагаются на статистику, полученную на основе весов или значений активации. Однако есть также некоторые исследования, которые рекомендуют находить оптимальные параметры на основе потерь при реконструкции. Кроме того, некоторые исследования также показывают, что в Количественной оценкадо или Количественная оценка Не обновляется в процессе Количественная Вес оценки (называемый

) для улучшения производительности.

только для веса Среди методов квантования GPTQ представляет собой раннюю и лучшую работу по квантованию больших моделей, основанную на традиционном алгоритме OBQ. OBQ достигает оптимального порядка квантования каждой строки весовых матриц, используя ошибку восстановления относительно матрицы Гессе неквантованных весов. После каждого шага квантования OBQ итеративно корректирует неквантованные веса, чтобы уменьшить ошибки реконструкции. Однако частые обновления матрицы Гессе во время процесса квантования увеличивают сложность вычислений. GPTQ упрощает этот процесс, принимая единый порядок слева направо для квантования каждой строки, что позволяет избежать необходимости обширных обновлений матрицы Гессе. Эта стратегия значительно снижает вычислительные требования, поскольку при квантовании строки вычисляется только матрица Гессе, а затем используются результаты вычислений для последующих строк, тем самым ускоряя весь процесс квантования. ЛУТ- GEMM предлагает новый метод с использованием справочных таблиц (Look-Up Table, LUT)из去Количественная метод оценки, предназначенный для уменьшения количества Количественной оценканакладные расходы, чтобы ускориться Количественная Процесс рассуждения о оценке модели. Кроме того, он использует метод, называемый бинарным кодированием Количественная. оценка(BCQ)из非均匀Количественная метод оценки, который содержит обучаемую Количественную интервал открытия. AWQ отмечает, что весовые каналы различаются по своей важности для производительности, при этом особое внимание уделяется тем каналам, которые совпадают с входными каналами, которые активируют выбросы. Чтобы улучшить сохранение ключевых весовых каналов, AWQ использует сложный метод параметризации. Этот метод выбирает коэффициенты повторной параметризации посредством поиска по сетке, что эффективно уменьшает ошибку реконструкции. OWQ заметил Количественная Оценка сложности с весами, связанными с активацией выбросов. Чтобы решить эту проблему, OWQ использует Количественную точность смешанной точности. стратегия оценки. Этот метод выявляет слабые столбцы в матрице весов и присваивает этим конкретным весам более высокую точность, сохраняя при этом более низкий уровень точности. рейтинг Оставшиеся веса. SpQR представляет метод в Количественной Процесс оценки идентифицирует и присваивает выбросам более высокие веса точности, в то время как остальные веса являются количественными. Кредит состоит из 3 цифр. SqueezeLLM предлагает хранить выбросы в разреженной матрице полной точности и применять неравномерную Количественную к оставшимся весам. оценка。в соответствии с Количественная оценка Определение чувствительности неоднородной Количественной Значение оценки может увеличить ценность Количественной Производительность модели оценки.QuIP представляет LDLQ, оптимальный адаптивный метод для квадратичных суррогатных целей. Исследования показывают, что обеспечение несогласованности между весами и матрицами Гессе может повысить эффективность LDLQ. QuIP использует LDLQ для достижения некогерентности посредством умножения случайных ортогональных матриц. FineQuant использует эвристический подход. Для определения каждого столбца Количественная детализация оценок в сочетании с эмпирическими данными, полученными в результате экспериментов по разработке Количественной схема оценки. Работа от QuantEase построена на основе GPTQ. Выполнение Количественной на каждом слое оценки, он предложил метод, основанный на спуске по координатам, для более точной компенсации недостающей Количественной Вес признания. Кроме того, QuantEase может использовать Количественную информацию из GPTQ. Веса оценок служат инициализацией и дальнейшим уточнением процесса компенсации. LLM-MQ защищает выбросы веса в формате FP16 и сохраняет их в формате сжатых разреженных строк (CSR) для повышения эффективности вычислений. Кроме того, LLM-MQ моделирует распределение разрядности каждого слоя как задачу целочисленного программирования и использует эффективный решатель для ее решения за секунды. LLM-MQ также разработала эффективное ядро CUDA для интеграции де-Количественной оператора оценки, тем самым снижая стоимость доступа к Память при расчетах.

Для активации веса квантования, ZeroQuant использует мелкозернистую Количественную определение веса и активации, использование ядерного синтеза для минимизации Количественной Память стоимость доступа в процессе оценки и выполнять дистилляцию знаний слой за слоем для восстановления производительности. FlexGen кэширует веса и напрямую Количественную. преобразовать в INT4, чтобы уменьшить занятость Память во время вывода больших объемов данных. ЛЛМ.int8() Было обнаружено, что выбросы в активации сконцентрированы в небольшом подмножестве каналов. Исходя из этого, LLM.int8() Разделите активацию и веса на две разные части на основе распределения выбросов внутри входного канала, чтобы минимизировать Количественную ценность активации. ошибка тарификации. Каналы, содержащие данные исключений значений активации и весов, хранятся в формате FP16, остальные каналы хранятся в формате INT8. SmoothQuant использует технику перепараметризации для решения Количественной задачи. Вызов значения активации. Этот метод вводит примерный коэффициент Сравнивать, который расширяет диапазон данных весового канала и уменьшает диапазон данных соответствующего канала активации. ZeroQuant представляет Количественную систему группового уровня Оценка Стратегия и активированный уровень токена Количественная метод оценки. На основе этого метода ZeroQuantV2 предлагает технологию LoRC (компенсация низкого ранга), использующую матрицу низкого ранга для облегчения проблемы Количественной компенсации. оценка Неточность. RPTQ обнаружил, что распределение различных активированных каналов на самом деле меняется, что дает Количественную качество приносит проблемы. Чтобы облегчить эту проблему, RPTQ реорганизует каналы с одинаковым распределением активации в кластеры и применяет Количественную независимо в каждом кластере. оценка. OliVe отмечает, что нормальные значения вблизи выбросов менее критичны. Таким образом, он объединяет каждый выброс с нормальным значением, жертвуя нормальным значением, чтобы получить более широкий диапазон представлений выбросов. OS+ отмечает, что распределение выбросов концентрированное и асимметричное, что является проблемой для больших моделей. Оценка представляет собой проблему. Чтобы решить эту проблему, OS+ представляет технологию перемещения и масштабирования на уровне канала. Определение параметров перемещения и масштабирования в процессе поиска позволяет эффективно обрабатывать концентрированные и асимметричные распределения выбросов. ZeroQuant-FP изучает веса и активации Количественная возможность уточнения формата FP4 и FP8. Исследования показывают, что сравнение С с целочисленными типами активирует Количественную Оценка для типов с плавающей запятой (FP4 и FP8) даст лучшие результаты. Всеведущий с предыдущими зависимостями Количественная Методы эмпирического расчета параметров оценки различны. Вместо этого он оптимизирует веса, обрезанные границы и эквивалентные коэффициенты масштабирования преобразования, чтобы минимизировать Количественную ценность. ошибка тарификации. QLLM устраняет пары выбросов путем реализации реорганизации каналов Количественная Влияние рейтинга. Кроме того, QLLM также разработал обучаемые параметры низкого ранга, чтобы уменьшить постквантованную Количественную ошибка тарификации. Atom использует смешанную точность и динамическую Количественную точность. Активированная стратегия. Примечательно, что этот подход расширяется и включает в себя Количественный кэш KV. Улучшение для INT4 для повышения пропускной способности. LLM-FP4 стремится преобразовать всю Модель Количественную Creature — это формат FP4, в котором реализована технология смещения индекса перед сменой. Этот метод сочетает в себе коэффициент примера Сравнивать значения активации с весом для решения проблемы количественности, вызванной выбросами. проблема с оценкой. BiLLM представляет собой один из самых низких показателей PTQ на сегодняшний день. BiLLM идентифицирует колоколообразное распределение весов и аномальное распределение «длинного хвоста» матрицы весов Гессе. На этом основании предлагается классифицировать весовую структуру на основе матрицы Гессе на значимые значения и незначимые значения и бинаризировать их соответственно. Таким образом, BiLLM может конвертировать большие модели в широкий спектр Количественных моделей. значение до 1,08, не уменьшая значительно недоумения. KVQuant предлагает Количественную кэш-память KV путем определения оптимальных типов данных в автономном режиме на калибровочном наборе. оценкаиз非均匀Количественная схема оценки. КИВИ предлагает 2бит, не требующий настройки Алгоритм квантования кэша KV, который использует одноканальное квантование для ключей. кеш, используя количественную оценку значения с помощью одного токена кэш. Ли и др. выполнили комплексную оценку влияния квантования на различные типы тензоров (включая KV). Кэш), различные задания, 11 разных больших МодельиSOTA Количественная Влияние метода оценки.

Quantization-Aware Training:QATсуществовать Модельтренироваться过程中考虑了Количественная Влияние рейтинга. Копировать путем интеграции Количественная уровень эффектов, QAT помогает весам адаптироваться Количественная ошибки, вызванные точностью, тем самым повышая производительность задачи. Однако обучение большой модели обычно требует большого количества обучающих данных и вычислительных ресурсов, что является потенциальным узким местом для реализации QAT. Поэтому текущие исследования «Работа» фокусируются на стратегиях снижения требований к обучающим данным или облегчения вычислительной нагрузки, связанной с реализацией QAT. Чтобы снизить требования к данным, LLM-QAT представляет подход без данных, который использует большой размер исходного FP16 для генерации обучающих данных. В частности, LLM-QAT использует каждый токен словаря в качестве стартового токена для генерации предложений. На основе сгенерированных данных обучения LLM- QAT применяет рабочий процесс на основе дистилляции для обучения квантованного LLM, чтобы он соответствовал выходному распределению исходной большой модели FP16. Норма Твик лишь ограничивает выбор стартовых тегов для тех языков, на которые приходится наибольшая доля в языковой категории. Эта стратегия может эффективно улучшить производительность генерации квантованных моделей для различных задач.

Чтобы уменьшить объем вычислений, во многих методах применяется точная настройка с эффективным использованием параметров. тюнинг, PEFT) стратегия ускорения QAT. QLoRA квантует веса больших моделей в 4 бита, а затем использует LoRA для каждой 4-битной матрицы весов в BF16 для точной настройки квантованной модели. QLoRA позволяет эффективно настраивать большие модели с 65B параметрами на графическом процессоре всего с 30 ГБ памяти. QALoRA предлагает добавить в QLoRA групповое квантование. Авторы отмечают, что количество параметров квантования в QLoRA значительно меньше количества параметров LoRA, что приводит к дисбалансу между квантованием и низкоранговой адаптацией. Они предположили, что операции на уровне группы могут решить эту проблему за счет увеличения количества параметров, предназначенных для количественной оценки. Кроме того, QA-LoRA может включать термины LoRA в соответствующую матрицу весов квантования. LoftQ отмечает, что инициализация матриц LoRA нулями в QLoRA неэффективна для последующих задач. В качестве альтернативы LoftQ предлагает использовать разложение по сингулярным значениям (разложение по сингулярным значениям) разрыва между исходными весами FP16 и квантованными весами. Value Разложение, SVD) для инициализации матрицы LoRA. LoftQ итеративно применяет Количественную разложение по сингулярным значениям для получения более точного приближения к исходным весам. Норма Твик предлагал обучить слой LayerNorm после квантования и использовать дистилляцию знаний для сопоставления выходного распределения квантованной модели с выходным распределением модели FP16, достигая эффекта, аналогичного LLM-QAT, избегая при этом более высоких затрат на обучение.

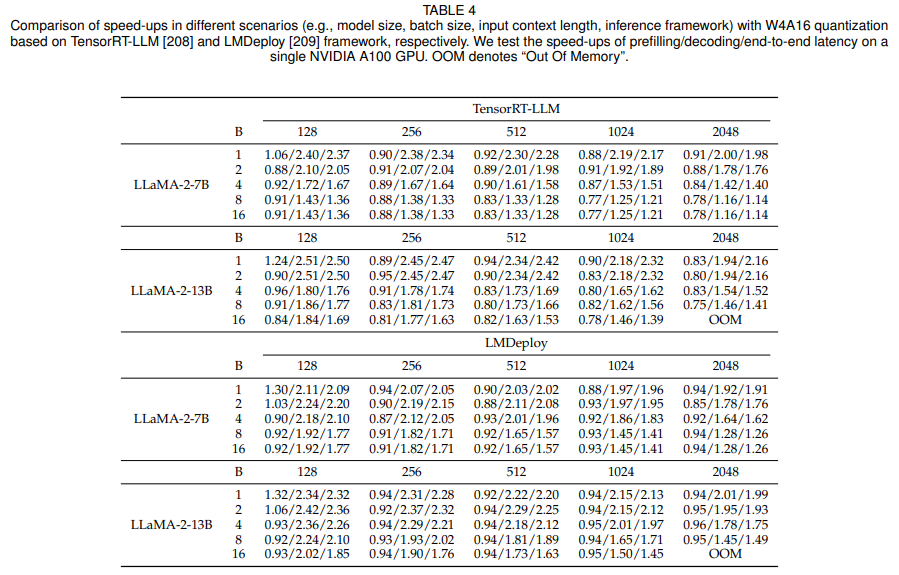

Эксперимент и анализ Сравнивать:本综述изавторвернодругой场景下изweight-only Эффект ускорения, создаваемый технологией квантования. Автор использовал LLaMA-2-7B и LLaMA-2-13B и взвешивал их с помощью AWQ Количественная разрядность до 4 бит. Автор использует NVIDIA A100 проводит эксперименты и развертывает Количественную с использованием двух фреймворков вывода TensorRT-LLMиLMDeploy. оценка后избольшой Модель。Затем,Авторы оценивают ускорение, достигнутое этими системами вывода на различных входных последовательностях.,Эти последовательности различаются по размеру пакета и длине контекста. Эффект ускорения задержки предварительного заполнения и задержки декодирования, сквозная задержка,Как показано в Таблице 4.

Таблица 4: Сравнение эффектов ускорения больших моделей

Результаты экспериментов показывают: (1) Только вес Квантование можно ускорить на этапе декодирования, тем самым достигая сквозного ускорения. Это улучшение в основном происходит за счет перехода от памяти с высокой пропускной способностью ( High Bandwidth Память (HBM) ускоряет загрузку квантованных моделей с весовыми тензорами низкой точности, этот подход значительно снижает накладные расходы на доступ к памяти. (2) На этапе предварительного наполнения измеряется только вес. Квантование может увеличить задержку. Это связано с тем, что узким местом на этапе предварительного заполнения являются вычислительные затраты, а не накладные расходы на доступ к памяти. Следовательно, только квантование весов без активации оказывает минимальное влияние на задержку. Кроме того, как показано на рисунке 9, только вес Квантование требует удаления весов низкой точности. приравнивается к FP16, что приводит к дополнительным вычислительным затратам и, таким образом, замедляет предварительное заполнение. (3) По мере увеличения размера партии и входной длины учитывается только вес. Ускорение квантования постепенно уменьшается. Это происходит главным образом потому, что для больших размеров пакетов и длины входных данных вычислительные затраты составляют задержку для более крупных случаев. Хотя только вес Квантование в основном снижает затраты на доступ к Память, но по мере увеличения размера пакета и длины входных данных вычислительные требования становятся более заметными, а его влияние на задержку становится менее значительным. (4) Поскольку стоимость доступа к Память связана с размером параметра Модели, учитывается только вес. Квантование обеспечивает большие преимущества для Модели с большими размерами параметров. По мере роста сложности и размера объекта неизбежно будет увеличиваться объем информации, необходимой для хранения и доступа к весам. Количественная оценка Модельмасса,weight-only Квантование может эффективно снизить занятость Памяти и накладные расходы на доступ к Память.

5.2.2 Разреженность

Разреженность — это метод сжатия,В структуры данных можно добавлять экземпляры Сравнивать элементов с нулевым значением (например, параметры модели или активации). Этот метод снижает сложность вычислений за счет эффективного игнорирования нулевых элементов во время вычислений. Применительно к большой модели,Разреженность обычно применяется к параметрам веса и активации внимания. Это привело к разработке стратегий снижения веса и механизмов разреженного внимания.

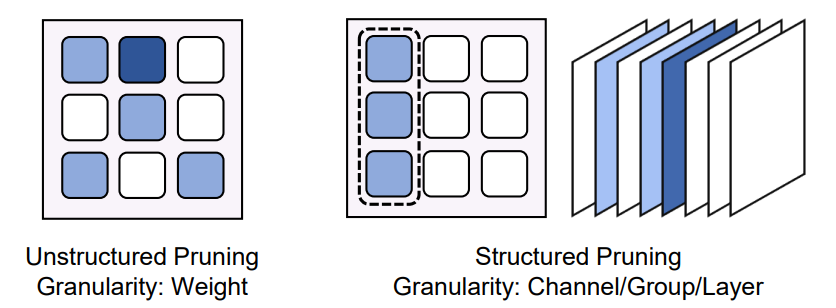

Весовая обрезка (Вес Pruning):权值修剪система地从Модель中去除不太关键из权值иструктура,Предназначен для снижения вычислительных затрат на этапе предварительного заполнения и этапе декодирования.,без существенного влияния на продуктивность. Этот метод разреживания делится на два основных типа: неструктурированная обрезка и структурированная обрезка. Их классификация основана на детализации процесса обрезки.,Как показано на рисунке 10.

Рисунок 10: Неструктурированная обрезка и структурированная обрезка

Неструктурированная обрезка позволяет сократить отдельные значения веса с высокой степенью детализации. Используйте структурированную обрезку,Обычно он обеспечивает более высокую разреженность с минимальным влиянием на прогнозы Модели. Однако,Редкие узоры, полученные за счет неструктурированной обрезки, не имеют регулярности на высоком уровне.,Вызывает нерегулярный доступ к Память и шаблоны вычислений. Эта неравномерность может серьезно затруднить потенциал аппаратного ускорения.,Потому что современная вычислительная архитектура рассчитана на плотные, регулярные данные. поэтому,Несмотря на достижение более высоких уровней разреженности,Но реальные преимущества неструктурированного сокращения с точки зрения аппаратной эффективности и ускорения вычислений могут быть ограничены.

В центре внимания обрезки веса является критерий обрезки.,Включает важность веса и пример сравнения дифферента. Учитывая огромные размеры параметров большой модели,Повышение эффективности обрезки также имеет решающее значение. Одним из критериев сокращения является минимизация потерь при реконструкции Модели. SparseGPT — типичный метод в этой области. Это соответствует идее OBS,Рассмотрим влияние удаления каждого веса на потери при реконструкции сети. OBS итеративно определяет маску обрезки для сокращения весов.,и реконструировать необрезанные веса, чтобы компенсировать потери от обрезки. SparseGPT преодолевает узкое место эффективности OBS за счет оптимальной технологии частичного обновления.,设计了一种на основеOBS重构ошибкаиз自适应掩码选择технология。Prune and Tune улучшает SparseGPT за счет точной настройки большой модели с использованием минимальных шагов обучения во время сокращения. ISC разработал новый стандарт обрезки, сочетающий стандарты значимости OBS и OBD. Алгоритм дополнительно назначает экземпляры неравномерного сокращения Сравнивать каждому слою на основе информации Гессиана. BESA изучает дифференцируемую бинарную маску посредством градиентного спуска с потерями при реконструкции. Обрезка каждого слоя определяется поочередной минимизацией ошибки реконструкции. Еще один популярный критерий обрезки — размер. Ванда предложила использовать поэлементное произведение веса на норму входной активации в качестве критерия сокращения. RIA совместно учитывает вес и активацию, используя меру относительной важности и активации, которая оценивает важность каждого элемента веса на основе веса всех его связей. Кроме того, RIA преобразует неструктурированную разреженную парадигму в структурированную разреженную парадигму N:M, которую можно найти на NVIDIA. Получите настоящее ускорение на графическом процессоре. OWL фокусируется на определении коэффициента обрезки каждого слоя. Он назначает коэффициент сокращения каждому слою на основе коэффициента выбросов активации.

По сравнению с неструктурированным сокращением, структурированное сокращение работает с более грубой степенью детализации, удаляя более крупные структурные единицы в модели, такие как целые каналы или слои. Эти методы напрямую способствуют ускорению вывода на традиционных аппаратных платформах, поскольку они соответствуют плотным, регулярным парадигмам данных, для обработки которых оптимизированы эти системы. Однако более грубая степень детализации структурированного сокращения часто оказывает более выраженное влияние на производительность модели. Такие стандарты обрезки также предусматривают структурированную схему обрезки. LLM-Prune предлагает независимый от задачи структурированный алгоритм сокращения. В частности, он сначала идентифицирует структуры связи в больших моделях на основе зависимостей связей между нейронами. Затем он решает, какие структурные группы удалить, на основе хорошо продуманных показателей сокращения на уровне группы. После сокращения предлагается восстановить производительность модели с помощью университетской технологии обучения параметров, такой как LoRA. Sheared LLaMA предлагает сократить исходную большую модель до конкретной целевой архитектуры существующей предварительно обученной большой модели. Кроме того, он разрабатывает технологию динамической пакетной загрузки данных для улучшения производительности после обучения.