14 изображений, подробно описывающих Zookeeper + Kafka в развертывании среды K8S

1. Обзор

Apache ZooKeeperZooKeeper — это централизованная служба, используемая для хранения информации о конфигурации, имени, обеспечения распределенной синхронизации и предоставления групповых услуг. Стремление к разработке и поддержке сервера с открытым исходным кодом.,добиться высокой надежностиРаспределенная координация,Фактически, его также можно рассматривать как одинРаспределенная база данных,Просто конструкция особенная,представляет собой древовидную структуру。Официальный документ сайта:https://zookeeper.apache.org/doc/r3.8.0/

Kafkaизначально был сделан Linkedin Разработанный компанией, это распределенная многокопийная реплика с поддержкой разделов, основанная на zookeeper скоординированныйРаспределенная система обмена сообщениями。Официальная документация:https://kafka.apache.org/documentation/

2. Zookeeper о развертывании k8s

1) Добавить источник

Адрес пакета развертывания:

helm repo add bitnami https://charts.bitnami.com/bitnami

helm pull bitnami/zookeeper

tar -xf zookeeper-10.2.1.tgz

2) Изменить конфигурацию

- Исправлять

zookeeper/values.yaml

image:

registry: myharbor.com

repository: bigdata/zookeeper

tag: 3.8.0-debian-11-r36

...

replicaCount: 3

...

service:

type: NodePort

nodePorts:

#NodePort Область действия по умолчанию 30000-32767

client: "32181"

tls: "32182"

...

persistence:

storageClass: "zookeeper-local-storage"

size: "10Gi"

# Каталог необходимо заранее создать на хост-компьютере.

local:

- name: zookeeper-0

host: "local-168-182-110"

path: "/opt/bigdata/servers/zookeeper/data/data1"

- name: zookeeper-1

host: "local-168-182-111"

path: "/opt/bigdata/servers/zookeeper/data/data1"

- name: zookeeper-2

host: "local-168-182-112"

path: "/opt/bigdata/servers/zookeeper/data/data1"

...

# Enable Prometheus to access ZooKeeper metrics endpoint

metrics:

enabled: true

- добавить в

zookeeper/templates/pv.yaml

{{- range .Values.persistence.local }}

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: {{ .name }}

labels:

name: {{ .name }}

spec:

storageClassName: {{ $.Values.persistence.storageClass }}

capacity:

storage: {{ $.Values.persistence.size }}

accessModes:

- ReadWriteOnce

local:

path: {{ .path }}

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- {{ .host }}

---

{{- end }}

- добавить в

zookeeper/templates/storage-class.yaml

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: {{ .Values.persistence.storageClass }}

provisioner: kubernetes.io/no-provisioner

3) Начать установку

# Сначала подготовьте изображение

docker pull docker.io/bitnami/zookeeper:3.8.0-debian-11-r36

docker tag docker.io/bitnami/zookeeper:3.8.0-debian-11-r36 myharbor.com/bigdata/zookeeper:3.8.0-debian-11-r36

docker push myharbor.com/bigdata/zookeeper:3.8.0-debian-11-r36

# Начать установку

helm install zookeeper ./zookeeper -n zookeeper --create-namespace

NOTES

NAME: zookeeper

LAST DEPLOYED: Sun Sep 18 18:24:03 2022

NAMESPACE: zookeeper

STATUS: deployed

REVISION: 1

TEST SUITE: None

NOTES:

CHART NAME: zookeeper

CHART VERSION: 10.2.1

APP VERSION: 3.8.0

** Please be patient while the chart is being deployed **

ZooKeeper can be accessed via port 2181 on the following DNS name from within your cluster:

zookeeper.zookeeper.svc.cluster.local

To connect to your ZooKeeper server run the following commands:

export POD_NAME=$(kubectl get pods --namespace zookeeper -l "app.kubernetes.io/name=zookeeper,app.kubernetes.io/instance=zookeeper,app.kubernetes.io/component=zookeeper" -o jsonpath="{.items[0].metadata.name}")

kubectl exec -it $POD_NAME -- zkCli.sh

To connect to your ZooKeeper server from outside the cluster execute the following commands:

export NODE_IP=$(kubectl get nodes --namespace zookeeper -o jsonpath="{.items[0].status.addresses[0].address}")

export NODE_PORT=$(kubectl get --namespace zookeeper -o jsonpath="{.spec.ports[0].nodePort}" services zookeeper)

zkCli.sh $NODE_IP:$NODE_PORT

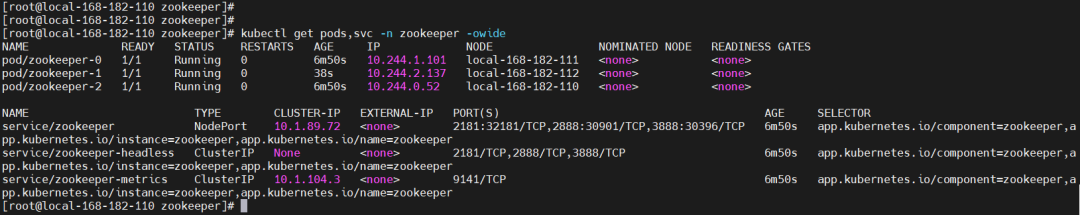

Посмотреть статус модуля

kubectl get pods,svc -n zookeeper -owide

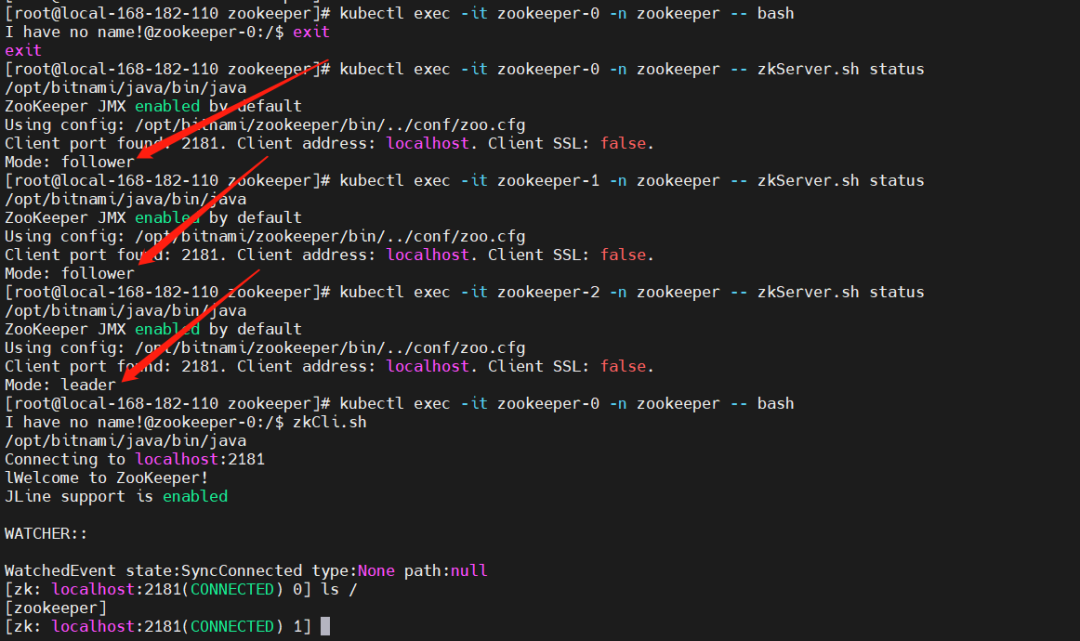

4) Тестовая проверка

# Войти в Zookeeper pod

kubectl exec -it zookeeper-0 -n zookeeper -- zkServer.sh status

kubectl exec -it zookeeper-1 -n zookeeper -- zkServer.sh status

kubectl exec -it zookeeper-2 -n zookeeper -- zkServer.sh status

kubectl exec -it zookeeper-0 -n zookeeper -- bash

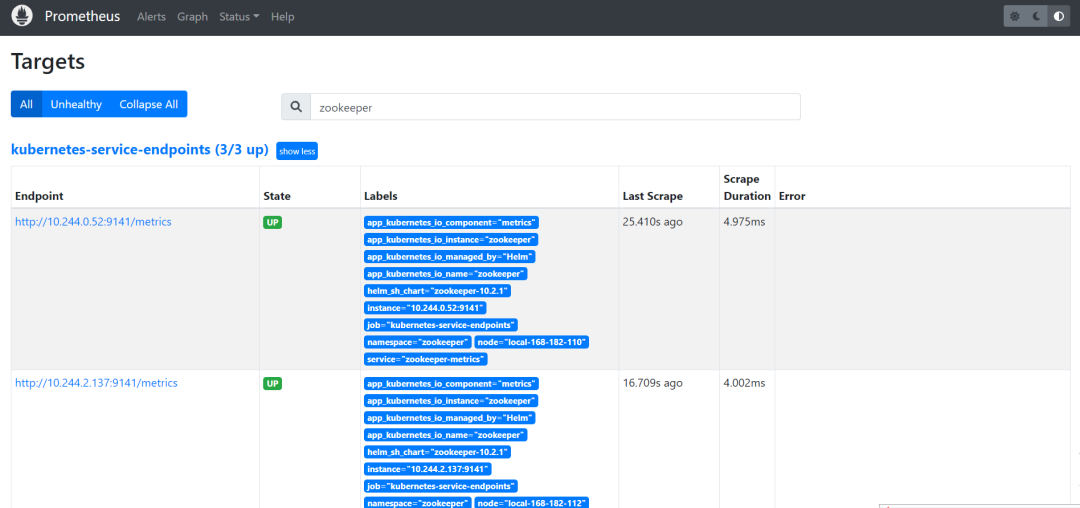

5) Мониторинг Прометея

Prometheus:https://prometheus.k8s.local/targets?search=zookeeper

Просмотреть собранные данные можно с помощью команд

kubectl get --raw http://10.244.0.52:9141/metrics

kubectl get --raw http://10.244.1.101:9141/metrics

kubectl get --raw http://10.244.2.137:9141/metrics

Grafana:https://grafana.k8s.local/

счет:admin,Получите пароль с помощью следующей команды

kubectl get secret --namespace grafana grafana -o jsonpath="{.data.admin-password}" | base64 --decode ; echo

импортировать grafana шаблон,Кластерные ресурсымонитор:10465

Официальный адрес загрузки модуля:

6) Удалить

helm uninstall zookeeper -n zookeeper

kubectl delete pod -n zookeeper `kubectl get pod -n zookeeper|awk 'NR>1{print $1}'` --force

kubectl patch ns zookeeper -p '{"metadata":{"finalizers":null}}'

kubectl delete ns zookeeper --force

3. Kafka о развертывании k8s

1) Добавить источник

Адрес пакета развертывания:

helm repo add bitnami https://charts.bitnami.com/bitnami

helm pull bitnami/kafka

tar -xf kafka-18.4.2.tgz

2) Изменить конфигурацию

- Исправлять

kafka/values.yaml

image:

registry: myharbor.com

repository: bigdata/kafka

tag: 3.2.1-debian-11-r16

...

replicaCount: 3

...

service:

type: NodePort

nodePorts:

client: "30092"

external: "30094"

...

externalAccess

enabled: true

service:

type: NodePort

nodePorts:

- 30001

- 30002

- 30003

useHostIPs: true

...

persistence:

storageClass: "kafka-local-storage"

size: "10Gi"

# Каталог необходимо заранее создать на хост-компьютере.

local:

- name: kafka-0

host: "local-168-182-110"

path: "/opt/bigdata/servers/kafka/data/data1"

- name: kafka-1

host: "local-168-182-111"

path: "/opt/bigdata/servers/kafka/data/data1"

- name: kafka-2

host: "local-168-182-112"

path: "/opt/bigdata/servers/kafka/data/data1"

...

metrics:

kafka:

enabled: true

image:

registry: myharbor.com

repository: bigdata/kafka-exporter

tag: 1.6.0-debian-11-r8

jmx:

enabled: true

image:

registry: myharbor.com

repository: bigdata/jmx-exporter

tag: 0.17.1-debian-11-r1

annotations:

prometheus.io/path: "/metrics"

...

zookeeper:

enabled: false

...

externalZookeeper

servers:

- zookeeper-0.zookeeper-headless.zookeeper

- zookeeper-1.zookeeper-headless.zookeeper

- zookeeper-2.zookeeper-headless.zookeeper

- добавить в

kafka/templates/pv.yaml

{{- range .Values.persistence.local }}

---

apiVersion: v1

kind: PersistentVolume

metadata:

name: {{ .name }}

labels:

name: {{ .name }}

spec:

storageClassName: {{ $.Values.persistence.storageClass }}

capacity:

storage: {{ $.Values.persistence.size }}

accessModes:

- ReadWriteOnce

local:

path: {{ .path }}

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- {{ .host }}

---

{{- end }}

- добавить в

kafka/templates/storage-class.yaml

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: {{ .Values.persistence.storageClass }}

provisioner: kubernetes.io/no-provisioner

3) Начать установку

# Сначала подготовьте изображение

docker pull docker.io/bitnami/kafka:3.2.1-debian-11-r16

docker tag docker.io/bitnami/kafka:3.2.1-debian-11-r16 myharbor.com/bigdata/kafka:3.2.1-debian-11-r16

docker push myharbor.com/bigdata/kafka:3.2.1-debian-11-r16

# node-export

docker pull docker.io/bitnami/kafka-exporter:1.6.0-debian-11-r8

docker tag docker.io/bitnami/kafka-exporter:1.6.0-debian-11-r8 myharbor.com/bigdata/kafka-exporter:1.6.0-debian-11-r8

docker push myharbor.com/bigdata/kafka-exporter:1.6.0-debian-11-r8

# JXM

docker.io/bitnami/jmx-exporter:0.17.1-debian-11-r1

docker tag docker.io/bitnami/jmx-exporter:0.17.1-debian-11-r1 myharbor.com/bigdata/jmx-exporter:0.17.1-debian-11-r1

docker push myharbor.com/bigdata/jmx-exporter:0.17.1-debian-11-r1

#Начать установку

helm install kafka ./kafka -n kafka --create-namespace

NAME: kafka

LAST DEPLOYED: Sun Sep 18 20:57:02 2022

NAMESPACE: kafka

STATUS: deployed

REVISION: 1

TEST SUITE: None

NOTES:

CHART NAME: kafka

CHART VERSION: 18.4.2

APP VERSION: 3.2.1

---------------------------------------------------------------------------------------------

WARNING

By specifying "serviceType=LoadBalancer" and not configuring the authentication

you have most likely exposed the Kafka service externally without any

authentication mechanism.

For security reasons, we strongly suggest that you switch to "ClusterIP" or

"NodePort". As alternative, you can also configure the Kafka authentication.

---------------------------------------------------------------------------------------------

** Please be patient while the chart is being deployed **

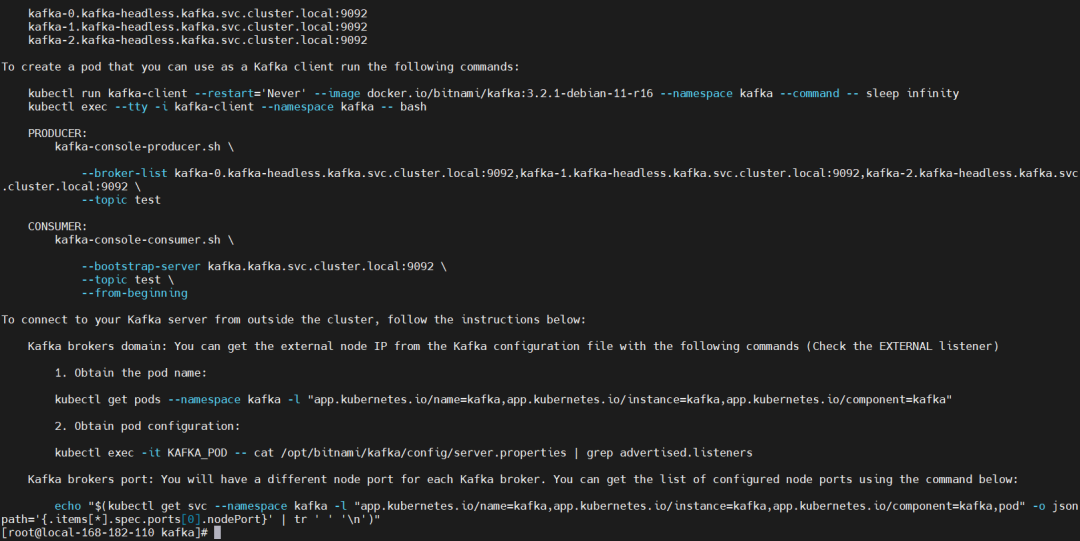

Kafka can be accessed by consumers via port 9092 on the following DNS name from within your cluster:

kafka.kafka.svc.cluster.local

Each Kafka broker can be accessed by producers via port 9092 on the following DNS name(s) from within your cluster:

kafka-0.kafka-headless.kafka.svc.cluster.local:9092

kafka-1.kafka-headless.kafka.svc.cluster.local:9092

kafka-2.kafka-headless.kafka.svc.cluster.local:9092

To create a pod that you can use as a Kafka client run the following commands:

kubectl run kafka-client --restart='Never' --image docker.io/bitnami/kafka:3.2.1-debian-11-r16 --namespace kafka --command -- sleep infinity

kubectl exec --tty -i kafka-client --namespace kafka -- bash

PRODUCER:

kafka-console-producer.sh \

--broker-list kafka-0.kafka-headless.kafka.svc.cluster.local:9092,kafka-1.kafka-headless.kafka.svc.cluster.local:9092,kafka-2.kafka-headless.kafka.svc.cluster.local:9092 \

--topic test

CONSUMER:

kafka-console-consumer.sh \

--bootstrap-server kafka.kafka.svc.cluster.local:9092 \

--topic test \

--from-beginning

To connect to your Kafka server from outside the cluster, follow the instructions below:

Kafka brokers domain: You can get the external node IP from the Kafka configuration file with the following commands (Check the EXTERNAL listener)

1. Obtain the pod name:

kubectl get pods --namespace kafka -l "app.kubernetes.io/name=kafka,app.kubernetes.io/instance=kafka,app.kubernetes.io/component=kafka"

2. Obtain pod configuration:

kubectl exec -it KAFKA_POD -- cat /opt/bitnami/kafka/config/server.properties | grep advertised.listeners

Kafka brokers port: You will have a different node port for each Kafka broker. You can get the list of configured node ports using the command below:

echo "$(kubectl get svc --namespace kafka -l "app.kubernetes.io/name=kafka,app.kubernetes.io/instance=kafka,app.kubernetes.io/component=kafka,pod" -o jsonpath='{.items[*].spec.ports[0].nodePort}' | tr ' ' '\n')"

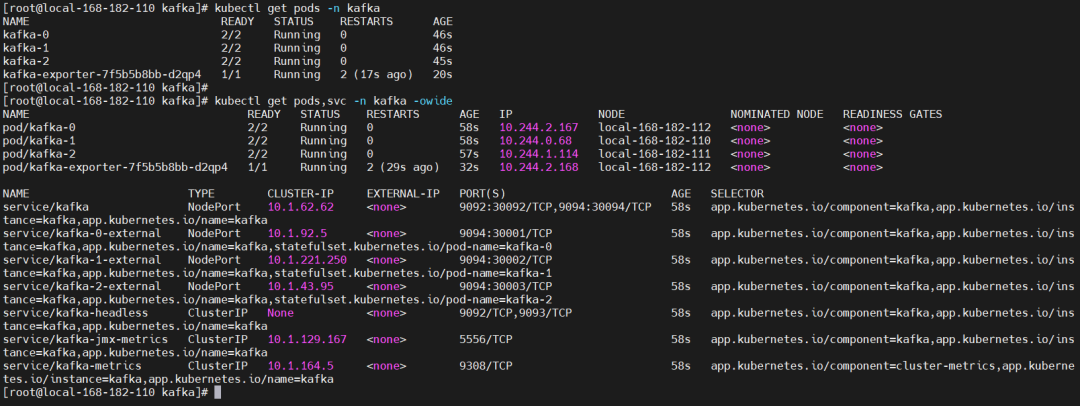

Посмотреть статус модуля

kubectl get pods,svc -n kafka -owide

4) Тестовая проверка

# Войти в Zookeeper pod

kubectl exec -it kafka-0 -n kafka -- bash

1. Создать тему (одна копия и один раздел)

--create: Укажите действие для создания темы

--topic: укажите название новой темы.

--bootstrap-server: Укажите адрес подключения Kafka

--config: укажите допустимые значения параметров в текущей теме. Справочный документ по списку параметров: Topic-level configuration

--partitions: укажите количество создаваемых в данный момент разделов Kafka, значение по умолчанию — 1.

--replication-factor: укажите количество копировать факторы для каждого раздела, значение по умолчанию — 1

kafka-topics.sh --create --topic test001 --bootstrap-server kafka.kafka:9092 --partitions 1 --replication-factor 1

# Проверять

kafka-topics.sh --describe --bootstrap-server kafka.kafka:9092 --topic test001

2. Просмотр списка тем

kafka-topics.sh --list --bootstrap-server kafka.kafka:9092

3. Тестирование производителя/потребителя

【Продюсер】

kafka-console-producer.sh --broker-list kafka.kafka:9092 --topic test001

{"id":"1","name":"n1","age":"20"}

{"id":"2","name":"n2","age":"21"}

{"id":"3","name":"n3","age":"22"}

【потребитель】

# Тратьте с нуля

kafka-console-consumer.sh --bootstrap-server kafka.kafka:9092 --topic test001 --from-beginning

# Укажите определенное место в разделе, чтобы начать потребление. Здесь указывается только один раздел. Вы можете написать еще несколько строк или просмотреть все соответствующие разделы.

kafka-console-consumer.sh --bootstrap-server kafka.kafka:9092 --topic test001 --partition 0 --offset 100 --group test001

4. Проверьте накопившиеся данные

kafka-consumer-groups.sh --bootstrap-server kafka.kafka:9092 --describe --group test001

5. Удалить тему

kafka-topics.sh --delete --topic test001 --bootstrap-server kafka.kafka:9092

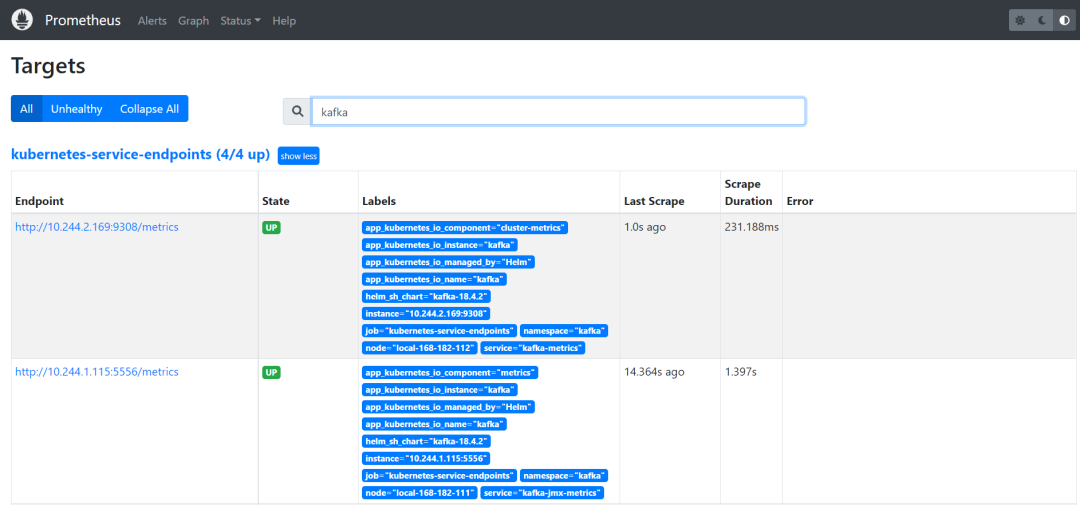

5) Мониторинг Прометея

Prometheus:

Просмотреть собранные данные можно с помощью команд

kubectl get --raw http://10.244.2.165:9308/metrics

Grafana:https://grafana.k8s.local/

счет:admin,Получите пароль с помощью следующей команды

kubectl get secret --namespace grafana grafana -o jsonpath="{.data.admin-password}" | base64 --decode ; echo

импортировать grafana шаблон,Кластерные ресурсымонитор:11962

Официальный адрес загрузки модуля:

6) Удалить

helm uninstall kafka -n kafka

kubectl delete pod -n kafka `kubectl get pod -n kafka|awk 'NR>1{print $1}'` --force

kubectl patch ns kafka -p '{"metadata":{"finalizers":null}}'

kubectl delete ns kafka --force

Zookeeper + kafka по развертыванию среды k8s уже здесь. Если у вас есть вопросы, оставьте мне сообщение!

- END -

Углубленный анализ переполнения памяти CUDA: OutOfMemoryError: CUDA не хватает памяти. Попыталась выделить 3,21 Ги Б (GPU 0; всего 8,00 Ги Б).

[Решено] ошибка установки conda. Среда решения: не удалось выполнить первоначальное зависание. Повторная попытка с помощью файла (графическое руководство).

Прочитайте нейросетевую модель Трансформера в одной статье

.ART Теплые зимние предложения уже открыты

Сравнительная таблица описания кодов ошибок Amap

Уведомление о последних правилах Points Mall в декабре 2022 года.

Даже новички могут быстро приступить к работе с легким сервером приложений.

Взгляд на RSAC 2024|Защита конфиденциальности в эпоху больших моделей

Вы используете ИИ каждый день и до сих пор не знаете, как ИИ дает обратную связь? Одна статья для понимания реализации в коде Python общих функций потерь генеративных моделей + анализ принципов расчета.

Используйте (внутренний) почтовый ящик для образовательных учреждений, чтобы использовать Microsoft Family Bucket (1T дискового пространства на одном диске и версию Office 365 для образовательных учреждений)

Руководство по началу работы с оперативным проектом (7) Практическое сочетание оперативного письма — оперативного письма на основе интеллектуальной системы вопросов и ответов службы поддержки клиентов

[docker] Версия сервера «Чтение 3» — создайте свою собственную программу чтения веб-текста

Обзор Cloud-init и этапы создания в рамках PVE

Корпоративные пользователи используют пакет регистрационных ресурсов для регистрации ICP для веб-сайта и активации оплаты WeChat H5 (с кодом платежного узла версии API V3)

Подробное объяснение таких показателей производительности с высоким уровнем параллелизма, как QPS, TPS, RT и пропускная способность.

Удачи в конкурсе Python Essay Challenge, станьте первым, кто испытает новую функцию сообщества [Запускать блоки кода онлайн] и выиграйте множество изысканных подарков!

[Техническая посадка травы] Кровавая рвота и отделка позволяют вам необычным образом ощипывать гусиные перья! Не распространяйте информацию! ! !

[Официальное ограниченное по времени мероприятие] Сейчас ноябрь, напишите и получите приз

Прочтите это в одной статье: Учебник для няни по созданию сервера Huanshou Parlu на базе CVM-сервера.

Cloud Native | Что такое CRD (настраиваемые определения ресурсов) в K8s?

Как использовать Cloudflare CDN для настройки узла (CF самостоятельно выбирает IP) Гонконг, Китай/Азия узел/сводка и рекомендации внутреннего высокоскоростного IP-сегмента

Дополнительные правила вознаграждения амбассадоров акции в марте 2023 г.

Можно ли открыть частный сервер Phantom Beast Palu одним щелчком мыши? Супер простой урок для начинающих! (Прилагается метод обновления сервера)

[Играйте с Phantom Beast Palu] Обновите игровой сервер Phantom Beast Pallu одним щелчком мыши

Maotouhu делится: последний доступный внутри страны адрес склада исходного образа Docker 2024 года (обновлено 1 декабря)

Кодирование Base64 в MultipartFile

5 точек расширения SpringBoot, супер практично!

Глубокое понимание сопоставления индексов Elasticsearch.